- •Вероятностные процессы

- •Введение

- •1.Общие свойства случайных фнкций и случайных процесов

- •Определение случайных функций

- •1.2. Моменты конечномерных распределений случайных функций

- •1.3. Основные типы случайных функций и случайных процессов

- •1.3.1. Стационарные процессы

- •1.3.2. Нормальные процессы

- •1.3.3. Эргодические случайные процессы

- •1.3.4. Сингулярные и линейно-сингулярные процессы

- •1.3.5. Процессы с независимыми приращениями

- •1.3.6. Марковские процессы

- •2. Дискретные случайные процессы

- •2.1. Примеры дискретных случайных процессов

- •2.2. Цепи Маркова

- •2.2.2. Матрица вероятностей перехода за n шагов.

- •Классификация состояний марковских цепей

- •Определение 2.8.

- •2.4. Эргодические свойства непериодических цепей. Стационарное распределение.

- •3.Пуассоновские процессы

- •3.1. Примеры пуассоновских процессов в асу.

- •Данные об отказах электронной вычислительной машины

- •3.2. Дифференциальные уравнения для переходных вероятностей

- •3.3. Процесс чистого размножения

- •3.4. Пуассоновские процессы в системах массового обслуживания

- •4.2. Сложение случайных процессов.

- •4.3 Дифференцируемость выборочных функций случайного процесса

- •4.4. Интегрирование случайных процессов

- •5. Представление случайных процессов и случайных функций

- •5.1. Методы описания детерминированных функций

- •5.2. Представление случайных процессов на конечном интервале времени

- •5.3. Интегральные уравнения с корреляционной функцией в качестве ядра

- •5.4. Разложение случайных функций в ряд Карунена-Лоэва

- •5.4.1. Представление винеовского процесса в виде разложения Карунена-Лоэва.

- •5.4.2. Представление процесса типа белого шума

- •5.5. Канонические представления случайных функций

- •5.5.1. Основные определения

- •5.5.2. Общие формулы для координатных функций

- •5.5.3. Каноническое разложение случайной функции в дискретном ряде точек

- •5.5.4. Рекуррентные формулы построения канонического разложения случайной функции.

3.3. Процесс чистого размножения

Предположим, что в процессе Пуассона вероятность одного события за время (t, t+ h) зависит от числа событий за время (0, t ). Такой процесс можно рассматривать как пуассоновский процесс с переменной интенсивностью, характеризующейся последовательностью λ0, λ1, λ2, ……

Удобной формой описания процесса Пуассона является описание его в пространстве состояний.

Пусть на время (0, t ) произошло n событий. Будем говорить, что в этом случае система находиться в состоянии E n. Если за время h произойдет очередное событие, то система перейдет в состояние E n+1. В противном случае система останется в состоянии E n.

Определение 3.1.

Пуассоновский процесс, для которого переход из состояния E n возможен только в состоянии E n+1, называется процессом чистого размножения [ 5 ].

Если в момент t система находиться в состоянии E n (n = 0,1, 2, ….), то вероятность того, что за время (t, t+ h) осуществляется переход в E n+1, как это следует из (3.2 ), равна λ n h + 0 (h). Вероятность иных изменений имеет более высокий порядок малости, чем h.

Дифференциальные уравнения (3.4 ) и (3.5 ) имеют для процессов чистого размножения следующий вид:

Р' n (t) = – λ n Р n (t) + λ n-1Рn-1(t);

Р0 (t) = – λ 0 Р 0 (t) (n ≥ 1 ) (3.7 ) Начальным состоянием системы является E 0 , причем Р 0 (0) =1, а Р 0 (t) = e - λ 0t.

Можно, однако, в начальный момент времени рассматривать систему в любом состоянии.

Обобщим рассмотренный процесс размножения. С этой целью предположим, что в системе возможны переходы из E n но только в E n+1, но и в состояние E n-1 . Конечно, в этом случае состояние E n уже нельзя трактовать как число событий, реализованных на отрезке ( 0,t ).

Процесс такого вида впервые был изучен в биологии, где с его помощью опи-сывались процессы рождения и гибели. Поэтому иногда такие процессы называют процессами " гибели и размножения" [ 5 ].

В задачах анализа и синтеза АСУ такие процессы находят достаточно широкое применение. Поэтому рассмотрим их подробнее.

3.4. Пуассоновские процессы в системах массового обслуживания

Начнем с содержательного примера, имеющего большое значение для анализа и синтеза АСУ.

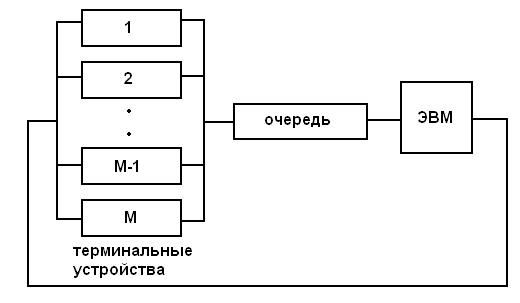

Пример 5. Рассмотрим вычислительную систему коллективного пользования, функционирующую в диалоговом режиме ( рис. 5 ).

Рис.5. Вычислительная система коллективного пользования

В этой вычислительной системе каждое терминальное устройство может находиться в одном из двух режимов: " активное ожидание" и " пассивное ожидание". В режиме активного ожидания терминальное устройство ожидает разрешения на ввод очередного сообщения в ЭВМ. Если ЭВМ свободна, то она немедленно приступает этого сообщения. В противном случае сообщение помещается в очередь, где ожидает в течение некоторого времени.

Пусть любое терминальное устройство, находящееся в режиме пассивного ожидания, может быть активизировано в интервале времени (t, t+ h) с вероятностью λ h + 0 (h), причем активизация терминалов происходит независимо друг от друга. Таким образом, если терминал пассивен в момент времени t, то промежутки времени от t до его активизации имеют распределение Пуассона (3.6)

Суммарный поток событий (поток переключений ) будет являться процессом чистого размножения с интенсивностью

![]() при

0 ≤ n

≤ М, ( 3.8)

при

0 ≤ n

≤ М, ( 3.8)

при n > М.

Предположим теперь, что времена обработки представляют собой случайные числа, имеющие экспоненциальное распределение e –μ t .

Другими словами, вероятность того что время обслуживания очередного сообщения будет больше, чем t, есть e –μ t. Из выражения ( 3.6 ) видно, что e –μ t представляет собой распределение Пуассона при n = 0.

Предполагая, наконец, что интервалы времени обработки сообщений взаимно независимы, придем к математической модели, описывающей функционирование вычислительной системы коллективного пользования в диалоговом режиме.

Для рассмотренного примера удобно вновь ввести пространство состояний, считая, что система находится в состоянии E n ,, где n – общее число обслуживае-

мых и ожидающих в очереди сообщений, n = 0, 1, 2, … , М.

Ясно, что в такой системе из состояний E n+1 возможны переходы как в E n+1 так и в E n-1. В силу малости члена 0 (h ) в уравнении ( 3.2 ) переходы в системе возможны лишь в ближайшие, соседние состояния. Если в некоторый момент система находится в состоянии E n, то вероятность того, что за время (t, t + h) осуществляется переход E n → E n+1, равна λ n h + 0 (h), а вероятность перехода E n → E n-1 (при n ≥ 1 ) равна μ h + 0 (h ). Вероятность того, что за время (t, t + h) осуществляется более чем одно изменение, имеет порядок малости более высокий, чем h .

Для вывода дифференциальных уравнений, описывающих поведение такой системы, предположим, что в момент времени t вероятность пребывания системы в состоянии E n равняется P n ( t ) . Для вычисления P n ( t + h) заметим, что система может находиться в момент времени t + h в состоянии E n в следующих трех случаях :

в момент t система находится в E n и за время h не происходит никаких изменений;

в момент t система находится в E n-1 и затем переходит в E n;

в момент t система находится в E n+1, к моменту ( t + h) система переходит в состояние E n .

По предположению, вероятность двух и более переходов за время h равняется 0 (h ). Кроме того, первые три возможности – взаимно исключающие и вероятности их можно складывать. Поэтому

P n ( t + h) = P n ( t )[ 1 - λ n h - μ h ] + λ n –1 h P n-1 + μ n+1 h P n+1 + 0 (h ).

Перенося P n ( t ) влево и разделив на h , получим при h → 0

P1 n ( t ) = - (λ n + μ n ) P n ( t ) + λ n –1 P n-1 ( t ) + μ n+1 P n+1( t ). ( 3.9)

Аналогично выводятся уравнения для n = 0, и n = М:

P1 0 ( t ) = - λ 0 P 0 ( t ) + μ 1( t );

P1

M

( t ) = - μ n

P

M

( t ) + λ

P

m-1(

t ). (3.10)

Если в момент t

= 0 система находится в состоянии i,

то должны выполняться начальные условия

![]() (

0 ) = 1,

(

0 ) = 1,

![]() = 0 при n

≠ i.

= 0 при n

≠ i.

Система дифференциальных уравнений ( 3.10 ) выведена для λi, μi, произвольно зависящих от n . В большинстве случаев зависимости λ( n) и μ( n ) имеет специальный вид. В частности для примера 5

λn = (μ – n)λ , μn = μ и дифференциальные уравнения принимают вид:

P1 0 ( t ) = - мλ P 0( t ) + μ P 1 ( t );

P1 n ( t ) = -[ ( М – n )λ + μ ] Pn( t ) + … + μ P n+1 ( t ) (3.11 )

P M ( t ) = - μ P M ( t ) + λP м -1( t ).

Эта линейная система дифференциальных уравнений, которая может быть решена обычными методами. При t → ∞ и ограниченных λ, μ, м система ( 3.11 ) имеет единственное решение [ 5 ], причем пределы

Существуют не зависят от начальных условий.

Предельные вероятности P n удовлетворяют системе линейных уравнений, получаемых из ( 3.11 ), если положить в них P1 n ( t ) = 0. Для P n из ( 3.11 )

при P1 n ( t ) = 0 легко вывести рекуррентную формулу

( М – n ) λ P n = μ P n + 1 (3.12)

Полагая n = М – 1, М = -2, … , 1, 0 , получаем

![]() (3.13)

(3.13)

Неизвестную постоянную P M можно определить из условий, что сумма P

равна единице. Легко видно, что

![]() (3.14)

(3.14)

Вероятность P 0 может интерпретироваться для примера 5 как вероятность того, что ЭВМ не занята. Математическое ожидание числа сообщений, стоящих в очереди, равно

![]() (3.15)

(3.15)

Так как P ! в сумме дают единицу, получим, используя (3.14 ), что

![]() (3.16)

(3.16)

или

![]()

4. ЛИНЕЙНЫЕ ОПЕРАЦИИ НАД СЛУЧАЙНЫМИ ПРОЦЕССАМИ

С НЕПРЕРЫВНЫМ ВРЕМЕНЕМ

4.1. Свойства корреляционных функций случайных процессов

с непрерывным временем.

В этом разделе мы подробно изучим

введенную в п.п. 1.1 корреляционную функцию

случайных процессов

![]() .

Напомним, что корреляционная функция

случайного процесса – это функция двух

аргументов :

.

Напомним, что корреляционная функция

случайного процесса – это функция двух

аргументов :

![]() (4.1)

(4.1)

На практике часто используют нормированную корреляционную функцию

![]() (4.2)

(4.2)

Последняя

функция удобна тем, что ее значения

находятся в пределах ± 1 и, следовательно,

по абсолютной величине

![]() можно судить о степени связности

(зависимости) двух ординат случайного

процесса.

можно судить о степени связности

(зависимости) двух ординат случайного

процесса.

Непосредственно из определения корреляционной функции (4.1) следует, что корреляционная функция симметрична

![]() (4.3)

(4.3)

Это обстоятельство позволяет ограничиться областью аргументов t≥ s или s ≥ t. Корреляционная функция случайного процесса удовлетворяет неравенству

![]() (4.4)

(4.4)

Корреляционная функция обладает очень важным свойством, позволяющим существенно облегчить анализ случайных процессов, свойством положительной определенности [6 ]. Смысл этого свойства в следующем. Рассмотрим интеграл

![]() (4.5)

(4.5)

где

![]() -

некоторые произвольные функции.

-

некоторые произвольные функции.

Подставив в (4.5) выражение корреляционной функции (4.1), меняя местами операции интегрирования и математического ожидания, получим

где

где

![]()

Последнее выражение можно записать теперь в виде:

![]()

Но

математическое ожидание неотрицательной

величины не может быть отрицательным

и, следовательно, при любой области

интегрирования Т и при любой функции

интеграл (4.5) не меньше нуля. Функция

![]() ,

обладающие таким свойством, называются

положительно определенными функциями.

,

обладающие таким свойством, называются

положительно определенными функциями.