- •1)Основные причины наличия в регрессионной модели случайного отклонения.

- •2)Основные этапы регрессионного анализа.

- •3)Спецификация модели, каким образом она осуществляется?

- •4)Стандартная ошибка регрессии Sxy.

- •5)Различие между теоретическим и эмпирическим уравнениями регрессии.

- •10)Доверительный интервал для предсказания индивидуальных значений зависимой переменной.

- •11)Каким образом определяется модель множественной линейной регрессии?

- •12)Предпосылки мнк. Каковы последствия их невыполнимости?

- •1°. Математическое ожидание случайного отклонения равно нулю для всех наблюдений:

- •4°. Случайное отклонение должно быть независимо от объясняющих переменных.

- •13)Характеристика коэффициентов уравнения регрессии.

- •14)Суть мнк для построения множественного линейного уравнения регрессии.

- •15)Статистическая значимость коэффициентов регрессии.

- •16)Интервальные оценки коэффициентов регрессии

- •17)Коэффициент детерминации r2. Отличие скорректированного коэффициента детерминации от обычного.

- •18)Анализ статистической значимости коэффициента детерминации r2.

- •19)Как используется f-статистика в регрессионном анализе?(Ответ в предыдущем вопросе)

- •20)Проверка общего качества уравнения регрессию

- •21)Автокорреляцией остатков и ее виды.

- •22)Статистика Дарбина–Уотсона. Формула расчета. Суть показателя.

- •28)Определениие мультиколлинеарности. Признаки наличия мультиколлинеарности.

- •29)Методы проверки наличия мультиколлиниарности. Показатель vif – «фактор инфляции вариации»

- •30)Методы устранения мультиколлинеарности.

- •31)Гетероскедастичность. Последствия гетероскедастичности.

- •32)Методы смягчения гетероскедастичности

- •33)Автокорреляция. Основные причины автокорреляции.

- •34)Последствия автокорреляции. Основные методы обнаружения автокорреляции.

- •35)Спецификация модели

- •36)Основные признаки качественной регрессионной модели.

- •37)Основные виды ошибок спецификации.

- •1. Отбрасывание значимой переменной

- •2. Добавление незначимой переменной

- •38)Обнаружение и корректировка ошибок спецификации

- •39)Проблемы спецификации

- •40)Необходимость использования фиктивных переменных в регрессионных уравнениях

- •41)Использование фиктивных переменных для сезонного анализа

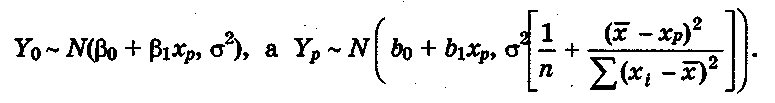

10)Доверительный интервал для предсказания индивидуальных значений зависимой переменной.

На практике иногда более важно знать дисперсию У, чем ее средние значения или доверительные интервалы для условных математических ожиданий. Это позволяет определить допустимые границы для конкретного значения Y.

Пусть

нас интересует некоторое возможное

значение y0

переменной

У при определенном значении хр

объясняющей

переменной

X.

Предсказанное

по уравнению регрессии значение

У при X

=

xp

составляет

ур.

Если

рассматривать значение у

о как

CB

Y0![]() ,

а.

у2

—

как СВ Yp,

то

можно отметить, что

,

а.

у2

—

как СВ Yp,

то

можно отметить, что

С

![]() и

и

![]() являются независимыми, а следовательно

, СВ

являются независимыми, а следовательно

, СВ

![]() имеет

нормальное распределение с

имеет

нормальное распределение с

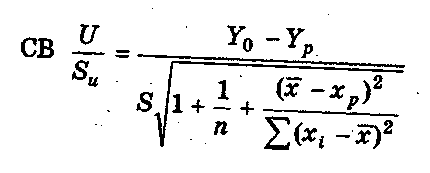

Но тогда можно показать, что

имеет нормальное распределение Стьюдента с числом степеней свободы .

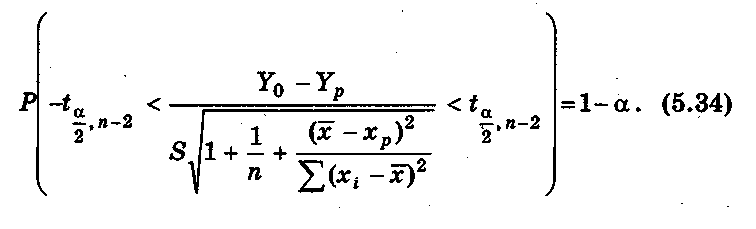

На основании этого можно сделать вывод, что интервал

определяет

границы, за пределами которых могут

оказаться не более

100

![]() % точек наблюдений при X

= хр.

Заметим,

что данный

интервал шире доверительного интервала

для условного математического ожидания

(на рис. 5.4 границы этого интервала

отмечены

пунктирной линией).

% точек наблюдений при X

= хр.

Заметим,

что данный

интервал шире доверительного интервала

для условного математического ожидания

(на рис. 5.4 границы этого интервала

отмечены

пунктирной линией).

Проводя

анализ построенных интервалов, несложно

заметить,

что наиболее узкими они будут при Хр

=![]() .

По

мере удаления

Х0

от

среднего значения доверительные

интервалы расширяются

(рис. 5.4). Поэтому необходимо достаточно

осторожно экстраполировать

полученные результаты на прогнозные

области.

С другой стороны, с ростом числа наблюдений

n

эти

интервалы сужаются к линии регрессии

при n

.

По

мере удаления

Х0

от

среднего значения доверительные

интервалы расширяются

(рис. 5.4). Поэтому необходимо достаточно

осторожно экстраполировать

полученные результаты на прогнозные

области.

С другой стороны, с ростом числа наблюдений

n

эти

интервалы сужаются к линии регрессии

при n

![]() .

.

11)Каким образом определяется модель множественной линейной регрессии?

модель множественной линейной регрессии.

Теоретическое линейное уравнение регрессии имеет вид:

![]()

или для индивидуальных наблюдений i, i = 1, 2,…, n,

![]()

Здесь

![]() — вектор размерности (т

+ 1)

неизвестных параметров.

— вектор размерности (т

+ 1)

неизвестных параметров.

![]() ,

у = 1, 2, ..., т,

называется

,

у = 1, 2, ..., т,

называется

![]() -м

теоретическим

коэффициентом регрессии (частичным

коэффициентом регрессии).

Он характеризует чувствительность

величины Y

к изменению

-м

теоретическим

коэффициентом регрессии (частичным

коэффициентом регрессии).

Он характеризует чувствительность

величины Y

к изменению

![]() .

Другими словами, он отражает влияние

на условное

математическое ожидание M(

.

Другими словами, он отражает влияние

на условное

математическое ожидание M(![]() )

зависимой

переменной У объясняющей переменной

Хj

при условии, что все другие объясняющие

переменные модели остаются постоянными.

— свободный

член, определяющий

значение У в случае,

когда все объясняющие переменные Xj)

равны

нулю.

)

зависимой

переменной У объясняющей переменной

Хj

при условии, что все другие объясняющие

переменные модели остаются постоянными.

— свободный

член, определяющий

значение У в случае,

когда все объясняющие переменные Xj)

равны

нулю.

После выбора линейной функции в качестве модели зависимости необходимо оценить параметры регрессии.

Пусть имеется n наблюдений вектора объясняющих переменных X = (X1, X2, ..., Хт) и зависимой переменной У:

![]()

Для

того чтобы однозначно можно было бы

решить задачу отыскания

параметров

![]() (т.е.

найти некоторый наилучший

вектор

(т.е.

найти некоторый наилучший

вектор

![]() ), должно выполняться неравенство

), должно выполняться неравенство

![]() .

Если

это неравенство не будет выполняться,

то существует бесконечно

много различных векторов параметров,

при которых линейная

формула связи между X

и

У будет абсолютно точно соответствовать

имеющимся наблюдениям. При этом, если

.

Если

это неравенство не будет выполняться,

то существует бесконечно

много различных векторов параметров,

при которых линейная

формула связи между X

и

У будет абсолютно точно соответствовать

имеющимся наблюдениям. При этом, если

![]()

![]() ,

то оценки коэффициентов вектора

рассчитываются

единственным образом — путем решения

системы т

+ 1 линейного

уравнения:

,

то оценки коэффициентов вектора

рассчитываются

единственным образом — путем решения

системы т

+ 1 линейного

уравнения:

Например,

для однозначного определения оценок

параметров

уравнения регрессии

![]() достаточно иметь выборку

из трех наблюдений (

достаточно иметь выборку

из трех наблюдений (![]() ),i

= 1, 2, 3. В этом

случае найденные значения параметров

),i

= 1, 2, 3. В этом

случае найденные значения параметров

![]() определяют такую плоскость

в

трехмерном пространстве,

которая пройдет именно через имеющиеся

три точки.

С другой стороны, добавление в выборку

к имеющимся трем

наблюдениям еще одного приведет к тому,

что четвертая точка

(

определяют такую плоскость

в

трехмерном пространстве,

которая пройдет именно через имеющиеся

три точки.

С другой стороны, добавление в выборку

к имеющимся трем

наблюдениям еще одного приведет к тому,

что четвертая точка

(![]() )

практически наверняка

будет лежать вне построенной плоскости

(и, возможно, достаточно далеко). Это

потребует определенной переоценки

параметров.

)

практически наверняка

будет лежать вне построенной плоскости

(и, возможно, достаточно далеко). Это

потребует определенной переоценки

параметров.

Таким образом, вполне логичен следующий вывод: если число наблюдений больше минимально необходимого, т.е. n > m+1, то уже нельзя подобрать линейную форму, в точности удовлетворяющую всем наблюдениям, и возникает необходимость оптимизации, т.е. оценивания параметров , при которых формула дает наилучшее приближение для имеющихся наблюдений.

В

данном случае число

![]() =

n

— т — 1

называется числом

степеней свободы. Нетрудно

заметить, что если число степеней свободы

невелико, то статистическая надежность

оцениваемой формулы невысока. Например,

вероятность верного вывода (получения

более точных оценок) по трем наблюдениям

существенно ниже, чем по тридцати.

Считается, что при оценивании множественной

линейной регрессии для обеспечения

статистической надежности требуется,

чтобы число наблюдений по крайней мере

в 3 раза превосходило число оцениваемых

параметров.

=

n

— т — 1

называется числом

степеней свободы. Нетрудно

заметить, что если число степеней свободы

невелико, то статистическая надежность

оцениваемой формулы невысока. Например,

вероятность верного вывода (получения

более точных оценок) по трем наблюдениям

существенно ниже, чем по тридцати.

Считается, что при оценивании множественной

линейной регрессии для обеспечения

статистической надежности требуется,

чтобы число наблюдений по крайней мере

в 3 раза превосходило число оцениваемых

параметров.

Самым распространенным методом оценки параметров уравнения множественной линейной регрессии является метод наименьших квадратов (МНК). Напомним, что его суть состоит в минимизации суммы квадратов отклонений наблюдаемых значений зависимой переменной У от ее значений У, получаемых по уравнению регрессии.