- •Оглавление

- •1. Количественные характеристики, используемые при измерении параметров вычислительных систем. Номинальное и пиковое быстродействие. Быстродействие вычислителя по гибсону.

- •2. Понятие о современных вычислительных системах. Диаметр. Средний диаметр.

- •3. Наиболее популярные схемы вычислительных систем: «общая шина», «линейка», «кольцо», «тор», «решетка».

- •4. Структура вычислительных систем типа двумерный тор, n-мерный двоичный гиперкуб.

- •5. Реализация обмена информацией в структуре типа «обобщенный nd-куб» и «nd-тор»

- •6. Структура вычислительных систем типа циркулянта и типа л(n,n,g) - граф.

- •7. Структура вычислительных систем типа «бинарное дерево», «мультидерево глубины n и ширины k».

- •8. Характеристика коммутаторов вычислительных систем.

- •9. Архитектурные свойства вычислительной сети и описание процессов её функционирования.

- •10. Надежность и живучесть вычислительной системы.

- •11А. Схемы обмена информацией между ветвями параллельных алгоритмов.

- •12. Структурные характеристики вычислительных систем.

- •13. Пример решения задачи умножения матриц с помощью вычислительных систем.

- •14. Показатели эффективности параллельных алгоритмов. Коэффициент накладных расходов, коэффициент ускорения. Понятие о сложных задачах.

- •Коэффициент ускорения

- •Понятие о сложных задачах

- •15. Закон амдаля и коэффициент эффективности параллельной программы.

- •16А. Понятие о сложных задачах

- •17. Принципы перехода от последовательного алгоритма к параллельному. Алгоритм преобразования последовательного алгоритма в параллельный.

- •18. Представление алгоритмов взвешенными графами. Свёртка и развёртка вершин графа. Основные определения матриц следования информационного графа. Алгоритмы их получения.

- •19. Треугольная матрица следования. Теорема об условиях её получения.

- •20. Матрица следования для информационно-логического графа. Алгоритм построения транзитивных связей в этой матрице.

- •21. Обоснование транзитивных операций дизъюнкции и конъюнкции.

- •22. Алгоритм определения наличия контуров в информационной граф-схеме алгоритма.

- •23. Понятие о матрице логической несовместимости. Внешние и внутренние замыкания в информационно-логическом графе.

- •24. Алгоритм построения матрицы логической несовместимости операторов.

- •25. Понятие о матрице независимости в граф-схемах алгоритмов.

- •26. Взаимно независимые операторы. Определение взаимной независимости. Полные и максимально полные множества взаимно независимых операторов.

- •27. Алгоритм нахождения полных множеств взаимно независимых операторов.

- •28. Алгоритмы построения ранних и поздних сроков окончания выполнения операторов.

- •29. Определение функции плотности загрузки и минимальной загрузки для вычислительных систем.

- •30. Алгоритм определения минимальной загрузки в вычислительной системе на заданном интервале.

- •31. Лемма об оценке максимально необходимого числа процессоров для решения поставленной задачи.

- •32. Утверждение об оценке минимально необходимого числа процессоров для решения поставленной задачи.

- •33. Об оценке снизу времени выполнения задачи при заданном количестве процессоров.

- •34. Уточнение оценки снизу времени выполнения задачи на n процессорах.

- •35. Алгоритм определения оценки минимального числа процессоров, необходимых для выполнения алгоритма за время t.

- •36. Алгоритм определения оценки минимального времени t выполнения заданного алгоритма на вычислительной системе, содержащей n процессоров.

- •37. Алгоритм оценки минимально необходимого количества процессоров для задачи, представленной информационно-логическим графом.

- •38. Алгоритм оценки времени выполнения задачи, представленной данным вычислительных систем графом.

- •39. Архитектурные аспекты при создании операционной системы вычислительных сетей.

- •40. Опыт применения методики крупноблочного распараллеливания сложных задач.

- •41. Основы функционирования вычислительной системы типа «микрос-т».

- •42. Исследование информационных графов с векторными весами вершин для планирования параллельных вычислений.

- •43. Алгоритм нахождения операторов входящих только в одно множество взаимно независимых операторов.

- •46. Определение плотности загрузки для I-го типа процессора и алгоритм ей вычисления.

- •51. Коммуникационная среда на основе масштабируемого когерентного интерфейcа sci.

- •52. Коммуникационная среда на основе технологии myrinet.

- •53. Краткая характеристика коммуникационной среды qsnet II.

- •54. Алгоритм распределения нитей граф-схемы алгоритма по узлам вычислительной сети.

- •55. Представление алгоритмов взвешенными графами. Основные определения матрицы описания информационного графа. Алгоритмы ее получения.

- •56. Изображение схем параллельных алгоритмов с помощью информационных (иг) и информационно-логических (илг) графов.

- •Вычисление матриц следования, расширенных матриц следования и матриц следования с транзитивными связями.

Алгоритм A обеспечивает, наряду с требуемой обработкой, управление одновременной работой M процессоров с необходимым обменом данными между ними.

Структура коллектива вычислителей, представленных в виде графа:

GS=(M, S*), где М={mi}, i= 0, …, N-1,

Si,j![]() S*,

i,

j=

{0, …, N-1}.

S*,

i,

j=

{0, …, N-1}.

Симметричной ВС называется неориентированный граф, в котором произвольная нумерация вершин не меняет степень вершин графа, где под степенью вершины понимается количество ребер, примыкающих к ней.

Одними из важных параметров сети являются ее диаметр и средний диаметр, определяющие временные задержки при обмене информацией между процессорами сети.

Диаметр d – это максимальное расстояние, определяемое как

![]()

где

![]() – расстояние между вершинами i

и j

рассматриваемой сети.

– расстояние между вершинами i

и j

рассматриваемой сети.

Расстояние есть минимальная длина простой цепи между вершинами i и j, где длина измеряется в количестве ребер между вершинами i и j.

Средний диаметр

![]() для выделенной вершины n

определяется как

для выделенной вершины n

определяется как

,

где pi

– расстояние от текущей вершины до

выделенной (i-ой),

,

где pi

– расстояние от текущей вершины до

выделенной (i-ой),

npi – число вершин, находящихся на расстоянии pi от выделенной.

Средний диаметр

сети

![]() :

:

.

.

Для симметричной

сети

![]() .

.

3. Наиболее популярные схемы вычислительных систем: «общая шина», «линейка», «кольцо», «тор», «решетка».

Схемы обмена между вычислителями:

О

бщая

шина.

Структура вычислительной сети типа

«Общая шина» описывается графом GS=(M,

S*),

где M

={mi},

i=0,

…, N-1

– множество вычислителей, N≥3,

S*

в каждый момент времени tk

= {t1,

…, tk}

состоит из одного ребра Si,j

(i,j

M),

а множество вершин tk

определяет моменты реконфигурации

сети.

бщая

шина.

Структура вычислительной сети типа

«Общая шина» описывается графом GS=(M,

S*),

где M

={mi},

i=0,

…, N-1

– множество вычислителей, N≥3,

S*

в каждый момент времени tk

= {t1,

…, tk}

состоит из одного ребра Si,j

(i,j

M),

а множество вершин tk

определяет моменты реконфигурации

сети.

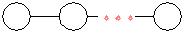

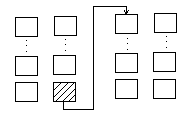

Л

инейка.

Структура

ВС типа «Линейка» описывается графом

GS=(M,

S*),

где M

={mi},

i=0,

…, N-1

– множество вычислителей, N≥3,

S*

состоит из ребер Si,(i+1),

i=0,

…, N-2.

инейка.

Структура

ВС типа «Линейка» описывается графом

GS=(M,

S*),

где M

={mi},

i=0,

…, N-1

– множество вычислителей, N≥3,

S*

состоит из ребер Si,(i+1),

i=0,

…, N-2.

*Каждый вычислитель кроме первого и последнего, связан друг с другом. Минус такой схемы: Отказ одного вычислителя приводит всю систему к сбою.

![]()

Кольцо. Структура ВС типа «Кольцо» описывается графом GS=(M, S*), где M ={mi}, i=0, …, N-1 – множество вычислителей, N≥3, S* состоит из ребер Si,(i+1)modN, i=0, …, N-1.

*Каждый вычислитель связан друг с другом. Функция mod(N) – строит ребро между первым и последним вычислителями.

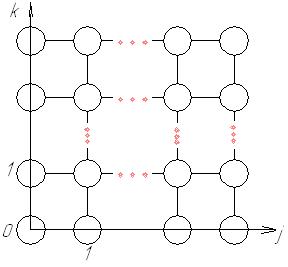

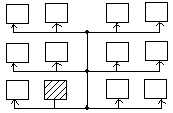

Решетка. Структура ВС типа «Решетка» описывается графом GS=(M, S*), где M={mi}, i= 0, …,N-1, N>5; S* состоит из множества ребер Si,k j {0, …,Y-1}, k {0, …, L-1}, причем L×Y=N.

Ребро проводиться между вершинами, определяемыми декартовым произведением [j] ×[k]. Две вершины соединяются ребром, если их декартовы произведения отличаются друг от друга на 1 по координате k или j соответственно.

Тор – см. след. вопрос.

4. Структура вычислительных систем типа двумерный тор, n-мерный двоичный гиперкуб.

Д вумерный

тор.

вумерный

тор.

*Здесь между собой соединяются граничные вычислители (возможно, все), т.е. те, которые имеют max или min координату по одной из осей. (минус: появляются дополнительные шины). Другими словами можно сказать, что двумерный тор- это ВС «2D-решетка», противоположные грани которой соединены, обеспечивая обмен данными между первым и последним элементами строки/столбца.

Структура ВС типа «двумерный тор» описывается графом GS=(M,S*), где M= 0, …, N-1, N≥7; S* состоит из ребер Si,k j {0, …,Y-1}, k {0, …, L-1}, причем L×Y=N.

Ребро проводиться между вершинами, определяемыми декартовым произведением [j] ×[k]. Две вершины соединяются ребром, если их декартовы произведения отличаются друг от друга на 1 по любой координате или на L-1 по координате k или на Y-1 по координате j.

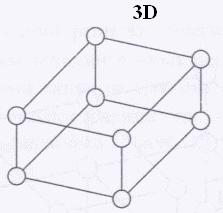

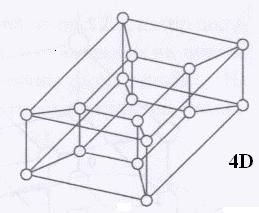

n-мерный двоичный гиперкуб.

С![]()

труктура

ВС типа «двоичный

гиперкуб»

описывается графом GS=(M,S*),

где М={mi},

i=0,

…,N-1,

N≥4,

вершины имеют номера Ni=2p,

p=0,1,…,n-1,

где n

– размерность гиперкуба.

труктура

ВС типа «двоичный

гиперкуб»

описывается графом GS=(M,S*),

где М={mi},

i=0,

…,N-1,

N≥4,

вершины имеют номера Ni=2p,

p=0,1,…,n-1,

где n

– размерность гиперкуба.

Каждая вершина Vi задается двоичным числом

q(Vi)=pvi,0… pvi,n-1.

Между вершинами Vi и Vj проводиться ребро, если их двоичные номера q(Vi) и q(Vj) различаются только одним разрядом.

5. Реализация обмена информацией в структуре типа «обобщенный nd-куб» и «nd-тор»

Обобщенный nd-куб.

Структура

ВС типа «обобщенный nd-куб»

описывается графом GS=(M,S*),

где М={mi},

i=0,

…,N-1,

N≥5.

Структура

ВС типа «обобщенный nd-куб»

описывается графом GS=(M,S*),

где М={mi},

i=0,

…,N-1,

N≥5.

По каждой координате j=1, …,n откладываются точки (вершины) с номерами 0,1,…,Nj-1, где Nj – размерность куба по координате j.

Множество вершин задается декартовым произведением [N1-1] ×[N2-1] ×…×[Nn-1]; N1 ∙N2 ∙…∙Nn=N. Две вершины соединяются ребром, если декартовы произведения отличаются друг от друга на 1 по координате Nj, j {1, …, n}.

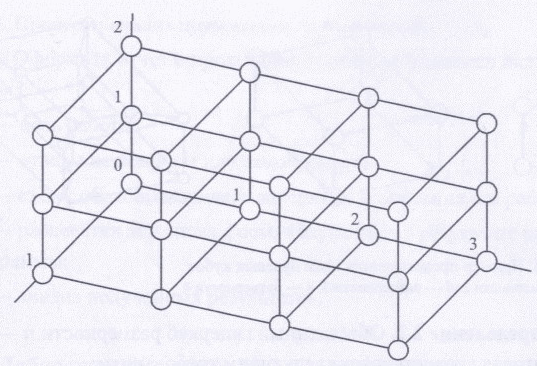

Обобщенный nd-тор.

Структура ВС типа «Обобщенный nd-тор» описывается графом GS=(M,S*), где М={mi}, i=0, …,N-1.

По каждой координате j=1,…,n, вводятся точки 0,1, …, Nj-1, где Nj размерность тора по координате j.

Множество вершин графа задается декартовым произведением [N1-1] ×[N2-1] ×…×[Nn-1].

Множество ребер сети S* строиться следующем образом: две вершины соединяются ребром, если их декартово произведение отличается друг от друга на 1 или на Nj -1 по координате j. (картинки 2D и 3D на след. странице)

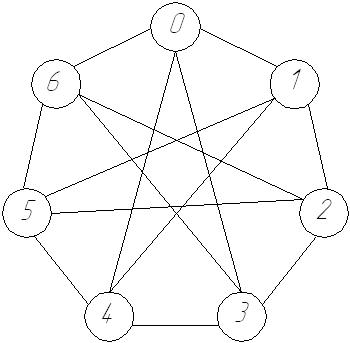

6. Структура вычислительных систем типа циркулянта и типа л(n,n,g) - граф.

Циркулянта.

П

редставляется

виде dn-графов,

которые описываются Dn=G(N,

q1,

…, qn),

где N

–число вершин графа (вычислителей),

которые нумеруются от 0 до N-1,

q1,

…, qn

– образующие

числа, такие что 0< q1<

q2<…<

qn<![]() .

N,

q1,

…, qn

– взаимно простые (наибольший общий

делитель равен 1). n

– число образующих чисел.

.

N,

q1,

…, qn

– взаимно простые (наибольший общий

делитель равен 1). n

– число образующих чисел.

Вершина i соединяется ребрами с вершинами (i ± q1)mod(N), …,(i ±qn)mod(N).

Обычно циркулянта представляется в виде матрицы или хордового кольца.

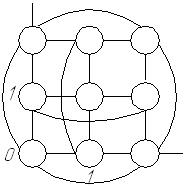

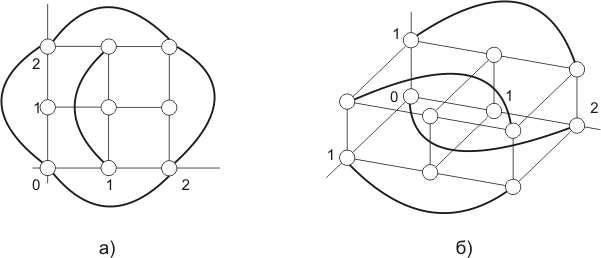

Л(N,ν,g).

N – количество вычислителей.

ν – степень вершин.

g – обхват графа (самый короткий контур (цикл) в графе).

Алгоритм построения такой структуры довольно сложен. Структура представляется в виде матрицы следования.

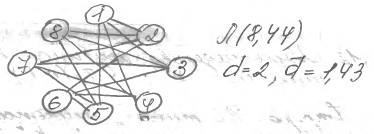

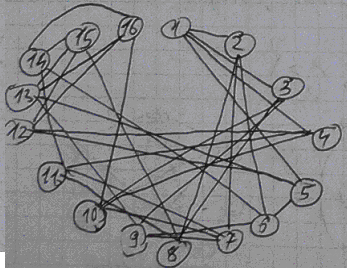

Структура ВС типа «Л(N,ν,g) – граф» описывается графом GS=(M, S*), где M={mi}, i=0, …, N-1; S* – симметричная вычислительная сеть, описываемая матрицей смежности. В матрице смежности пишется: номер элемента – номера элементов, с которым он соединяется. (на рисунке Л(8,4,4) и Л(16,4,4))

7. Структура вычислительных систем типа «бинарное дерево», «мультидерево глубины n и ширины k».

Б инарное

дерево To(n).

инарное

дерево To(n).

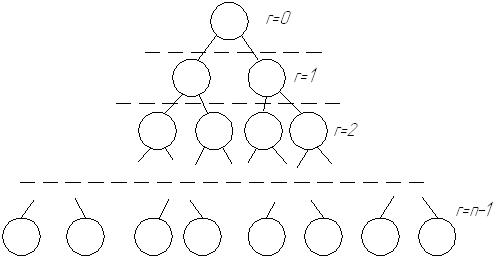

Структура ВС типа «бинарное дерево» обозначается To(n) глубины n описывается графом GS=(M, S*), где M={mi}, i=0, …, N-1, N=2n-1;

Содержит n рангов r (r={0, …,n-1}), причем в каждом ранге размещается ровно 2r вершин так, что каждая вершина ранга r (0<r<n-2) соединяется с парой вершин ранга r+1.

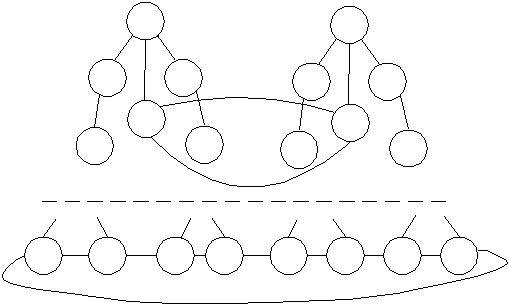

Мультидерево глубины n и ширины k T1(n, k).

С

![]()

![]()

![]()

![]()

![]() труктура

ВС типа «Мультидерево глубины n

и ширины k»

T1(n,

k),

число вычислителей N=k*2n

описывается графом GS=(M,

S*),

где M={mi},

i=0,

…, N-1,

а сеть S*

содержит k

двоичных деревьев, объединенных с

помощью колец R0

и R1.

труктура

ВС типа «Мультидерево глубины n

и ширины k»

T1(n,

k),

число вычислителей N=k*2n

описывается графом GS=(M,

S*),

где M={mi},

i=0,

…, N-1,

а сеть S*

содержит k

двоичных деревьев, объединенных с

помощью колец R0

и R1.

К![]() орневая

вершина

орневая

вершина

![]() j={1,

…,k}

каждого из k

деревьев соединена ребром с вершиной

j={1,

…,k}

каждого из k

деревьев соединена ребром с вершиной

![]() и они образуют

кольцо R0

(

и они образуют

кольцо R0

(![]() ,

,![]() ,

…,

,

…,![]() ).

Второе кольцо R1

образованно вершинами листьев и содержит

k*2n-1

элементов.

).

Второе кольцо R1

образованно вершинами листьев и содержит

k*2n-1

элементов.

8. Характеристика коммутаторов вычислительных систем.

Наиболее часто используются следующие:

Простые коммутаторы с временным разделением (с общей шиной);

Простые коммутаторы с пространственным разделением.

Сосредоточенные составные коммутаторы.

Распределенные составные коммутаторы.

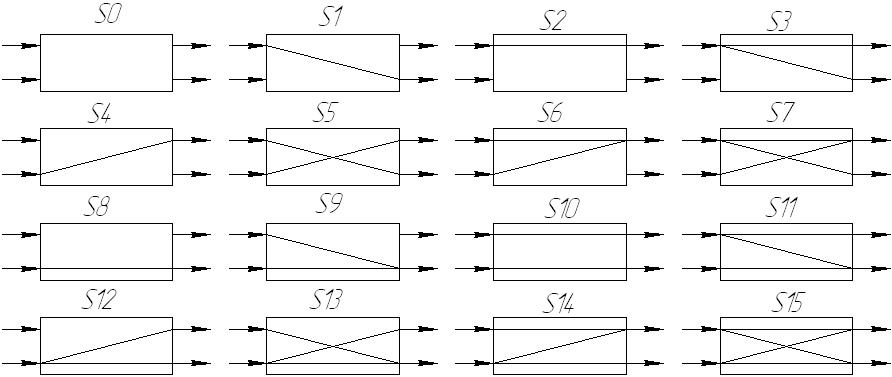

Коммутаторы с пространственным разделением: n входов и m выходов. Например, n=m=2.

Количество состояний коммутатора Q=2k, где k –количество связей в коммутаторе.

k=1 (S1, S2, S4, S8) – простые коммутаторы 1-го типа.

k=2 (S3, S5, S6, S9, S10, S12) – простые коммутаторы 2-го типа.

k=3 (S7, S11, S13, S14) – простые коммутаторы 3-го типа.

k=4 (S15) – простые коммутаторы 4-го типа (коммутатор Клоза –соединяет n входов и m выходов).

Баньян-сети: существует путь от каждого из n входов к каждому из m выходов (S5).

Коммутаторы объединяются в цепочки для создания более сложных.

Коммутаторы, управляемые с помощью программы, называются транспьютерами( коммутаторы с программируемой архитектурой, или динамические). Не управляемые с помощью программ – статические.

9. Архитектурные свойства вычислительной сети и описание процессов её функционирования.

Описание процесса функционирования сети.

Сеть функционирует

с помощью алгоритма А,

который управляет вычислителями Сi

C,

i=0,

…, N-1

на сети G.

В алгоритм А

входит совокупность программ:

![]() , причем

, причем

![]() ,

которые осуществляют вычисления. Набор

данных:

,

которые осуществляют вычисления. Набор

данных:

![]() ,

,

![]() –

для каждой программы свой.

–

для каждой программы свой.

Алгоритм А

представляется совокупностью:

![]() ,

где

,

где

![]() – вычислительная часть, а

– вычислительная часть, а

![]() –

обеспечение связи через сеть.

–

обеспечение связи через сеть.

![]() – обеспечивает

аппаратно-программную часть.

– обеспечивает

аппаратно-программную часть.

Аппаратные средства, с помощью которых реализуется совокупность алгоритмов Ai, i=0,…,N-1, и которые вместе с сетью связей составляют среду для осуществления взаимодействия между вычислителями ВС, называются коммутаторами.

Программно-аппаратные средства, с помощью которых реализуется совокупность программ Pi, i=0,…,N-1, и которые вместе с сетью связей составляют среду для осуществления взаимодействия между вычислителями ВС, называются коммутаторами с программируемой структурой.

У большинства ВС алгоритмы Ai=Aj, i, j=1, …,N-1, и программы Рi=Рj. Такие системы называются однородными. На них можно решать любые задачи, но лучше всего – решать ДУ, находить коэффициенты Фурье.

Принципы технической реализации ВС.

При технической реализации ВС используются принципы модульности и близкодействия.

Принцип модульности

заключается в следующем: ВС формируется

из унифицированных модулей Mi,

![]() где R

– количество

разнообразных моделей в системе. Каждый

модуль функционально закончен; имеются

модули сопряжения. Набор модулей

представляет функционально законченный

набор процессоров, что означает, что

можно решать любую задачу. Помимо полного

набора Mi,

может быть набор Min,

где R

– количество

разнообразных моделей в системе. Каждый

модуль функционально закончен; имеются

модули сопряжения. Набор модулей

представляет функционально законченный

набор процессоров, что означает, что

можно решать любую задачу. Помимо полного

набора Mi,

может быть набор Min,

![]() т.е. можно брать подмножество из множества

Mi

и получать другую ВС с другими

характеристиками.

т.е. можно брать подмножество из множества

Mi

и получать другую ВС с другими

характеристиками.

Модульность обеспечивает:

возможность использования любого модуля для выполнения любого соответствующего задания пользователя.

простая замена одного модуля на однотипный.

масштабируемость – можно уменьшить или увеличить количество модулей без коренной реконфигурации связей между остальными модулями.

открытость систем для модернизации, что исключает ее моральное старение.

В системах с массовым параллелизмом, в которых есть только один модуль, обладающий вычислительной и соединительной полнотой, то, что стоит в узле, называется элементарным процессором (машиной); его разрядность колеблется от 1 до 64.

Близкодействие обуславливает такую организацию информационного взаимодействия между модулями вычислителя, при которой каждый из них может непосредственно обмениваться информацией с весьма ограниченной частью модулей вычислителя, следовательно, структура ВС позволяет осуществлять взаимодействие между удаленными вершинами вычислителя лишь с помощью промежуточных вершин вычислителя, передающих информацию от точки к точке. Удаленными считаются вершины, расстояние между которыми >1.

Принцип близкодействия допускает реализацию механизма управления ВС, не зависящего от числа вычислителей. Данный принцип, в частности, выражается в том, что поведение каждого вычислителя Сi C зависит только от ограниченного подмножества С* C.

Во взаимосвязи с принципом близкодействия говорят о локальной связи вычислителя. Последнее означает, что состояние вычислителя Сi на очередном временном шаге (t+1) зависит от состояния на предыдущем шаге t вычислителей Сj C*, непосредственно связанных с ним.

Т.о., состояние Еi

на шаге (t+1)

есть функция:

![]() ,

т.е. состояние вычислителя зависит от

его локального окружения.

,

т.е. состояние вычислителя зависит от

его локального окружения.

ВС основанные на принципах модульности и близкодействия, обладают рядом ценных свойств, таких как децентрализованность, асинхронность и распределенность.

Асинхронность: функция ВС обеспечивается, если порядок срабатывания ее модулей определяется не с помощью выработанных тем или иным образом отметок времени, а достижением заданных значений.

Использование асинхронных схем позволяет достичь в системе алгоритмически предельного быстродействия. Модули ВС срабатывают немедленно после достижения соответствующего условия. Применение асинхронных схем обмена информацией между вычислителями позволяет не учитывать разброс в их тактовых частотах и длительностях импульсов сигналов линей связи.

Архитектурные свойства ВС.

Имеется ряд свойств ВС, которые обеспечивают ей значительные преимущества перед раннее создаваемыми вычислительными комплексами. К таким свойствам относят:

Масштабируемость. Обеспечивает способность к наращиванию и сокращению производительности ВС, что дает возможность в течение длительного времени быть адекватным средством решения сложных задач. Это означает, в частности, что производительность, достигнутую на заданном количестве вычислителей, можно увеличить, подключив к ВС новые вычислители. Свойство наращивания производительности представляет потенциальную возможность решать задачи любой сложности.

Универсальность. Обеспечивается тем, что она состоит из вычислителей, поэтому любая задача, для которой составлен алгоритм, может быть решена на ВС с той или иной степенью эффективности – сколько вычислителей может быть использовано для решения поставленной задачи и насколько хорошо распараллеливается заданный алгоритм.

Производительность ВС достигается за счет усложнения структуры. Пределы увеличения производительности полностью зависят от масштабируемости.

Реконфигурируемость ВС бывает статической и динамической. В статическом режиме приспособление структуры ВС под класс решаемых задач (выбор количества вычислителей, структуры сети), определяется предварительно на этапе подготовки задачи к выполнению. При этом возможно, при наличии времени, оптимальный или квазиоптимальный подбор конфигурации сети. При решении задач в случае дефицита времени конфигурация сети определяется динамически на основе быстро решаемых эвристических алгоритмов.

Надежность и «живучесть». (см. след. вопрос)

Самоконтроль и самодиагностика.

Важным фактором функционирования ВС является самоконтроль и самодиагностика, что обеспечивает и высокую надежность и «живучесть». В качестве контрольно-диагностического подмножества ВС может быть использованы любые исправные вычислители, а в пределах этого подмножества – любой вычислитель. Выбор диагностического подмножества ВС производиться, как правило, автоматически.

Технико-экономическая эффективность.

Не менее ценным свойством ВС является конструктивная однородность , что резко увеличивает её технико-экономическую эффективность. Это свойство ВС позволяет резко снизить сроки ее разработки, и приводит к повышению технологичности производства, упрощает статическую и динамическую реконфигурацию, облегчает техническую эксплуатацию.

10. Надежность и живучесть вычислительной системы.

Под надежностью вычислительной сети понимается ее способность к автоматической настройке и функционированию таких структурных схем, которые при отказах и восстановлениях вычислительной сети обеспечивают заданный уровень производительности.

Отказ – событие, при котором система теряет способность выполнять функции, связанные с реализацией параллельной программы, с заданным числом ветвей. Если вычислительная сеть находится в состоянии отказа, то число неисправных вычислителей превосходит число вычислителей, составляющих структуру избыточности.

Под живучестью вычислительной сети понимается свойство вычислительной сети, которое в условиях отказов и восстановления вычислительной сети гарантирует производительность в заданных пределах при выполнении параллельной программы даже в случае отсутствия зарезервированных вычислителей.

Полный отказ – событие, состоящее в том, что система теряет способность к выполнению параллельной программы.

Частичный отказ – событие, при котором имеет место отказы вычислителей, однако сохраняется возможность реализации на вычислительной сети параллельной программы.

11А. Схемы обмена информацией между ветвями параллельных алгоритмов.

Дифференцируемый обмен (1 источник, 1 приемник; Малоэффективен).

Трансляционный обмен (1 источник, все приемники). (one to all broadcast)

Трансляционно-циклический обмен – источник постоянно «двигается». Тот, кто был приемником, становиться источником, и наоборот. (за n тактов) (all to all broadcast)

Конвейерно-параллельный обмен – все нечетные номера становятся источниками, а четные – приемниками, а затем они меняются. (за 2 такта)

Коллекторный (по сути – инвертированный трансляционный обмен). Вычислитель передатчик становится приемником. В одну ветвь собирается информация из l≤ n ветвей. Такой обмен требует n тактов и реализуется как последовательность n дифференцируемых обменов.

Имеется статистика частоты использования схем обмена информацией при реализации крупноблочных параллельных алгоритмов. Которая представлена в таблице:

-

Тип обмена

ДО

ТО

ТЦО

КПО

КО

Частота использования

2%

17%

40%

34%

7%

12. Структурные характеристики вычислительных систем.

Структурные задержки при передаче информации между узлами характеризуются d и

ВС.

ВС.Структурная коммутируемость. Характеризуется вектор-функцией:

![]()

Координата

![]() - вероятность реализации в системе

вероятности одновременных непересекающихся

межмашинных взаимодействий (n)

при заданной структуре сети G

и коэффициенту готовности S

вычислителя и коэффициенту готовности

- вероятность реализации в системе

вероятности одновременных непересекающихся

межмашинных взаимодействий (n)

при заданной структуре сети G

и коэффициенту готовности S

вычислителя и коэффициенту готовности

![]() сети.

сети.

Структурная коммутируемость характеризует способность ВС к параллелизации обмена между вычислителями. При этом требуется чтобы:

При дифференцируемом обмене имелась возможность реализации 1 обмена между двумя вычислителями.

При трансляционном обмене реализовалась одновременная передача информации от одного вычислителя во все остальные.

При конвейерно-параллельном обмене выполнялось одновременно

взаимодействий между парами вычислителей.

взаимодействий между парами вычислителей.