Лабораторная работа 1.3 по ирс исследование эффективного кодирования с укрупнением алфавита

1 Цель работы

1.1 Изучение принципа укрупнения алфавита с целью эффективного (экономного) кодирования.

1.2 Исследование эффективности кодирования с укрупнением алфавита для дискретных источников без памяти и с памятью.

2 Ключевые положения

2.1 Дискретный источник сообщений – это источник, который выдает последовательность знаков конечного алфавита объема MA. Дискретные источники классифицируются на:

– источники без памяти – появление любого знака последовательности не зависит от предыдущих знаков. Такой источник задается безусловными вероятностями знаков алфавита P(ak), для k = 1, 2,…, MA.

– источник с памятью – появление любого знака последовательности зависит от предыдущих знаков. Такой источник задается условными вероятностями знаков алфавита. Для математического описания дискретных источников с памятью используют цепи Маркова и такие источники называются марковскими K-го порядка. В этом случае появление любого знака последовательности зависит только от K предыдущих знаков. Тогда марковский источника 1-го порядка (когда вероятность появления знака в последовательности зависит только от предыдущего) будет задаваться условными вероятностями P(ak / aj), для k, j = 1, 2,…, MA.

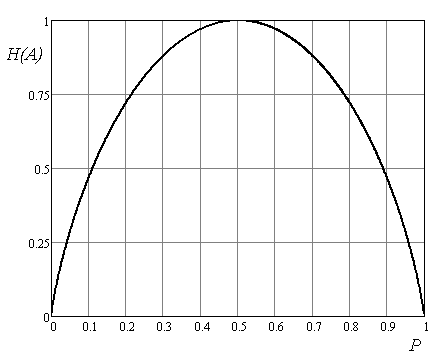

2.2 Двоичный источник дискретных сообщений (MA = 2) без памяти задается безусловными вероятностями P(a1) = p и P(a2) = (1 – p). Зависимость энтропии такого источника от p показана на рис. 1 и записывается как:

H(A)

= –plog2p

– (1 – p)log2(1

– p). (1)

H(A)

= –plog2p

– (1 – p)log2(1

– p). (1)

Э

Рисунок

1

– Зависимость энтропии H(A)

от вероятности p

H(A),

дв.ед./знак

p

2.3 Для марковского двоичного источника сообщений с памятью 1-го порядка необходимо задать условные вероятностями P(a1 / a1), P(a1 / a2), P(a2 / a1) и P(a2 / a2). Энтропия такого источника определяется:

H(A)

= –

![]()

![]() . (2)

. (2)

Пример 1. Задан марковский двоичный источник сообщений с памятью 1-го порядка с вероятностями P(a1) = P(a2) = 0,5; P(a1 / a1) = P(a2 / a2) = 0,3; P(a1 / a2) = P(a2 / a1) = 0,7. Найти энтропию источника.

По формуле (2) находим

H(A) = – 0,5(0,3log20,3 + 0,7log20,7) – 0,5(0,3log20,3 + 0,7log20,7) = 0,881бит/знак

Энтропия источника с памятью меньше, чем энтропия двоичного источника без памяти с равными вероятностями (Hmax(A) = 1 бит/знак). В этом случае избыточность обусловлена статистической связью между знаками.

2.4 В случае двоичного источника без памяти, когда знаки разновероятны, то энтропия меньше 1 дв.ед./знак (рис. 1). К примеру, P(a1) = 0,8 , P(a2) = 0,2. Тогда энтропия равна H(A) = 0,722 дв.ед./знак. Применение эффективного кодирования (например, кода Хаффмана) к такому двоичному источнику не даст никакого эффекта (каждый из знаков будет кодироваться одним битом, независимо от вероятностей их появления). Для эффективного кодирования требуется предварительное укрупнение алфавита.

Под укрупнением алфавита будем понимать формирование нового алфавита укрупненных знаков (укрупненный знак является сочетанием из m знаков первичного алфавита). Объем нового (вторичного) алфавита MB определяется как

MB

=

![]() . (3)

. (3)

Кодирование такого укрупненного (вторичного) алфавита будет более эффективным.

Пример 2. Рассмотрим укрупнение по 3 знака (m = 3) для двоичного источника без памяти приведенного выше с энтропией H(A) = 0,722 бит/знак.

Т.к. двоичный источник без памяти (т.е. источник выдает знаки независимо друг от друга), то из теории вероятности известно, что вероятность появления укрупненного знака будет равна произведению вероятностей входящих в него знаков первичного алфавита (P(a1a1) = P(a1) P(a1)). Объем укрупненного алфавита по формуле (3) равен MB = = 23 = 8. Рассчитаем вероятности укрупненных знаков и применим к ним эффективное кодирование (например, метод Шеннона-Фано) (табл. 1).

Таблица 1 – кодирование укрупненного алфавита

-

Укрупн. знак bi

Вероятность P(bi)

Подгруппы

Кодовые комбинации

I

II

III

IV

V

a1a1a1

0,512

0

0

a1a1a2

0,128

1

0

0

100

a1a2a1

0,128

1

101

a2a1a1

0,128

1

0

110

a1a2a2

0,032

1

0

0

11100

a2a1a2

0,032

1

11101

a2a2a1

0,032

1

0

11110

a2a2a2

0,008

1

11111

Рассчитаем среднюю длину кодовой комбинации укрупненных знаков:

![]() =

2,184

символов

=

2,184

символов

а среднее число кодовых символов на знак определяется как

![]() . (4)

. (4)

Для

рассмотренного случая получим

![]() = 0,728 символов. При сравнении с энтропией

H(A) = 0,722

бит/знак

видно, что предварительное укрупнение

алфавита значительно повысило

эффективность сжатия (кодирование

первичного алфавита без укрупнения

давало

= 1).

= 0,728 символов. При сравнении с энтропией

H(A) = 0,722

бит/знак

видно, что предварительное укрупнение

алфавита значительно повысило

эффективность сжатия (кодирование

первичного алфавита без укрупнения

давало

= 1).

С увеличением количества знаков при укрупнении m можно получать более эффективный код, т.е. среднее число кодовых символов на знак будет больше приближаться к энтропии.

2.5 Укрупнение алфавита также целесообразно в случае дискретного источника сообщений с памятью. Известно, что статистическая зависимость между знаками первичного алфавита, расположенных рядом, больше, чем расположенных на расстоянии нескольких знаков. Соответственно, укрупненные знаки будут обладать значительно меньшей зависимостью (очевидно, что чем больше m, тем меньше зависимость между укрупненными знаками). В этом случае (для источника с памятью) для определения вероятностей укрупненных знаков необходимо учитывать условные вероятности (P(a1a1) = P(a1) P(a1 / a1)).

Таким образом, избыточность, обусловленная статистическими связями между знаками первичного алфавита, преобразуется в избыточность, обусловленную различными вероятностями укрупненных знаков. А такую избыточность можно уменьшить, используя эффективное кодирование (например, кодирование Хаффмана).