- •1 Які існують види інформації?

- •2 Як формулюється теорема дискретизації?

- •3 Що таке інформація, кодування, канал зв'язку, шум?

- •4.Що таке ансамблі та джерела повідомлень

- •5 У чому полягають основні положення Шеннона до визначення кількості інформації?

- •7 Що таке ентропія джерела? Які її властивості?

- •9 Що таке умовна ентропія? Які є види умовної ентропії?

- •11 Як знаходиться часткова умовна ентропія?

- •12 Як знаходиться загальна умовна ентропія?

- •13 Які основні властивості умовної ентропії?

- •14 Чим обумовлена статистична надмірність джерела інформації?

- •15 Чим описується інформаційний канал?

- •17 Чим визначається ентропія об'єднання двох джерел інформації?

- •18 Які основні властивості взаємної ентропії?

- •19 Як знаходиться кількість інформації на одне повідомлення двох статистично залежних джерел?

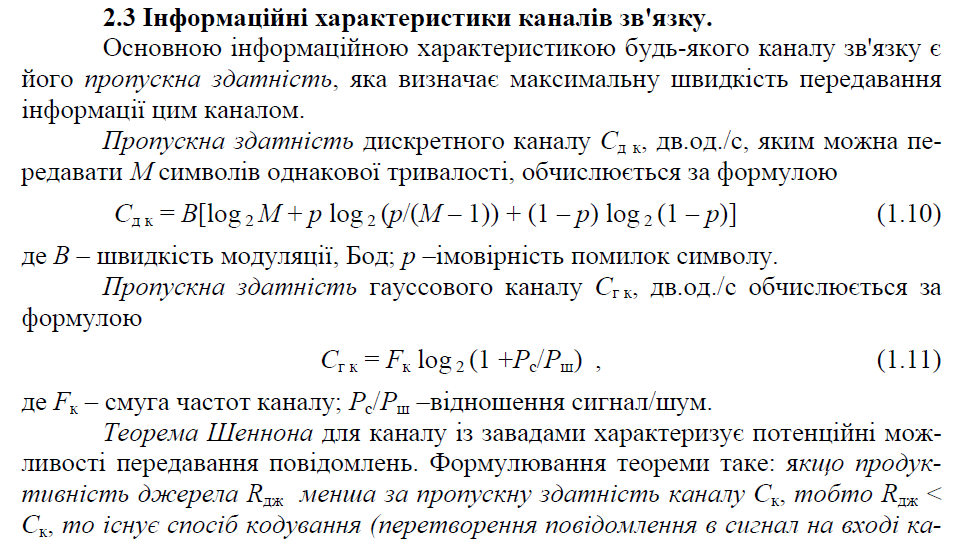

- •27 Що таке продуктивність джерела інформації?

- •28 Що таке швидкість передачі інформації по каналу зв'язку та як вона визначається?

- •30 Як формулюється теорема Шеннона про кодування дискретного джерела за відсутності завад?

- •32 Як формулюється теорема Шеннона про кодування дискретного джерела за наявності завад?

- •33 Якими статистичними моделями описуються джерела інформації?

11 Як знаходиться часткова умовна ентропія?

Часткова умовна ентропія - це кількість інформації, що припадає на одне повідомлення джерела X за умови встановлення факту вибору джерелом Y повідомлення yj, або кількість інформації, що припадає на одне повідомлення джерела Y за умови, що відомий стан джерела X:

, (1.16)

, (1.17)

де , - алфавіти повідомлень; xi - певне повідомлення джерела X, щодо якого визначається часткова умовна ентропія H(Y/xi) алфавіту Y за умови вибору джерелом X повідомлення xi; yj - певне повідомлення джерела Y, щодо якого визначається часткова умовна ентропія H(X/yj) алфавіту X за умови вибору повідомлення yj; i - номер повідомлення з алфавіту X; j - номер повідомлення з алфавіту Y; p(xi/yj), p(yj/xi) – умовні імовірності.

---------------------------------------------------------------------------------------------------

12 Як знаходиться загальна умовна ентропія?

Загальна умовна ентропія визначається так:

, (1.18)

. (1.19)

Отже, загальна умовна ентропія (1.18) - це середньостатистична кількість інформації (математичне сподівання), що припадає на будь-яке повідомлення джерела X, якщо відомий його статистичний взаємозв'язок з джерелом Y. Так само загальна умовна ентропія (1.19) - це середня кількість інформації, яка міститься в повідомленнях джерела Y за наявності статистичного взаємозв'язку з джерелом X.

---------------------------------------------------------------------------------------------------

13 Які основні властивості умовної ентропії?

Властивості умовної ентропії:

1) якщо джерела повідомлень X і Y статистично незалежні, то умовна ентропія джерела X стосовно Y дорівнює безумовній ентропії джерела X і навпаки:

H(X/Y)=H(X), H(Y/X)=H(Y);

2) якщо джерела повідомлень X і Y настільки статистично взаємозв'язані, що виникнення одного з повідомлень спричиняє безумовну появу іншого, то їхні умовні ентропії дорівнюють нулю:

H(X/Y)=H(Y/X)=0;

3) ентропія джерела статистично взаємозалежних повідомлень (умовна ентропія) менша від ентропії джерела незалежних повідомлень (безумовної ентропії):

H(X/Y)<H(X), H(Y/X)<H(Y).

---------------------------------------------------------------------------------------------------

14 Чим обумовлена статистична надмірність джерела інформації?

З властивості 3 випливає поняття статистичної надмірності, обумовленої наявністю статистичної залежності між елементами повідомлення:

![]() ,

(1.22)

,

(1.22)

де H(X/Y) - загальна умовна ентропія джерела X стосовно джерела Y; H(X) - безумовна ентропія джерела X.

Наявність статистичної надмірності джерела інформації дозволяє використовувати кодування інформації, націлене на зменшення її надмірності. Таке кодування називається ефективним, або статистичним.

15 Чим описується інформаційний канал?

![]()

17 Чим визначається ентропія об'єднання двох джерел інформації?

Ентропію H(X, Y) об'єднання двох джерел інформації X і Y знаходять через імовірності p(xi, yj) системи випадкових повідомлень xi, yj для всіх i=1...k, і j=1...l. Для цього складається матриця ймовірностей системи двох статистично залежних джерел

![]() . (1.25)

. (1.25)

Ентропія об'єднання двох джерел H(X, Y) (взаємна ентропія) - це середня кількість інформації, що припадає на два будь-які повідомлення джерел X і Y:

![]() .

(1.26)

.

(1.26)

З рівності p(xi, yj)= p(yj, xi) випливає, що

H(X, Y)=H(Y, X).

---------------------------------------------------------------------------------------------------