- •1.1. Понятие информации и ее свойства

- •Позиционные системы счисления

- •1. Базис, алфавит, основание.

- •7.3. Числа с фиксированной точкой

- •8. Числа с плавающей точкой (вещественные)

- •. Диапазон представления вещественных чисел

- •9. Кодирование текста

- •10. Кодирование графической информации

- •Принцип действия

- •22. Операционная система

- •Операционная система Windows 7

- •Функции операционных систем

1.1. Понятие информации и ее свойства

Информация (от латинского informatio – разъяснение, изложение) – в самом общем понимании представляет собой меру распределения материи и энергии в пространстве и во времени, меру изменений, которыми сопровождаются все протекающие в мире процессы.

В исследованиях, связанных с понятием информации, много нерешенных вопросов. До сих пор длится дискуссия, является ли информация свойством всего материального, или – только живых организмов, или – исключительно разумных, сознательно действующих существ.

В настоящее время известно множество определений информации как результат научной дискуссии и различных подходов к трактовке данного понятия (технического, правового, социального и других), см., например. Общего определения информации до сих пор не выработано. Определения информации давали такие широко известные ученые, как Н.Винер, Р.Хартли, К.Шеннон, Н.Рашевский и другие. Ниже приведены некоторые из наиболее распространенных определений.

Информация:

![]() фундаментальная

первооснова и всеобщее свойство

Вселенной, которая существует независимо

от нас, проявляется в трехмерном процессе

взаимодействия микро- и макропроцессов

энергии, движения и массы в пространстве

и времени;

фундаментальная

первооснова и всеобщее свойство

Вселенной, которая существует независимо

от нас, проявляется в трехмерном процессе

взаимодействия микро- и макропроцессов

энергии, движения и массы в пространстве

и времени;

результат отражения движения объектов материального мира в системах живой природы;

свойство материи изменяться и отражать это изменение;

сообщение, описание фактов;

новости, новые сведения;

"отраженное разнообразие";

снятая неопределенность, связанная со случайными процессами, а также с превращением возможности в действительность;

свойство объекта уменьшать неопределенность процесса изменения его состояния во времени;

снятие (устранение) неопределенности, где неопределенность – недостаточное знание об объектах и явлениях (отождествляется с неинформированностью субъекта);

уменьшение неопределенности в результате сообщения;

степень модификации структуры входными данными;

передача, основа связи и управления в живой природе и машинах;

сведения о лицах, предметах, событиях, явлениях и процессах независимо от формы их представления, используемые в целях получения знаний, принятия решений.

Информация – отражение в психике закона существования мира (психическое отражение мира):

как инвариант обратимых трансформаций поступающего к субъекту сообщения;

инвариант: величина, остающаяся неизменной при тех или иных преобразованиях;

единица, заключающая в себе все основные признаки своих конкретных реализаций;

сведения об окружающем мире и протекающих в нем процессах, воспринимаемые биологическим объектом или специальным устройством.

Информация об объекте есть изменение параметра наблюдателя, вызванное взаимодействием наблюдателя с объектом.

Информация имеет ряд важных особенностей.

1. Собственно об информации можно говорить лишь тогда, когда хотя бы одним объектом в материальном взаимодействии является живой организм. Исходя из этого, информация есть воспринимаемая живым организмом через органы чувств окружающая действительность в виде распределения материи и энергии во времени и в пространстве и процессов их перераспределения.

2. Информация не материальна, хотя ее носителем является материя.

3. Чем сложнее объект материального мира или процесс, тем больше информации он в себе несет.

4. Чем сложнее организм, тем больше вариантов его поведения может соответствовать одной и той же полученной информации.

В отечественной науке сложились две основные концепции восприятия информации как явления – атрибутивная и функциональная.

Сторонники атрибутивной концепции (Б.В. Ахлибинский, Л.Б. Баженов, Б.В. Бирюков, К.Е. Морозов, И.Б. Новик, Л.А. Петрушенко, А.Д. Урсул и др.) считают информацию свойством всех материальных объектов, т.е. атрибутом материи.

Сторонники функциональной концепции (В.В. Вержбицкий, Г.Г. Вдовиченко, И.И. Гришкин, Д.И. Дубровский, Н.И. Жуков, А.М. Коршунов, М.И. Сетров и др.) связывают информацию с функционированием самоорганизующихся систем. Этими самоорганизующимися системами являются живые организмы и, возможно, в будущем кибернетические устройства.

Всякая информация обладает тремя основными параметрами:

количеством;

содержанием;

ценностью.

Количественный момент исследуется в основном математической статистикой, содержательный – семантической теорией. Самую известную формулу количества информации предложил К. Шеннон: количество информации выражается количественным изменением неопределенности в результате сообщения. А. Колмогоров решает проблему алгоритмически: здесь количество информации соответствует сложности алгоритма, переводящего систему из одного состояния в другое. Суть семантического подхода к проблеме: информация есть осмысленные тексты, состоящие из знаков некоторого языка. Существует система, в которой эти знаки различимы и осмысленны (носители информации). Осмысление предполагает, что знаки известны воспринимающей системе (приемнику информации). Последняя должна содержать в себе подсистему, позволяющую объяснить каждое

понятие с помощью набора других понятий – так называемый тезаурус. Информация воспринимается приемником посредством цепочки трансляций – перевода тезаурусом знаков языка носителя на язык приемника. На основе полученной таким образом информации система реагирует на окружающий мир. Понятие информации – основное в кибернетической теории Н. Винера и его последователей, утверждающих, что все процессы управления и связи в живой природе, обществе, машинах представляют собой процесс передачи, хранения и переработки информации. Действующий объект поглощает последнюю из окружающего мира и использует ее для выбора правильного поведения. Количество информации есть количество выбора, или отрицательная энтропия – основа и средство борьбы с кибернетическим "шумом", искажающим информацию (в термодинамическом смысле "шум" означает возрастание энтропийного хаоса).

Информация включает содержательную и представительскую составляющие. Содержательная составляющая информации отражает ее сущностную сторону, связанную с отражением реальной действительности. Представительская составляющая определяет форму представления информации для передачи, обеспечения ее адекватного восприятия потребителем.

Информация характеризуется формой представления, содержанием и затратами интеллектуального труда человека на ее создание.

Форма представления информации может быть классифицирована по:

степени упорядоченности;

форме закрепления;

доступности.

Основными свойствами информации являются:

способность воздействовать на психику;

значимость (полнота);

достоверность;

целостность;

адекватность.

Способность воздействовать на психику – неотъемлемое свойство информации. Фундаментальное свойство информации (применительно к человеку) – оторвавшись от объекта отражения существовать самостоятельно, стать содержимым памяти, то есть самостоятельно участвовать в психических процессах, трансформируясь в представления, знания, умения, навыки.

Значимость информации – свойство информации сохранять свою потребительскую ценность для получателя в течение времени, т.е. не подвергаться моральному старению.

Достоверность информации – соответствие полученной информации действительной обстановке. Достоверность достигается:

обозначением времени свершения событий, сведения о которых передаются;

тщательным изучением и сопоставлением данных, полученных из различных источников;

проверкой сомнительных сведений; своевременным скрытием дезинформационных и маскировочных мероприятий;

исключением искаженной информации, передаваемой по техническим средствам.

Целостность информации – это неизменность информации в условиях случайных или преднамеренных действий в процессе эксплуатации информационной системы. Под целостностью информации также понимается актуальность и непротиворечивость информации, ее защищенность от разрушения и несанкционированного изменения.

Адекватность или старение информации – свойство информации утрачивать со временем свою практическую ценность, обусловленное изменением состояния отображаемой ею предметной области.

2 Синтаксическая мера информации.

Эта мера количества информации оперирует с обезличенной информацией, не выражающей смыслового отношения к объекту. На синтаксическом уровне учитываются тип носителя и способ представления информации, скорость передачи и обработки, размеры кодов представления информации.

Объём данных (VД) понимается в техническом смысле этого слова как информационный объём сообщения или как объём памяти, необходимый для хранения сообщения без каких-либо изменений.

Информационный объём сообщения измеряется в битах и равен количеству двоичных цифр (“0” и “1”), которыми закодировано сообщение.

В компьютерной практике слово “бит” используется также как единица измерения объёма памяти. Ячейка памяти размером в 1 бит может находиться в двух состояниях (“включено” и “выключено”) и в неё может быть записана одна двоичная цифра (0 или 1). Понятно, что бит — слишком маленькая единица измерения информации, поэтому пользуются кратными ей величинами. Основной единицей измерения информации является байт. 1 байт равен 8 битам. В ячейку размером в 1 байт можно поместить 8 двоичных цифр, то есть в одном байте можно хранить 256 = 28 различных чисел. Для измерения ещё бóльших объёмов информации используются такие величины:

1 Килобайт = |

210 байт = |

1024 байт |

1 Мегабайт = |

210 Килобайт = |

1024 Килобайт |

1 Гигабайт = |

210 Мегабайт = |

1024 Мегабайт |

1 Терабайт = |

210 Гигабайт = |

1024 Гигабайт |

Пример 1.2.1. Важно иметь представление, сколько информации может вместить килобайт, мегабайт или гигабайт. При двоичном кодировании текста каждая буква, знак препинания, пробел занимают 1 байт. На странице книги среднего формата примерно 50 строк, в каждой строке около 60 символов, таким образом, полностью заполненная страница имеет объём 50 x 60 = 3000 байт ≈3 Килобайта. Вся книга среднего формата занимает ≈ 0,5 Мегабайт. Один номер четырёхстраничной газеты — 150 Килобайт. Если человек говорит по 8 часов в день без перерыва, то за 70 лет он наговорит около 10 Гигабайт информации. Один чёрно-белый кадр (при 32 градациях яркости каждой точки) содержит примерно 300 Кб информации, цветной кадр содержит уже около 1 Мб информации. Телевизионный фильм продолжительностью 1,5 часа с частотой 25 кадров в секунду — 135 Гб.

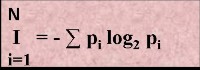

Количество информации I на синтаксическом уровне определяется через понятие энтропии системы.

Пусть до получения информации потребитель имеет некоторые предварительные (априорные) сведения о системе α. Мерой его неосведомленности о системе является функция H(α), которая в то же время служит и мерой неопределенности состояния системы.

После получения некоторого сообщения β получатель приобрел некоторую дополнительную информацию Iβ(α), уменьшившую его априорную неосведомленность так, что неопределенность состояния системы после получения сообщения β стала Hβ(α).

Тогда количество информации Iβ(α) ξ системе, полученной в сообщении β, определится как

Iβ(α)=H(α)-Hβ(α).

т.е. количество информации измеряется изменением (уменьшением) неопределенности состояния системы. Если конечная неопределенность Hβ(α) ξбратится в нуль, то первоначальное неполное знание заменится полным знанием и количество информации Iβ(α)=H(α). Иными словами, энтропия системы Н(а) может рассматриваться как мера недостающей информации.

Энтропия системы H(α), θмеющая N возможных состояний, согласно формуле Шеннона, равна:

![]() ,

где Pi

—

вероятность того, что система находится

в i-м состоянии. Для случая, когда все

состояния системы равновероятны, т.е.

их вероятности равны Pi

=

,

где Pi

—

вероятность того, что система находится

в i-м состоянии. Для случая, когда все

состояния системы равновероятны, т.е.

их вероятности равны Pi

=![]() ,

ее энтропия определяется соотношением

,

ее энтропия определяется соотношением

![]() .

.

Пример 1.2.2. Часто информация кодируется числовыми кодами в той или иной системе счисления, особенно это актуально при представлении информации в компьютере. Естественно, что одно и то же количество разрядов в разных системах счисления может передать разное число состояний отображаемого объекта, что можно представить в виде соотношения

N=mn,

где N — число всевозможных отображаемых состояний; m — основание системы счисления (разнообразие символов, применяемых в алфавите); n —число разрядов (символов) в сообщении. Допустим, что по каналу связи передается n-разрядное сообщение, использующее m различных символов. Так как количество всевозможных кодовых комбинаций будет N=m", то при равновероятности появления любой из них количество информации, приобретенной абонентом в результате получения сообщения, будет

I=log N=n log m — формула Хартли.

Если в качестве основания логарифма принять m, то / = n. В данном случае количество информации (при условии полного априорного незнания абонентом содержания сообщения) будет равно объему данных /=VД , полученных по каналу связи.

Наиболее часто используются двоичные и десятичные логарифмы. Единицами измерения в этих случаях будут соответственно бит и дит.

Коэффициент (степень) информативности (лаконичность) сообщения определяется отношением количества информации к объему данных, т.е.

![]() .

.

С увеличением Y уменьшаются объемы работы по преобразованию информации (данных) в системе. Поэтому стремятся к повышению информативности, для чего разрабатываются специальные методы оптимального кодирования информации.

Семантическая мера информации

Для измерения смыслового содержания информации, т.е. ее количества на семантическом уровне, наибольшее признание получила тезаурусная мера, которая связывает семантические свойства информации со способностью пользователя принимать поступившее сообщение. Для этого используется понятие тезаурус пользователя.

Тезаурус — это совокупность сведений, которыми располагает пользователь или система.

В зависимости от соотношений между смысловым содержанием информации S и тезаурусом пользователя Sp изменяется количество семантической информации Ic, воспринимаемой пользователем и включаемой им в дальнейшем в свой тезаурус. Характер такой зависимости показан на рис. 1.2.2. Рассмотрим два предельных случая, когда количество семантической информации Ic равно 0:

• при Sp→0 пользователь не воспринимает, не понимает поступающую информацию;

• при Sp→ пользователь все знает, и поступающая информация ему не нужна.

Рис. 1.2.2. Зависимость количества семантической информации, воспринимаемой потребителем, от его тезауруса.

Максимальное количество семантической информации Ic потребитель приобретает при согласовании ее смыслового содержания S со своим тезаурусом Sp (Sp = Sp opt), когда поступающая информация понятна пользователю и несет ему ранее не известные (отсутствующие в его тезаурусе) сведения. Следовательно, количество семантической информации в сообщении, количество новых знаний, получаемых пользователем, является величиной относительной. Одно и то же сообщение может иметь смысловое содержание для компетентного пользователя и быть бессмысленным для пользователя некомпетентного. Относительной мерой количества семантической информации может служить коэффициент содержательности С, который определяется как отношение количества семантической информации к ее объему:

![]()

Прагматическая мера информации

Эта мера определяет полезность информации (ценность) для достижения пользователем поставленной цепи. Эта мера также величина относительная, обусловленная особенностями использования этой информации в той или иной системе.

Ценность информации целесообразно измерять в тех же самых единицах (или близких к ним), в которых измеряется целевая функция.

Для сопоставления введённые меры информации представим в таблице

Мера информации |

Единицы измерения |

Примеры (для компьютерной области) |

|

Синтаксическая: шенноновский подход компьютерный подход |

Степень уменьшения неопределенности

Единицы представления информации |

Вероятность события

Бит, байт. Кбайт и та |

|

Семантическая |

Тезаурус

Экономические показатели |

Пакет прикладных программ, персональный компьютер, компьютерные сети и т.д. Рентабельность, производительность, коэффициент амортизации и тд. |

|

Прагматическая |

Ценность использования |

Емкость памяти, производительность компьютера, скорость передачи данных и т.д. Денежное выражение Время обработки информации и принятия решений |

|

1.3. Качественные характеристики информации.

Формула Хартли-Шеннона для равновероятных событий.

В 1928 г. американский инженер Р. Хартли предложил научный подход к оценке сообщений. Предложенная им формула имела следующий вид:

I = log2 K , Где К - количество равновероятных событий; I - количество бит в сообщении, такое, что любое из К событий произошло. Тогда K=2I. Иногда формулу Хартли записывают так:

I = log2 K = log2 (1 / р) = - log2 р, т. к. каждое из К событий имеет равновероятный исход р = 1 / К, то К = 1 / р.

Задача.

Шарик находится в одной из трех урн: А, В или С. Определить сколько бит информации содержит сообщение о том, что он находится в урне В.

Решение.

Такое сообщение содержит I = log2 3 = 1,585 бита информации.

Но не все ситуации имеют одинаковые вероятности реализации. Существует много таких ситуаций, у которых вероятности реализации различаются. Например, если бросают несимметричную монету или "правило бутерброда".

"Однажды в детстве я уронил бутерброд. Глядя, как я виновато вытираю масляное пятно, оставшееся на полу, старший брат успокоил меня:

- не горюй, это сработал закон бутерброда.

- Что еще за закон такой? - спросил я.

- Закон, который гласит: "Бутерброд всегда падает маслом вниз". Впрочем, это шутка, - продолжал брат.- Никакого закона нет. Прсто бутерброд действительно ведет себя довольно странно: большей частью масло оказывается внизу.

- Давай-ка еще пару раз уроним бутерброд, проверим, - предложил я. - Все равно ведь его придется выкидывать.

Проверили. Из десяти раз восемь бутерброд упал маслом вниз.

И тут я задумался: а можно ли заранее узнать, как сейчас упадет бутерброд маслом вниз или вверх?

Наши опыты прервала мать…" ( Отрывок из книги "Секрет великих полководцев", В.Абчук).

В 1948 г. американский инженер и математик К Шеннон предложил формулу для вычисления количества информации для событий с различными вероятностями. Если I - количество информации, К - количество возможных событий, рi - вероятности отдельных событий, то количество информации для событий с различными вероятностями можно определить по формуле:

I = - Sum рi log2 рi, где i принимает значения от 1 до К.

Формулу Хартли теперь можно рассматривать как частный случай формулы Шеннона:

I = - Sum 1 / К log2 (1 / К) = I = log2 К.

При равновероятных событиях получаемое количество информации максимально.

Задачи. 1. Определить количество информации, получаемое при реализации одного из событий, если бросают а) несимметричную четырехгранную пирамидку; б) симметричную и однородную четырехгранную пирамидку. Решение. а) Будем бросать несимметричную четырехгранную пирамидку. Вероятность отдельных событий будет такова: р1 = 1 / 2, р2 = 1 / 4, р3 = 1 / 8, р4 = 1 / 8, тогда количество информации, получаемой после реализации одного из этих событий, рассчитывается по формуле: I = -(1 / 2 log2 1/2 + 1 / 4 log2 1/4 + 1 / 8 log2 1/8 + 1 / 8 log2 1/8) = 1 / 2 + 2 / 4 + + 3 / 8 + 3 / 8 = 14/8 = 1,75 (бит). б) Теперь рассчитаем количество информации, которое получится при бросании симметричной и однородной четырехгранной пирамидки: I = log2 4 = 2 (бит). 2. Вероятность перового события составляет 0,5, а второго и третьего 0,25. Какое количество информации мы получим после реализации одного из них? 3. Какое количество информации будет получено при игре в рулетку с 32-мя секторами? 4. Сколько различных чисел можно закодировать с помощью 8 бит? Решение: I=8 бит, K=2I=28=256 различных чисел.

Физиологи и психологи научились определять количество информации, которое человек может воспринимать при помощи органов чувств, удерживать в памяти и подвергать обработке. Информацию можно представлять в различных формах: звуковой, знаковой и др. рассмотренный выше способ определения количества информации, получаемое в сообщениях, которые уменьшают неопределенность наших знаний, рассматривает информацию с позиции ее содержания, новизны и понятности для человека. С этой точки зрения в опыте по бросанию кубика одинаковое количество информации содержится в сообщениях "два", "вверх выпала грань, на которой две точки" и в зрительном образе упавшего кубика.

При передаче и хранении информации с помощью различных технических устройств информацию следует рассматривать как последовательность знаков (цифр, букв, кодов цветов точек изображения), не рассматривая ее содержание.

Считая, что алфавит (набор символов знаковой системы) - это событие, то появление одного из символов в сообщении можно рассматривать как одно из состояний события. Если появление символов равновероятно, то можно рассчитать, сколько бит информации несет каждый символ. Информационная емкость знаков определяется их количеством в алфавите. Чем из большего количества символов состоит алфавит, тем большее количество информации несет один знак. Полное число символов алфавита принято называть мощностью алфавита.

Молекулы ДНК (дезоксирибонуклеиновой кислоты) состоят из четырех различных составляющих (нуклеотидов), которые образуют генетический алфавит. Информационная емкость знака этого алфавита составляет:

4 = 2I, т.е. I = 2 бит.

Каждая буква русского алфавита (если считать, что е=е) несет информацию 5 бит (32 = 2I).

При таком подходе в результате сообщения о результате бросания кубика , получим различное количество информации, Чтобы его подсчитать, нужно умножить количество символов на количество информации, которое несет один символ.

Количество информации, которое содержит сообщение, закодированное с помощью знаковой системы, равно количеству информации, которое несет один знак, умноженному на число знаков в сообщении.

Понятие бита, байта. Единицы измерения информации.

В информатике используются различные подходы к измерению информации:

Содержательный подход к измерению информации. Сообщение – информативный поток, который в процессе передачи информации поступает к приемнику. Сообщение несет информацию для человека, если содержащиеся в нем сведения являются для него новыми и понятными Информация - знания человека ? сообщение должно быть информативно. Если сообщение не информативно, то количество информации с точки зрения человека = 0. (Пример: вузовский учебник по высшей математике содержит знания, но они не доступны 1-класснику)

Алфавитный подход к измерению информации не связывает кол-во информации с содержанием сообщения. Алфавитный подход - объективный подход к измерению информации. Он удобен при использовании технических средств работы с информацией, т.к. не зависит от содержания сообщения. Кол-во информации зависит от объема текста и мощности алфавита. Ограничений на max мощность алфавита нет, но есть достаточный алфавит мощностью 256 символов. Этот алфавит используется для представления текстов в компьютере. Поскольку 256=28, то 1символ несет в тексте 8 бит информации.

Вероятностный подход к измерения информации. Все события происходят с различной вероятностью, но зависимость между вероятностью событий и количеством информации, полученной при совершении того или иного события можно выразить формулой которую в 1948 году предложил Шеннон.

Количество информации - это мера уменьшения неопределенности.

1 БИТ – такое кол-во информации, которое содержит сообщение, уменьшающее неопределенность знаний в два раза. БИТ- это аименьшая единица измерения информации

Единицы измерения информации: 1байт = 8 бит

1Кб (килобайт) = 210 байт = 1024 байт

1Мб (мегабайт) = 210 Кб = 1024 Кб

1Гб (гигабайт) = 210 Мб = 1024 Мб

Формула

Шеннона

I - количество информации

N – количество возможных событий

pi – вероятности отдельных событий

Задача1: Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика, если в непрозрачном мешочке находится 50 белых, 25красных, 25 синих шариков

1) всего шаров 50+25+25=100

2) вероятности шаров 50/100=1/2, 25/100=1/4, 25/100=1/4

3)I= -(1/2 log21/2 + 1/4 log21/4 + 1/4 log21/4) = -(1/2(0-1) +1/4(0-2) +1/4(0-2)) = 1,5 бит

Количество

информации достигает max значения,

если события равновероятны, поэтому

количество информации можно расcчитать

по формуле ![]()

Задача2 : В корзине лежит 16 шаров разного цвета. Сколько информации несет сообщение, что достали белый шар?

т.к. N = 16 шаров, то I = log2 N = log2 16 = 4 бит.