- •3. Теория информации

- •3.1. Количественное определение информации

- •3.2. Энтропия источника с памятью

- •3.3. Типичные и нетипичные комбинации

- •Количество и скорость передачи информации по дискретному каналу с шумами

- •Теорема оптимального кодирования

- •Энтропия непрерывного источника сообщений

- •Пропускная способность непрерывного канала связи

3. Теория информации

3.1. Количественное определение информации

Для сравнения между собой различных источников сообщений и каналов связи необходимо ввести количественную меру, позволяющую оценивать информацию содержащеюся в сообщении. Такая мера была введена К. Шеноном в 1946 г.

Предполагается,

что источник дискретных сообщений

выдает последовательность сообщений

![]() из алфавита

из алфавита![]() ,

где k – объем алфавита.

,

где k – объем алфавита.

Каждое из сообщений

![]() содержит информацию о состоянии некоторой

системы, передаваемой адресату данного

сообщения. При оценке количества

передаваемой информации невозможно

учитывать субъективные показатели,

такие как полезность или ценность

передаваемой информации для получателя.

Для оценки количественной меры предаваемой

информации исходят из неопределенности,

которая имеется у получателя сообщения

о том, какое сообщение

содержит информацию о состоянии некоторой

системы, передаваемой адресату данного

сообщения. При оценке количества

передаваемой информации невозможно

учитывать субъективные показатели,

такие как полезность или ценность

передаваемой информации для получателя.

Для оценки количественной меры предаваемой

информации исходят из неопределенности,

которая имеется у получателя сообщения

о том, какое сообщение![]() из возможных сообщений

из возможных сообщений![]() ,

будет получено в следующий момент

времени. Степень неопределенности

получения сообщения

,

будет получено в следующий момент

времени. Степень неопределенности

получения сообщения![]() ,

определяется вероятностью

,

определяется вероятностью![]() передачи сообщения

передачи сообщения![]() из всех возможных сообщений алфавита

дискретного источника. В качестве оценки

количественной меры информации,

содержащиеся в

из всех возможных сообщений алфавита

дискретного источника. В качестве оценки

количественной меры информации,

содержащиеся в![]() ,

можно принять вероятность посылки этого

сообщения

,

можно принять вероятность посылки этого

сообщения![]() .

В связи с тем, что

.

В связи с тем, что![]() образуют

полный алфавит всех возможных сообщений,

образуют

полный алфавит всех возможных сообщений,

![]() .

.

Если рассматривать

сообщение

![]() не как бессмысленный набор букв, а как

определенное сообщение, то вероятность

посылки источником символа

не как бессмысленный набор букв, а как

определенное сообщение, то вероятность

посылки источником символа![]() ,

в общем случае определяется

последовательностью символов посланных

ранее. Например, телетайпный аппарат

передает текстовое сообщение, вероятность

передаваемых символов в этом случае

определяется словом сообщения.

,

в общем случае определяется

последовательностью символов посланных

ранее. Например, телетайпный аппарат

передает текстовое сообщение, вероятность

передаваемых символов в этом случае

определяется словом сообщения.

Количество

информации содержащийся в сообщении

![]() зависит от вероятности посылки этого

сообщения в источнике

зависит от вероятности посылки этого

сообщения в источнике![]() .

Вид функции

.

Вид функции![]() определяется

из следующих предположений:

определяется

из следующих предположений:

если источник посылает только одно сообщение

,

т.е.

,

т.е. ,

то можно утверждать что сообщение не

содержит ни какой полезной информации,

т.е.

,

то можно утверждать что сообщение не

содержит ни какой полезной информации,

т.е.

![]() ; (2.1)

; (2.1)

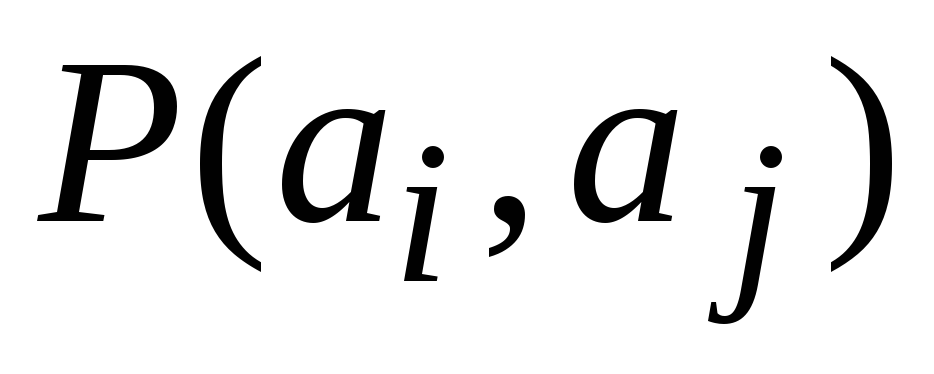

если были посланы последовательно сообщения

и

и ,

вероятность такого события

,

вероятность такого события ,

то количество информации в таком

сообщении равно сумме меры информации

в каждом из сообщений в отдельности.

,

то количество информации в таком

сообщении равно сумме меры информации

в каждом из сообщений в отдельности.

Пусть

![]() – вероятность получения символа

– вероятность получения символа![]() ;

;![]() – вероятность приема символа

– вероятность приема символа![]() после

после

![]() ;

;![]() ,

то вышеизложенные предположения можно

записать так:

,

то вышеизложенные предположения можно

записать так:

![]() . (2.2)

. (2.2)

Обозначим

![]() ,

получим

,

получим

![]() (2.3)

(2.3)

Исходя из того,

что

![]() – конечное множество (

– конечное множество (![]() )

и

)

и

![]() ,

продифференцируем уравнение (2.3) по

,

продифференцируем уравнение (2.3) по

![]() ,

в итоге получим

,

в итоге получим

![]() . (2.4)

. (2.4)

Если ввести

обозначение

![]() ,

и умножить уравнение (2.4) на

,

и умножить уравнение (2.4) на![]() ,

получим

,

получим

![]() . (2.5)

. (2.5)

Это возможно только

если

![]() .

Интегрируя (1.5) получим

.

Интегрируя (1.5) получим

![]() (2.6)

(2.6)

Исходя из предположения (2.1) вид функции определяющий меру информации можно определить как

![]() (2.7)

(2.7)

Масштабный множитель

![]() в уравнении (2.7) выбирается произвольным

образом, обычно с учетом того, что

в уравнении (2.7) выбирается произвольным

образом, обычно с учетом того, что![]() полагают

полагают![]() .

В этом случае

.

В этом случае

![]() (2.8)

(2.8)

Значение

![]() означат, что вероятность приема сообщения

означат, что вероятность приема сообщения![]() составляет

составляет![]() ,

оно называется натуральной единицей.

,

оно называется натуральной единицей.

В вычислительной

технике чаще используют понятие двоичной

единицы или бит. В этом случае используют

![]() .

Формула (2.8) приобретает вид

.

Формула (2.8) приобретает вид

![]() (2.9)

(2.9)

Бит означает получение одного из двух равно вероятных событий.

Формула (2.9) отражает

меру информации содержащийся в сообщении

![]() .

Количественную оценку всего источника

дискретных сообщений

.

Количественную оценку всего источника

дискретных сообщений![]() ,

исходя из (2.3) можно оценить как:

,

исходя из (2.3) можно оценить как:

![]() (2.10)

(2.10)

Значение

![]() называют энтропией источника дискретных

сообщений. Данная величина отражает

среднюю неопределенность при приеме

очередного сообщения. Энтропия источника

называют энтропией источника дискретных

сообщений. Данная величина отражает

среднюю неопределенность при приеме

очередного сообщения. Энтропия источника![]() в том случае, если

в том случае, если![]() и вследствие этого

и вследствие этого![]()

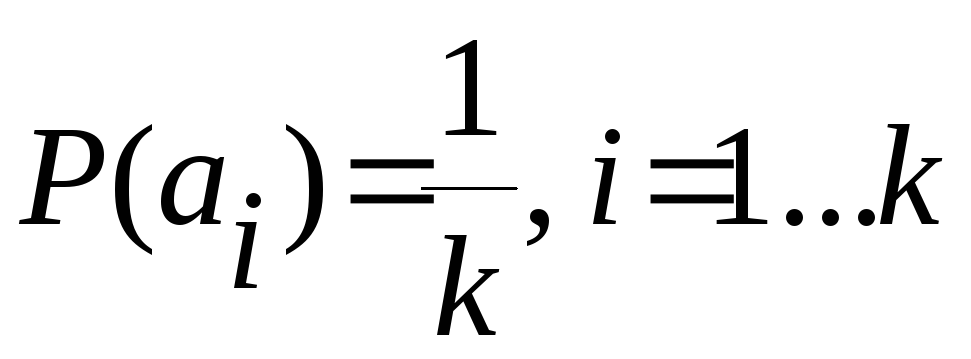

Максимальное

значение

![]() будет принимать, если

будет принимать, если ,

в этом случае

,

в этом случае

![]() .

(2.11)

.

(2.11)

Для источника дискретных сообщений вводится понятие избыточности источника:

![]() ,

(2.12)

,

(2.12)

![]() является безразмерной

величиной в пределах [0…1].

является безразмерной

величиной в пределах [0…1].

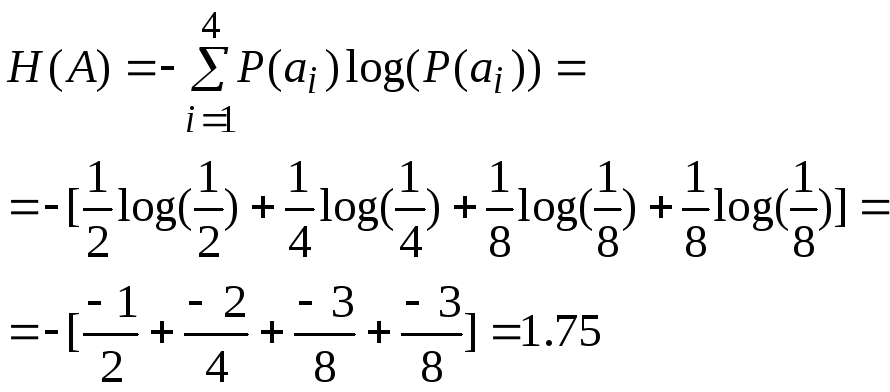

Для примера

рассмотрим дискретный источник сообщений,

выдающий последовательность букв:

![]() «АБСББАДАДААСАААБ», в этом случае

«АБСББАДАДААСАААБ», в этом случае![]() ,

алфавит источника сообщений состоит

из символов: ‘А’, ‘Б’, ‘С’ и ‘Д’,

,

алфавит источника сообщений состоит

из символов: ‘А’, ‘Б’, ‘С’ и ‘Д’,![]() .

.

Энтропия источника по (2.10) будет определяться как:

Максимально возможная энтропия подобного источника по (2.11) будет составлять

![]() .

.

Избыточность

источника дискретных сообщений

![]() составит

составит

![]() .

.

Не трудно заметить,

что чем больше вероятность появления

сообщения

![]() ,

тем ниже значение энтропии источника

сообщений. Для примера построим график

,

тем ниже значение энтропии источника

сообщений. Для примера построим график![]() от

от![]() ,

для

,

для![]() .

В этом случае, если

.

В этом случае, если![]() -

вероятность посылки источником символа

-

вероятность посылки источником символа![]() ,

то вероятность посылки источником

символа

,

то вероятность посылки источником

символа![]() соответственно

будет равна

соответственно

будет равна![]() .

В этом случае энтропия подобного

источника двоичных сообщений будет

равна

.

В этом случае энтропия подобного

источника двоичных сообщений будет

равна

![]() .

.

|

Рис.

3.1. Зависимость энтропии источника

двоичных сообщений от вероятности

посылки символа

|

График зависимости

|