- •3. Экспертные системы (эс) - основная разновидность интеллектуальных систем. Функциональные возможности и области применения.

- •4. Интеллектуальные информационные системы поддержки решений.

- •5. Прикладная ииспр для поддержки банковских решений при оценке кредитоспособности заёмщика. Архитектура системы и характеристика функциональных блоков.

- •Анализ финансового состояния заемщика.

- •Подсистема анализа залоговых средств

- •Подсистема учета кредитной истории

- •8. Прикладная ииспр для расчета производственной программы предприятия и календарного планирования. Основные модели производства. Назначение ииспр.

- •9. Интеллектуальные технологии решения задач управления в экономике.

- •11. Идея и метод принятия решений средствами инженерии квантов знаний.

- •12. Процесс подготовки и принятия решений.

- •17. Содержательная и формальная постановка задачи принятия решений (зпр) на основе теории ожидаемой полезности. 3 основных класса зпр.

- •18. Инженерия знаний для принятия решений в экономике и бизнесе. (лр Бизнес логика и лр КвантБ)

- •19. Интеллектуальные базы данных в экономике и бизнесе.

- •20. Оперативная аналитическая обработка данных olap. Система data mining.

- •21. Бд и хранилища данных в экономике и бизнесе.

- •22. Имитационные модели, эвристические модели, эвристическое программирование.

- •25.Классификация информационных систем ис, как сппр по месту и виду использования в экономике и бизнесе.

12. Процесс подготовки и принятия решений.

Традиционный процесс подготовки и принятия решений включает три главные стадии: концепции проектирования и выбора. Завершает процесс выполнение решения.

Концептуальная стадия начинается с определения организационных целей. Задачи возникают, из неудовлетворенности существующим состоянием дел или их развитием. На этой стадии пытаются определить, существует ли проблема, идентифицировать ее признаки, определить ее значимость и в итоге окончательно определить задачу. Часто то, что описывается как проблема, может быть только признаком проблемы. Так как проблемы реального мира обычно усложняются многими взаимосвязанными факторами. Поэтому иногда бывает трудно различать между признаками и действительной проблемой.

Стадия проектирования влечет порождение, развитие и анализ возможных направлений действия. На этой стадии также строится, испытывается и проверяется модель ситуационной задачи. Моделирование включает концептуализацию задачи и ее абстрагирование в количественной и/или качественной формах. Для математической модели идентифицируются переменные и устанавливаются уравнения, описывающие их отношения. Если необходимо, производятся упрощения путем принятия набора определенных допущений. Однако должно учитываться и соблюдаться правильное равновесие между степенью упрощения модели и ее адекватностью представления действительности.

Граница между стадиями проектирования и выбора часто неразличима, т.к. некоторые действия могут быть совершены как при проектировании, так и на стадии выбора. Кроме того, возможны частые возвраты со стадии выбора на стадию проектирования. Стадия выбора включает поиск, оценку и выработку рекомендации по приемлемому решению на модели. Решение на основе модели – это набор значений переменных для выбранной альтернативы.

Существует несколько основных подходов к реализации поиска на стадии выбора решения, зависящих от критерия выбора. Это оптимизационные методы, слепой поиск и эвристический поиск. Процесс поиска связан с оценкой. Оценка является конечным шагом, который ведет к рекомендуемому решению. Основными подходами к оценке альтернатив являются: многоцелевая (или многокритериальная) оценка, анализ чувствительности, что-если (what – if) анализ и анализ от цели.

Современные системы управления становятся все более сложными, и одна функциональная цель, например, максимизация прибыли, встречается редко. Менеджеры хотят достигать одновременно нескольких целей, некоторые из которых конфликтуют друг с другом. Поэтому, часто необходимо анализировать каждую альтернативу в свете ее потенциального влияния на несколько целей.

13. Искусственные нейронные сети (ИНС) — математические модели, а также их программные или аппаратные реализации, построенные по принципу организации и функционирования биологических нейронных сетей — сетей нервных клеток живого организма. Это понятие возникло при изучении процессов, протекающих в мозге, и при попытке смоделировать эти процессы. Первой такой попыткой были нейронные сети Маккалока и Питтса. Впоследствии, после разработки алгоритмов обучения, получаемые модели стали использовать в практических целях: в задачах прогнозирования, для распознавания образов, в задачах управления и др.

ИНС представляют собой систему соединённых и взаимодействующих между собой простых процессоров (искусственных нейронов). Такие процессоры обычно довольно просты, особенно в сравнении с процессорами, используемыми в персональных компьютерах. Каждый процессор подобной сети имеет дело только с сигналами, которые он периодически получает, и сигналами, которые он периодически посылает другим процессорам. И, тем не менее, будучи соединёнными в достаточно большую сеть с управляемым взаимодействием, такие локально простые процессоры вместе способны выполнять довольно сложные задачи.

С точки зрения машинного обучения, нейронная сеть представляет собой частный случай методов распознавания образов, дискриминантного анализа, методов кластеризации и т. п. С математической точки зрения, обучение нейронных сетей это многопараметрическая задача нелинейной оптимизации. С точки зрения кибернетики, нейронная сеть используется в задачах адаптивного управления и как алгоритмы для робототехники. С точки зрения развития вычислительной техники и программирования, нейронная сеть — способ решения проблемы эффективного параллелизма.. А с точки зрения искусственного интеллекта, ИНС является основой философского течения коннективизма и основным направлением в структурном подходе по изучению возможности построения (моделирования)естественного интеллекта с помощью компьютерных алгоритмов.

Нейронные сети не программируются в привычном смысле этого слова, они обучаются. Возможность обучения — одно из главных преимуществ нейронных сетей перед традиционными алгоритмами. Технически обучение заключается в нахождении коэффициентов связей между нейронами. В процессе обучения нейронная сеть способна выявлять сложные зависимости между входными данными и выходными, а также выполнять обобщение. Это значит, что в случае успешного обучения сеть сможет вернуть верный результат на основании данных, которые отсутствовали в обучающей выборке, а также неполных и/или «зашумленных», частично искаженных данных.

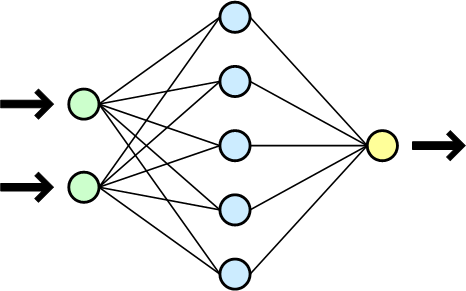

Схема

простой нейросети. Зеленым цветом

обозначены входные нейроны,

голубым скрытые нейроны,

жёлтым — выходной нейрон

Схема

простой нейросети. Зеленым цветом

обозначены входные нейроны,

голубым скрытые нейроны,

жёлтым — выходной нейрон

14. Перцептрон – математическая и компьютерная модель восприятия информации мозгом, предложенная Ф. Розенблатом в 1957 году. Главной особенностью данной модели является способность к обучению. Основная математическая задача, с которой он справляется, — это линейное разделение любых нелинейных множеств.

Элементарный перцептрон состоит из элементов 3-х типов: S-элементов, A-элементов и одного R-элемента.

S-элементы — это слой сенсоров, или рецепторов. В физическом воплощении они соответствуют, например, светочувствительным клеткам сетчатки глаза или фоторезисторам матрицы камеры. Каждый рецептор может находиться в одном из двух состояний — покоя (соответствует 0) или возбуждения (соответствует 1), и только в последнем случае он передаёт единичный сигнал в следующий слой, ассоциативным элементам.

A-элементы называются ассоциативными, потому что каждому такому элементу, как правило, соответствует целый набор (ассоциация) S-элементов. A-элемент активизируется, как только количество сигналов от S-элементов на его входе превысило некоторую установленную величину.

Сигналы

от возбудившихся A-элементов, в свою

очередь, передаются в сумматор R, причём

сигнал от i-го ассоциативного элемента

передаётся с коэффициентом

![]() .

Этот коэффициент называется весом A—R

связи.

.

Этот коэффициент называется весом A—R

связи.

Так же как и A-элементы, R-элемент подсчитывает сумму значений входных сигналов, помноженных на веса. R-элемент, а вместе с ним и элементарный перцептрон, выдаёт «1», если линейная форма превышает порог θ, иначе на выходе будет «−1». Математически, функцию, реализуемую R-элементом, можно записать так:

![]()

Обучение элементарного перцептрона состоит в изменении весовых коэффициентов связей A—R. Веса связей S—A (которые могут принимать значения {−1; 0; +1}) и значения порогов A-элементов выбираются случайным образом в самом начале и затем не изменяются.

Классический метод обучения перцептрона — это метод коррекции ошибки. Он представляет собой такой вид обучения с учителем, при котором вес связи не изменяется до тех пор, пока текущая реакция перцептрона остается правильной. При появлении неправильной реакции вес изменяется на единицу, а знак (+/-) определяется противоположным от знака ошибки.

Допустим, необходимо обучить перцептрон разделять два класса объектов так, чтобы при предъявлении объектов первого класса выход перцептрона был положителен (+1), а при предъявлении объектов второго класса — отрицательным (−1).

Случайным образом выбираются пороги для A-элементов и устанавливаются связи S—A (далее они изменяться не будут).

Начальные коэффициенты равны нулю.

Предъявляем обучающую выборку: объекты с указанием класса, к которым они принадлежат.

Показываем перцептрону объект первого класса. При этом некоторые A-элементы возбудятся. Коэффициенты , соответствующие этим возбуждённым элементам, увеличиваем на 1.

Предъявляем объект второго класса и коэффициенты тех A-элементов, которые возбудятся при этом показе, уменьшаем на 1.

Обе части шага 3 выполним для всей обучающей выборки. В результате обучения сформируются значения весов связей .

Существует теорема, согласно которой элементарный перцептрон, обучаемый по такому алгоритму, независимо от начального состояния весовых коэффициентов и последовательности появления стимулов всегда приведет к достижению решения за конечный промежуток времени.