- •Вероятностные модели и парадокс Бертрана.

- •Математическая модель центра случайной величины. Математическое ожидание

- •Медиана

- •Математическая модель разброса случайной величины.

- •Случайные величины. Зависимость событий и случайных величин.

- •5. Виды сходимости случайных величин

- •6. Закон больших чисел

- •7. Распределение Пуассона

- •Теорема Пуассона

- •Обобщение теоремы Пуассона

- •8. Устойчивые распределения

- •12. Информационные свойства Пуассоновского процесса

- •17. Обобщения Пуассоновского процесса, дважды стохастический Пуассоновский процесс

- •Цпт для обобщённых процессов Кокса

- •Збч для обобщённых процессов Кокса

- •19. Островершинность масштабных смесей нормальных законов

- •Свойства коэффициента эксцесса

- •20. Устойчивость нормальных смесей относительно смешивающего распределения: прямая задача.

- •21. Устойчивость нормальных смесей относительно смешивающего распределения: обратная задача.

- •22. Моделирование распределений приращений финансовых индексов смесями нормальных законов.

6. Закон больших чисел

Теорема (ЗБЧ)

Пусть

есть бесконечная последовательность

норсв

![]() ,

определённых на одном вероятностном

пространстве

,

определённых на одном вероятностном

пространстве

![]() .

Пусть

.

Пусть

![]() .

.

|

Обозначим Sn выборочное среднее первых n членов: |

|

Тогда

![]() почти наверное.

почти наверное.

|

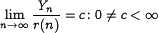

Оценка скорости сходимости ЗБЧ: |

|

r(n) — скорость сходимости (порядок убывания остатка)

, где

—

стандартное нормальное распределение.

—

стандартное нормальное распределение.

7. Распределение Пуассона

|

|

— распределение Пуассона с параметром λ>0, если X – случайная |

величина, принимающая целочисленные неотрицательные значения.

E X = DX = λ

Так

что пуассоновское распределение —

предельное для биномиального (при

![]() ).

).

Опр. Схема серий {Xn,j} — последовательность последовательностей н.о.р.с.в. (n фиксировано).

Теорема Пуассона

Пусть

в системе серий

![]() .

.

Тогда

![]()

Обобщение теоремы Пуассона

Рассматривается та же схема серий.

Пусть

![]() ,

Тогда

,

Тогда

![]()

8. Устойчивые распределения

Опр. G(x) — устойчивая функция распределения, если для ее характеристической функции g(t) выполнено

![]()

или

G(a1*x+b1)*G(a2*x+b2)

= G(a*x+b) (

![]() a1,a2>0,

b1,b2

из

R,

a1,a2>0,

b1,b2

из

R,

![]() a>0 и

b из

R)

a>0 и

b из

R)

|

где * — это свёртка: |

|

||

|

а характеристическая функция |

|

|

|

Теорема Леви

Пусть

X1,

X2

… —

норсв. Тогда F(x) может быть предельной

для сумм вида

при

некоторых

![]() тогда и только тогда, когда F(x) — устойчива.

тогда и только тогда, когда F(x) — устойчива.

Опр.

Функция

распределения F(t)

с характеристической функцией f(t)

называется безгранично делимой, если

![]()

![]()

![]() характеристическая функция fn(t)

такая, что f(t) = (fn(t))n

характеристическая функция fn(t)

такая, что f(t) = (fn(t))n

Теорема Хинчина

|

Пусть |

|

Тогда

F(x) может быть предельной для сумм вида

Xn,1

+ Xn,2

+ … + Xn,mn

при

![]() т.и т.т.,

когда F(x) безгранично делима.

т.и т.т.,

когда F(x) безгранично делима.

9. Информация и энтропия. Их свойства.

Информация

Опр. Пусть

A

– событие, P(A)

> 0. Тогда информацией

события,

содержащейся в А, называется величина

![]()

Опр. Пусть

A,B

– события, P(A)

> 0, P(B)

> 0. Тогда информацией

события,

содержащейся в B

относительно А, называется величина

Основание логарифма определяет единицу измерения информации.

Если

основание

![]() — nat,

— nat,

если основание 2 — bit.

Основание логарифма всегда больше единицы.

Свойства информации:

1) Чем меньше P(A), тем больше I(A).

2) Если А, В – независимые с.в., I(A|B) = 0.

3) Если А, В – независимые с.в., I(AB) = I(A)+ I(В).

Энтропия

|

Опр. Пусть E – эксперимент с исходами и соответствующими им вероятностями |

|

Пусть

Q(E)

— случайная величина со значениями

I(Ai),

принимаемыми с вероятностями p![]() .

.

Тогда

энтропией

E

называется величина

![]()

Свойства энтропии:

1) H(E)![]() 0,

H(E)=0

pi=1

0,

H(E)=0

pi=1

2) Н(Е)

не зависит от A![]() ,

а зависит только от p

,

а зависит только от p![]() .

.

3) H(E)

— непрерывная функция p![]() .

.

4) Максимальная энтропия у экспериментов с n исходами у того, у которого исходы равновероятны.

|

5) E – эксперимент с исходами |

|

E![]() получается из Е объединением двух

исходов с номерами i

и j.

получается из Е объединением двух

исходов с номерами i

и j.

E![]() — эксперимент с двумя исходами

— эксперимент с двумя исходами

![]() которым соответствуют вероятности

pi/(pi+pj),

pj/(pi+pj).

которым соответствуют вероятности

pi/(pi+pj),

pj/(pi+pj).

Тогда

![]()

Теорема Фадеева

Если

функционал H(p1,..pn)

удовл. 1)-5) =>

10. Дифференциальная энтропия. Свойства некоторых распределений.

Пусть

![]() — случайная величина.

— случайная величина.

-

дискретна.

Тогда энтропия равна

дискретна.

Тогда энтропия равна

,

,

![]() если

число значений

если

число значений

![]() бесконечно.

бесконечно.

-

абсолютно

непрерывна.

Тогда энтропия равна

абсолютно

непрерывна.

Тогда энтропия равна

Где

f(![]() )

– плотность распределения

)

– плотность распределения

![]() .

Такая энтропия называется дифференциальной

энтропией.

.

Такая энтропия называется дифференциальной

энтропией.

, где R[-a;a] — равномерное распределение

P(![]() )

— показательное распределение

)

— показательное распределение

N

(a,

![]() )

— нормальное распределение

)

— нормальное распределение

Вывод:

-

Равномерное распределение наиболее неопределенное среди всех распределений на конечном отрезке.

-

Показательное распределение наиболее неопределенное среди всех распределений на положительной полуоси.

-

Нормальное распределение наиболее неопределенное среди всех распределений на

.

.

Замечание: на эту теорему может быть задача.

11. Определение пуассоновского процесса.

Опр. Случайный

процесс —

семейство случайных величин X(t,![]() ),

определенное на одном пространстве

(

),

определенное на одном пространстве

(![]() ),

t

),

t![]() T

T![]() R.

R.

Опр. Траектория

случайного процесса — X(t,

![]() )

при фиксированном

)

при фиксированном

![]() .

.

X(t) -> S — множество всех траекторий случайного процесса.

На

S

можно определить борелевскую сигма-алгебру

![]() ,

порожденную множеством всех открытых

подмножеств S.

,

порожденную множеством всех открытых

подмножеств S.

Событие

X(t):

![]() -> S

— прообраз любого B

-> S

— прообраз любого B![]() .

.

Опр. Распределением

случайного процесса называется мера

P![]() ,

т.ч.

,

т.ч.

![]() :

:

![]()

Опр. Процесс

X(t)

— процесс с

независимым приращением,

если

![]()

X

(t![]() ),

X

(t

),

X

(t![]() )-X

(t

)-X

(t![]() ),

… , X

(t

),

… , X

(t![]() )-X

(t

)-X

(t![]() )

— независимы в совокупности.

)

— независимы в совокупности.

Опр. Процесс

X(t)

— однородный,

если распределение X(t+h) - X(t)

совпадает с распределением X(s+h)

- X(s)

для

![]() t,

s,

h:

t,

t+h,

s,

s+h

t,

s,

h:

t,

t+h,

s,

s+h

![]() T.

T.

Опр. Процесс X(t) — пуассоновский, если

1) X(0)=0 почти наверное

2) X(t) имеет независимые приращения

3) X(t) однородный

4)

При

![]() >0,

h>0, h->0

>0,

h>0, h->0

P(X(h)

= 0) = 1-

![]() h

+o(h)

h

+o(h)

P(X(h)

= 1) =

![]() h

+o(h)

h

+o(h)

P(X(h) >= 2) = o(h)

![]() – интенсивность

пуассоновского процесса.

– интенсивность

пуассоновского процесса.

Для

пуассоновского процесса EX(t)

= DX(t)

=

![]() t

t