- •1:В чём заключается идея коннективизма?

- •2 И 3:из чего состоит биологический нейрон?

- •4:Классическая модель формального нейрона

- •5:Что такое функция активации?

- •7:Что такое сигмаидальный нейрон?

- •8:Адалайн-нейтрон

- •9:Паде-нейрон

- •10: История развития нейрокопьютера

- •15:Однослойные нейронные сети

- •16:Многослойные нейронные сети Ответ: многослойные искусственные нейронные сети

- •Нелинейная активационная функция

- •17:Сети с обратными связями Ответ: Сети с обратными связями

- •18:Нейроэмулятор

- •19: Нейрочипы: анализ и сравнительные характеристики

- •20: Нейрокомпьютеры, реализованные на базе пцос и плис

- •21:Однослойный персептрон

- •23:Многослойный персептрон

- •Вопрос 25:аглоритм обратного распространения ошибки

- •34 Радиальные сети

- •35:Обучение радиальной сети

- •36: Рекуррентные нейронные сети

- •38: Обучение сети Хопфилда

- •42:Персептронная сеть с обратной связью

- •44,Алгоритмы обучения

- •Алгоритм нейронного газа

- •50:Методы редукции нейронной сети

42:Персептронная сеть с обратной связью

Один из простейших способов построения рекуррентной сети на базе однонаправленной HC состоит во введении в персептронную сеть обратной связи. В дальнейшем мы будем сокращенно называть такую сеть RMLP (англ.: Recurrent MultiLayer Perceptron - рекуррентный многослойный персептрон). Ее обобщенная структура представлена на рис. 1 (Хк -единичные элементы запаздывания).

Сеть RMLP повсеместно применяется для моделирования динамических процессов в режиме "онлайн". Типичным примером ее приложения может служить имитация нелинейных динамических объектов, для которых сеть RMLP выступает в роли модели, а алгоритм уточнения весов - в роли процедуры идентификации параметров этой модели Идентифицированная модель может в последующем использоваться для управления данным объектом. Именно по этой причине сети RMLP наиболее популярны для имитации систем управления машинами, устройствами и динамическими процессами.

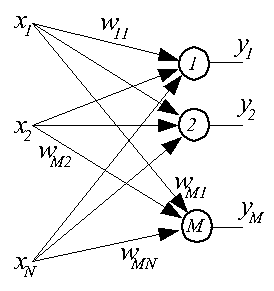

43Сетями с самоорганизацией называются сети, не требующие для своего обучения "учителя" и самостоятельно адаптирующие свои веса под обучающие данные. Такие сети строятся из нейронов типа WTA и подобных им. Как правило, это однослойные сети, в которых каждый нейрон получает все компоненты входного вектора X размерностью N. На рисунке представлена структурная схема такой сети.

Веса входных связей i-ого нейрона образуют вектор

Wi=[wi1, wi2, ..., wiN]T

Кроме связей, явно представленных в схеме, на этапе обучения имеют место связи между нейронами, позволяющие судить о степени "соседства" нейронов друг с другом, при этом смысл понятия "соседство" может быть разным. Такие сети часто требуют нормализации значений входного вектора.

Укрупненно процесс обучения сети выглядит следующим образом. На вход сети подается обучающий вектор Xk, для каждого нейрона определяется d(Xk, Wi) - расстояние (в смысле выбранной метрики) между векторами Xk и Wi. Определяется нейрон-победитель, для которого это расстояние оказывается наименьшим. Вокруг нейрона-победителя образуется окрестность Skw из нейронов-соседей с известным "расстоянием" до победителя. Веса нейрона-победителя и веса его соседей из Skw уточняются, например, по правилу Кохонена

Wk+1i=Wki+nuki*(Xk-Wki),

где nuki - коэффициент обучения, значение которого уменьшается с увеличением расстояния от i-ого нейрона до победителя. Веса нейронов вне Skw не изменяются. Размер окрестности Skw и величина nuki с течением времени обучения уменьшаются.

44,Алгоритмы обучения

Целью обучения сети с самоорганизацией на основе конкуренции является минимизация погрешности квантования Eq=(1/p)*sum[k=1:p](d(Xk, Ww(k))), где p - количество обучающих векторов Xk, Ww(k) - вектор весов нейрона-победителя при предъявлении вектора Xk.

Примеры результатов обучения, близких к оптимальным, представлены ниже на рисунках. Используются сети с 15 и 22 нейронами и двухкомпонентным входным вектором X=[x1, x2]T. На левых рисунках представлено распределение данных в обучающих выборках, на правых - распределение весов нейронов обученной сети.

Для обучения сетей с самоорганизацией на основе конкуренции наибольшее распространение получили два описывАлгоритм Кохонена

В нейронных сетях, предложенных Т. Кохоненом (1982 г.), соседство нейронов носит топологический характер. В простом случае нейроны слоя Кохонена образуют одномерную цепочку, при этом каждый нейрон имеет, в общем случае, двух ближайших соседей (слева и справа). В более сложном случае нейроны Кохонена образуют двумерную сетку с четырьмя соседями у каждого нейрона (слева, справа, сверху, снизу). В еще более сложном случае сетка гексагональна - у каждого нейрона шесть соседей на плоскости (по циферблату часов - 2, 4, 6, 8, 10, 12 часов).

Коррекция весов нейронов в ходе обучения выполняется по формуле: Wk+1i=Wki+nuki*Gk(i,Xk)*(Xk-Wki).

где функция соседства Gk(i,Xk) определяется, как правило, формулой Гаусса в виде: Gk(i,Xk)=exp(-d2(i,Xk)/(2*(sk)2)), где d(i,Xk) - расстояние от i-ого нейрона до нейрона-победителя с индексом wk в k-ом цикле обучения. При этом d(wk,Xk)=0, d(i,Xk)=1 для всех ближайших соседей wk, d(i,Xk)=2 для всех "внешних" ближайших соседей ближайших соседей нейрона победителя с индексом wk и так далее.

Как обычно, коэффициент обучения nuki и параметр ширины функции Гаусса sk уменьшаются в ходе обучения (с ростом k).

В результате обучения слоя Кохонена по такому алгоритму топологически соседние нейроны становятся типичными представителями кластеров обучающих данных, соседствующих в многомерном пространстве. В этом достоинство сетей Кохонена, называемых также картами Кохонена, - наглядность в представлении (путем одномерной или двумерной визуализации) многомерных данных.