- •Лекция 3. Формулы Шеннона и Хартли. Расчёт количества информации. Кодирование символьных, графических и звуковых данных. Структуры данных Формула Шеннона

- •Формула Хартли

- •Количество информации, получаемой в сообщении

- •Кодирование символьных (текстовых и числовых) данных

- •Кодирование графических данных

- •Кодирование звуковых данных

- •Структуры данных

Формула Хартли

Формула Хартли – это частный случай формулы Шеннона для равновероятных альтернатив.

Подставив в формулу Шеннона вместо pi его (в равновероятном случае не зависящее от i) значение pi = 1/N, получим:

![]() ,

таким образом, формула Хартли выглядит

очень просто:

,

таким образом, формула Хартли выглядит

очень просто:

![]()

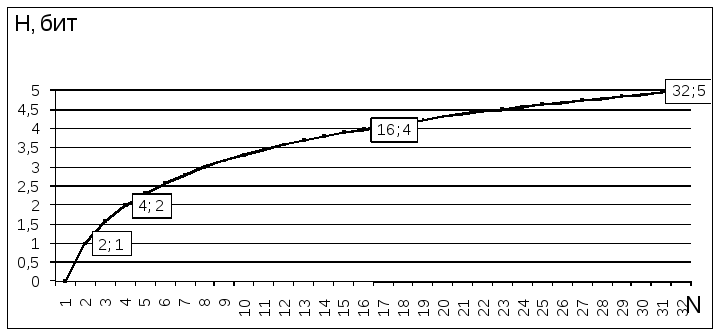

Из нее следует, что с увеличением количества альтернатив (N), растёт и неопределенность (H). Эти величины связаны в формуле не линейно, а через двоичный логарифм. Логарифмирование по основанию 2 и приводит количество возможных вариантов к единицам измерения информации – битам.

Как видно, энтропия будет являться целым числом лишь в том случае, когда N является степенью числа 2, т. е. если N принадлежит ряду: 1, 2, 4, 8, 16, 32, 64, 128, 256, 512, 1024, 2048…

Зависимость энтропии от количества равновероятных вариантов выбора (равнозначных альтернатив)

Для решения обратных задач, когда известна неопределенность (H) или полученное в результате ее снятия количество информации (I) и нужно определить какое количество равновероятных альтернатив соответствует возникновению этой неопределенности, используют обратную формулу Хартли, которая выводится в соответствии с определением логарифма и выглядит еще проще:

![]()

Например, если информация о том, что некий Иванов живет на втором этаже, соответствует 3 битам, то по формуле можно определить количество этажей в доме, как: N = 23 = 8 этажей.

Если же вопрос поставить так: “В доме 8 этажей, то какое количество информации мы получим, узнав, что интересующий нас Иванов живет на втором этаже?”, то расчёт можно произвести по формуле:

I = log2(8) = 3 бита

Количество информации, получаемой в сообщении

До сих пор формулы приводились для расчета энтропии (неопределенности) H с указанием на то, что H в них можно заменять на I, потому что количество информации, получаемое при полном снятии неопределенности некоторой ситуации, количественно равно начальной энтропии этой ситуации.

Но в общем случае неопределенность может быть снята только частично, поэтому количество информации I, получаемой из некоторого сообщения, вычисляется как уменьшение энтропии, произошедшее в результате получения данного сообщения.

![]()

Для равновероятного случая, используя для расчета энтропии формулу Хартли, получим:

![]()

Второе равенство выводится на основании свойств логарифма. Таким образом, в равновероятном случае I зависит от того, во сколько раз изменилось количество вариантов выбора (рассматриваемое разнообразие).

Исходя из предыдущей формулы, можно сделать вывод, что при полном снятии неопределенности, когда Nпосле = 1:

![]()

количество полученной в сообщении информации равно неопределенности, которая существовала до получения сообщения.

Если Nпосле = Nдо, то I = log2(1) = 0, то это значит, что, неопределенность не изменилась, и, следовательно, информации получено не было.

Если Nпосле < Nдо, то Nдо / Nпосле > 1, или I > 0 (какая-то информация получена).

Если Nпосле > Nдо, то Nдо / Nпосле < 1, или I < 0 (информации нет).

Таким образом, количество полученной информации будет положительной величиной, если в результате получения сообщения количество рассматриваемых альтернатив уменьшилось, и отрицательной, - если оно увеличилось.

Если количество рассматриваемых альтернатив в результате получения сообщения уменьшилось вдвое, т. е. Nдо / Nпосле = 2, то I = log2(2) = 1 бит. Другими словами, получение 1 бита информации исключает из рассмотрения половину равнозначных вариантов.

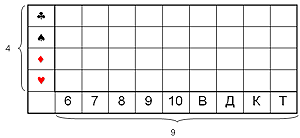

В качестве примера рассмотрим опыт с колодой из 36 карт.

Допустим, кто-то выбирает одну карту из колоды. Нас интересует, какую именно из 36 карт он достал. Начальная неопределенность, рассчитываемая по формуле I = log2(Nдо / Nпосле), составляет:

H = log2(36/1) = log10(36) * 3,332 5,17 бит.

Вытянувший карту сообщает нам часть информации. Используя формулу, определим, какое количество информации мы получаем из этих сообщений:

Вариант A. “Это карта красной масти”.

I = log2(36/18) = log2(2) = 1 бит (красных карт в колоде половина, неопределенность уменьшилась в 2 раза).

Вариант B. “Это карта пиковой масти”.

I = log2(36/9) = log2(4) = 2 бита (пиковые карты составляют четверть колоды, неопределенность уменьшилась в 4 раза).

Вариант С. “Это одна из старших карт: валет, дама, король или туз”.

I = log2(36/16) = log2(36) – log2(16) = 5,17 – 4 = 1,17 бита (полученное количество информации больше одного бита, поэтому неопределенность уменьшилась больше чем в два раза).

Вариант D. “Это одна карта из колоды".

I = log2(36/36) = log2(1) = 0 бит (неопределенность не уменьшилась - сообщение не информативно).

Вариант E. “Это дама пик". I=log2(36/1)=log2(36)=5,17 бит (неопределенность полностью снята).