- •Введение

- •Информация и сигнал. Общая схема передачи информации

- •1.2. Основные этапы развития радиоэлектроники

- •Сигналы

- •2.1. Классификация сигналов

- •Формы представления детерминированных сигналов

- •2.2. Спектры периодических сигналов

- •Распределение мощности в спектре периодического сигнала

- •Спектры простейших периодических сигналов

- •2.3. Спектры непериодических сигналов

- •Свойства преобразования Фурье

- •Распределение энергии в спектре непериодического сигнала

- •Свойства d-функции

- •2.4. Корреляционный анализ детерминированных сигналов

- •2.5. Радиосигналы - модулированные колебания

- •Спектр амплитудно-модулированного сигнала

- •Спектр радиосигнала при угловой модуляции

- •Балансная и однополосная амплитудные модуляции

- •Импульсно-модулированные сигналы

- •Спектр амплитудно-импульсного модулированного сигнала

- •Внутриимпульсная частотная модуляция

- •2.6. Случайные сигналы Случайные величины

- •Плотность вероятности функции от случайной величины

- •Многомерная плотность вероятности

- •Случайный процесс

- •Спектральный анализ случайных сигналов

- •Примеры случайных процессов

- •1. Постоянное напряжение случайного уровня Ак

- •2. Гармоническое колебание со случайной фазой

- •3. Белый шум

- •2.7. Дискретизация непрерывных сигналов

- •Дискретизация по критерию наибольшего отклонения. Адаптивная дискретизация

- •2.8. Информация и сигнал. Информационная емкость сигналов Количественная оценка информации

- •Информационная емкость дискретного и непрерывного сигналов

- •Непрерывный сигнал

- •Вопросы для самопроверки к главе II.

- •3. Радиотехнические цепи

- •3.1. Квазистационарность тока. Законы Кирхгофа.

- •Принцип суперпозиции для линейной цепи

- •Законы Кирхгофа

- •I закон Кирхгофа

- •II Закон Кирхгофа

- •3.2. Символическая форма для синусоидальных токов, действующие значения, мгновенная, полная, активная и реактивная мощности

- •3.3. Двухполюсники. Комплексное сопротивление двухполюсника

- •Последовательное соединение двухполюсников

- •Параллельное соединение двухполюсников

- •3.4. Методы расчета сложных цепей а) Общий метод

- •Б) Метод контурных токов

- •В) Метод узловых напряжений.

- •3.5. Преобразование Лапласа

- •3.6. Расчет линейных цепей при несинусоидальных эдс и переходных процессах

- •Включение цепи r, l, c под постоянное напряжение

- •Размыкание ключом части сложной цепи

- •3.7. Четырехполюсники

- •Соединения четырехполюсников. Матричная запись уравнений

- •Каскадное соединение

- •Параллельное соединение

- •3.8. Передаточная функция и импульсная характеристика цепи

- •3.9. Передаточная функция соединений четырехполюсников. Обратная связь

- •3.10. Примеры расчета передаточных функций и импульсных

- •Скомпенсированный делитель напряжения

- •Интегрирующая цепь

- •Дифференцирующая цепь

- •Параллельный колебательный контур как четырехполюсник

- •Мост Вина

- •Тройная фазосдвигающая rc-цепь

- •Двойной т-образный мост

- •Система идентичных индуктивно-связанных контуров

- •Резистивный (апериодический) каскад усиления

- •4. Методы анализа прохождения сигналов через цепи

- •4.1. Спектральный метод

- •Условия отсутствия искажений

- •4.2. Метод интеграла наложения Дюамеля

- •4.3. Корреляция сигнала на входе и выходе четырехполюсника

- •Рассмотрим два крайних случая

- •4.4. Анализ прохождения прямоугольного импульса через интегрирующую цепь

- •4.8. Прохождение амплитудно-модулированного сигнала через колебательный контур

- •4.9. Прохождение частотно-модулированного сигнала через колебательный контур

- •4.10. Импульсный трансформатор

- •5.2. Аппроксимация нелинейных характеристик

- •Аппроксимация степенным полиномом

- •Кусочно-линейная аппроксимация

- •Аппроксимация показательной функцией

- •5.3. Воздействие гармонического сигнала на нелинейные элементы. Степенная аппроксимация.

- •Кусочно-линейная аппроксимация

- •Показательная аппроксимация

- •5.4. Воздействие суммы двух гармонических колебаний на нелинейный элемент со степенной характеристикой

- •5.5. Нелинейное резонансное усиление

- •5.6. Умножение частоты

- •5.7. Амплитудная модуляция

- •5.8. Амплитудное детектирование

- •5.9. Преобразование частоты сигнала

- •5.10. Синхронное детектирование

- •6. Линейно-параметрические цепи

- •6.1. Особенности линейно-параметрических цепей

- •6.2. Схема замещения емкости, изменяющейся по гармоническому закону

- •6.3. Одноконтурный параметрический усилитель

- •6.4. Параметрический генератор-параметрон

- •7. Неквазистационарные токи. Цепи с распределенными параметрами

- •7.1. Уравнение телеграфистов. Синусоидальный сигнал

- •7.2. Частный случай пренебрежения затуханием (короткие линии)

- •7.3. Общий случай временной зависимости входного сигнала

- •7.4. Подключение заряженной линии к активному сопротивлению

- •7.5. Волноводы

2.8. Информация и сигнал. Информационная емкость сигналов Количественная оценка информации

Получение информации всегда приводит к уменьшению неопределенности. Рассмотрим дискретный источник информации, характери-

зуемый

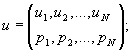

дискретным набором (ансамблем) состояний

с заданной вероятностью их появления:

![]()

Меру неопределенности выбора состояния источника можно рассматривать как меру количества информации, получаемой при полном устранении неопределенности (т. е. содержащейся в источнике). Эта мера должна удовлетворять ряду естественных условий.

1. Монотонное возрастание с увеличением возможности выбора(оценка по пятибалльной системе более полная, чем по двухбалльной).

2. Аддитивность

количества информации - неопределенность

объединенного источника информации

должна равняться сумме неопределенностей

(а следовательно, и количества информации)

исходных источников. Так, два независимых

источника с числомравновероятных состояний

n и m можно рассматривать как один

источник, реализуемый пары состояний

nimj с

общим числом состояний N=mn, тогда ![]() Это

соотношение выполняется, если в качестве

меры неопределенности источника с

равновероятными состояниями принять

логарифм числа состояний

Это

соотношение выполняется, если в качестве

меры неопределенности источника с

равновероятными состояниями принять

логарифм числа состояний ![]()

![]() Для

другого примера аналогично: если каждое

сообщение состоит из n символов, выбираемых

из объема m, то число всех возможных

сообщений

Для

другого примера аналогично: если каждое

сообщение состоит из n символов, выбираемых

из объема m, то число всех возможных

сообщений ![]() и,

следовательно,

и,

следовательно,![]() ,

т. е. информация, полученная при выборке

каждого из n символов, складывается.

,

т. е. информация, полученная при выборке

каждого из n символов, складывается.

Основание

логарифма определяет только масштаб

или единицу количества информации, т.

к. при N = 1 ![]() (одно

состояние не имеет неопределенности),

то минимальное количество информации

будет при N = 2. Чтобы получить при этом

единицу информации, основание логарифма

приравнивают к 2 и такую единицу информации

называют «бит» - информацию

получаем при осуществлении одного из

двух возможных состояний H = 1 бит

при

(одно

состояние не имеет неопределенности),

то минимальное количество информации

будет при N = 2. Чтобы получить при этом

единицу информации, основание логарифма

приравнивают к 2 и такую единицу информации

называют «бит» - информацию

получаем при осуществлении одного из

двух возможных состояний H = 1 бит

при ![]() N =

2 (Хартли, 1928). Предложенная мера количества

информации применима только для

равновероятных состояний:

N =

2 (Хартли, 1928). Предложенная мера количества

информации применима только для

равновероятных состояний: ![]() тогда

тогда ![]() информация,

полученная при осуществлении i-го

состояния.

информация,

полученная при осуществлении i-го

состояния.

При

неравновероятных состояниях свобода

выбора источника ограничена, что должно

привести к уменьшению неопределенности

(и количества информации). Так, если

источник информации имеет два состояния

с вероятностями 0,99 и 0,01, то неопределенность

здесь значительно меньше, чем при

равновероятных состояниях с вероятностями

0,5 и 0,5. Значит мера неопределенности

должна зависеть от функции распределения

вероятности случайной величины. Еще

одно условие состоит в том, что мера

неопределенности не должна зависеть

от пути выбора состояния в ансамбле, в

том числе и многоступенчатом по группам

состояний. К. Шенноном высказано

утверждение, а Л. Я. Хинчиным математически

доказано, что единственный функционал,

удовлетворяющий сформулированным

условиям, есть![]() (Шеннон,

1946 г). Сравнивая это выражение с выражением

Хартли

(Шеннон,

1946 г). Сравнивая это выражение с выражением

Хартли ![]() для

равновероятных состояний, видим, что

при разных вероятностях происходит

усреднение количества информации по

всем возможным состояниям.

для

равновероятных состояний, видим, что

при разных вероятностях происходит

усреднение количества информации по

всем возможным состояниям.

Выражение

Шеннона совпадает с выражением Больцмана

для энтропии физической системы. В

частности, по второму закону термодинамики

энтропия замкнутой системы молекул ![]()

![]() ,

где mN - общее

число молекул, mi - количество

молекул со скоростями в интервале

,

где mN - общее

число молекул, mi - количество

молекул со скоростями в интервале ![]() ,

т. к.

,

т. к. ![]() - вероятность

такого состояния. В обоих случаях

величина H характеризует

степень разнообразия состояний системы.

Максимальное значение энтропии при

равновероятных состояниях растет с

ростом числа этих состояний. Энтропия

объединения нескольких статистически

независимых источников равна сумме

энтропии исходных источников:

- вероятность

такого состояния. В обоих случаях

величина H характеризует

степень разнообразия состояний системы.

Максимальное значение энтропии при

равновероятных состояниях растет с

ростом числа этих состояний. Энтропия

объединения нескольких статистически

независимых источников равна сумме

энтропии исходных источников:

т.

к. ![]()

![]()

![]()

Энтропия характеризует среднюю неопределенность выбора одного состояния из ансамбля.

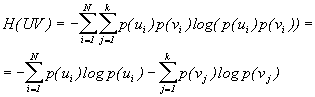

Для

статистически зависимых ансамблей UV,

описываемых совместной

вероятностью, ![]() где

где ![]() - условная

вероятность.

- условная

вероятность.

![]() где

где

![]() ,

, ![]()

![]() - условная

энтропия.

- условная

энтропия.

Энтропия объединения двух статистически связанных ансамблей U и V равна безусловной энтропии одного ансамбля плюс условная энтропия другого относительно первого.

Энтропия непрерывного источника информации бесконечна, т. к. неопределенность выбора из бесконечно большого числа возможных состояний бесконечно велика.

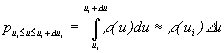

Производя предельный переход в формуле Шеннона

,

получим

,

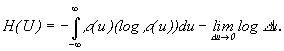

получим

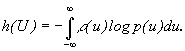

Вторая

часть бесконечна, но она не зависит от

плотности вероятности. Первая часть

называется дифференциальной энтропией Ее

можно трактовать как среднюю

неопределенность выбора случайной

величины U по сравнению со средней

неопределенностью выбора случайной

величины, изменяющейся в диапазоне,

равном единице, и имеющей равномерное

распределение.

Ее

можно трактовать как среднюю

неопределенность выбора случайной

величины U по сравнению со средней

неопределенностью выбора случайной

величины, изменяющейся в диапазоне,

равном единице, и имеющей равномерное

распределение.

При статистически связанных непрерывных источниках, дифференциальная условная энтропия

![]()

![]()

Дифференциальная

энтропия зависит от масштаба (единицы

измерения). Для непрерывного источника

информации, ввиду бесконечности его

меры неопределенности, понятие количества

информации имеет несколько подходов.

Наиболее простой из них - замена

непрерывного сообщения дискретным с

интервалом дискретизации по

Котельникову![]() что

позволяет полностью восстановить

непрерывное сообщение, а следовательно,

не потерять информацию.

что

позволяет полностью восстановить

непрерывное сообщение, а следовательно,

не потерять информацию.

Прямой же подход определяет количество информации как разность априорной и апостериорной дифференциальной энтропии, последняя не равна нулю из-за некоторой неопределенности, оставшейся после регистрации события вследствие помех и конечной величины точности регистрации. При таком определении количества информации исчезает бесконечность после вычитания постоянного бесконечного члена.