- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

- •Кафедра «Радиоэлектронных систем»

Кафедра «Радиоэлектронных систем»

Дисциплина ОТРЭС

Тема 3. Основы теории информации

Лекция 3/1. Информационные характеристики источника сообщений

2013

Кафедра «Радиоэлектронных систем»

Дисциплина ОТРЭС

1. Основные понятия, определения и задачи теории информации

Общим классификационным признаком для всех радиоэлектронных систем гражданской авиации является информационный признак, т.к.

все эти системы

передают, принимают, передают и принимают или извлекают информацию.

Информацию для ее передачи, хранения, обработки или распростра- нения необходимо представить в виде каких-либо символов (знаков)

xk, k = [1, L], т.е. представить ее в некоторой форме. Эти символы

(знаки) xk называются элементарными символами источника

сообщений (ИС).

Множество различных элементарных символов ИС {xk}, k = [1, L],

используемых источником информации (ИИ) для формирования сообщений, называется алфавитом ИС, а мощность этого множества

L – объемом алфавита ИС.

Упорядоченная совокупность элементарных символов xk образует сообщение {x}.

Кафедра «Радиоэлектронных систем»

Дисциплина ОТРЭС

Теория информации изучает способы наилучшей передачи сообщений по каналам передачи информации с заданными свойствами.

Выбор наилучшего способа передачи (извлечения) сообщений

является основной задачей не только теории информации, но и инженерной практики

на этапе эксплуатации систем передачи и извлечения информации.

Для решения основной задачи теории информации необходимо в первую очередь решить задачу согласования информационных характеристик источника информации (сообщений) и канала передачи (извлечения) информации.

В дальнейшем будем считать, что при изучении данной дисциплины

термины

«источник информации» (ИИ) и «источник сообщений» (ИС) –

синонимы

Кафедра «Радиоэлектронных систем»

Дисциплина ОТРЭС

Для решения задачи согласования информационных характеристик

источника информации (сообщений)

и канала передачи (извлечения) информации

необходимо решить ряд частных задач:

-определения количества информации, содержащегося в сообщении;

-оценки информативности источника информации (сообщений) в целом;

-определения скорости передачи информации, с которой она может быть передана по заданному каналу;

-определения количества информации, теряемой в канале в результате воздействия помех.

В свою очередь, для решения основной и частных задач теории информации

необходимо определить меру количества информации.

Кафедра «Радиоэлектронных систем»

Дисциплина ОТРЭС

2.Количественная оценка информации

В1946 г. К. Шеннон предложил связать количество информации, содержащееся в сообщении, с вероятностями использования символов алфавита ИС при формировании сообщений.

Для количественной оценки информации был принят интуитивно-

вероятностный подход:

маловероятное сообщение (сенсация) содержит

много информации,

а известное (достоверное) сообщение

не содержит информации.

Отсюда логично предположить, что количество информации ί(xk), содержащееся в k-м символе алфавита ИС xk, находится в обратной

зависимости от вероятности его появления Р(xk):

ί(xk) = f(1/Р(xk),

Кафедра «Радиоэлектронных систем»

Дисциплина ОТРЭС

Очевидно:

-количество информации, содержащееся в любом символе источника сообщений, не должно быть отрицательным;

-количество информации, содержащееся в двух и более независимых символах сообщения, должно быть равно сумме количеств информации в каждом из них.

Исходя из приведенных соображений можно сформулировать следующие

требования к функции f(1/Р(xk):

-она должна быть неотрицательной: f[1/Р(xk)] ≥ 0;

-она должна быть равна нулю при Р(xk) = 1;

-она должна быть монотонно убывающей;

-она должна обладать свойством аддитивности, то есть количество информации в двух и более независимых символах сообщения должно быть равно сумме количеств информации в каждом из них.

Кафедра «Радиоэлектронных систем»

Дисциплина ОТРЭС

Предъявленным требованиям удовлетворяет логарифмически-обратная зависимость ί(xk) от Р(xk):

ί(xk) = loga(1/Р(xk),

Действительно:

-ί(xk) ≥ 0, так как Р(xk) ≤ 1;

-для известных сообщений ί(xk) = 0, так как Р(xk) = 1;

-функция ί(xk) монотонно убывает с ростом Р(xk);

-свойство аддитивности для независимых xk и xl также выполняется: ί(xk,xl) = loga(1/Р(xk,xl) = loga(1/Р(xk) + loga(1/Р(xl) = ί(xk) + ί(xl).

Величина ί(xk) называется частным количеством информации, содержащемся в k-м символе алфавита источника сообщений.

Основание логарифма a определяет единицу измерения количества информации:

если a > 0, то i(xk) = 1 при Р(xk) = 1/a.

Кафедра «Радиоэлектронных систем»

Дисциплина ОТРЭС

Втеории информации обычно полагают a = 2.

Вэтом случае единицей количества информации является бит, т.е. 1 бит информации содержит символ сообщения, вероятность появления которого равна 1/2.

Достоинством полученной меры информации является ее объективность, то есть независимость от конкретного содержания информации в сообщении.

Кафедра «Радиоэлектронных систем»

Дисциплина ОТРЭС

3. Энтропия и избыточность источника

дискретных сообщений

Частное количество информации ί(xk) определяет количество информации,

содержащееся только в определенном символе алфавита ИС, и не может

служить характеристикой ИС в целом.

Характеристика ИС в целом должна быть однозначно связана с частными количествами информации, заключенными во всех символах алфавита источника:

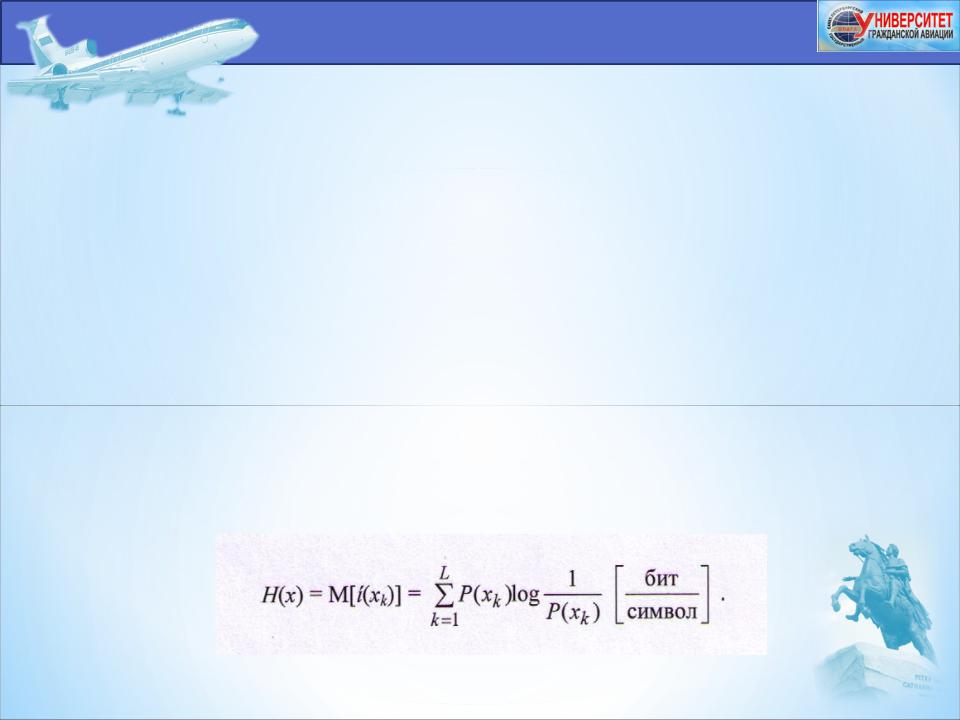

H (x) = Ф [{ί(xk)}], k = [1, L], где Ф (...) – некоторая функция L переменных.

Такой характеристикой является среднее по вероятности количество информации, приходящееся на один символ алфавита ИС, т.е. математическое ожидание количества информации, содержащегося

Величина H(x) называется энтропией источника дискретных сообщений.

Кафедра «Радиоэлектронных систем»

Дисциплина ОТРЭС

Таким образом,

энтропия ИС - это среднее количество информации, содержащееся в одном символе алфавита ИС.

Основные свойства энтропии ИС:

1.H(x) ≥ 0, так как ί(xk) ≥ 0, k = [1, L].

2.H(x) = 0, тогда и только тогда, когда ИС выдает один символ xk при k =

n с вероятностью |

Р(xn) = 1, а остальные символы при k ≠ n с |

вероятностью Р(xk) = 0.

3. Значение энтропии достигает максимума, если символы источника равновероятны, то есть при Р(xk) = 1/L, k = [1, L].

В этом случае

H(x) = Hмакс(x) = log L.