- •Теория информации и кодирования

- •Модель системы передачи информации

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Кодирование источника сообщений

- •Методы, повышающие качество приема передаваемой информации:

- •Для повышения качества приема используют следующие основные способы:

- •Избыточные коды

- •КЛАССИФИКАЦИЯ ПОМЕХОУСТОЙЧИВЫХ КОДОВ

- •Основные задачи:

- •Внесение избыточности

- •Внесение избыточности

- •ОСНОВНЫЕ ХАРАКТЕРИСТИКИ КОРРЕКТИРУЮЩИХ КОДОВ

- ••Если код используется только для обнаружения ошибок кратностью r, то необходимо и достаточно,

- •Весовой состав кодового множества

- •Избыточные коды

- •Разделимые избыточные кода

- •Корректирующий код Хемминга

- •Классический код Хемминга (7,4)

- •блок-схема кодера

- •схема декодера

- •Формальное описание избыточных кодов

- •Формальное описание избыточных кодов

- •Формальное описание избыточных кодов

- •Формальное описание избыточных кодов

- •Формальное описание избыточных кодов

- •Формальное описание избыточных кодов

- •Формальное описание избыточных кодов

- •Формальное описание избыточных кодов

Теория информации и кодирования

Читает доц.шеховцов clarahena@mail.ru

Модель системы передачи информации

|

|

Кодирование |

|

|

Источник |

|

|

Канал связи |

|

|

Неизбыточный |

|

||

сообщен |

|

избыточный |

|

Модуляция, НКС, |

ий |

|

Код |

|

ДКС |

|

|

код |

|

|

|

|

|

|

Декодирование Избыточного кода неизбыточного

кода

Кодирование источника сообщений

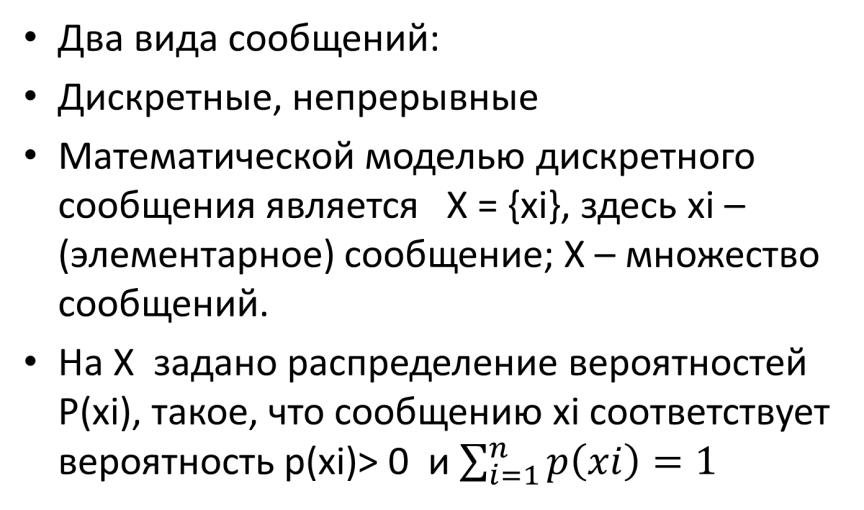

•Два вида сообщений:

•Дискретные, непрерывные

•Математической моделью дискретного сообщения является X = {xi}, здесь xi – (элементарное) сообщение; X – множество сообщений.

•На X задано распределение вероятностей P(xi), такое, что сообщению xi соответствует вероятность p(xi)> 0 и

Кодирование источника сообщений

•Конечное множество сообщений X с заданным на нем

распределением вероятностей P(x) называется ансамюлем сообщений и обозначается {X, P(x)}. Таким образом , источник сообщений характеризуется составом X и заданным на нем распределение вероятностей появления сообщений на его выходе P(x)=

• {p(xi)}.

Кодирование источника сообщений

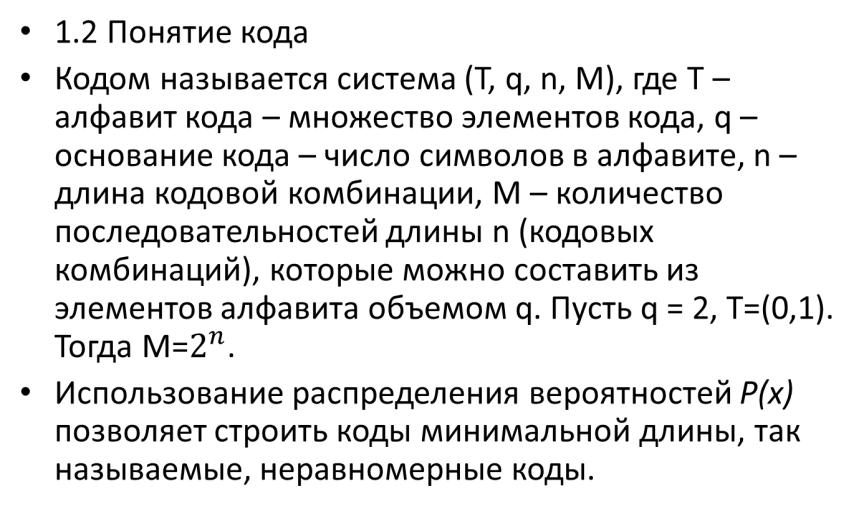

•1.2 Понятие кода

•Кодом называется система (T, q, n, M), где T – алфавит кода – множество элементов кода, q – основание кода – число символов в алфавите, n – длина кодовой комбинации, M – количество последовательностей длины n (кодовых комбинаций), которые можно составить из элементов алфавита объемом q. Пусть q = 2, T=(0,1). Тогда M=.

•Использование распределения вероятностей P(x) позволяет строить коды минимальной длины, так называемые, неравномерные коды.

Кодирование источника сообщений

•1.3 Количество собственной информации. Энтропия ансамбля сообщений

•Количество собственной информации в сообщении xϵ X определяется величиной J(x)=-log p(x).ю Основание, по которому

берется логарифм, определяет

единицу измерения количества информации. Если это 2, то единица измерения – «бит».. Если

это e, то «нат».

Кодирование источника сообщений

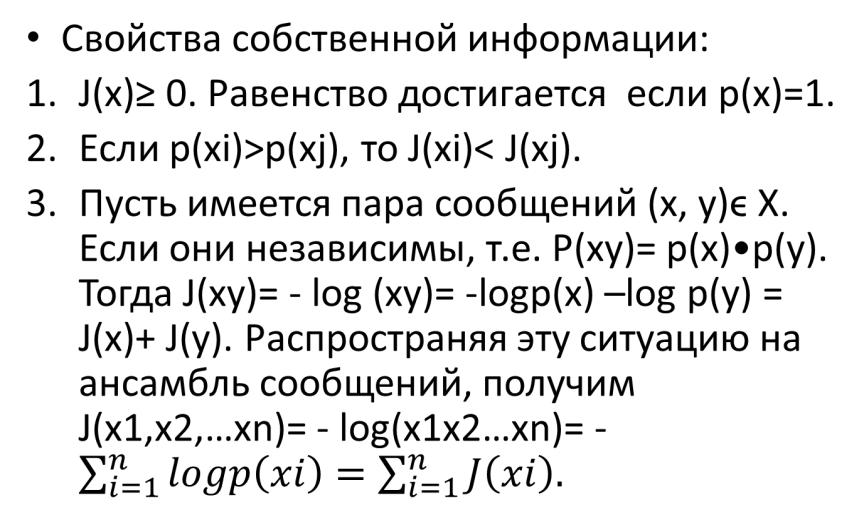

• Свойства собственной информации:

1.J(x)≥ 0. Равенство достигается если p(x)=1.

2.Если p(xi)>p(xj), то J(xi)< J(xj).

3.Пусть имеется пара сообщений (x, y)ϵ X. Если они независимы, т.е. P(xy)= p(x)•p(y). Тогда J(xy)= - log (xy)= -logp(x) –log p(y) = J(x)+ J(y).

Распространяя эту ситуацию на ансамбль сообщений, получим J(x1,x2, …xn)= - log(x1x2…xn)= -

Кодирование источника сообщений

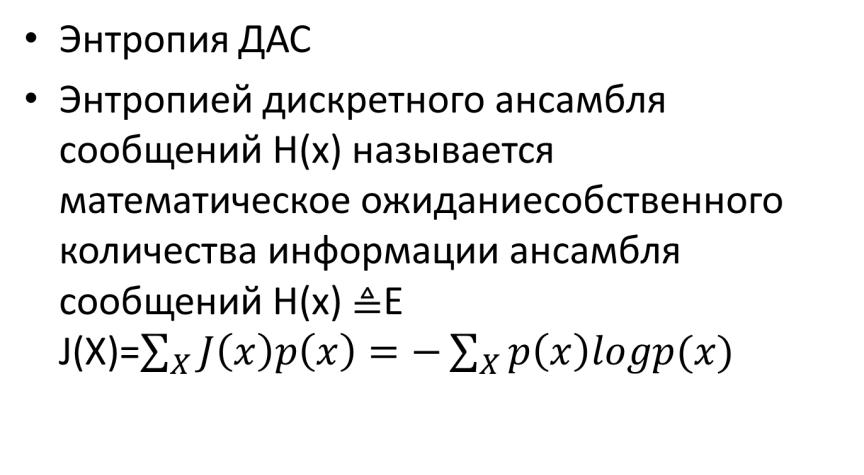

•Энтропия ДАС

•Энтропией дискретного ансамбля сообщений H(x) называется математическое ожиданиесобственного количества информации ансамбля сообщений H(x) E J(X)=

Кодирование источника сообщений

Свойства энтропии

1.H(x)≥0. H(x)=0 если существует такое xiϵ X, что p(xi)=1 и p(xj)=0 для всех j‡I xjϵX.

2.Если ансамбль X содержит N сообщений, то H(x)≤ log N. Если для всех xiϵX p(xi)=1/N, то есть раcпределение вероятностей на множестве X равномерно, то H(x)= log N.

Кодирование источника сообщений

•Оптимальное кодирование – кодирование сообщений неравномерным кодом.

•В общем случае кодирование можно представить как отображение δ: X→M.

•Простой способ построения неизбыточного равномерного кода:

•Построение графа типа двоичного дерева.