ИСКУССТВЕННЫЙ ИНТЕЛЛЕКТ В РОБОТОТЕХНИКЕ

.pdfи используется для решения наиболее трудных задач обработки информации и управления.

Представление знаний в форме искусственных нейронных сетей.

В искусственных нейронных сетях (ИНС) знания формируются какотображениявходовнавыходы. Ониформируютсявпроцессе обучения, прикоторомузловыеэлементынастраиваютсявсоответ- ствиисзапоминаемойинформацией. Наборытакихотображений запоминаютсяиактивизируютсявассоциативнойструктуреИНС.

ИНСнаилучшимобразомрешаютзадачиклассификациииап- проксимации. Ценным свойством ИНС является их способность к обобщению, т.е. решению задач при неполной информации на входах вследствие присущей им ассоциативности.

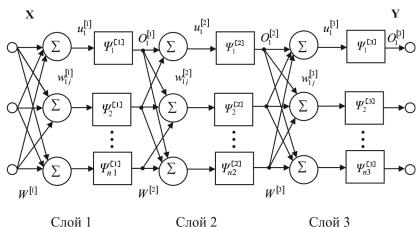

На рис. 2.6 приведена структура трехслойной обучаемой ИНС персептронноготипа. Отображениевходовнавыходы, формируе- мое таким персептроном, можно представить в матричной форме

Y [x] [3][W [3] [2][W [2] [1][W [1]X ]]] .

Здесь – статическая характеристика нейрона – его функция активации, а W – настраиваемые веса. Сигнал, подаваемый на функцию активации i-го нейрона s-го слоя,

ui[s] ns wij[s] o[js 1],

j0

авыход нейрона после функции активации

oi[s] [is](ui[s]) [is][ ns wij[s] o[js 1]]. j 0

Процессобученияперсептронасостоитвподборевесоввовсех слоях. Дляэтоготребуетсяразделитьобщуюошибкунавыходесети между желаемым и реальным выходом при заданном входе про- порционально вкладу каждого слоя в отображение зависимости между входами и выходами, а затем вычислить новые значения весов для нейронов всех слоев. Функция ошибки, используемая при обучении,

71

E E p |

1 |

(dip yip )2 , |

p |

2 |

p i |

гдеE – ошибкаотображенияp-гопримеразависимости(p=1,...P).

Рис. 2.6. Схема трехслойного персептрона.

Цельобучениясостоитвкоррекциивсехвесовнейроновтаким образом, чтобы разность между действительными и желаемыми выходами, усредненная по всем примерам, была минимальна.

Стандартный алгоритм минимизации функции ошибки Е основан на пошаговом градиентном спуске. На входы сети по- следовательно подаются векторы, соответствующие обучающим образам. Для каждого примера веса wij[s] (s = 1, 2, 3) изменяются добавлением ∆wij[s], пропорционального градиенту Ер

[s] |

|

E p |

|

|

w |

- |

|

, 0 . |

|

w[s] |

||||

ij |

|

|

||

|

|

ij |

|

Еслипараметрηдостаточномал, этапроцедураминимизирует Е= ∑Ер. Существуюттакжеэвристическиеалгоритмынастройки, обеспечивающие большую скорость обучения, чем градиентный алгоритм.

72

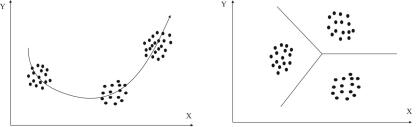

Прямонаправленные сети с самообучением. Сети, работающие без учителя, получили применение для сжатия и кластеризации входных образов (рис. 2.7 и 2.8). Сжатие данных и уменьшение степени их избыточности может облегчить последующую работу снимиивыделитьсущественныепризнаки. Поэтомусамообучаю- щиесяИНСчастоиспользуютименнодляпредобработки«сырых» данных.

Рис. 2.7. Сжатие (обобщение) |

Рис. 2.8. Кластеризация |

информации |

информации |

НаиболееизвестнымвариантомсамообучающихсяИНСявля- ются сети Кохонена. Такие сети относятся к прямонаправленным ИНСссоревновательнымобучением. Онозаключаетсявувеличе- нии весов нейронов сети пропорционально значениям его входов и выходов. В результате выход нейрона с наибольшим выходом усиливается, а остальных – подавляется. Этот принцип физиолог Хебб обнаружил в 1949 году в естественных нейронных сетях. На его основе и были разработаны программы самонастройки ИНС.

Нейронныесетис обратнымисвязями. В1982 годуДж. Хопфилд,

специалист в области физики твердого тела, выявил аналогию междунейроннымисетямииспиновымистёклами. Наэтойоснове онпредложилновыйтипИНСсобратнымисвязями, которыеполу- чили название сети Хопфилда. В отличие от прямонаправленных ИНС, которыепослеобученияосуществляютстатическоепреобра- зованиевходногосигнала, этисетиявляютсядинамическими. Сети Хопфилда используются как ассоциативная память, в частности, для распознавания образов и их классификации.

73

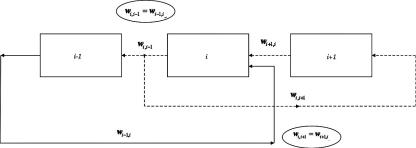

На рис. 2.9 показана структура сети Хопфилда. Каждый i-й нейрон соединяется прямыми с каждым (i-1)-м нейроном и об- ратными связями с каждым (i+1)-м нейроном.

Рис. 2.9. Структура сети Хопфилда

Такаясетьможетиспользоватьсявследующихрежимах. Васин- хронном режиме нейроны могут принимать два состояния s 1; 1 . В дискретные моменты времени t 1,2,... случайным образомвыбираетсяk-йнейрон, длякотороговычисляетсязначе- ние потенциала uk wki si . При выполнении условия uk sk 0 , состояниенейронаменяетсянапротивоположное: sk sk . Впо- следовательном режиме перебор нейронов производится не слу- чайно, ациклически, новкаждыймоментвремениt можетменять- сясостояниелишьодногонейрона. Впараллельномрежимеодно- временно изменяется состояние тех нейронов, для которых вы- полняетсяусловие uk sk 0 . Синхронизациямоментовобновления состояний нейронов делает такую динамику подверженной «за- цикливанию».

АсинхроннаядинамикасетиХопфилдасопровождаетсяумень- шением энергии

E 1 wij si s j .

2 i, j

Такприизменениисостоянияодногоk-гонейронаеговкладвве-

личинуэнергииЕизменяетсяс Ek t sk wkj s j t sk t uk t

i k

74

на Ek t 1 sk t 1 uk t . Следовательно Ek t 1 Ek tsk t uk t . Этаэволюциясостояниязаканчиваетсястационар-

ным состоянием с минимумом величины E .

Для обучения сети Хопфилда можно использовать правило Хебба и вычислять веса связей по формуле

|

|

wij |

1 |

ip pj , wij 0; i, j |

|

. |

|

|

1,N |

||||

|

|

|

||||

|

|

|

N |

|||

Здесь p = 1,...,P – число примеров; p – вектор, кодирующий |

||||||

образ: p p |

|

. Этоправилогарантируетстационарностьпро- |

||||

i |

N |

|||||

извольновыбранныхвекторов p вслучае, когдаихчислоP=0.05N. |

||||||

При больших значениях P некоторые из запомненных p теряют свойствостационарности. При P 0.14N стационарныесостояние

сети теряют всякую связь с p и сеть переходит из режима запо- минания в режим с большим числом аттракторов, далеких от за-

помненных p [3].

2.6. Когнитивный искусственный интеллект

Термин «когнитивный» возник в психологии для обозначения познавательнойдеятельностичеловека, азатемперешелвтехнику какопределениесамообучающихсяинтеллектуальныхтехнических систем. Когнитивныйискусственныйинтеллект– этосамообуча- ющийсяилисамосовершенствующийсяискусственныйинтеллект. В предыдущих параграфах 2.4 и 2.5 при рассмотрении формали- зованных и биоподобных методов искусственного интеллекта упоминалось об их развитии в направлении придания им способ- ности к самообучению с целью приобретения новых знаний, что соответствует важнейшей способности естественного интеллекта

кпознанию, т.е. когнитивности (cognition – познание).

Врамках искусственного интеллекта разрабатываются искус- ственные когнитивные системы, накапливающие знания в про- цессеобучения. Рассмотримнесколькопримеровтакихсистем[3].

75

Система АСТ (Adaptive Control of Thought) основана на методах математическойлогики– системепродукций, состоящейизрабо- чей памяти и памяти продукций, а также на обобщенной модели мышления человека, включающей память, знания, принятие решений и обучение. Обучение рассматривается как процесс, включающийдекларативныйипроцедурныйэтапывзависимости от состояния знаний системы.

В начале обучения (на декларативном этапе) в памяти систе- мы формируются начальные знания в форме высказываний, но их нельзя непосредственно использовать при решении задачи. Высказывания формируются в кратковременной рабочей памяти

ипредварительнообрабатываютсяинтерпретатором«сверху-вниз» (отцелизадачиксредствамеерешения). Когдазадачапоставлена, тоинформацияоней, содержащаясяврабочейпамяти, заменяется знаниями из долговременной памяти. Интерпретатором является система универсальных продукций, которые можно использовать для преобразования информации, необходимого для решения за- дачи. Такиепреобразованиявыполняютсяспомощьюмеханизмов компиляции знаний, названных процедурализацией и компози- цией.

Процедурализация состоит в замене переменных в начальных универсальных продукциях на некоторые конкретные значения. Композиция обеспечивает слияние независимых продукций

иформирование обобщенной продукции, позволяющей за один шагсделатьтребуемоедействие. Этоповышаетскоростьобработки

иуменьшает нагрузку на долговременную память. Заметим, что

унаученногочеловека(специалиста) логическиевыводыделаются «снизу-вверх» по типу образного мышления.

Пройдякомпиляциюзнаний, необходимыхдлярешениязада- чи, процессобученияпереходитнапроцедурныйэтап, соответству- ющий координации знаний. Три механизма координации знаний названыспециализацией, обобщениемиусилением. Специализа- цияобеспечиваетсозданиеновойпродукциинаосноверазделения успешноинеуспешноприменяемыхпродукций, атакжевыявление условийуспешногопримененияивключенияэтихусловийвновую

76

продукцию. Обобщение объединяет продукции, порождающие один результат. Оно реализуется за счет исключения несовпадаю- щихвысказыванийвусловияхпродукцийвслучае, когдапродукции имеют одно и тоже действие, а также путем последующей замены постоянных на переменные. Усиление позволяет повысить при- оритет часто используемых продукций, чтобы при сопоставлении онииспользовалисьчаще. Этоприводиткстабилизациипроцесса решения задачи.

ПриреализацииАСТбылиразработанынесколькоархитектур, которые продолжают модернизироваться. Наиболее интересный вариант архитектуры, названный АСТ-R (Rational), представлен на рис. 2. 10. Эта архитектура содержит 5 модулей. Модуль целей следитзавнутреннимсостояниемсистемы, формируетнаборцелей, которыеопределяютповедениесистемы. Решениезадачопределя- ется текущими целями, в соответствии с которыми генерируются действия. Декларативный модуль ищет информацию в долговре- менной памяти декларативных знаний. Визуальный модуль обра-

Рис. 2 10. Архитектура АСТ-R

77

батывает сенсорную информацию о среде. Мануальный модуль формируетмоторныедействия, которыеизменяютокружающую среду. Продукционная система включает процедурную память и координирует действия всех перечисленных модулей, раз- решая конфликты, возникающие, если поиск решений требует реализации сразу нескольких продукций. Это делается через 4 буфера, которые способны воспринимать ограниченное ко- личество информации.

АСТ-R действует циклически: информационные паттерны, находящиесявбуферах(определяемыевнешнейсредойивнутрен- ним состоянием системы), распознаются, одиночные продукции запускаются и буферы модернизируются. Декларативные знания кодируют объекты среды, в то время как процедурные знания ко- дируютеенаблюдаемыепреобразования. Когнитивностьвозникает при взаимодействии декларативной и процедурной памяти. Цен- тральным свойством АСТ-R является то, что эти два типа знаний настраиваютсявспецифическихприложенияхчерезкодирование знаний. Таким образом АСТ-R учится путем регулирования или настройки параметров знаний.

Система SOAR также обучается и решает задачи с использова- ниемпродукционныхправил. Онаиспользуетметодыкомпиляции знаний, подобныепредложеннымвАСТ, ипозволяетстроитьког- нитивныесистемы, которыемогутбытьохарактеризованывтерми- нахцелей, состояний, операторовипредпочтений. Предпочтения могут быть использованы, чтобы организовать нормы для выбора приемлемыхцелей, состоянийпространствазадачииоператоров. Долговременная база знаний системы содержит набор правил. Кратковременнаяпамятьфиксируетнабортекущейинформации, помещаемый в рабочую память.

СистемаSOAR быласконструировананабазепсихологических идей и может рассматриваться как программная реализация уни- фицированнойтеориипознания. Эмпирическиеисследованиявы- явили, чтовомногихпримерахповедениеSOAR-системсравнимо с поведением людей. Организационная структура системы может изменяться в ответ на изменения среды, поскольку она встроена

78

в базу знаний и связана со стандартной рабочей процедурой ре- структуризации системы при различных условиях.

Последующая разработка Robo-SOAR ориентирована на ис- пользованиевинтеллектуальнойробототехнике. Болеепоздниераз- работкиPlural SOAR, TAC Air SOAR идр. основанынаболееполных моделях человеческого познания и используются для построения когнитивныхагентовдляколлективнойработы. Такиемногоагент- ныевариантыSOAR строятсясиспользованиемвнутреннихмоделей других агентов команды, когнитивных структур общения и комму- никации. Каждый член команды является агентом с ментальной моделью поведения, о которой другие агенты или знают, или будут знать в определенных обстоятельствах. Эти знания могут включать представления о целях и предпочтениях других агентов, что позво- ляеткаждомуагентупрогнозироватьихповедение. Агентыкоманды имеютзнаниякакреализоватькоммуникацииипередаватьсообще- ния. Коммуникация в этих моделях управляется путем передачи соглашенийсоспециальным, связаннымсзадачейсодержанием.

Система EURISCO построена как интеллектуальная система, использующаяметаправила, которыепозволяютформироватьно- выезнаниявпроцессефункционированиявизмененныхусловиях. Метаправилаиспользуютсявместеспродукционнойбазойзнаний и реализуют так называемое индуктивное обучение, основанное на обобщениях. Набор метаправил позволяет накапливать новые продукционныеправилаврежимеобучения. Любоепонятиевси- стеме, включая правила, представлено в виде фрейма из слотов, которые могут добавляться или уничтожаться в процессе работы. Новыеслотысоздаютсяпометаправилам, определяющимпричины создания. Структура фреймов и внутренних слотов иерархически наращивается путем добавления информации, необходимой для лучшего соответствия ситуации.

Подобныесистемы, посуществу, имитируюткреативныефунк- ции человека, позволяющие делать «открытия», т.е. генерировать неизвестные факты и правила, обладающие полезностью.

Система CASNET является примером обучаемой системы на семантических сетях. Такие системы менее популярны, чем про-

79

дукционные, но также могут в определенной степени отображать когнитивныепроцессыформированияпонятийвпамятичеловека. CASNET развиваетконцепциюсложныхсемантическихсетейсав- томатическимформированиемпонятийиотношениймеждуними.

Система ориентирована на диагностику заболевания глауко- мой. В ней используется одна из разновидностей семантических сетей– каузальнаясеть. Узлысетипредставляютсостояниясисте- мы, адуги– отношения. Структурасети– иерархическая. Принято трехуровневое описание болезни: наблюдения, физиологические состояния, категории болезни.

Система ET (Expert Tomographer) использует эволюционный (генетический) алгоритм обучения, который работает хорошо, когда имеет место удачное представление компонентов знаний. Выбранная форма представления знаний в виде фреймов со слотами, содержащими компоненты правил (условия и заклю- чения), коэффициентыуверенностиипорогисрабатыванияус- ловий, коэффициенты уверенности и ослабления заключений, позволяет учитывать иерархию слотов и неопределенности. Генетический алгоритм применен для улучшения фреймов с правилами.

Рассмотрим два фрейма, которые генетический алгоритм должен скопировать и пересечь друг с другом с использованием операции кроссовера:

Фрейм 1: ЕСЛИ кт = нарушение И плотность = гиперплотный

Ииб = нейросимптомы И время = меньше 6 недель ТО д = инфаркт; Фрейм 2: ЕСЛИ кт = нарушение И плотность = гиперплотный

Ииб= нейросимптомыИвремя= меньше1 неделиТОд= гематома.

Здесь ЕСЛИ, ТО – слоты первого уровня; кт – компьютерная

томография, иб – история болезни, д – диагноз; плотность и вре- мя – слоты второго уровня, сопровождаемые своими значениями (справа после =). Одно возможное пересечение при кроссове- ре – обмен значениями слотов время. В результате пересечения рождаются

ПотомокФрейма 1 со слотом время = меньше 1 неделя; ПотомокФрейма 2 со слотом время = меньше 6 недель.

80