LEC03.Теория информации

.pdf

Информатика

Учебный год 2014/2015 Кафедра ВТ НИУ ИТМО. Соснин В.В., Балакшин П.В.

Группы 1100, 1101, 1103, 1105, 1106, 1652

Лекция 3. Введение в теорию информации

2

Анализ аннотаций студентов

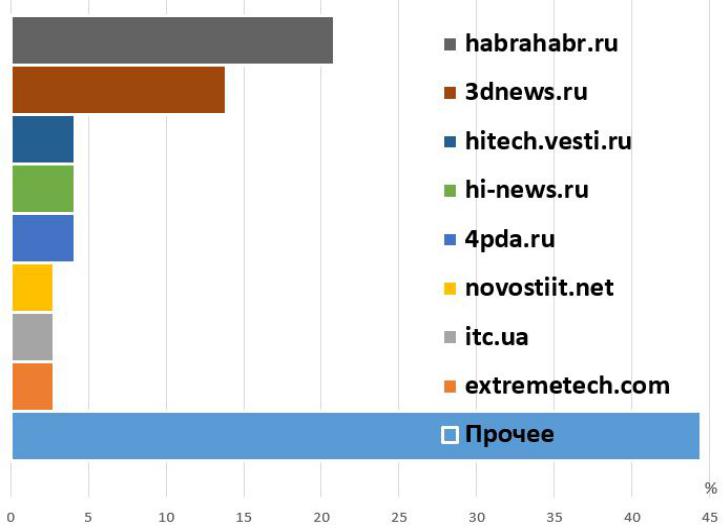

Список IT-ориентированных |

3 |

|

|

новостных ресурсов |

|

3dnews.ru, 4pda.ru, android.com, betanews.com, blogs.intel.com, cam.ac.uk, cnews.ru, computerworld.com, dailytechinfo.org, datbaze.ru, discovery.com, extremetech.com, gizmodo.com, habrahabr.ru, hi-news.ru, hitech.vesti.ru, iksmedia.ru, it-news-world.ru, it-top.ru, itworld.ru, it.tut.by, itc.ua, itnews.com.ua, itupdate.ru, itworld.com, mobiledevice.ru, news-it.net, news.softpedia.com, novostiit.net, osp.ru, overclockers.ru, research.ibm.com, sciencedaily.com, sciencemag.org, singularityhub.com, thehackernews.com, theverge.com, thg.ru, usenix.org, wired.co.uk ...

4

Дайджест аннотаций студентов

1.Доставка товаров дронами.

2.Компьютерные игры против депрессии.

3.Автомобиль на 3D-принтере.

4.Компьютер в SD-карте (500 MHz, 1GiB).

5.Хитрый фишинг tabnabbing.

6.Китайские палочки с датчиками.

7.Доставка Wi-Fi на дронах.

8.CodeSpells — игра в программирование.

9.Петабайт данных на одном DVD (x250000).

Терминология теории информации

Информация – это некоторая упорядоченная последовательность сообщений, отражающих, передающих и увеличивающих наши знания.

Информация – это сведения об окружающем мире (объекте, процессе, явлении, событии), которые являются объектом преобразования (включая хранение, передачу и т.д.) и используются для выработки поведения, для принятия решения, для управления или для обучения.

5

Терминология теории информации (2)

Информация – новые сведения (энтропия).

Информация – новые сведения (энтропия).

Данные — форма представления сведений (речь, буквы).

Данные — форма представления сведений (речь, буквы).

Пример: «Байкал — самое глубокое озеро Земли»

Пример: «Байкал — самое глубокое озеро Земли»

●Сколько в этой фразе информации для русского?

●Сколько в этой фразе информации для китайца?

●Сколько данных в этой фразе?

Алфавит – конечное множество различных знаков (букв), символов, для которых определена операция конкатенации (присоединения символа к символу или цепочке символов).

Знак – любой элемент алфавита.

Слово – конечная последовательность букв алфавита.

Словарь — множество различных слов над алфавитом.

6

Признаки классификации информации

●отношение к источнику или приемнику (входная, выходная и внутренняя);

●отношение к конечному результату (исходная, промежуточная и результирующая;

●актуальность;

●адекватность;

●доступность (открытая, закрытая);

●понятность;

●полнота (недостаточная, достаточная, избыточная);

●достоверность;

●массовость;

●изменчивость (постоянная, переменная, смешанная);

●объективность;

●точность;

●стадия использования (первичная, вторичная);

● ценность (полезность). |

7 |

Измерение количества информации

Методы получения информации

●Эмпирические

●Теоретические

●Эмпирико-теоретические

Количество информации – число, адекватно характеризующее разнообразие (неопределённость) в оцениваемой системе.

Мера информации – численная оценка количества информации, которая обычно задана неотрицательной аддитивной функцией (т.е. мера информации объединения событий равна сумме мер каждого события).

8

Мера Хартли

Пусть известны N равновероятных состояний некоторой системы S (например: “орёл”, “решка”). Если каждое состояние системы закодировать двоичными кодами, то длину кодаd необходимо

выбрать так, чтобы число всех различных комбинаций Ральф Хартли было бы не меньше, чем N:

2d≥ N → d≥ log2 N

Значит, для однозначного описания системы требуется log2N бит. В общем случае количество информации в системе S равно

Hs = logkN

Единицы измерения количества информации:

бит (k=2), трит (k=3), дит (k=10), нит/нат (k=e)

9

Пример использования меры Хартли

Пример 1. Ведущий загадывает число от 1 до 64. Какое количество вопросов типа «да-нет» понадобится, чтобы гарантировано угадать число?

●Первый вопрос: «Загаданное число меньше 32?». Ответ: «Да».

●Второй вопрос: «Загаданное число меньше 16?». Ответ: «Нет».

●…

●Шестой вопрос (в худшем случае) точно приведёт к верному ответу. Значит, в соответствии с мерой Хартли в загадке ведущего содержится log264 = 6 бит информации.

Пример 2. Ведущий держит за спиной шахматного ферзя и собирается поставить его на произвольную клетку пустой доски. Какое количество информации содержится в его действии?

Ответ: всего на доске 8х8 клеток, а цвет ферзя может быть белым или чёрным, т. е. всего возможно 8х8х2 = 128 равновероятных состояний. Значит, количество информации по Хартли равно log2128 = 7 бит.

10