- •Примеры базисов

- •Интегрирование

- •Определение

- •Аддитивная граница

- •25. Вероятность ошибки при оптимальном приеме в канале со случайной фазой

- •26. Относительная фазовая модуляция

- •27. Распределения Релея и Райса

- •28. Канал с замираниями. Модель с рассеивателями

- •32. Каналы с межсимвольной интерференцией. Оптимальный прием

- •Литература

11. Вероятность ошибки при оптимальном приеме дискретных сигналов

Вероятность ошибки может быть найдена как

q−1 |

|

Pe = ∑Pe (i)Pi , |

(11.1) |

i=0 |

|

где Pe (i) – вероятность ошибки при передаче i -го сигнала, |

Pi – вероятность |

передачи i -го сигнала. Выражение (11.1) дает точное значение вероятности ошибки. В ряде случаев воспользоваться этим выражением не удается, так как

невозможно точно вычислить условные вероятности Pe (i) . В этом |

случае |

приходится пользоваться верхней оценкой вероятности ошибки |

|

q−1 ~ |

|

Pe ≤ ∑Pe (i)Pi , |

(11.2) |

i=0 |

|

~ ≥

где Pe (i) Pe (i) верхняя оценка условной вероятности ошибки. Для вычисления этой оценки существует ряд подходов. Рассмотрим некоторые из них.

Аддитивная граница (аддитивное неравенство, неравенство Буля, граница объединения). Условная вероятность ошибки при передаче i -го сигнала определяется как

Pe (i) = Pr[i ≠ i | i] .

Используя понятие решающей области, виде

Pr[i) ≠ i | i] = Pr[r Ri

это выражение можно переписать в

q−1 |

|

|

|

| i]= Pr U{r Rk |

| i} . |

(11.3) |

|

|

k =0 |

|

|

k ≠i |

|

||

|

|

|

|

Аддитивное неравенство позволяет оценить сверху вероятность объединения любых событий. Оно записывается как

|

|

|

≤ ∑Pr[ Ai ] , |

(11.4) |

Pr UAi |

||||

|

i |

|

i |

|

где {Ai } множество некоторых событий. Применяя (11.4) к (11.3), получим

Pr[i) |

q−1 |

|

≠ i | i] ≤ ∑Pr[r Rk | i] . |

(11.5) |

k =0 k ≠i

Вероятность Pr[r Rk | i] в свою очередь может быть оценена сверху вероятностью ошибки в системе передачи, использующей только два сигнала

s |

(t) и s |

k |

(t) . |

В такой системе существуют только две решающие области R(2) |

|||||||||

i |

|

|

|

|

|

|

|

|

|

i |

|

|

|

и |

R(2) 1), |

то есть R(2) |

UR(2) = R D и |

R(2) I R |

(2) . Очевидно, |

что R(2) |

R |

k |

, |

||||

|

k |

|

|

i |

k |

i |

k |

|

k |

|

|

||

поэтому Pr[r Rk | i] ≤ Pr[r Rk(2) | i] , далее |

|

|

|

|

|

|

|

||||||

|

|

|

|

|

~ |

q−1 |

|

(2) |

| i] . |

|

|

|

|

|

|

|

|

|

Pe (i) ≤ Pe (i) = |

∑Pr[r Rk |

|

|

|

|

|||

|

|

|

|

|

|

k =0 |

|

|

|

|

|

|

|

|

|

|

|

|

|

k ≠i |

|

|

|

|

|

|

|

Вычисление |

вероятности Pr[r Rk(2) |

| i] |

обычно |

оказывается |

сравнительно |

||||||||

несложным в отличие от вероятности Pr[r Rk |

| i] . Окончательное выражение |

||||||||||||

для аддитивной границы вероятности ошибки имеет вид |

|

|

|

|

|||||||||

|

|

|

|

|

q−1 q−1 |

|

|

| i]Pi . |

|

|

|

|

|

|

|

|

|

|

Pe ≤ ∑∑Pr[r Rk(2) |

|

(11.6) |

||||||

i=0 k =0 k ≠i

□

Аппроксимация решающей области. Условная вероятность ошибки при передаче i -го сигнала определяется как

Pe (i) = Pr[i ≠ i | i] .

Используя понятие решающей области, это выражение можно переписать в виде

Pr[i) ≠ i | i] =1 − Pr[r Ri | i]=1 − ∫w(r | i)dr . |

(11.7) |

Ri |

|

Если интеграл в правой части равенства (11.7) вычислить не удается, то можно

оценить его снизу, |

используя подходящую аппроксимацию решающей области |

|

~ |

~ |

выбрана так, |

Ri . Пусть Ri Ri |

и конфигурация аппроксимирующей области Ri |

|

что интеграл ∫R~i w(r | i)dr вычисляется аналитически. Поскольку w(r | i) ≥ 0 для

всех r , так как это плотность вероятностей, то ∫R~ w(r | i)dr ≤ ∫R w(r | i)dr . |

||

|

i |

i |

Поэтому имеем верхнюю границуPe (i) ≤1 − ∫R~i |

w(r | i)dr и окончательно |

|

1 Верхний индекс 2 здесь означает, что в системе используется только два сигнала

q−1 |

|

Pe ≤1 − ∑Pi ∫~ w(r | i)dr . |

(11.8) |

i=0 Ri |

|

□

В завершение отметим, что для вычисления вероятности ошибки следует использовать, в тех случаях, когда это возможно, точное выражение (11.1), либо оценки, например, оценки (11.6) и (11.8). Во всех случаях для вычисления вероятности ошибки необходимо знать априорное распределение на входе канала {Pi }, условные функции плотности вероятности w(r | i) , описывающие канал, и алгоритм приема, то есть конфигурацию решающих областей.

Число двоичных единиц (бит) переносимых q -ичным сигналом равно

m = log2 q . При ошибке, происходящей при передаче сигналов, формируется ошибочное решение относительно номера переданного сигнала и возникает от

1 до m ошибочных бит. Рассмотрим вероятность ошибки на бит Pb , и ее связь с

вероятностью ошибки на символ Pe . Определим вероятность принятия решения в пользу сигнала с номером i' при условии, что был передан сигнал с номером

i , и обозначим ее |

как Pe (i,i') , |

i' ≠ i , |

то |

есть Pe (i,i') = Pr[r Ri' | i] . Тогда |

|||||

очевидно, чтоPe (i) = ∑iq'=−10,i'≠i Pe (i,i') . |

|

|

|

|

|

|

|||

Пусть |

n(i,i') |

- число разрядов, |

в |

которых различаются |

двоичные |

||||

представления |

номеров сигналов |

i |

и |

i' . Например, |

n(5,6) = 2 , |

так как |

|||

510 =1012 , 610 |

=1102 . Очевидно, |

что |

1 ≤ n(i,i') ≤ m при |

i' ≠ i . Тогда можно |

|||||

записать, что |

|

|

|

|

|

|

|

|

|

|

|

|

1 |

q−1 q−1 |

|

|

|

||

|

|

Pb = |

∑∑Pe (i,i')n(i,i')Pi . |

|

|

||||

|

|

|

|

|

|||||

|

|

|

m i=0 |

i'=0 |

|

|

|

||

i'≠i

Вэтом равенстве фактически записано отношение среднего числа ошибочно принятых бит к их общему числу. Точное вычисление вероятности ошибки на бит может оказаться затруднительным. Основная проблема состоит

ввычислении, или достаточно точном оценивании, вероятностей Pe (i,i') . Тем

не менее, в ряде случаев сигналов она разрешима.

Заметим, что вероятность ошибки на бит может быть уменьшена, если назначить номера сигналов так, чтобы уменьшить величины произведений

Pe (i,i')n(i,i') . |

На практике |

часто оказывается, что значения вероятностей |

|

Pe (i,i') сильно различаются |

при различных i,i' . В частности это так при |

||

использовании АМ, |

ФМ, КАМ сигналов. Поэтому разумно назначить номера |

||

сигналов так чтобы |

величина n(i,i') была малой для тех пар (i,i') , для которых |

||

вероятность |

Pe (i,i') |

велика. В этом случае можно добиться, что произведения |

|

Pe (i,i')n(i,i') |

будут |

небольшими и общая вероятность ошибки на бит |

|

уменьшится. |

Такая нумерация может быть обеспечена с использованием кода |

||

Грея (Gray code).

Код Грея представляет собой переупорядочение двоичных кодовых последовательностей таким образом, что соседние последовательности

отличаются только в одном двоичном разряде. |

|

Простой пример приведен в |

||||

табл.11.1. |

|

|

|

|

|

|

|

|

|

|

|

|

Таблица 11.1 |

|

Код Грея длины 3 |

|

|

|

||

|

|

|

|

|

|

|

|

Десятичное |

|

Двоичное |

|

Код |

|

|

представление |

|

представление |

|

Грея |

|

|

0 |

|

000 |

|

000 |

|

|

1 |

|

001 |

|

001 |

|

|

2 |

|

010 |

|

011 |

|

|

3 |

|

011 |

|

010 |

|

|

4 |

|

100 |

|

110 |

|

|

5 |

|

101 |

|

111 |

|

|

6 |

|

110 |

|

101 |

|

|

7 |

|

111 |

|

100 |

|

Из табл. 11.1 в частности |

следует, что |

n(5,6) =1, так как 510 =111Gray , |

||||

610 =101Gray . Это значит, что при |

ошибочном решении в пользу сигнала 6 при |

|||||

условии, что был передан сигнал 5, произойдет ошибка только в одном двоичном разряде, а не в двух как при обычной нумерации сигналов. Это значит, что применение кода Грея вместо обычной нумерации сигналов желательно, если вероятность Pe (5,6) велика.

Алгоритм построения кода Грея. Код Грея любой длины может быть

построен рекуррентно. Обозначим код Грея длины n как |

G(n) . Очевидно, что |

|

G(1) ={0,1} . |

Построение кода G(n +1) на основе кода |

G(n) выполняется |

следующим |

образом: |

|

|

~ |

~ |

а) Построение вспомогательного списка G(n) . Список |

G(n) |

|

представляет собой список G(n) , переупорядоченный в обратном порядке |

|

|

б) |

~ |

|

Построение кода Грея G(n +1) из G(n) и G(n) . К началу каждого |

||

слова из |

~ |

и оба |

G(n) приписывается 0, к словам из G(n) приписывается 1, |

||

|

~ |

|

списка слов объединяются, то есть G(n +1) = ((0g, g G(n)),(1g, g G(n))). |

|

|

Пример. Построение кода Грея длины 4. |

|

|

|

~ |

|

По определению G(1) ={0,1} . Тогда G(1) = (1,0) , и G(2) = (00,01,11,10) . |

||

|

~ |

= (10,11,01,00) , и G(3) = (000,001,011,010,110,111,101,100). |

Следовательно G(2) |

||

~ |

= (100,101,111,110,010,011,001,000) , и окончательно G(4) = (0000, |

|

Поэтому G(3) |

||

0001, 0011,0010,0110,0111,0101,0100,1100,1101,1111,1110,1010,1011,1001,1000).

12. Оптимальный прием в канале с аддитивным белым гауссовским шумом

Пусть {si (t)} - множество сигналов, используемых для передачи,

заданных на интервале [0,T ] , i = 0,1,..., q −1, {Pi }- |

априорное распределение, |

||||

заданное на этом |

множестве. |

Сигнал |

на выходе канала |

имеет вид |

|

r(t) = s(t) + n(t) , где |

s(t) {si (t)} , |

n(t) - аддитивный белый гауссовский шум |

|||

(АБГШ) со спектральной плотностью мощности |

N0 / 2 . Задача |

приемника |

|||

состоит в определении номера переданного сигнала |

i по принятому сигналу |

||||

r(t) . |

|

|

|

|

|

Выберем базис {ϕ j (t)}, j =1,..., D , |

для представления сигналов. Тогда |

||||

вместо множества сигналов {si (t)} можно рассматривать множество D -мерных вещественных сигнальных векторов (сигнальных точек) {si }, где si = (si1 ,..., siD )

и |

sij = (si ,ϕ j ) = ∫0T si (t)ϕ j (t)dt |

- скалярное произведение i −го сигнала и |

j -ой |

||||||

базисной |

функции, |

j =1,..., D . |

Аналогично можно построить разложение |

||||||

принятого |

сигнала |

r(t) |

|

по |

базисным |

функциям, |

r = (r1 ,..., rD ) , |

где |

|

rj |

= (r,ϕ j ) = ∫0T r(t)ϕ j (t)dt . |

Очевидно, что |

r = s +n , где |

n = (n1 ,..., nD ) |

и |

||||

n j |

= (n,ϕ j ) = ∫0T n(t)ϕ j (t)dt |

- |

скалярное произведение шума и j -ой базисной |

||||||

функции. |

Отметим, |

что случайные величины (с.в.) n j |

независимы между |

||||||

собой и имеют гауссовское распределение с нулевым математическим ожиданием, поскольку шум имеет нулевое среднее, и дисперсией N0 / 2 , то есть

n j = 0 , n2j = N0 / 2 , и n j nk = 0 , j, k = 0,1,..., D , j ≠ k . Эти свойства следуют из

свойств БГШ.

Для построения алгоритма оптимального приема нужно знать вид

условных плотностей |

вероятностей |

w(r | i) , |

определяемых |

каналом. |

При |

|||||||||||

условии, что передан i -й сигнал, |

r = si |

+ n , поэтому для канала с АБГШ |

|

|

|

|||||||||||

|

1 |

D |

|

|

2 |

|

|

1 |

D |

|

|

1 |

D |

|

|

|

|

|

|

r −si |

|

|

|

|

∑(rj − sij ) |

2 |

|

||||||

w(r | i) = |

|

|

exp − |

|

|

|

= |

|

|

|

− |

|

|

|

, |

|

|

N0 |

|

πN0 |

exp |

N0 |

|

|

|||||||||

|

πN0 |

|

|

|

|

|

|

|

j=1 |

|

|

|

||||

или w(r | i) = K exp(− d 2 (r, si ) / N0 ), где K = (πN0 )−D / 2 , d( , ) - евклидово

расстояние между точками из R D . Теперь можно записать выражение для решающих областей оптимального приемника МАВ

Ri( MAB) = r : Pi exp(− d 2 (r, si ) / N0 )= max Pk exp(− d 2 (r, sk ) / N0 ), |

|

|

|

0≤k≤q−1 |

|

или |

= min (d 2 (r, sk ) − N0 ln Pk ). |

|

Ri( MAB) = r : d 2 (r, si ) − N0 ln Pi |

(12.1) |

|

|

0≤k≤q−1 |

|

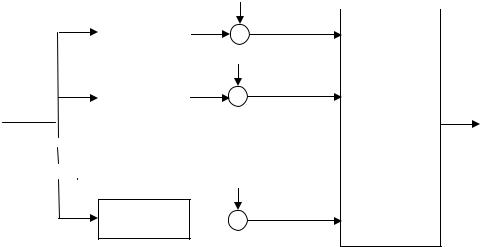

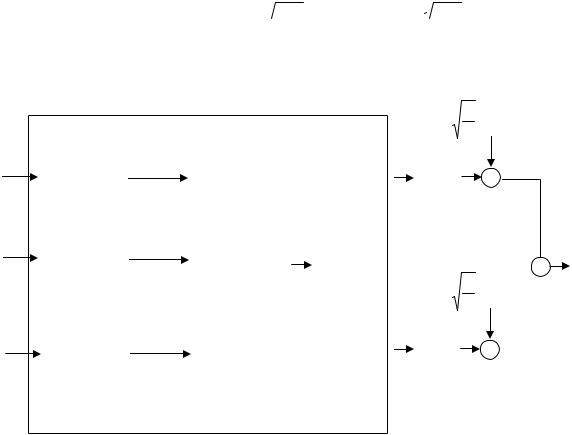

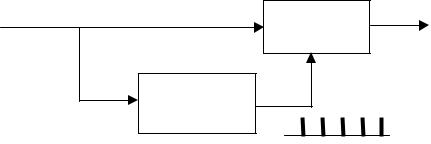

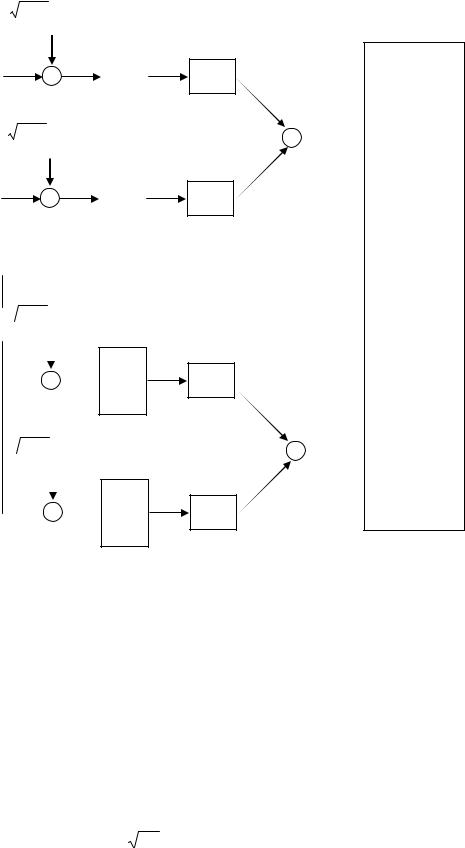

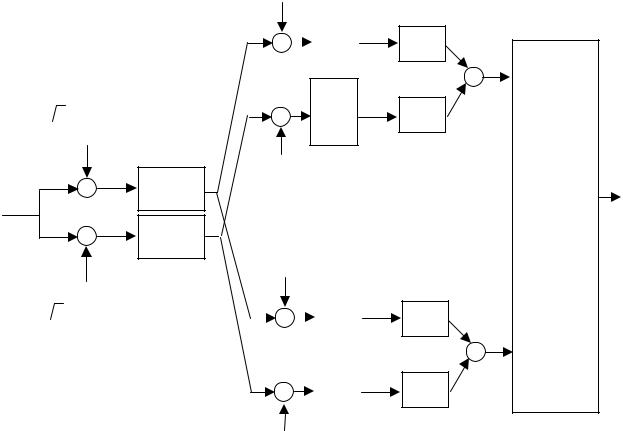

Схема приемника МАВ для канала с АБГШ показана на рис. 12.1

|

|

|

|

− N0 ln P0 |

|

|

|

|

|

|

|

|

|

|

d 2 (r, s0 ) |

+ |

|

|

||

|

|

|

|

|||

|

|

|

|

− N0 ln P1 |

|

|

|

|

|

|

|

||

r |

d 2 |

(r,s1 ) |

+ |

|

Выбор |

i |

|

|

|

|

минимума |

||

|

|

|

|

|

|

|

− N0 ln Pq−1

d 2 (r, sq−1 )  +

+

Рис.12.1 Схема оптимального приемника для канала с АБГШ (приемник по МАВ)

Решающие области МП имеют вид

Ri( MП) = r : exp(− d 2 (r, si ) / N0 )= max exp(− d 2 (r, sk ) / N0 ), |

|

||||

|

|

0≤k≤q−1 |

|

|

|

или |

|

|

|

|

|

R( MП) = r : d(r, s |

) = min d(r, s |

k |

) . |

(12.2) |

|

i |

i |

0≤k ≤q−1 |

|

|

|

|

|

|

|

|

|

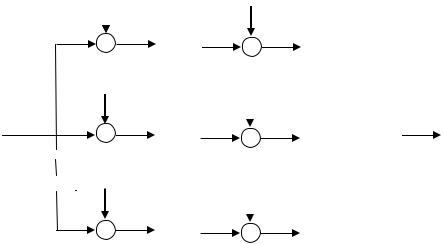

Последнее равенство означает, что прием по МП в канале с АБГШ эквивалентен приему по минимуму евклидова расстояния. Схема приемника МП для канала с АБГШ показана на рис. 12.2

|

|

d 2 (r,s0 ) |

|

|

|

|

|

|

|

Выбор |

|

|

|

|

|

|

|

r |

|

d 2 |

(r,s1 ) |

i |

|

|

|

|

минимума |

|

|

|

|

|

|

||

d 2 (r, sq−1 )

Рис.12.2. Схема оптимального приемника для канала с АБГШ (приемника по МП)

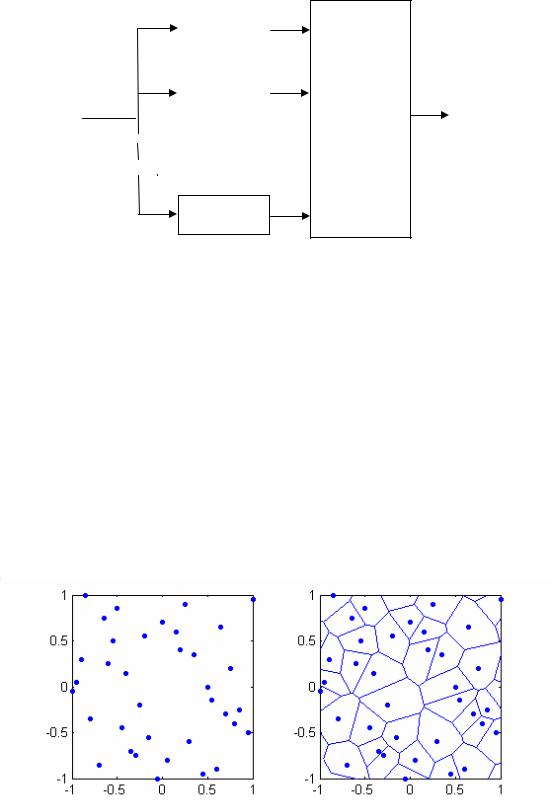

Решающая область Ri , заданная равенством (12.2), представляет собой

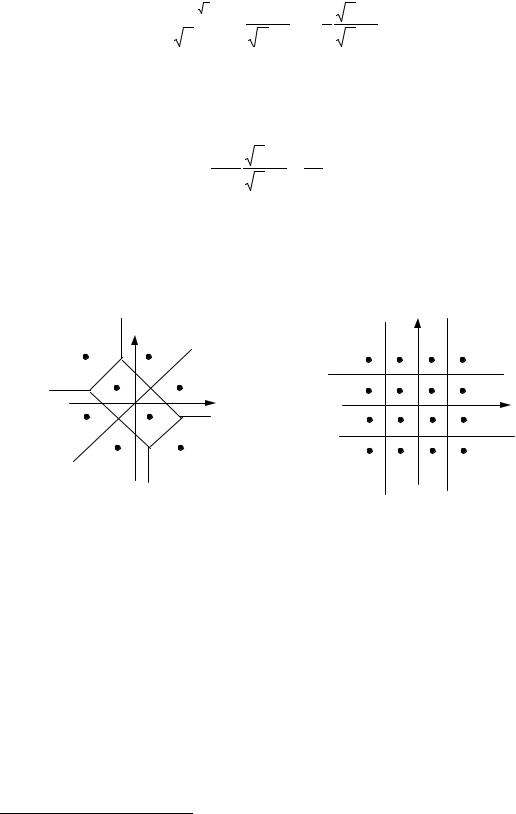

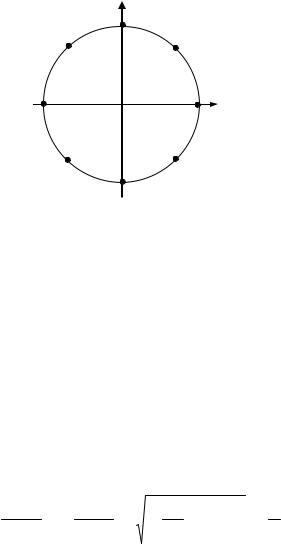

множество точек из R D , лежащих ближе к si , чем к любой другой сигнальной точке sk , k ≠ i . Для случая D = 2 эти области представляют собой выпуклые многоугольники и известны как области Вороного. На рис.12.3 показано для примера некоторое произвольное двумерное сигнальное созвездие и соответствующее ему разбиение на решающие области (области Вороного).

Рис.12.3 Сигнальное созвездие и разбиение на решающие области (области Вороного).

На вход схем, показанных на рис.12.1 и 12.2 , подается вектор r , полученный в результате конечномерного представления выходного сигнала канала r(t) . Рассмотрим более подробно как выглядит приемник,

обрабатывающий выходной сигнал канала r(t) . Поскольку конечномерное представление сохраняет расстояние, то

d 2 (r, si ) = d 2 (r(t), si (t)) = T∫(r(t) − si (t))2 dt = T∫r 2 (t)dt − 2T∫r(t)si (t)dt + Ei ,

0 0 0

где Ei = ∫0T si2 (t)dt – энергия i -го сигнала. Тогда равенства (12.1) и (12.2) можно переписать в виде

Ri( MAB) = |

|

T |

|

|

max |

T |

|

, |

(12.3) |

r : ∫r(t)si (t)dt −Ci( МАВ) = |

∫r(t)sk (t)dt −Ck( МАВ) |

|

|||||||

|

|

0 |

|

|

0≤k≤q−1 |

|

|

|

|

|

|

|

|

|

0 |

|

|

|

|

где C (МАВ) = (E |

k |

− N |

0 |

ln P ) / 2 , k = 0,1,..., q −1, |

|

|

|

|

|

k |

|

i |

|

|

|

|

|

||

T

Ri( MП) = r : ∫r(t)si (t)dt −Ci( МП)

0

|

T |

|

= |

0max≤k≤q−1 |

∫r(t)sk (t)dt −Ck( МП) |

|

|

0 |

, (12.4)

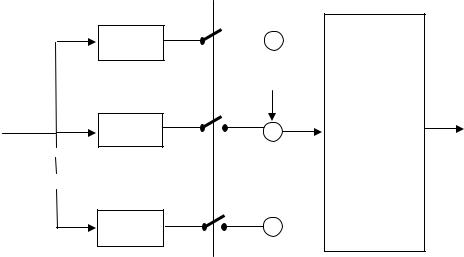

где Ck(МП) = Ek / 2 . Как видно из определения областей (12.3) и (12.4),

решения по МАВ и по МП строятся почти одинаково, разница состоит лишь в

постоянных Ck( МАВ) и Сk( МП) . |

На |

рис 12.4 показана схема оптимального |

||||||

приемника. Эта схема эквивалентна ранее приведенным схемам. |

|

|||||||

|

s0 (t) |

|

|

|

−C0 |

|

|

|

|

|

T |

|

|

|

|||

|

× |

|

|

∫dt |

+ |

|

|

|

|

|

|

|

0 |

|

|

|

|

|

s1 (t) |

|

|

|

|

−C |

Выбор |

|

|

|

|

|

|

||||

|

|

|

T |

|

|

|||

r(t) |

|

|

|

|

1 |

i |

||

|

|

|

|

|

|

|||

× |

|

|

∫dt |

|

|

максимума |

||

|

|

+ |

|

|

||||

|

|

|

|

|

||||

|

|

|

|

0 |

|

|

|

|

|

sq−1 (t) |

|

|

|

−Cq−1 |

|

|

|

|

|

|

|

|

|

|||

|

|

|

T |

|

|

|

||

|

× |

|

|

∫dt |

+ |

|

|

|

|

|

|

|

0 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Рис.12.4. Схема оптимального (корреляционного) приемника для канала с АБГШ

Приемник, показанный на рис.12.4 называется корреляционным, так как структура, приведенная на рис 12.5, называется коррелятором.

|

si (t) |

|

|

r(t) |

T |

||

|

|||

|

∫dt |

||

× |

|

||

|

|

0 |

|

|

|

|

Рис.12.5. Коррелятор

Еще одна эквивалентная приведенным структура оптимального приемника может быть получена с использованием так называемых согласованных фильтров. Фильтр называется согласованным с сигналом si (t) ,

если его импульсная переходная характеристика равна hi (t) = si (T −t).

Рассмотрим реакцию фильтра, согласованного с сигналом si (t) , на сигнал r(t)

∞ |

∞ |

|

t1 = T −t +τ |

|

|

|

|

||||

yi (t) = ∫r(τ)hi (t −τ)dτ = |

∫r(τ)si (T −t +τ)dτ = |

|

τ = t1 −T + t |

|

= |

−∞ |

−∞ |

|

dτ = dt1 |

|

|

|

|

|

|

|

= ∞∫r(t1 −T + t)si (t1 )dt1 .

−∞

Отсюда следует, что yi (t) t =T = yi (T ) = ∞∫r(t1 )si (t1 )dt1 . Это значит, что значение

−∞

на выходе согласованного фильтра, взятое в момент t = T , равно значению на выходе коррелятора. Поэтому оптимальный приемник может быть построен по схеме с согласованными фильтрами и следующими за ними устройствами взятия отсчетов (см. рис.12.6)

h0 (t)

r(t)

h1 (t)

hq−1 (t)

−C0

−C0

+

+

|

−C1 |

Выбор |

i |

|

|

||

|

|

максимума |

|

+ |

|

|

|

|

|

|

−Cq−1

−Cq−1

+

t = T

Рис.12.6. Схема приемника с согласованными фильтрами для канала с АБГШ

Свойства согласованного фильтра. Предположим, что имеется некоторый фильтр с конечной импульсной переходной характеристикой h(t) , 0 < t < T . Пусть на его вход поступает сигнал r(t) = s(t) + n(t) , где s(t) -

полезный сигнал, а n(t) - АБГШ. Покажем, что если фильтр h(t) согласован с сигналом s(t) , то отношение сигнал/шум на выходе фильтра будет

максимальным.

Рассмотрим сигнал на выходе фильтра (символ , как и ранее, обозначает свертку)

y(t) = r(t) h(t) = ∞∫r(τ)h(t −τ)dτ = ∞∫s(τ)h(t −τ)dτ + ∞∫n(τ)h(t −τ)dτ .

−∞ −∞ −∞

Поскольку импульсная переходная характеристика фильтра h(t) равна нулю вне интервала (0,T ) то можно записать, что

|

y(t) = ∫t |

s(τ)h(t −τ)dτ + ∫t |

n(τ)h(t −τ)dτ = sh (t) + nh (t) , |

|

|

t −T |

t−T |

||

где sh (t) = ∫t |

s(τ)h(t −τ)dτ , |

nh (t) = ∫t |

n(τ)h(t −τ)dτ - сигнальная и шумовая |

|

t−T |

|

t−T |

||

составляющие сигнала на выходе фильтра соответственно. Обозначим

~ |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

и |

рассмотрим |

значение |

отсчета |

сигнала |

на выходе фильтра, |

||||||||||

h (t) = h(t −T ) |

|||||||||||||||||||||||||||||||

взятого в момент t = T . Оно равно |

|

|

|

|

|

||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

T |

~ |

T |

~ |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

y(t) |

|

t=T = y(T ) = ∫s(t)h (t)dt + |

∫n(t)h (t)dt , |

|

|||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

0 |

|

0 |

|

|

|

или |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

~ |

~ |

|

(12.5) |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

y(T ) = sh (T ) + nh (T ) = (s, h ) + |

(n, h ) , |

|||||

где через |

|

( , ) |

|

|

|

обозначено скалярное |

произведение функций, |

~ |

|||||||||||||||||||||||

|

|

|

|

sh (T ) = (s, h ) - |

|||||||||||||||||||||||||||

отсчет сигнальной составляющей на выходе фильтра, |

nh (T ) = |

~ |

|||||||||||||||||||||||||||||

(n, h ) - отсчет |

|||||||||||||||||||||||||||||||

шумовой составляющей на выходе фильтра. |

Величина nh (T ) |

представляет |

|||||||||||||||||||||||||||||

собой гауссовскую случайную величину с нулевым средним |

и дисперсией |

||||||||||||||||||||||||||||||

(N0 / 2) |

|

~ |

|

|

|

2 |

|

= (N0 / 2) |

|

h |

2 |

. |

|

|

|

|

|

|

|||||||||||||

|

h |

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||||||||||

В |

|

дальнейшем рассмотрении |

будет |

использовано |

неравенство |

||||||||||||||||||||||||||

( f , g)2 ≤ |

|

|

|

f |

|

|

|

2 |

|

|

|

g |

|

|

|

2 , |

|

известное |

как неравенство Коши-Шварца-Буняковского. |

||||||||||||

|

|

|

|

|

|

|

|

|

|||||||||||||||||||||||

Оно обращается в равенство, |

если функции f (t) и |

g(t) |

пропорциональны, то |

||||||||||||||||||||||||||||

есть если |

f (t) = Cg(t) , где C - некоторая константа. |

|

|

|

|||||||||||||||||||||||||||

|

Легко видеть, что если положить |

|

|

|

|

||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

~ |

|

|

|

|

(12.6) |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

h (t) = Cs(t) , |

|

|

|

||

то для величины квадрата сигнальной составляющей в равенстве (12.5) можно

с использованием |

неравенства |

Коши-Шварца-Буняковского |

записать, |

|

что |

|||||||||||||||||||||||||||

sh (T )2 = (s,Cs)2 = C 2 |

|

|

|

s |

|

|

|

4 = C 2 E 2 , |

где |

E |

- энергия сигнала. При этом условии |

|||||||||||||||||||||

|

|

|

|

|||||||||||||||||||||||||||||

дисперсия шумовой компоненты будет равна σh2 = (N0 / 2) |

|

|

|

Cs |

|

|

|

2 |

= (N0 / 2)C 2 |

|

|

|

s |

|

|

|

2 , |

|||||||||||||||

|

|

|

|

|

|

|

|

|||||||||||||||||||||||||

а отношение этих величин будет равно своему максимальному значению |

|

|

|

|

|

|

||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

sh (T )2 |

= |

E |

|

|

|

|

|

|

|

|

|

||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

. |

(12.7) |

|||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

σh2 |

(N0 / 2) |

|||||||||||||||||||

Заметим, что значение константы C не играет роли, так как она присутствует в |

||||||||||||||||||||||||||||||||

числителе и |

знаменателе этого |

отношения. Поэтому в дальнейшем можно |

||||||||||||||||||||||||||||||

считать что |

C =1 . |

Из равенства (12.6) |

~ |

|

|

|

|

что |

||||||||||||||||||||||||

следует, что h(t) = s (t) = s(T −t) , |

|

|||||||||||||||||||||||||||||||

совпадает с определением согласованного фильтра.

Рассмотрим теперь свойства согласованного фильтра в частотной области. Обозначим через H ( f ) ↔ h(t) частотную характеристику фильтра.

Поскольку h(t) = s(T −t) , то

|

|

|

|

|

|

|

|

|

|

Замена |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

∞ |

∞ |

|

|

|

T −t = t |

|

∞ |

|

||||||||||||||||||||||

H ( f ) = ∫h(t)e− j 2πft dt = |

∫s(T −t)e− j 2πft dt = |

t = T −t1 |

= ∫s(t1 )e− j 2πf (T −t1 ) dt1 = |

|||||||||||||||||||||||||||

−∞ |

−∞ |

|

|

|

1 |

|

−∞ |

|

||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

dt = −dt1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

∞ |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

= e− j 2πfT ∫s(t1 )e j 2πft1 dt1 = e− j 2πfT S* ( f ) , |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

−∞ |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

где S( f ) - спектр сигнала. Спектр |

сигнальной |

составляющей |

на выходе |

|||||||||||||||||||||||||||

согласованного фильтра равен |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

Sh ( f ) = S( f )H ( f ) = S( f )e− j 2πfT S * ( f ) = e− j 2πfT |

|

S( f ) |

|

2 . |

|

|||||||||||||||||||||||||

|

|

|

||||||||||||||||||||||||||||

Тогда сама сигнальная составляющаяsh (t) ↔ Sh ( f ) равна |

|

|||||||||||||||||||||||||||||

|

|

|

|

|

∞ |

|

|

|

|

|

|

|

2 e j 2πft df , |

|

||||||||||||||||

|

|

|

sh (t) = ∫e− j 2πfT |

|

S( f ) |

|

|

|||||||||||||||||||||||

|

|

|

|

|||||||||||||||||||||||||||

|

|

|

|

|||||||||||||||||||||||||||

|

|

|

|

|

−∞ |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

а ее отсчет в момент t = T будет равен |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

sh (T ) = ∞∫e− j 2πfT |

|

S( f ) |

|

2 e j 2πfT df = ∞∫ |

|

S( f ) |

|

2 df = ∞∫s2 (t)dt = |

|

|

|

s |

|

|

|

2 = E . |

||||||||||||||

|

|

|

|

|

|

|

|

|||||||||||||||||||||||

|

|

|

|

|

|

|

|

|||||||||||||||||||||||

−∞ |

|

|

|

|

|

−∞ |

−∞ |

|

||||||||||||||||||||||

Здесь также использовано равенство Парсеваля. |

Отсюда следует, |

что как и |

||||||||||||||||||||||||||||

ранее, sh (T )2 = E 2 .

Шум на выходе согласованного фильтра окрашен и имеет спектральную плотность мощности

Nh ( f ) = (N0 / 2) H ( f ) 2 = (N0 / 2) S * ( f )e− j 2πfT 2 = (N0 / 2) S( f ) 2 .

Мощность шума на выходе фильтра (или дисперсия отсчета шума на выходе фильтра) равна, как и прежде,

∞ ∞ ∞

σh2 = ∫Nh ( f )df = (N0 / 2) ∫ S( f ) 2 df = (N0 / 2) ∫s2 (t)dt = (N0 / 2)

s

s

2 = (N0 / 2)E.

2 = (N0 / 2)E.

−∞ |

−∞ |

|

−∞ |

|

|

Следовательно получаем, что |

|

|

|

||

|

|

sh (T )2 |

= |

E |

, |

|

|

σh2 |

(N0 / 2) |

||

и это выражение совпадает с (12.7).

13. Вероятность ошибки при передаче двоичных сигналов в канале с аддитивным белым гауссовским шумом

Рассмотрим простой случай передачи двоичных сигналов. Вероятность ошибки определяется по формуле полной вероятности как

q−1

Pe = ∑Pe (i)Pi =Pe (0)P0 + Pe (1)P1 ,

i=0

где Pe (i) - условная вероятность ошибки при передаче i -го сигнала, Pi -

вероятность передачи i -го сигнала. Найдем сначала вероятность Pe (0) . Как следует из определения алгоритма приема по МП

Pe (0) = Pr[d 2 (r, s0 ) > d 2 (r,s1 ) | 0]= Pr[ |

|

r −s0 |

|

|

|

2 > |

|

|

|

r −s1 |

|

|

|

2 | 0] |

|

|

|

|

|

|

|

При передаче сигнала s0 (t) на выходе канала наблюдается r(t) = s0 (t) + n(t) , и

следовательно r = s0 +n . Тогда

Pe (0) = Pr[

n

n

2 >

2 >

s0 −s1 + n

s0 −s1 + n

2 ]= Pr[

2 ]= Pr[

n

n

2 −

2 −

s0 −s1 + n

s0 −s1 + n

2 > 0].

2 > 0].

Рассмотрим выражение

n

n

2 −

2 −

s0 −s1 + n

s0 −s1 + n

2 :

2 :

|

|

|

|

n |

|

|

|

2 − |

|

|

|

s0 −s1 + n |

|

|

|

2 = |

|

|

|

n |

|

|

|

2 − |

|

|

|

s0 −s1 |

|

|

|

2 − 2(s0 −s1 , n) − |

|

|

|

n |

|

|

|

2 = − |

|

|

|

s0 −s1 |

|

|

|

2 − 2(s0 −s1 , n) . |

||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

Таким образом, |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Pe (0) = Pr[ξ > ∆2 ], |

|

(13.1) |

|||||||||||||||||||||||||||

где ξ = −2(s0 −s1 ,n) , |

|

|

|

|

∆2 = d 2 (s0 ,s1 ) = |

|

|

|

s0 −s1 |

|

|

|

2 – квадрат |

расстояния между |

||||||||||||||||||||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|||||||||||||||||||||||||||||||||||||||||||||||||||

сигналами. Определим характеристики случайной величины ξ . Она равна |

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

D |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

ξ = −2(s0 −s1 ,n) = −2∑(s0 j − s1 j )n j , |

|

(13.2) |

|||||||||||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

j=1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

где s0 j , s1 j - координаты соответствующих сигнальных точек, |

|

n j - скалярные |

||||||||||||||||||||||||||||||||||||||||||||||||||||||||

произведения АБГШ |

|

|

|

|

и базисных функций. |

|

Величины n j |

это независимые |

||||||||||||||||||||||||||||||||||||||||||||||||||

одинаково распределенные гауссовские с.в. (см. свойства АБГШ) с параметрами n j = 0 , n2j = N0 / 2 . Найдем параметры величины ξ , определенной равенством

(13.2). Поскольку ξ представляет собой линейную комбинацию независимых

гауссовских с.в., то она тоже гауссовская. Далее, найдем математическое ожидание и дисперсию

|

|

|

|

|

D |

|

|

|

D |

|

|

|

|

|

|

|

ξ |

= − 2∑(s0 j − s1 j )n j = −2∑(s0 j − s1 j ) |

n j |

= 0 , |

|

|

|||||||

|

|

|

|

|

j=1 |

|

|

|

j=1 |

|

|

|||

|

D |

|

D |

|

|

|

|

D |

|

|

||||

D[ξ] = D − 2∑(s0 j − s1 j |

)n j = 4∑(s0 j − s1 j )2 D[n j ] = 2N0 ∑(s0 j − s1 j )2 =2N0 ∆2 . |

|||||||||||||

|

j=1 |

|

j=1 |

|

|

|

|

j=1 |

|

|

||||

Итак, |

вероятность Pe (0) вычисляется, как указано в (13.1), где ξ |

- |

||||||||||||

гауссовская с.в. с параметрами (0, 2N0 ∆2 ) . |

|

|

|

|

|

|

|

|||||||

Определим функцию |

|

|

|

|

|

|

|

|

|

|||||

|

|

|

|

|

|

Q(x) = ∞∫ |

1 |

|

e−z2 / 2 dz . |

(13.3) |

||||

|

|

|

|

|

|

|

x |

2π |

|

|

|

|

|

|

Легко |

видеть, |

что |

Q(x) = Pr[ζ > x] , где ζ гауссовская |

с.в. |

с |

|||||||||

параметрами (0,1). С использованием функции (13.3) можно найти вероятность превышения некоторого порога A гауссовской с.в. X общего вида с

параметрами (m,σ 2 ) , то есть

Pr[ X > A] = Q Aσ− m .

С использованием (13.1) и (13.3) можно записать, что

P (0) |

|

2 |

|

|

∆ |

|

= Q |

∆ |

|

= Q |

. |

||

e |

|

2 |

|

|

2N0 |

|

|

|

∆ 2N0 |

|

|

|

Аналогичное значение имеет и вероятность Pe (1) , поэтому

P |

|

∆ |

|

(13.4) |

= Q |

|

. |

||

e |

|

2N0 |

|

|

|

|

|

|

Как следует из выражения (13.4), вероятность ошибки при передаче двоичных сигналов по каналу с АБГШ зависит только от евклидова расстояния между сигналами (но не от их конкретного вида!) и от интенсивности шума.

Функция Q(x) , используемая в выражении (13.4), не выражается через элементарные функции и вычисляется численно. На практике она может быть найдена из таблиц. Чаще, однако, в руководствах по теории вероятностей

встречаются таблицы значений гауссовской функции распределения, определенной как

F(x) = ∫x |

1 |

e−z2 / 2 dz . |

−∞ |

2π |

|

Связь между ней и функцией Q(x) задается равенством Q(x) =1 − F(x) . Часто встречаются также таблицы так называемой функции ошибок и дополнительной функции ошибок, определенных следующим образом

2π ∫0x e−z2 dz

и |

|

|

erfc(x) = |

2 |

∫x∞ e−z 2 dz =1 −erf(x) , |

|

π |

|

соответственно. Связь функции |

Q(x) с erfc(x) задается равенством |

|

Q(x) = erfc(x /  2 )/ 2 . Можно указать также просто вычисляемые верхние и

2 )/ 2 . Можно указать также просто вычисляемые верхние и

нижние границы для Q(x) для положительных значений ее аргумента

1 |

− |

1 |

−x2 / 2 |

< Q(x) < |

1 |

e |

−x2 / 2 |

, |

(13.5) |

|

1 |

e |

|

2π x |

|

||||||

2π x |

|

x2 |

|

|

|

|

|

|

|

|

и наиболее простую верхнюю границу |

|

|

|

|

|

|

|

|||

|

|

Q(x) ≤ |

1 |

e−x2 / 2 . |

|

|

|

|

(13.6) |

|

|

|

2 |

|

|

|

|

||||

|

|

|

|

|

|

|

|

|

|

|

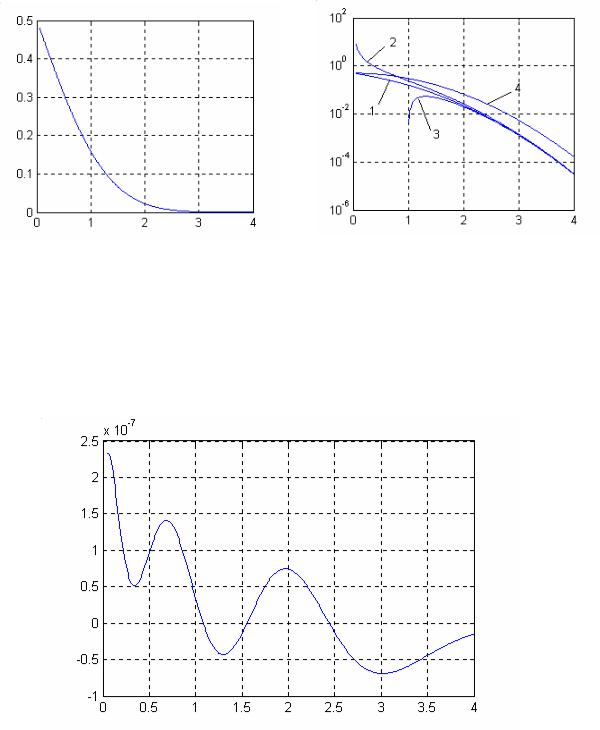

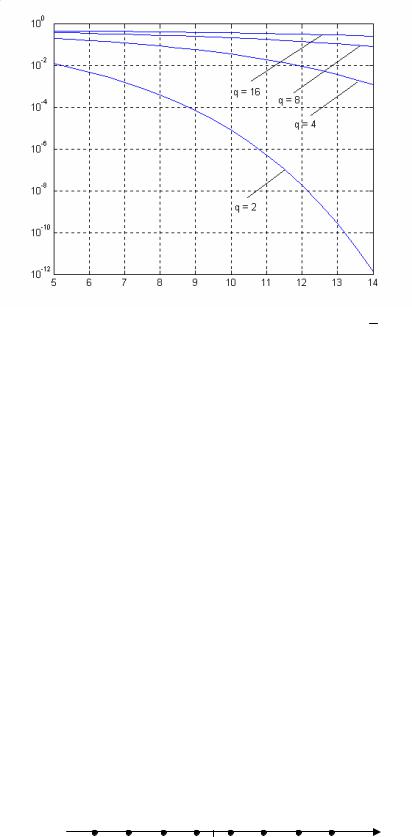

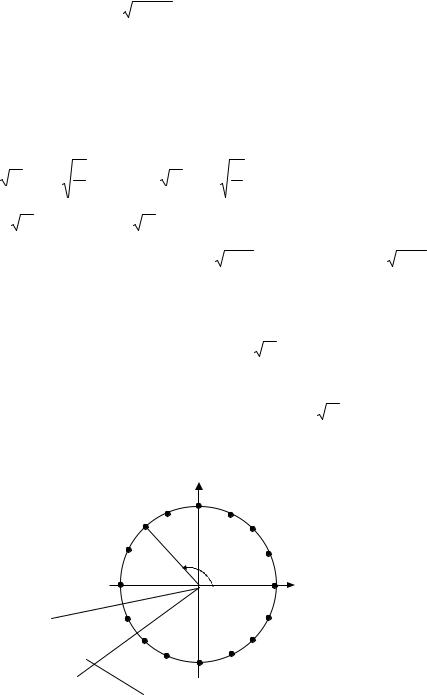

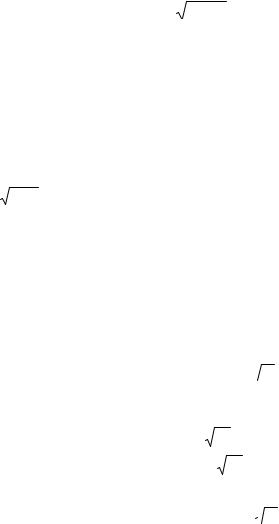

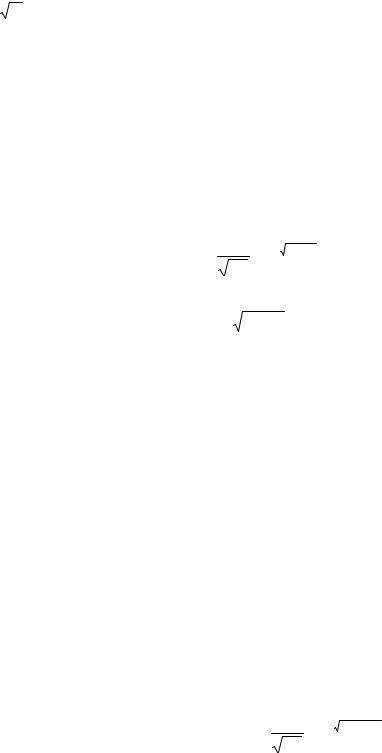

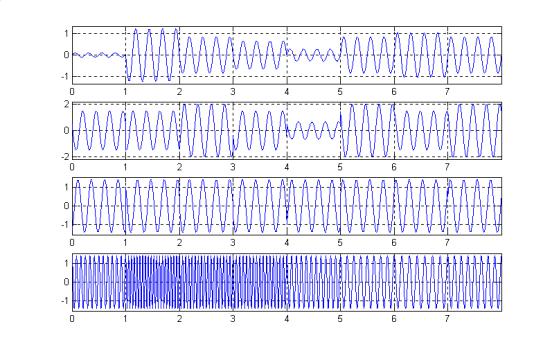

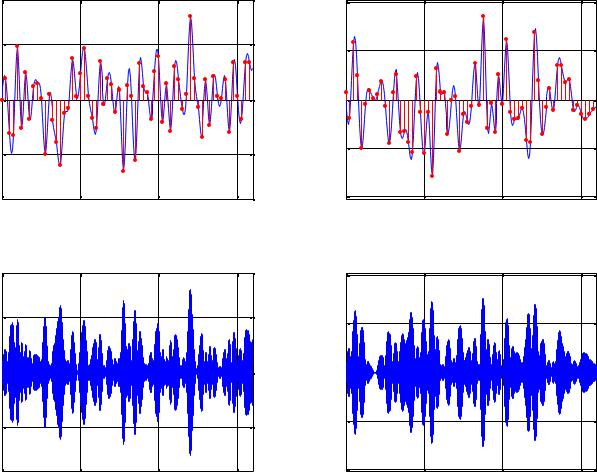

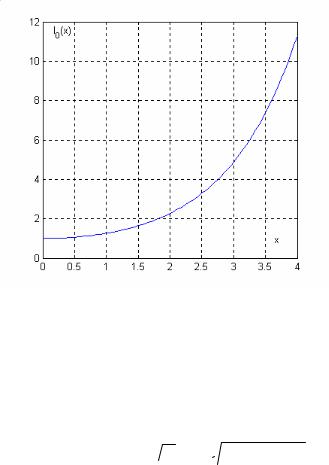

На рис.13.1а показан график функции Q(x) , а на рис.13.1б – графики этой функции, а также верхняя и нижняя границы (13.5) и простейшая верхняя граница (13.6) в полулогарифмическом масштабе.

|

Весьма точно значения Q(x) |

могут быть найдены с использованием |

|||||

приближенного выражения сравнительно удобного для программирования |

|||||||

|

|

|

5 |

|

1 |

i |

|

|

|

Q(x) ≈ f (x) |

∑ |

a |

, |

(13.7) |

|

|

|

|

|||||

|

|

|

i |

|

|

|

|

|

|

|

i=0 |

|

(1 + px) |

|

|

где |

f (x) = (1/ |

2π ) exp(−x2 / 2) , |

|

p = 0.2316419 , |

a = 0.3193815 , |

||

|

|

|

|

|

|

|

1 |

a2 |

= −0.3565638 , |

a3 =1.781478 , a4 = −1.821256 , a5 =1.330274 . Качество |

|||||

приближения иллюстрируется графиком рис.13.2, где показана разность между истинным значением Q(x) и приближением (13.7)

а |

б |

Рис.13.1 а) функция Q(x) , б) 1- функция Q(x) , 2,3 – верхняя и нижняя границы (13.5) , 4 – простая верхняя граница (13.6)

Рис.13.2 Ошибка приближения функции Q(x)

14. Вероятность ошибки для различных систем двоичных сигналов в канале с аддитивным белым гауссовским шумом

Ранее получено, что вероятность ошибки для двоичных сигналов может быть найдена как

& |

|

# |

, |

Pe ( Q |

|

! |

|

|

2N0 |

! |

|

% |

|

|

где - расстояние между сигналами, N0 / 2 - значение спектральной плотности мощности АБГШ. Рассмотрим три различных набора двоичных сигналов.

1. Противоположные сигналы. Пусть )1 (t) некоторая нормированная функция, заданная на интервале [0,T ] и определяющая форму сигнала,

)1

)1

( 1.

( 1.

Положим что s0 (t) (  E)1 (t) , s1 (t) (

E)1 (t) , s1 (t) (  E)1 (t) , где E энергия сигналов,

E)1 (t) , где E энергия сигналов,

T T

E ( + s02 (t)dt ( + s12 (t)dt .

0 0

Оба сигнала могут быть представлены с использованием всего одной базисной функции. Это значит, что противоположные сигналы образуют одномерное

сигнальное множество, s0 ( ( E ) , |

s1 ( ( |

E ) . Легко заметить, что решающие |

|||

области в данном случае имеют вид бесконечных полупрямых R0 ( [0, ,) , |

|||||

R1 ( (,,0) , см. рис.14.1 |

|

|

|

|

|

|

s1 |

|

|

s0 |

|

|

E |

|

|

|

|

|

0 |

E |

|||

Рис.14.1 Сигнальное множество (противоположные сигналы)

Очевидно, что расстояние между сигналами равно ( 2 E , тогда вероятность ошибки равна

E , тогда вероятность ошибки равна

|

& |

# |

(14.1) |

P(пр) ( Q |

2E ! . |

||

e |

|

! |

|

|

% |

N0 |

|

Величина E / N0 называется отношением сигнал/шум. В инженерной практике принято выражать это отношение в децибелах (дБ). Величина отношения, измеренная в дБ, определяется как

−E / N0 .дБ ( 10 log10 −E / N0 .,

и наоборот

E / N0 ( 10−E / N0 .дБ / 10 .

Перевод отношения в децибелы и обратно можно легко выполнять в уме, если запомнить несложные правила:

a) при увеличении отношения в два раза, соответствующая величина в децибелах увеличивается на 3 дБ (точнее на 3.01 дБ), так как 10 log10 2 ( 3.01 / 3 ;

б) при уменьшении отношения в два раза, соответствующая величина в

децибелах |

уменьшается |

на |

3 дБ |

(точнее |

на |

3.01 |

|

|

дБ) |

так |

как |

||||||||||||||

10 log10 (1/ 2) ( 3.01 / 3 ; |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Пример. Пусть E / N0 ( 5 . Требуется оценить −E / N0 .дБ . Легко видеть, |

|||||||||||||||||||||||||

что −E / N0 .дБ ( 7 дБ , действительно |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

10 log10 5 ( 10 log10 (10 / 2) ( 10 log10 10 10 log10 2 ( 10 3 ( 7 . □ |

|

|

|||||||||||||||||||||||

2. Ортогональные сигналы. Пусть )1 (t) и ) 2 (t) две ортонормированные |

|||||||||||||||||||||||||

функции, заданные на интервале [0,T ] , |

()1 ,) 2 ) ( 0 и |

|

|

|

)1 |

|

|

|

( |

|

|

|

) 2 |

|

|

|

( 1. Положим |

||||||||

|

|

|

|

|

|

|

|

||||||||||||||||||

что s0 (t) ( |

E)1 (t) , s1 (t) ( |

E) 2 (t) , где |

E - |

энергия сигналов. В этом случае |

|||||||||||||||||||||

+0T s0 (t)s1 (t)dt ( 0 , и сигналы имеют равную энергию |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||

|

|

|

T |

T |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

E ( + s02 (t)dt ( + s12 (t)dt . |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||

|

|

|

0 |

0 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Сигналы могут быть представлены с использованием двух базисных |

|||||||||||||||||||||||||

функций. Это значит, что ортогональные |

сигналы образуют |

двумерное |

|||||||||||||||||||||||

сигнальное |

множество, |

s0 ( ( |

E ,0) , |

s1 ( (0, |

E ) . |

|

Легко |

|

заметить, |

что |

|||||||||||||||

решающие области в данном случае имеют вид бесконечных полуплоскостей

R0 ( {r ( (r1 , r2 ) : r1 0 r2 } , R1 ( {r ( (r1 , r2 ) : r1 1 r2 } , см. рис.14.2 .

Очевидно, что расстояние между сигналами равно (  2E , тогда

2E , тогда

E  s1

s1

s0

0

E

E

Рис.14.2 Сигнальное множество (ортогональные сигналы)

вероятность ошибки равна

P |

(орт) |

& |

E |

# |

(14.2) |

|

( Q |

|

! . |

||

e |

|

N0 |

! |

|

|

|

|

% |

|

|

|

□

3. Сигналы с пассивной паузой. В этом случае s0 (t) ( 0 , s1 (t) 2 0 и

T

E ( +0 s12 (t)dt . Базис для представления этого набора сигналов состоит из одной функции)1 (t) ( s1 (t) /  E . Тогда s1 (t) (

E . Тогда s1 (t) (  E)1 (t) и

E)1 (t) и

)1

)1

( 1. Сигналы с пассивной паузой образуют одномерное сигнальное множество, s0 ( (0) , s1 ( (

( 1. Сигналы с пассивной паузой образуют одномерное сигнальное множество, s0 ( (0) , s1 ( ( E ) . Легко заметить, что решающие области в данном случае имеют вид бесконечных полупрямых R0 ( (,,

E ) . Легко заметить, что решающие области в данном случае имеют вид бесконечных полупрямых R0 ( (,,  E / 2) , R1 ( (

E / 2) , R1 ( ( E / 2, ,) , см. рис.14.3

E / 2, ,) , см. рис.14.3

s0 |

s1 |

0 |

E |

Рис.14.3 Сигнальное множество (сигналы с пассивной паузой)

Очевидно, что расстояние между сигналами равно (  E , тогда вероятность ошибки равна

E , тогда вероятность ошибки равна

|

& |

E |

# |

(14.3) |

P(пп) ( Q |

! . |

|||

e |

|

2N0 |

! |

|

|

% |

|

|

|

□

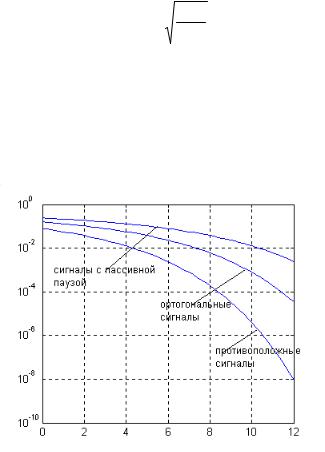

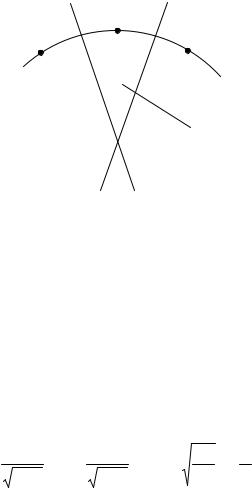

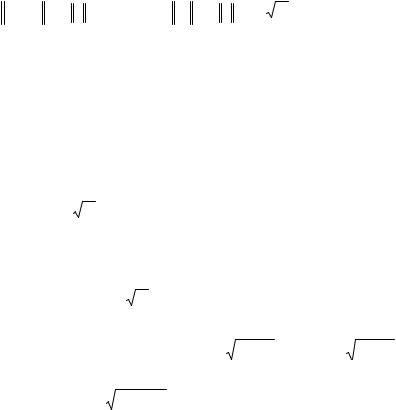

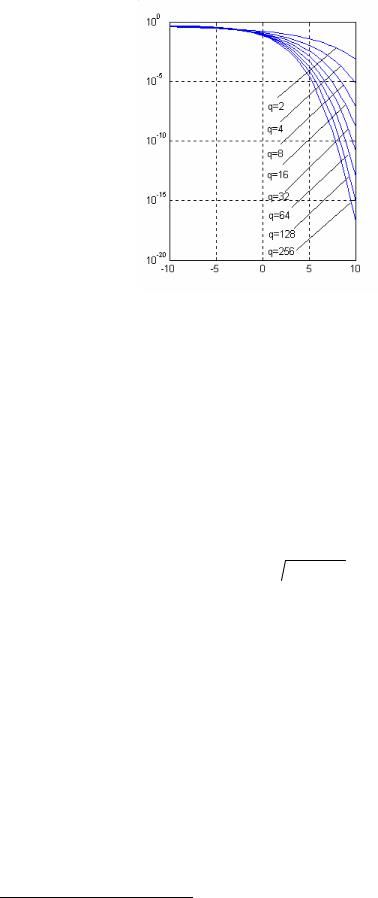

Pe

E / N0 , дБ

Рис.14.1 Вероятность ошибки для двоичных сигналов

Приведенные выражения для вероятности ошибки справедливы при любой форме сигналов (при сохранении противоположности или ортогональности). От формы сигналов зависят другие свойства сигналов, в частности, спектральные свойства.

Как видно из равенств (14.1)-(14.3) и графиков, представленных на рис.14.1, наименьшую вероятность ошибки обеспечивают противоположные сигналы. При использовании ортогональных сигналов для достижения той же вероятности ошибки требуется вдвое (или на 3дБ) большее отношение сигнал/шум, чем при использовании противоположных сигналов. Сигналы с пассивной паузой уступают ортогональным 3дБ, а противоположным - 6 дБ.

15. Дискретная амплитудная модуляция. Вероятность ошибки

Сигналы дискретной амплитудной модуляции (АМ) |

имеют |

вид |

si (t) = Aiϕ(t) , где ϕi (t) - некоторая нормированная функция, |

заданная |

на |

интервале [0,T ] и определяющая форму сигнала, Ai - амплитуда i -го сигнала, i = 0,1,...q −1. Определим амплитуду i -го сигнала как

|

|

A = |

E |

|

|

2i |

|

|

|

||

|

|

1 − |

. |

|

|

||||||

|

|

|

i |

|

|

|

q −1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

Тогда A0 = |

E , |

Aq−1 = − E , |

а |

все |

|

|

промежуточные |

значения |

амплитуды |

||

расположены |

с |

равномерным |

шагом |

|

|

в |

интервале [− |

E , E ] . |

Сигнальное |

||

множество АМ показано на рис 15.1. |

|

|

|

|

|

|

|

||||

|

|

sq−1 |

|

|

|

|

s1 |

s0 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

− |

E |

|

0 |

|

|

E |

|

|

|

Рис.15.1 Сигнальное множество АМ сигналов.

Минимальное расстояние между сигналами, как видно из рис.15.1, составляет

∆ = 2 E /(q −1) . Определим энергию каждого сигнала. Очевидно, что энергия i -го сигнала равна

E /(q −1) . Определим энергию каждого сигнала. Очевидно, что энергия i -го сигнала равна

Ei = Ai 2 = E 1 − q2−i1 2 ,

то есть энергия сигналов принимает различные значения. Величина E имеет смысл максимальной энергии. Как обычно будем полагать, что сигналы передаются равновероятно. Найдем значение средней энергии

|

|

q−1 |

|

E |

q−1 |

|

2i |

2 |

|

E |

q−1 |

|

4 |

q−1 |

|

4 |

|

q−1 |

|

||

E |

= |

∑ |

E P = |

1 |

− |

|

= |

|

∑ |

1 − |

∑ |

i + |

|

∑ |

i2 . |

||||||

|

|

|

|

|

|

2 |

|||||||||||||||

|

|

i i |

q |

∑ |

|

q −1 |

|

|

q |

|

|

(q −1) |

|

(q −1) |

|

||||||

|

|

i=0 |

|

i=0 |

|

|

|

i=0 |

|

i=0 |

|

|

i=0 |

|

|||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1 |

|

q−1 |

|

2i |

|

2 |

|

|

|

|

|

|

|

|

|

|

|

|

|||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

∑ |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||

Найдем |

значение |

|

выражения |

|

|

|

|

|

|

|

|

|

1 |

− |

|

|

. |

Используя |

|

тождества |

||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

q i=0 |

|

q −1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||

∑ik=0 i = k(k +1) / 2 и ∑ik=0 i2 |

= k(k +1)(2k +1) / 6 , получим |

|

|

|

|

|

|

|

|

|

|

|

||||||||||||||||||||||||||||||||

|

|

1 |

|

q−1 |

|

2i |

|

|

2 |

1 |

q−1 |

|

|

|

|

4 |

|

q−1 |

|

|

4 |

|

|

|

q−1 |

|

|

|

|

|

|

|

||||||||||||

|

|

|

∑ |

1 |

− |

|

|

= |

|

∑ |

1 − |

|

∑ |

i + |

|

|

|

∑ |

i |

2 = |

|

|

|

|

||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

2 |

|

|

|

|

|

||||||||||||||||||||||||

|

|

|

|

|

|

|

q −1 |

|

|

q |

|

|

|

|

|

(q −1) |

|

|

(q −1) |

|

|

|

|

|

|

|

|

|||||||||||||||||

|

|

q i=0 |

|

|

|

|

i=0 |

|

|

|

|

i=0 |

|

|

|

|

i=0 |

|

|

|

|

|

|

|

|

|||||||||||||||||||

|

|

1 |

|

|

4 |

|

|

q(q −1) |

|

|

|

|

|

4 |

|

|

|

|

(q |

−1)q(2q −1) |

|

|

1 q +1 |

|

|

|

|

|||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||||||||||||||||

|

= |

|

|

|

q − |

|

|

|

|

|

|

|

|

|

+ |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

= |

|

|

|

|

. |

|

|

|

|||

|

|

q |

(q −1) |

|

2 |

|

|

|

(q |

−1) |

2 |

|

|

|

6 |

|

|

3 q −1 |

|

|

|

|||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||||||||||||||

Поэтому |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

= |

|

E q +1 |

. |

|

|

|

|

|

|

|

|

|

|

|

|

|

(15.1) |

|||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

E |

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3 q −1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||

Решающие области |

для |

|

|

i =1,2,..., q − 2 |

представляют собой |

отрезки |

||||||||||||||||||||||||||||||||||||||

длины |

∆ с |

центрами |

|

в |

|

|

сигнальных |

точках |

s1 ,s2 ,...,sq−2 , |

то |

есть |

|||||||||||||||||||||||||||||||||

Ri = [ Ai |

− ∆/ 2, Ai + ∆/ 2) . |

Решающие |

области для |

крайних |

|

|

точек |

s0 |

и |

sq−1 |

||||||||||||||||||||||||||||||||||

представляют |

собой бесконечные |

|

|

|

|

полупрямые |

|

R0 =[ A0 − ∆/ 2, ∞) |

и |

|||||||||||||||||||||||||||||||||||

Rq−1 = (−∞, Aq−1 + ∆/ 2) . |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||

Сигнал на выходе канала имеет вид |

r(t) = s(t) + n(t) , |

|

где s(t) {si (t)} , |

|||||||||||||||||||||||||||||||||||||||||

n(t) – АБГШ со спектральной плотностью мощности |

N0 / 2 . В силу того, что |

|||||||||||||||||||||||||||||||||||||||||||

сигнальное множество АМ сигналов одномерно, имеем следующее

конечномерное представление r = A + n , где |

A {Ai }, |

n – г.с.в с параметрами |

|||||||||

|

|

|

|

|

|

|

|

|

|||

|

|

= 0 , |

|

n2 |

= N0 / 2 . |

Найдем вероятность |

ошибки. |

По формуле полной |

|||

|

n |

||||||||||

вероятности имеем |

|

|

|

|

|

|

|||||

|

|

|

|

|

|

q−1 |

|

1 |

q−1 |

|

|

|

|

|

|

|

|

Pe = ∑Pe (i)Pi |

= |

∑Pe (i) , |

(15.2) |

||

|

|

|

|

|

|

|

|||||

|

|

|

|

|

|

i=0 |

|

q i=0 |

|

|

|

где Pe (i) - вероятность при передаче i -го сигнала, |

Pi |

- вероятность передачи |

|||||||||

i -го |

сигнала, Pi |

=1/ q . Рассмотрим |

сначала |

вычисление Pe (i) при |

|||||||

i =1,2,..., q − 2 .

Pe (i) = Pr[r Ri |

| i] = Pr[Ai |

+ n [ Ai − ∆/ 2, Ai |

+ ∆/ 2)]= Pr[n [−∆/ 2,+∆ |

|||||||||||||||||

−∆ / 2 |

1 |

|

2 |

/ |

N0 |

|

∞ |

|

1 |

|

|

|

2 |

/ N0 |

|

|

∆ |

|

||

= ∫ |

e |

−x |

dx + |

∫ |

|

|

e |

−x |

|

dx = |

|

|

||||||||

|

|

|

|

|

πN0 |

|

|

|

2Q |

2N0 |

. |

|||||||||

−∞ |

πN0 |

|

|

|

|

∆/ 2 |

|

|

|

|

|

|

|

|

||||||

Найдем оставшиеся вероятности Pe (0) и Pe (q −1) |

|

|

|

|

||||||||||||||||

Pe (0) = Pr[r R0 |

| 0] = Pr[A0 |

+ n [ A0 − ∆/ 2, ∞)]= Pr[n [−∆/ 2, ∞)] |

||||||||||||||||||

|

|

−∆ / 2 |

|

1 |

|

|

2 |

/ N0 |

|

|

|

|

|

|

∆ |

|

|

|

||

|

|

= ∫ |

|

|

e |

−x |

dx |

|

|

|

|

|

|

|

||||||

|

|

|

|

πN0 |

|

|

|

= Q |

2N0 |

. |

|

|

||||||||

|

|

|

−∞ |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

Аналогично можно показать, что |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||

|

|

|

|

|

|

|

|

|

|

∆ |

|

|

|

|

|

|

|

|

|

|

|

|

P (q −1) = Q |

|

|

|

|

. |

|

|

|

|

|

|

|||||||

|

|

|

e |

|

|

|

|

|

|

2N0 |

|

|

|

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

/ 2)]=

(15.3)

=

(15.4)

(15.5)

Подстановка (15.3)-(15.5) в (15.2) с учетом того, что ∆ = 2 E /(q −1) дает окончательное выражение

E /(q −1) дает окончательное выражение

P |

= |

2q − 2 |

|

2E |

1 |

|

, |

(15.6) |

|

Q |

|

|

|

||||

e |

q |

|

N0 |

q −1 |

|

|

|

|

|

|

|

|

|

|

|||

определяющее зависимость вероятности ошибки от максимального отношения сигнал/шум E / N0 . С использованием равенства (15.1) получим выражение,

определяющее зависимость вероятности ошибки от среднего значения отношения сигнал/шум E / N0

P |

= |

|

|

6E |

1 |

|

(15.7) |

|

2q − 2 Q |

. |

|||||||

e |

|

q |

|

N |

|

q2 −1 |

|

|

|

|

|

|

|

0 |

|

|

|

При q = 2 равенства (15.6) и |

(15.7) обращаются в |

Pe = Q( 2E / N0 ) - |

||||||

вероятность ошибки для двоичных противоположных сигналов, при этом также

E = E .

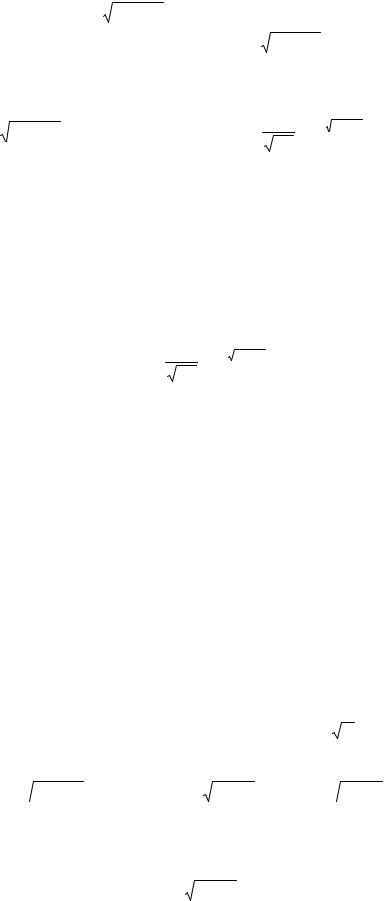

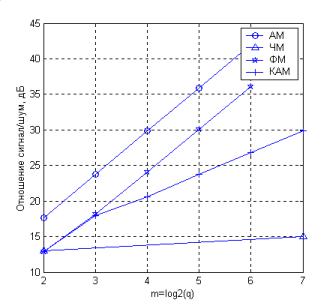

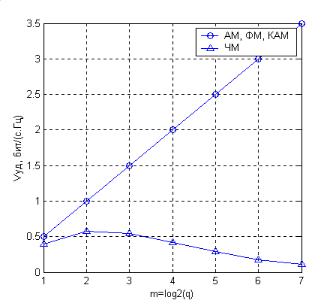

Графики, показанные на рис. 15.2, дают представление о зависимости вероятности ошибки от среднего значения отношения сигнал/шум. Важно отметить, что вероятность ошибки резко возрастает с увеличением объема сигнального алфавита.

Pe

E / N0 , дБ

Рис.15.2 Вероятность ошибки для АМ сигналов

Рассмотрим вывод выражения для вероятности ошибки на бит для сигналов АМ. Среднее значения отношения сигнал шум/шум на бит равно

|

|

|

|

|

|

1 |

|

|

|

|

|

|

E |

|

E |

|

|||||||

|

|

|

|

|

= |

|

|

|

|

|

. |

|

|

|

|

|

|

|

|

||||

|

N0 |

|

|

log2 q N0 |

|

||||||

|

bit |

|

|

||||||||

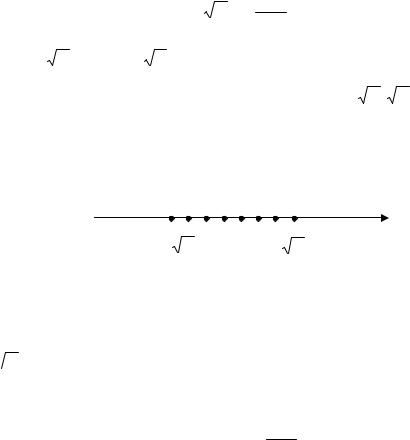

Вероятность ошибки на бит зависит от отображения сообщений (номеров сигналов) в сигнальные точки. Предпочтительным будет такое отображение, при котором близко расположенные сигнальные точки соответствуют сообщениям, различающимся в малом числе двоичных разрядов. Такое отображение для сигналов АМ достигается с использованием кода Грея. В этом случае блоки двоичных данных, соответствующие соседним сигнальным точкам, будут отличаться только в одной позиции (см. пример для АМ-8 на Рис.15.3).

100 101 111 110 010 011 001 000

0

Рис.15.3 Сигнальное множество АМ –8 сигналов (отображение в соответствии с кодом Грея)

Поскольку ошибочное решение относительно переданного сигнала наиболее вероятно в пользу соседних сигналов, то оно будет приводить к ошибке только в одном бите. Это значит, что в большинстве случаев доля ошибочных двоичных разрядов при ошибочном решении равна 1/ log 2 q =1/ m . Отсюда следует, вероятность ошибки на бит как функции от отношения сигнал/шум на бит задается выражением

|

|

1 |

|

|

|

1 |

2q −2 |

|

|

|

E |

|

log2 q |

|

|

|

||

P |

≈ |

|

P |

= |

Q |

|

|

|

|

. |

(15.8) |

|||||||

|

|

|

|

|

6 |

|

|

|

2 |

|

|

|||||||

b |

|

log2 |

q |

e |

|

log2 q |

q |

|

|

N0 |

q |

−1 |

|

|

||||

|

|

|

|

|

|

|

bit |

|

|

|

|

|||||||

16. Квадратурная амплитудная модуляция. Вероятность ошибки

Сигналы квадратурной амплитудной модуляции (КАМ) (quadrature amplitude modulation, QAM) имеют вид si (t) = si1ϕ1 (t) + si2ϕ2 (t) , где ϕ1 (t), ϕ2 (t) - две ортонормированные функции, заданные на интервале [0,T ] и

определяющие форму сигнала, i = 0,1,..., q −1. Из определения сигналов КАМ следует, что D = 2 . Величины si1 , si2 для сигналов КАМ принимают дискретные значения равномерно расположенные в некотором конечном интервале. Они могут рассматриваться как амплитудные множители при функциях ϕ1 (t) и ϕ2 (t) , поэтому сигнал КАМ представляет собой сумму двух ортогональных АМ сигналов si1ϕ1 (t) и si2ϕ2 (t) .

Как обычно будем считать, что q = 2m , где m - целое; число m может

рассматриваться как число бит переносимых сигналом (при отсутствии

кодирования). Положим для начала, что m = 2k , k - целое. Тогда |

q = 2k |

тоже |

||||||||||||||||

целое. Поставим в соответствие номеру сигнала i , |

i = 0,1,..., q −1, пару целых i1 |

|||||||||||||||||

и i2 , i1 ,i2 = 0,1,..., q −1, по правилу i = i1 |

q + i2 . Иначе говоря, i1 , |

i2 это цифры |

||||||||||||||||

в |

|

|

-ичном представлении числа i . Положим, что |

|

|

|

|

|

|

|

||||||||

q |

|

|

|

|

|

|

|

|||||||||||

|

|

|

|

|

|

2i |

|

|

|

2i |

2 |

|

|

|

|

|||

|

|

|

|

|

|

1 |

|

|

|

|

|

|

|

|

||||

|

|

|

|

|

si1 = A 1 − |

q −1 |

, |

si2 = A 1 − |

q −1 |

, |

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||

где A - максимальное абсолютное значение величин si1 |

и si2 . Очевидно, что |

|||||||||||||||||

значения величин si1 и si2 расположены с |

равномерным |

шагом |

в |

|||||||||||||||

интервале[−A, A] . Сигнальное множество КАМ показано на рис 16.1 |

|

|||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

а |

б |

в |

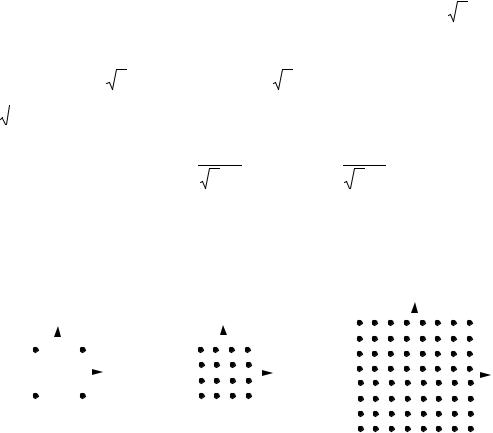

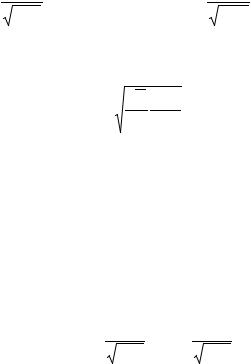

Рис.16.1 Сигнальное множество КАМ а) q = 4 , б) q =16 , в) q = 64

При q = 2m , где m = 2k −1, сигнальное множество строится путем

“прореживания ” сигнального множества для q = 22k . Примеры приведены на рис.16.2 – множество для КАМ8 построено из множества КАМ16, а множество для КАМ32 из множества для КАМ64 путем выбрасывания половины точек.

а |

б |

Рис.16.2 Сигнальное множество КАМ а) q = 8 , б) q = 32

Минимальное расстояние между сигналами, как видно из рис.16.1, составляет

|

|

|

|

∆ = 2A /( |

q −1) . |

|

|

|

|

|

(16.1) |

|||

Определим энергию каждого сигнала. Очевидно, что энергия i -го |

||||||||||||||

сигнала равна |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

E |

|

= s2 |

+ s2 |

|

− |

2i |

|

2 |

|

− |

2i |

|

|

2 |

i |

= A2 1 |

1 |

|

+ A2 |

1 |

|

2 |

|

, |

|||||

|

i1 |

i2 |

|

|

q −1 |

|

|

|

|

q −1 |

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|||

то есть энергия сигналов принимает различные значения. Как обычно будем полагать, что сигналы передаются равновероятно. Найдем значение средней энергии

|

|

|

|

|

|

|

|

|

1 q−1 |

|

A2 |

q −1 q −1 |

|

|

|

2i |

|

2 |

|

|

|

2i |

2 |

|

|

2 |

|

|

|

|

||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|