- •ВВЕДЕНИЕ

- •1. ПРИМЕРЫ И КЛАССИФИКАЦИЯ ЗАДАЧ ПРИНЯТИЯ РЕШЕНИЙ. ОБЗОР МЕТОДОВ

- •2. ОСНОВНЫЕ СВЕДЕНИЯ ИЗ ТЕОРИИ ЭКСТРЕМАЛЬНЫХ ЗАДАЧ

- •2.1. Основные понятия

- •2.2. Порядок решения экстремальных задач

- •3. ДИНАМИЧЕСКИЕ ЗАДАЧИ ПРИНЯТИЯ РЕШЕНИЙ

- •3.1. Постановка задачи оптимального управления

- •3.2. Функционал, его свойства, необходимые и достаточные условия достижения экстремума

- •3.3. Вариационные задачи на безусловный экстремум

- •3.4. Вариационные задачи на условный экстремум

- •3.5. Каноническая форма уравнений Эйлера. Принцип максимума

- •3.6. Практические примеры применения принципа максимума

- •3.6.1. Синтез программы управления мягкой посадкой космического летательного аппарата

- •3.6.2. Синтез системы стабилизации, оптимальной по быстродействию

- •3.6.3. Расчетный пример

- •4. МАТЕМАТИЧЕСКОЕ ПРОГРАММИРОВАНИЕ

- •4.1. Линейное программирование: постановка задачи, основные понятия, графическая интерпретация

- •4.2. Симплекс-метод

- •4.2.1. Алгебраический вариант

- •4.2.2. Табличный вариант

- •4.3. Решение задач дискретного линейного программирования

- •4.4. Двойственная задача линейного программирования

- •4.5. Нелинейное программирование

- •4.5.1. Обобщенный метод множителей Лагранжа, условия Куна-Таккера

- •4.5.2. Численный метод зондирования пространства параметров

- •4.5.3. Методы безусловной оптимизации

- •4.5.4. Методы безусловной оптимизации первого и второго порядка

- •4.5.5. Прямые методы условной оптимизации

- •4.5.6. Непрямые методы условной оптимизации

- •4.5.7. Применение симплекс-метода для решения целочисленных задач нелинейного программирования

- •5. СТРАТЕГИЧЕСКИЕ МАТРИЧНЫЕ ИГРЫ

- •5.1. Основные термины и допущения. Формализация задачи. Принципы поиска решения

- •5.2. Общие методы решения стратегических матричных игр

- •5.2.2. Способы упрощения стратегических матричных игр

- •5.2.3. Решение стратегических матричных игр методом линейного программирования

- •5.2.4. Итерационный алгоритм Брауна-Робинсон

- •5.3. Примеры решения стратегических матричных игр

- •6. СТАТИСТИЧЕСКИЕ МАТРИЧНЫЕ ИГРЫ

- •Библиографический список

- •ОГЛАВЛЕНИЕ

На основе полученного решения задачи линейного программирования (табл. 46) получим решение игры, приведенной в табл. 42: V =1/ q = 5 (здесь, в отличие от (70), решалась задача обеспе-

чения максимума целевой функции); |

q* = u V =1/ 20 5 = 0,25 , |

|||||||

|

|

|

|

|

1 |

1 |

|

|

q* = u V =1/10 5 = 0,5 , |

q* = u V =1/ 20 5 = 0,25 |

, p* = u V = |

||||||

2 |

2 |

|

3 |

3 |

|

|

1 |

4 |

= 1/20 5 = 0,25 , p* = u V =1/10 5 = 0,5 , |

p* |

= u V =1/ 20 5 = 0,25 . |

||||||

|

2 |

5 |

|

|

3 |

6 |

|

|

Остается внести поправку в значение цены игры и записать решение исходной игровой задачи: V=5–5=0, P*=(0,25; 0,5; 0,25), Q*=(0,25; 0,5; 0,25).

5.2.4. Итерационный алгоритм Брауна-Робинсон

Приближенный численный метод решения игр основан на использовании итерационного алгоритма Брауна-Робинсон. Данный алгоритм предусматривает моделирование многократного повторения партий игры с выбором каждой из сторон для очередной партии чистой стратегии, обеспечивающей ей наилучший результат в условиях применения противоположной стороной наблюдаемой смешанной стратегии. Наблюдаемая, или опытная, смешанная стратегия рассчитывается по результатам проведенных партий игры. Установлено, что при увеличении количества смоделированных партий опытные стратегии сторон стремятся к оптимальным, а средний выигрыш стороны А – к цене игры.

Проследим работу алгоритма на основе примера 41. Матрица игры представлена в табл. 42.

Предположим, что для первой партии игры сторона А выбрала максиминную стратегию А1, сторона В – одну из минимаксных стратегий В2. В результате этой партии выигрыш стороны А составил «–3» единицы. Опытная стратегия стороны А описывается вектором P=(1; 0; 0), стороны В – вектором Q=(0; 1; 0).

Для второй партии игры сторона В выбирает чистую стратегию в условиях применения стороной А чистой стратегии А1. Очевидно, она придет к выводу о целесообразности сохранения стратегии В2. В свою очередь сторона А для второй партии выбирает чистую стратегию в условиях применения стороной В чистой стратегии В2. В этом случае наибольший выигрыш она сможет получить, перейдя к стратегии А2. Итак, сочетание стратегий сторон во второй партии игры А2В2, выигрыш стороны А во второй партии составит

146

4 единицы. Суммарный накопленный выигрыш стороны А по результатам двух партий игры равен единице, средний выигрыш за две партии составил 0,5.

После двух партий опытная стратегия стороны А описывается вектором P=(0,5; 0,5; 0), стороны В – вектором Q=(0; 1; 0).

Для третьей партии игры сторона В выбирает чистую стратегию в условиях применения стороной А опытной смешанной стратегии. Поэтому прогнозируемый результат для каждой из возможных чистых стратегий она должна рассчитывать усреднением соответствующего столбца матрицы игры с учетом опытных частот применения стороной А ее чистых стратегий – элементов полученного по предшествующим партиям вектора P. Наименьший ожидаемый проигрыш соответствует стратегиям В1 и В3. Примем для стороны В правило выбора в таких случаях стратегии с наименьшим номером.

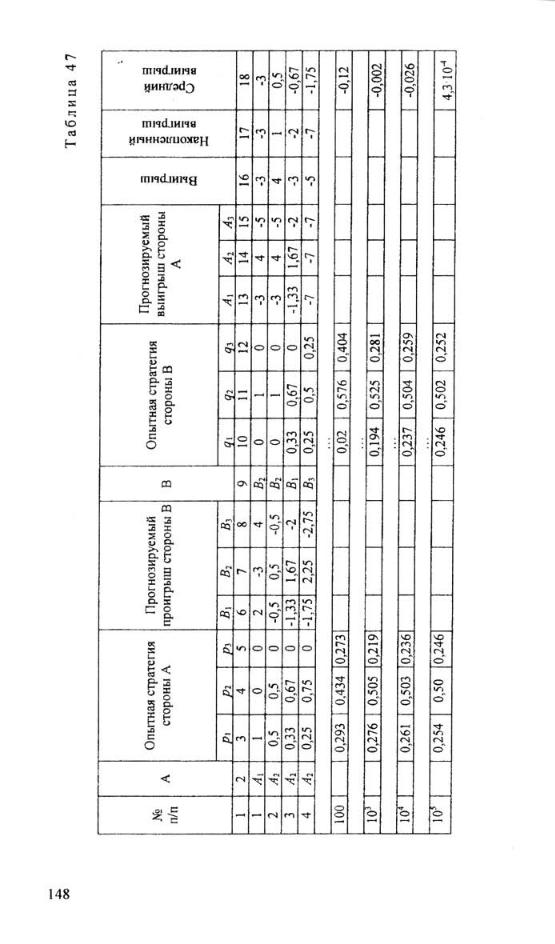

Результаты работы алгоритма на рассмотренных и последующих шагах подробно представлены в табл. 47.

В первом столбце таблицы приводится номер очередной партии, итог и накопленные результаты которой представлены в соответствующей строке. В столбцах 2 и 9 – чистые стратегии, примененные сторонами в очередной партии, в столбцах 3...5 – опытная смешанная стратегия стороны А после очередной партии, в столбцах 4...6 – ожидаемые проигрыши стороны В при различных ее чистых стратегиях в условиях применения стороной А такой опытной стратегии, в столбцах 10...12 – опытная стратегия стороны В, в столбцах 13...15 – ожидаемые выигрыши стороны А при различных ее чистых стратегиях в условиях применения стороной В текущей опытной стратегии, в столбце 16 – выигрыш стороны А, соответствующий сочетанию чистых стратегий из столбцов 2 и 9, в столбце 17 – суммарный (накопленный) выигрыш стороны А с учетом рассматриваемой партии, в столбце 18 – средний выигрыш стороны А в проведенных партиях игры (отношение накопленного выигрыша к номеру строки).

Представленные в табл. 47 результаты в сопоставлении с результатами решения рассматриваемого примера методом линейного программирования подтверждают возможность получения решения игры итерационным методом, причем точность результата, очевидно, определяется количеством смоделированных партий.

147