neuro_lab1

.pdf

Отчет по лабораторной работе № 1

по дисциплине «Нейрокомпьютеры и их применение»

на тему: «Изучение основных понятий теории ИНС и приемов работы с пакетом Statistica Neural Networks»

Цель работы: освоение приемов работы с программным пакетом Statistica Neural Networks и изучение основных понятий теории ИНС на примере простых задач распознавания логических функций (И, ИЛИ, исключающее ИЛИ).

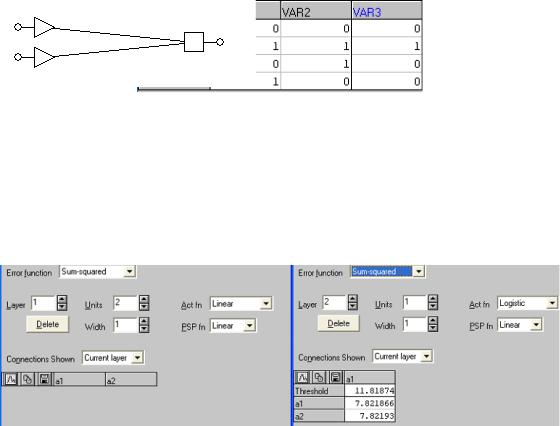

1. Зададим исходные данные для решения задачи распознавания логической функции AND:

Рис. 1 – Таблица истинности AND

Построим нейросеть для решения задачи:

Рис. 2 – Нейросеть, предназначенная для распознавания AND

Характеристики нейросети:

−Тип: многослойный перцептрон

−Число слоев: 2

−Число входов: 2

−Число выходов: 1

−Steps: 1

−Lookahead: 0

−Функция преобразования нейронов: minimax

1

−Функция активации нейронов первого слоя: linear

−Функция активации нейронов второго слоя: logistic

−Функция ошибки: sum-squared

Обучим нейросеть методом обратного распространения ошибки. Параметры обучения:

−Число эпох: 1500

−Скорость обучения: от 0,9 до 0,7

−Momentum: 0,8

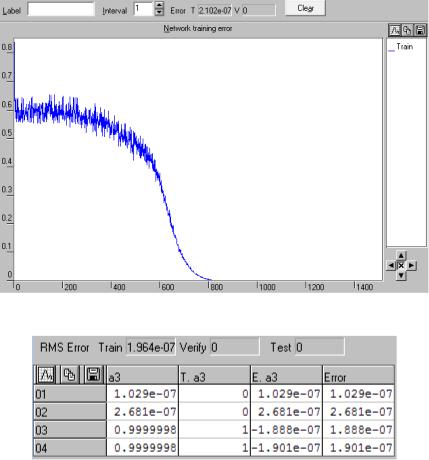

Рис. 3 – График ошибки обучения нейросети

Рис. 4 – Таблица с предсказаниями нейросети и действительными классами

Вывод: из рис. 3 видно, что в процессе обучения нейросети в течение 1500 эпох значение ошибки обучения постепенно убывает, на последней эпохе достаточно мало и составляет 0,0196. Из рис. 4 видно, что значения, предсказанные нейросетью, отличаются от действительных менее, чем на 5 %. Следовательно, данную нейросеть можно использовать для задачи распознавания логической функции AND.

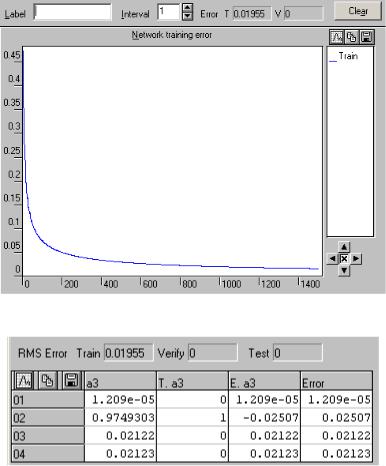

2. Зададим исходные данные для решения задачи распознавания логической функции OR:

2

Рис. 5 – Таблица истинности OR

а) Используем нейросеть из двух слоев для решения задачи:

Рис. 6 - Вид нейросети, предназначенной для распознавания OR

Характеристики нейросети:

−Тип: многослойный перцептрон

−Число слоев: 2

−Число входов: 2

−Число выходов: 1

−Steps: 1

−Lookahead: 0

−Функция преобразования нейронов: minimax

−Функция активации нейронов первого слоя: linear

−Функция активации нейронов второго слоя: logistic

−Функция ошибки: sum-squared

Обучим нейросеть методом обратного распространения ошибки. Параметры обучения:

−Число эпох: 1000

−Скорость обучения: от 0,7 до 0,5

−Momentum: 0,8

3

Рис. 7 – График ошибки обучения нейросети

Рис. 8 - Таблица с предсказаниями нейросети и действительными классами

Вывод: из рис. 7 видно, что в процессе обучения нейросети в течение 1000 эпох значение ошибки обучения постепенно убывает, на последней эпохе достаточно мало и составляет 0,0203. Из рис. 8 видно, что значения, предсказанные нейросетью, отличаются от действительных менее, чем на 5 %. Следовательно, данную нейросеть можно использовать для задачи распознавания логической функции OR.

Б) Используем нейросеть с характеристиками, аналогичными предыдущей нейросети, но с функцией активации нейронов второго слоя step (пороговая) для решения задачи распознавания

OR.

Обучим нейросеть методом обратного распространения ошибки. Параметры обучения:

−Число эпох: 3

−Скорость обучения: от 0,8 до 0,1

−Momentum: 0,3

4

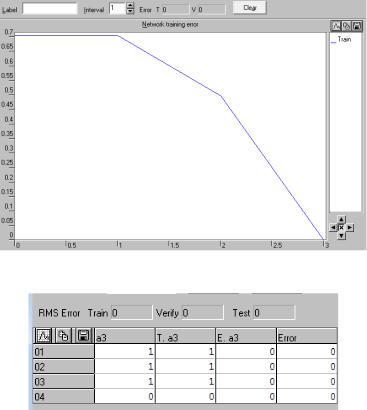

Рис. 9 – График ошибки обучения нейросети

Рис. 10 - Таблица с предсказаниями нейросети и действительными классами

Вывод: из рис. 9 видно, что в процессе обучения нейросети значение ошибки обучения убывает и становится равным нулю на 3 эпохе. Из рис. 10 видно, что значения, предсказанные нейросетью, не отличаются от действительных. Следовательно, данную нейросеть можно использовать для задачи распознавания логической функции OR. Полученная нейросеть лучше варианта а), так как ее обучение занимает меньше времени и приводит к безошибочным результатам предсказания.

в ) Используем нейросеть с характеристиками, аналогичными предыдущей нейросети, но с функцией активации нейронов второго слоя linear для решения задачи распознавания OR.

Обучим нейросеть методом обратного распространения ошибки. Параметры обучения:

−Число эпох: 1400

−Скорость обучения: от 0,85 до 0,01

−Momentum: 0,3

5

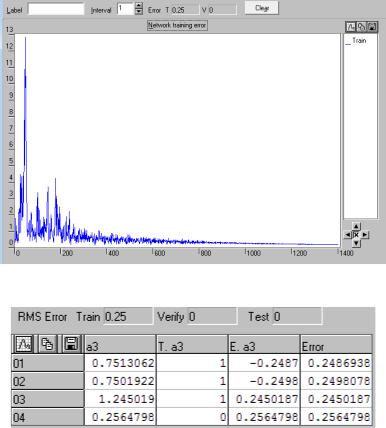

Рис. 11 – График ошибки обучения нейросети

Рис. 12 - Таблица с предсказаниями нейросети и действительными классами

Вывод: из рис. 11 видно, что в процессе обучения нейросети в течение 1400 эпох значение ошибки обучения постепенно убывает, на последней эпохе составляет 0,25. Из рис. 12 видно, что значения, предсказанные нейросетью, отличаются от действительных примерно на 25 %. Следовательно, данную нейросеть не следует использовать для задачи распознавания логической функции OR.

6

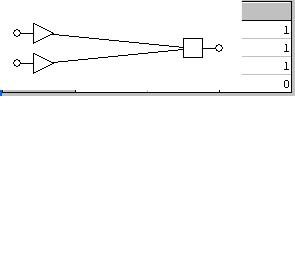

3. Зададим исходные данные для решения задачи распознавания логической функции XOR:

Рис. 13 – Таблица истинности XOR

а)

Рис. 14 - Вид нейросети, предназначенной для распознавания XOR

Характеристики нейросети:

−Тип: многослойный перцептрон

−Число слоев: 2

−Число входов: 2

−Число выходов: 1

−Steps: 1

−Lookahead: 0

−Функция преобразования нейронов: minimax

−Функция активации нейронов первого слоя: linear

−Функция активации нейронов второго слоя: logistic

−Функция ошибки: sum-squared

Обучим нейросеть методом обратного распространения ошибки. Параметры обучения:

−Число эпох: 700

−Скорость обучения: 0,05

−Momentum: 0,3

7

Рис. 15 – График ошибки обучения нейросети

Рис. 16 - Таблица с предсказаниями нейросети и действительными классами

Вывод: из рис. 15 видно, что в процессе обучения нейросети в течение 700 эпох значение ошибки обучения практически не меняется, на последней эпохе составляет 0,502. Из рис. 16 видно, что значения, предсказанные нейросетью, отличаются от действительных примерно на 50 %. Следовательно, данную нейросеть нельзя использовать для задачи распознавания логической функции XOR.

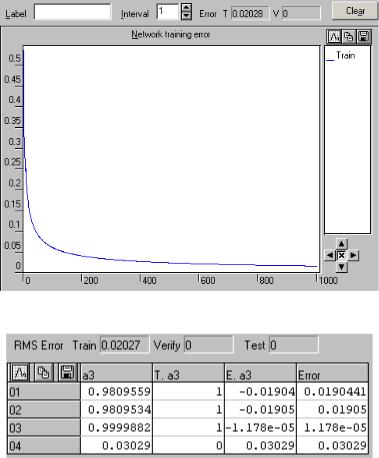

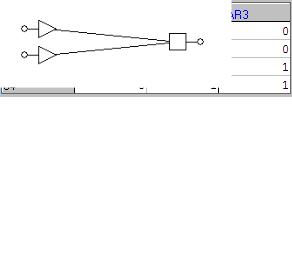

б) В нейросеть из пункта а) добавим внутренний слой из двух нейронов.

Рис. 17 - Вид нейросети, предназначенной для распознавания XOR

Характеристики нейросети:

−Тип: многослойный перцептрон

−Число слоев: 3

−Число входов: 2

−Число нейронов внутреннего слоя: 2

−Число выходов: 1

−Steps: 1

8

−Lookahead: 0

−Функция преобразования нейронов: minimax

−Функция активации нейронов первого слоя: linear

−Функция активации нейронов внутреннего слоя: logistic

−Функция активации нейронов выходного слоя: logistic

−Функция ошибки: sum-squared

Обучим нейросеть методом обратного распространения ошибки. Параметры обучения:

−Число эпох: 1000

−Скорость обучения: от 0,8 до 0,1

−Momentum: 0,3

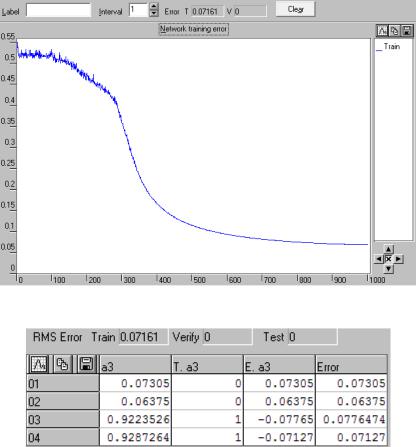

Рис. 18 – График ошибки обучения нейросети

Рис. 19 - Таблица с предсказаниями нейросети и действительными классами

Вывод: из рис. 18 видно, что в процессе обучения нейросети в течение 1000 эпох значение ошибки обучения постепенно убывает, на последней эпохе составляет 0,0716. Из рис. 19 видно, что значения, предсказанные нейросетью, отличаются от действительных примерно на 7 %. Следовательно, данную нейросеть можно использовать для задачи распознавания логической функции XOR.

9

в) Используем нейросеть с характеристиками, аналогичными предыдущей нейросети, но с функцией активации нейронов выходного слоя linear для решения задачи распознавания XOR.

Обучим нейросеть методом обратного распространения ошибки. Параметры обучения:

−Число эпох: 1500

−Скорость обучения: от 0,2 до 0,05

−Momentum: 0,3

Рис. 20 – График ошибки обучения нейросети

Рис. 21 - Таблица с предсказаниями нейросети и действительными классами

Вывод: из рис. 20 видно, что в процессе обучения нейросети в течение 1400 эпох значение ошибки обучения постепенно убывает, на последней эпохе практически равно нулю. Из рис. 21 видно, что значения, предсказанные нейросетью, отличаются от действительных менее, чем на 1 %.

Следовательно, данную нейросеть можно использовать для задачи распознавания логической функции XOR.

10