- •Глава 5 інформаційні характеристики джерел повідомлень і каналів зв'язку

- •5.1 Загальні відомості про джерела повідомлень і канали зв'язку

- •5.2 Основні поняття теорії інформації

- •5.2.1 Часткова кількість інформації

- •5.2.2 Ентропія джерела повідомлень

- •5.3 Інформаційні характеристики дискретних каналів зв'язку

- •5.3.1 Кількість інформації, що передається по каналу зв'язку (взаємна інформація)

- •5.3.2 Пропускна спроможність дискретного каналу зв'язку

- •5.4 Теореми кодування шеннона для дискретного каналу зв'язку

- •5.4.1 Теорема про властивість асимптотичної рівноімовірності (вар)

- •5.4.2 Теорема 1. Про кодування джерела повідомлень

- •5.4.3 Теорема 2. Про кодування в каналі без завад

- •5.4.4 Теорема кодування в дискретному каналі з завадами

- •5.4.5 Інтерпретація теореми кодування

- •5.4.6 Енергетичний виграш кодування

- •5.5 Потенційні можливості безперервних каналів зв'язку при передачі дискретних повідомлень

- •5.5.1 Кодування й декодування в безперервному каналі зв'язку

- •5.5.2 Пропускна спроможність безперервного каналу зв'язку

- •5.5.2.1 Взаємна інформація пари відликів для аддитивної гауссовскої завади

- •5.5.2.2 Умовна диференціальна ентропія

- •5.5.2.3 Пропускна спроможність безперервного каналу зв’язку

- •5.5.2.4 Ε-ентропія безперервного джерела повідомлень

- •5.6 Теорема кодування для безперервного каналу зв'язку

- •5.6.1 Теорема про кодування в безперервному каналі з завадами

- •5.7 Потенційні можливості каналів з багатьма користувачами

5.3 Інформаційні характеристики дискретних каналів зв'язку

5.3.1 Кількість інформації, що передається по каналу зв'язку (взаємна інформація)

Розглянемо

деякий дискретний канал зв'язку, заданий

алфавітом входу і виходу (X,Y)

і умовним розподілом

![]() ,

і припустимо, що на вхід каналу

безпосередньо поступають повідомлення

від деякого дискретного джерела

повідомлень з алфавітом А,

співпадаючим з вхідним алфавітом каналу

Х.

Це припущення еквівалентне умові, що

сам вхід каналу є дискретним джерелом

повідомлень з алфавітом Х

і розподілом вірогідності послідовностей,

складених з символів цього алфавіту.

,

і припустимо, що на вхід каналу

безпосередньо поступають повідомлення

від деякого дискретного джерела

повідомлень з алфавітом А,

співпадаючим з вхідним алфавітом каналу

Х.

Це припущення еквівалентне умові, що

сам вхід каналу є дискретним джерелом

повідомлень з алфавітом Х

і розподілом вірогідності послідовностей,

складених з символів цього алфавіту.

Припустимо,

що це джерело має деяку ентропію Н(Х)

і видає послідовність х.

Тоді, якщо на виході каналу з'явилася

деяка послідовність у,

то можна поставити наступне питання:

як розрахувати кількість інформації

![]() ,

що міститься в х,

за умови, що на виході з'явилася

послідовність у?

Відповідь на нього можливо отримати,

скориставшись визначенням часткової

кількості інформації (5.4), але при заміні

безумовного розподілу вірогідності на

умовне, тобто

,

що міститься в х,

за умови, що на виході з'явилася

послідовність у?

Відповідь на нього можливо отримати,

скориставшись визначенням часткової

кількості інформації (5.4), але при заміні

безумовного розподілу вірогідності на

умовне, тобто

![]() (5.15)

(5.15)

Визначимо

умовну

ентропію

![]() входу каналу Х

при відомому виході Y

як МО (5.15) аналогічно тому, як це було

зроблено при знаходженні ентропії

джерела з виразу (5.6).

входу каналу Х

при відомому виході Y

як МО (5.15) аналогічно тому, як це було

зроблено при знаходженні ентропії

джерела з виразу (5.6).

Тоді маємо

![]() (5.16)

(5.16)

де, як і раніше, верхній індекс n в квадратних дужках означає довжину вхідних і вихідних послідовностей.

У окремому випадку каналу без пам'яті легко отримати з (5.16) вираз

![]() (5.17)

(5.17)

Умовна ентропія володіє наступними властивостями:

1)

![]() .

.

(Доводиться

за визначенням

![]() ).

).

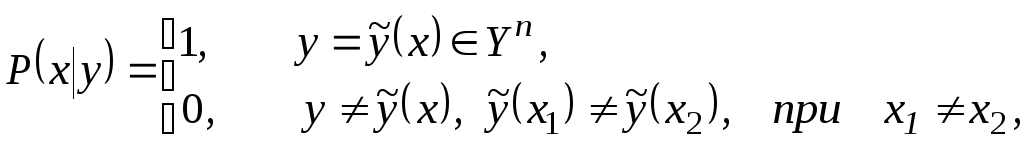

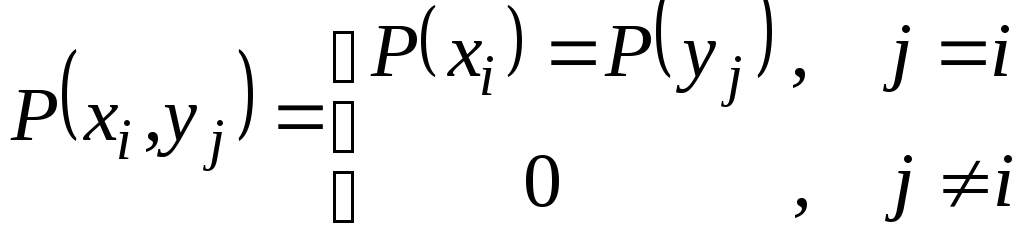

2) Якщо вхід і вихід каналу зв'язку взаємно однозначні, тобто

то

![]() (Ця властивість очевидна).

(Ця властивість очевидна).

3) ![]() (5.18)

(5.18)

4) ![]() (5.19)

(5.19)

тоді,

і лише тоді, коли

![]() при всіх

при всіх

![]() ,

тобто коли х

і у

взаємно незалежні. (перевіряється

безпосередньо).

,

тобто коли х

і у

взаємно незалежні. (перевіряється

безпосередньо).

Приведені

вище властивості дозволяють наочно

пояснити сенс поняття умовної ентропії

![]() .

Це середня інформація, що втрачається

з кожним символом в каналі зв'язку із-за

перешкод.

.

Це середня інформація, що втрачається

з кожним символом в каналі зв'язку із-за

перешкод.

Дійсно,

оскільки

![]() ,

то інформація із-за перешкод завжди

втрачається, але ніколи не отримується.

Якщо помилки в каналі відсутні, тобто

вхідна послідовність переходить в одну,

і лише в одну вихідну послідовність, то

,

то інформація із-за перешкод завжди

втрачається, але ніколи не отримується.

Якщо помилки в каналі відсутні, тобто

вхідна послідовність переходить в одну,

і лише в одну вихідну послідовність, то

![]() ,

то втрати інформації відсутні. (Не

виключена ситуація, коли вхідна

послідовність переходить з деякою

вірогідністю в різні вихідні, але все

таки по вихідній послідовності можна

однозначно визначити вхідну. Тоді як і

раніше

,

то втрати інформації відсутні. (Не

виключена ситуація, коли вхідна

послідовність переходить з деякою

вірогідністю в різні вихідні, але все

таки по вихідній послідовності можна

однозначно визначити вхідну. Тоді як і

раніше

![]() і втрати інформації будуть відсутні.)

і втрати інформації будуть відсутні.)

Нарешті,

якщо вихід каналу не залежить від входу,

а саме це і означає збіг умовної і

безумовної вірогідностей, то по каналу

зв'язку не передаватиметься ніякій

інформації, а оскільки на вхід каналу

поступає інформація Н(Х),

то вся вона виявляється втраченою із-за

перешкод, тобто

![]() .

.

Визначимо

кількість

інформації,

що передається по каналу зв'язку I(X,Y),

або взаємну інформацію між виходом Y

і входом X

як різниця між кількістю інформації,

що поступає на вхід (яка, як ми знаємо,

дорівнює ентропії входу Н(Х)),

і кількістю інформації, втраченою в

каналі зв'язку (яка, як ми тільки що

з'ясували, дорівнює умовній ентропії

![]() ).

).

Тому можливо записати

![]() (5.20)

(5.20)

Ця величина володіє наступними властивостями:

1) ![]()

де

ентропія виходу Н(Y)

і умовна ентропія виходу при відомому

вході

![]() визначаються абсолютно аналогічно

(5.6) і (5.16), з тією лише різницею, що

розподіли, що є там,

визначаються абсолютно аналогічно

(5.6) і (5.16), з тією лише різницею, що

розподіли, що є там,

![]() і

і

![]() повинні бути замінені на

повинні бути замінені на

![]() і

і

![]() відповідно. Ця властивість вимагає

доказу (див. [44]).

відповідно. Ця властивість вимагає

доказу (див. [44]).

2) ![]()

(Виходить безпосередньо з властивості 3 умовної ентропії.)

3)

![]() ,

тоді і тільки тоді, коли вхід і вихід

каналу статистично незалежні, тобто

,

тоді і тільки тоді, коли вхід і вихід

каналу статистично незалежні, тобто

![]() при всіх

при всіх

![]() .

(Виходить безпосередньо з властивості

4 умовної ентропії.)

.

(Виходить безпосередньо з властивості

4 умовної ентропії.)

4) ![]()

(Виходить

з визначення

![]() і властивості 1 умовної ентропії.)

і властивості 1 умовної ентропії.)

5) Якщо в каналі зв'язку відсутні завади, то

![]()

(Виходить з властивості 2 умовної ентропії.)

6)

![]() .

.

(Виходить з властивості 1 для кількості переданої по каналу інформації і властивості 1 для умовної ентропії.)

7)

![]() .

.

(Виходить формально безпосередньо з визначення, якщо покласти x=y, X=Y.)

8) Будь-які детерміновані або випадкові перетворення вихідних послідовностей каналу, у тому числі і угрупування спостережень, тобто об'єднання декількох послідовностей, що належать певній підмножині в один символ, не можуть збільшити кількість інформації.

У випадку, якщо ці перетворення взаємно однозначні, то кількість інформації не змінюється. Відмічена властивість виходить з того, що, пройшовши по каналу (перетворювачу) інформація або втрачається (за наявності неоднозначних перетворень) або не змінюється (при однозначних перетвореннях).

Вираз (5.20) для взаємної інформації може бути перетворена також до наступного вигляду, який іноді зручніший для розрахунків:

У окремому випадку каналу без пам'яті отримуємо наступний вираз:

![]() . (5.21)

. (5.21)

Формула

(5.21) підтверджує первинне визначення

![]() як кількості інформації, що передається

по каналу зв'язку з завадами. Дійсно,

якщо є обрив каналу, відповідний

відсутності статистичного зв'язку між

входом і виходом,

як кількості інформації, що передається

по каналу зв'язку з завадами. Дійсно,

якщо є обрив каналу, відповідний

відсутності статистичного зв'язку між

входом і виходом,

![]() то інформація по каналу не передається

(властивість 3).

то інформація по каналу не передається

(властивість 3).

Якщо в каналі завади відсутні, то можливо записати

тобто інформація передається повністю (властивість 5).

Властивість

1 виявляється менш очевидною. Вона

показує, що кількість інформації, що

передається з входу на вихід і «як би»

з виходу на вхід, виявляється одним і

тим же. По суті ця властивість і дозволяє

визначити величину

![]() ,

що задається співвідношенням (5.20), як

взаємну інформацію між X

і Y

(або, що те ж саме, між Y

і X).

,

що задається співвідношенням (5.20), як

взаємну інформацію між X

і Y

(або, що те ж саме, між Y

і X).

Таким

чином, величина

![]() подібно до коефіцієнта кореляції для

гаусівських випадкових величин виступає

тут як міра статистичної

залежності

між входом X

і виходом Y

каналу зв'язку. Властивість 1 спрощує

розрахунок

подібно до коефіцієнта кореляції для

гаусівських випадкових величин виступає

тут як міра статистичної

залежності

між входом X

і виходом Y

каналу зв'язку. Властивість 1 спрощує

розрахунок

![]() в деяких випадках, що визначається

наступною властивістю умовної ентропії.

в деяких випадках, що визначається

наступною властивістю умовної ентропії.

9) Для двійкового каналу з аддитивним шумом (п. 4.7)

де

Н(Е)

–

ентропія завади, що задається

співвідношенням (5.6), в якому розподіл

![]() замінений на розподіл зразків помилок

замінений на розподіл зразків помилок

![]() .

.

Об'єднавши властивість 9 для умовної ентропії в каналі з аддитивним шумом і властивість 1 для кількості передаваної інформації, отримуємо наступне уявлення:

![]() (5.22)

(5.22)

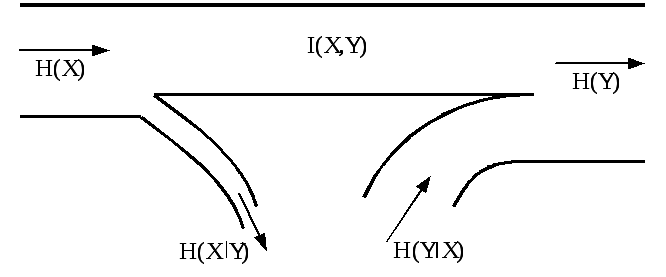

Визначення взаємної інформації наочно ілюструється на рис. 5.2.

Якщо

для каналу зв'язку задана швидкість

передачі νк

[симв/с], то аналогічно визначенню

продуктивності джерела можна визначити

швидкість передачі інформації по каналу

зв'язку

![]() :

:

![]() [біт/с]. (5.23)

[біт/с]. (5.23)

Рисунок 5.2 – Ілюстрація передачі інформації по каналу з завадами