ответы мо

.doc-

Оптимальный-наилучший.

-

Недопустимы выражения «самый оптимальный» и т.п., потому что лучше наилучшего не бывает.

-

Оптимизация в широком смысле-выбор наилучшего варианта из мн-ва альтер-х.

-

Оптимизация в узком смысле-миним-я или максим-я ф-й.

-

Наиболее полно используют возможности современной вычислительной техники численные методы.

-

Впервые ввёл в математике термин «оптимизация» Лейбниц.

-

Синоним МО-математическое программирование.

-

Невозможно прделожить один метод, один-во эффект-й для всех задач, поэтому изучается мн-во методов.

-

Предмет учебной дисциплины «Методы оптимизации»-ЧМ организации.

-

Параметры оптимизации-переменные параметры, т.е. те независ-е перем. в задаче оптимизации, кот. можно произвольно менять. Вектор переменных параметров-набор всех перем-х парам. x=(x1, x2, ..,xn)T, n=dimX.

-

Пространство параметров xiєR=(-∞;+∞)-мн-во всех векторов Х(Rn). Размерность-Rn=RxRx…xR(n раз).

-

Допустимая область-включает ограничения в виде равенств и неравенств: D={x|gk(x)≤0,k=1,p; hj(x)=0, j=1,r}

-

Критерий качества-любой функ-нал, кот представляет качество системы.

-

Целевая функция-критерий качества с указанием признака его оптим-ции(миним-ции или максим).

-

Задача оптимизации-миним-ции целевой ф-ии при отсутствии или наличии огр-ний.

-

Решение задачи оптимизации: x*-вектор, удовлет-й усл: f(x*)=min f(x).

-

МО-ЧМ, кот позвол-т получить реш-е зад-и опт-ии эфф-м путем без полного перебора вар-тов

-

Задача Дидоны: Треб. Max площадь S(x)=x1*x2 при огранич. периметра l(x)=x, l(x)=2x1+x2. Задача нелин-го прогр. S(x)→max, 2x1+x2=C.

-

Задача нелинейного программирования это задача на условный минимум с ограничениями типа неравенств.

-

Задача оптимального распределения ресурсов: требуется из m рес-ов, запасы кот. a1,..,am, изготовить n изделий x1,..,xn. Ci-стоимость продажи xi, bij-норма расхода jго рес-са для произв iго изделия. Необх max прибыль предпр. f(x)=Σcixi, Σbijxi≤aj, j=1,m, xi≥0, i=1,n. Зад. лин-г прогр-я.

-

Общей задачей лин. прогр-я называется задача, которая состоит в определении макс. (мин.) значения функции?

-

Транспортная задача: миним-ции перевозок различ-х грузов из пункта произв-ва в п. потребл. при огр-ях этих грузов как в п. произв, так и в п. потребл. Лин.програм.

-

Задача оптимизации ракеты: Цел ф-я f(x)-модель стоимости ракеты, включ. 26 огран-й. dimx=25. Цел ф-я и огран. нелин-ые. f(x) →min, xєD. Было получ реш-е x*, для кот. f*=f(x*)=2330000$. Чичинадзе разраб. метод ψ-преобр и нашел глоб мин f**=f(x**)=1359000$.

-

Полезность решения задач опт:

-

Основные признаки классификации МО: применяемые средства, типы задач опт-ции, пор-ку проив-х

-

Классификация МО по применяемым средствам: аналит-е(методы мат анализа), графич-е, числ-е(прим вычисл техники), эксперемент-е, полного перебора вар-тов.

-

Классификация МО по математической формулировке задачи оптимизации: одномер поиска, многомер безусл опт-ии, условной опт-ии, лин програм-я, выпуклого прогр-я, миним-ии суммы квадратов, дискр прогр-я.

-

МО по порядку используемых производных целевой функции: 0го(прямого поиска), 1го(первая произв ▼f(x)-вектор произ-х), 2го.

-

МОП для задачи 0го.

-

Т x* назыв т миним ф-ии, если в ней достиг найменшее знач по сравн-ю с др т нек-й её окрестности f*=f(x*).

-

Теорема Ферма: если диф-я ф-я f(x) в т x* имеет экстремум, то f’(x*)=0.

-

Точки, в кот произв-я обращ-ся в 0 назыв стационарными.

-

Найменьший минимум многоэкстр-й ф-ии назыв глобал, остальные-локал-е.

-

Необходимый признак сущ-я экстр ф-ии одной перем: произв-я обращ-сь в 0..

-

Необх и дост-й признак сущ-я экстр ф-ии одной перем: изменение знаков произв при переходе через данную точку.

-

Если для f’’(x) f’(x*)=0, а f’’(x*)≠0(>0-min, <0-max)

-

Строго убывающими и строго возрастающими явл ф-ии, если для знач u<v f(u)<f(v).

-

Унимодальная ф-я-для кот сущ-т такое знач аргум x*левее кот ф-я убывает, а правее-возраст.

-

Выпуклая-ф-я, если для любого λє[0,1] и любых 2х т u и v вып-ся f(λu+(1-λ)v)≤ λf(u)+(1-λ)f(v). Если нерв-во строгое-строго выпук

-

Аналогично выпукл, только знак ≥.

-

Особенность выпуклой функции, имеющей минимум: график выпуклой функции лежит под хордой, соединяющей две любые ее точки.

-

Инт-л неопред-интер-л [a,b]cR, кот содержит неизв т миним x*.

-

Этапы МОП: поиск инт-ла неопр, его уменьшение.

-

Чтобы определить инт-л неопр необх 2 точки.

-

Чтобы уменьшить этот интервал необх 2 внутр точки.

-

Правило исключ инт-в: если для [a,b], содерж-го т мин x* со знач ф-ии f*=f(x*) известны 2 внутр точки u и v такие, что u<v, fu=f(u), fv=f(v), то при усл fu<fv x*є[a,b], а при усл fu ≥fv xє[u,b].

-

Метод Свенна предназначен для поиска инт-ла неопр методом удвоения шага

-

Если ф-я в найденной точке f1<f0, то шаг удваивается в полож-м напр, иначе идем в отриц-м напр-ии.

-

Шаги вычисл до тех пор, пока знач ф-ии уменьш.

-

Метод Свенна: пусть треб найти инт неопр в т мин унимод ф-ии f(x). Зададим нач т поиска x0 и вычисл f0=f(x0)На осн зад-го шага h>0 найдем x1=x0+h и вычисл f1=f(x1). Если f1<f0, то вып поиск в полож направл путем удвоения шага по ф-ле xk+1=xk+2kh. Если f1≥f0, то x2=x0-h и f2=f(x2). Если f2<f0, то вып-ся шаги в отриц напр по ф-ле xk+1=xk-2k-1h.

-

Метод Свенна 0 пор-ка.

-

Пассивная стратегия опред-ся тем, что т поиска xkє[a,b] зад-ся заранее до вычис знач-й ф-ии в этих т.

-

Назначение метода равномерного поиска-уменьш инт-ла неопр.

-

Метод равномерного поиска: пусть известен инт неопр и задано допуст число вычисл ф-ии n. Разделим [a,b] длинны L=b-a равномер и т на n+1частей длины δ=L/n+1, xk=a+k* δ, fi=minfk. Конечный инт неопр Ln=2δ=2L/n+1.

-

Эффективность метода равномерного поиска опред-ся отнош длин конечного инт неопр к начальному rn=Ln/L=2/n+1.

-

Преимущество равномер поиска-позволяет вычислить миним даже многоэкстрем-й цел ф-ии в зад-м инт с гарантир-й точностью. Недостатки-для унимод ф-й сущ-т намного более эфф методы поиска.

-

Последовательные МОП отличаются выбором целевой ф-ии.

-

Назначение метода дихотомии: уменьшение инт-ла неопр.

-

Основные принципы метода дихотомии:

-

Метод дихотомии: пусть известен инт неопр длинны L=b-a и для уменьш инт-ла разделим его на т u и v. По правилу искл инт-лов остан-ся новый инт неопр [a,v] или [u,b]. u=c- δ, v=c+ δ. Если fu<fv, то [a,v] новый инт неопр, иначе [u,b]. Длинна нового инт L2=L/2 + δ. Чтобы длинна нового инт была найм δ должно быть как можно меньше.Т. обр., на каждой итер 2жды вычисл знач ф-ии и при дост малом δ инт неопр <в 2р.

-

Для повышения эфф-ти поиска полаг-т l1=l2, т.е. u и v зад-ся симм-но относ серед инт-ла c=a+b /2 на расст δ.

-

Метод дихотомии нулевого порядка.

-

Основным недост метода дих-мии явл его завис от парам δ: при большом знач метод теряет эфф-ть, а при малом т u и v могут оказ неразлич и инт неопр м.б. потерян. Также недост явл вычисл знач ф-ии в 2х т на каждой итер. Дост-м явл высокая эфф-ть по сравн с методом равномер поиска и простота алгоритма.

-

Назначение метода деления интервала пополам: уменьш инт-ла неопр.

-

Метод деления интервала пополам: разделим инт неопр длинны L=b-a пополам. Т c=a+b /2 и вычисл fc=f(c). Разделим левый инт-л [a,c] пополам и u=a+c /2, fu=f(u). Если fu<fc, то (c,b] не содержит т мин x* и его можно исключ. Новый инт-л [a,c] с извест средней т (v,fv). Иначе [c,b] пополам, т b=c+b /2, fb=f(b). Если fv<fc, то [a,c) искл, [c,b]-инт неопр. Иначе искл крайние инт-лы [a,u) и (v,b], а [u,v] инт неопр, включ ср т (c,fc).

-

Эффек-ть метода: в найл случае, когда выбир левая половина инт-ла, длинна инт-ла неопр после n вычисл ф-ии fn=L/2n-1. В противном сл Ln=L/2(n-1)/2, rn=Ln/L, 1/2n-1≤rn≤1/2(n-1)/2.

-

Метод деления интервала пополам нулевого пор-ка

-

Достоинства метода деления инт-ла пополам: по сравн с дихот данный метод в найл случае использ-т примерно вдвое меньшее число вычисл, а в найхуд-только на 1 больше; не зависит от δ и в нем примен только операции сложения и деления на 2; облад высокой надежностью. Недостаток-более сложный алгоритм, а также вычисл 2х зач ф-ии в найхуд случае для каждой итер.

-

Числа Фибоначчи вычисл по ф-ле Fn=Fn-1+Fn-2

-

10 первых чисел Фибоначчи: 1, 1, 2, 3, 5, 8, 13, 21, 34, 55.

-

Cвойства чисел Фибоначчи: Fn2-Fn-1Fn+1=(-1)n; Fn-1Fn-2-FnFn -3 =(-1)n.

-

Формула Бине для чисел Фибоначчи:

-

Назначение метода Фибоначчи: уменьш инт-ла неопр.

-

Метод Фибоначчи: инт неопр длинны L=b-a дел 2мя т x1 и x2, симм-ми относ центра инт-ла, после чего прим правило исключ инт-лов. На послед-х итер оста-ся одна изв-я внутр т инт-ла xk, а след т xk+1 нах-ся симм-но изв-й внутри т. На послед итер после n вычисл-й ф-ии ост-ся инт неопр длинны Ln, кот получ также, как и в дихот.

-

Общая формула для длин интервалов неопределенности в методе Фибоначчи: Ln-j=Fj+1Ln-Fj-1δ, j=1,n-1.

-

В методе Фибоначчи для начала поиска необх найти полож первой т деления исх инт, кот должна лежать на расст L2 от конца инт. При j=n-2 получим L2=Fn-1Ln-Fn-3 δ.

-

Метод Фибоначчи явл теор самым эфф-м методом уменьш инт, т.к. на всех итер кроме 1й вычисл только 1 знач. Rn=1/Fn

-

Метод Фибоначчи 0го пор-ка.

-

Недостатком метода Фиб явл зависимость от δ и треб-ся задавать число n. Преимущ-найбольшая эфф-ть.

-

Задача «о делении отрезка в крайнем и среднем отношении» привела к появл ЗС: разделить отрезок AB тC в таком отнош, чтобы длина большей части отр CB так относ к длине меньшей части AC, как длина всего AB к большей части CB.

-

Уравнение ЗС: AB/CB=CB/AC, AB=AC+CB, x=AC+CB /CB=1+AC/CB=1+1/CB/AC=1+1/x, x2=x+1, корень

.

. -

Численное представление ЗС

.

. -

Свойства ЗС: обратное ему число на осн x2=x+1 можно получить вычит-ем единицы, любая целая степень ЗС равна сумме пред.

-

Связь между числами Фиб и ЗС:

-

Назначение метода ЗС: уменьш инт-ла неопр.

-

Метод ЗС: 2 первые т дел x1=b-tL, x2=a+tL. В этих т вычисл знач ф-ии f1=f(x1), f2=f(x2) и на осн сравн-я этих знач по прав искл инт-в в ост-ся инт-л [a,x2]=>(f1<f2), [x1,b]=>(f1>f2). После 1й итер имеем меньший инт неопр с 1 внутр т, кот делит новый инт также по ЗС. На посл итер-х наход-ся только 1 внутр т, симм-я оставш-ся т относ-но центра. Итер до тех пор пока Ln<E.

-

Как и метод Фиб, ЗС использ принцип сиим-ии для 2х внутр т деления инт неопр.

-

Метод ЗС обладает преимущ-м перед Фиб, потому что в нем вычисл можно прекратить в любой момент, т.к. точки, в кот пров-ся вычисл не зависят от их общего числа n.

-

Поиск минимума в методе ЗС начин с определ 2х первых т дел-я x1=b-tL, x2=a+tL и вычисл знач ф-ии f1=f(x1), f2=f(x2).

-

Эффективность метода ЗС: Ln=tn-1L=L/

n-1,

rn=1/

n-1,

rn=1/ n-1.

n-1. -

Сравнение методов Фиб и ЗС: lim LFn/

n-1L=lim

n-1L=lim n+1/

n+1/ =

= .

Т.обр, при больших n

методом ЗС будет найден инт неопр на

17% больше, чем методом Фиб.

.

Т.обр, при больших n

методом ЗС будет найден инт неопр на

17% больше, чем методом Фиб. -

Метод ЗС 0го пор-ка.

-

Дост-во метода ЗС:высокая эфф-ть, практ-ки такая же, как у Фиб и дост-но постой алг, не треб-й задания числа вычисл n. Недостаток: завис от иррац-го числа t, кот необх задавать с макс возм-й точностью, иначе внутр т инт-ла могут изменить порядок и инт-л будет утерян, снижается надежность метода.

-

Назначение метода адаптации шага: уменьш инт-ла неопр.

-

Метод адаптации шага: зад-ся нач т x0, r0=0, h0. Из нач т нах-ся пробная т поиска y1=x0+h0, g1=f(y1). Все итер провод-ся по ф-ам yk+1=xk+hk, gk+1=f(yk+1). После этого нах-ся лучшая т поиска (xk+1, fk+1). В завис от сравн новой и лучшей точек и знач предыд множ шага, вычисл знач нового множ-ля

-

Шаг поиска в методе адаптации шага изм-ся по ф-ле hk+1=hk * rk+1.

-

Метод адаптации шага 0го пор-ка.

-

Дост метода адапт шага: алг проще метода Свенна или дел инт пополам, не связан ни с какими парам, а основан на опер-х слож и умнож на степени 2ки, работает надежно и позв нах-ть мин цел-й ф-ии со сверхвысокой точностью.

-

Группы методов уменьшения инт неопр: 1)требующие задания инт неопр , ф-ии одной перем-равномер поиск, дихот, дел пополам, Фиб, ЗС. 2)не треб зад-я инт неопр-адапт шага.

-

Сравните эффективность методов уменьшения интервала неопределенности.

|

r |

МРП |

МД |

МДИП |

МФ |

МЗС |

|

10-1 |

19 |

8 |

[5; 9] |

6 |

6 |

|

10-2 |

199 |

14 |

[8; 15] |

11 |

11 |

|

10-3 |

1999 |

20 |

[11; 21] |

16 |

16 |

|

10-4 |

19999 |

28 |

[15; 29] |

20 |

21 |

|

10-5 |

199999 |

34 |

[18; 35] |

25 |

25 |

По этой таблице видно, что теоретически самым эффективным методом умень-шения интервала неопределенности является метод Фибоначчи. Незначительно уступает ему в эффективности метод золотого сечения.

101. Какое назначение метода бисекции?

применяется для уменьшения интервала неопределенности с помощью вычисления производной целевой функции в средней точке интервала и часто используется для повышения надежности методов аппроксимации и интерполяции первого порядка.

102. На каких свойствах производной основан метод бисекции?

если мы ищем ноль, то на концах отрезка функция должна быть противоположных знаков. Разделим отрезок пополам и возьмём ту из половинок, на концах которой функция по-прежнему принимает значения противоположных знаков. Если значение функции в серединной точке оказалось искомым нулём, то процесс завершается.

103. По какому принципу уменьшается интервал неопределенности в методе бисекции?

На каждой итерации происходит уменьшение интервала неопределенности в 2 раза с помощью вычисления производной целевой ф-ции. При этом по правилу исключения интервалов исключается правая или левая часть интервала в зависимости от значения ф-ции и произв в средней точке. Итерации продолжаются до тех пор, пока длина интервала неопределенности не станет меньше заданного значения.

104.Опишите метод бисекции.

В этом методе

вычисляются средняя точка интервала

![]() ,

а также значения функции и ее производной

в средней точке:

,

а также значения функции и ее производной

в средней точке: ![]() . Если

. Если ![]() ,

то найдена точка минимума , и вычисления

прекращаются. Если

,

то найдена точка минимума , и вычисления

прекращаются. Если ![]() ,

то исключим интервал [a,c),

не содержащий точку минимума, полагая

a=c.

Если же

,

то исключим интервал [a,c),

не содержащий точку минимума, полагая

a=c.

Если же ![]() ,

то исключим интервал (c,b],

полагая b=c.

Вычисления продолжаются, пока длина

интервала неопределенности L=b-a

превосходит допустимую погрешность

L>E.

,

то исключим интервал (c,b],

полагая b=c.

Вычисления продолжаются, пока длина

интервала неопределенности L=b-a

превосходит допустимую погрешность

L>E.

105.Какова эффективность метода бисекции?

![]() . Соответствует методу дихотомии.

. Соответствует методу дихотомии.

106.Какого порядка метод бисекции? Первого

107.Какие преимущества и недостатки метода бисекции?

Недостатки: в наихудшем случае может потратить только на одно вычисление функции больше, чем метод дихотомии.

Преимущества: в наилучшем случае он использует почти вдвое меньшее количество вычислений. К тому же в методе применяются только простые арифметические операции сложения чисел и деления на два.

108.Какое назначение методов квадратичной интерполяции?

Минимизации унимодальной целевой функции с целью поиска точки минимума функции.

109.Какие основы методов квадратичной интерполяции?

Основаны на

аппроксимации целевой функции квадратичным

полиномом ![]() ,

где коэффициенты определяются по

значениям целевой функции и ее производных.

,

где коэффициенты определяются по

значениям целевой функции и ее производных.

110.Выведите формулу квадратичной интерполяции для точки минимума.

Дифференцируем

равенство ![]() ,

и получаем

,

и получаем ![]()

По необходимому

условию существования экстремума

![]() получим

точку минимума параболы

получим

точку минимума параболы ![]() .Дальше

определить коэф.

.Дальше

определить коэф.

111.Какое назначение метода квадратичной интерполяции с тремя точками?

При помощи аппроксимации f(x) по 3 ее точкам квадратичным полиномом осущ поиск точки минимума этого функции точкой минимума этого полинома.

112.Опишите метод квадратичной интерполяции с тремя точками.

Первые

3 точки находим по м.Свенна: ![]() .

Подставляем эти значения в ур.параболы.:сист.

.

Подставляем эти значения в ур.параболы.:сист.

![]() .Решая

сист от параметров и подставив их в

.Решая

сист от параметров и подставив их в ![]() получим т. Минимума

получим т. Минимума  .

Далее отбрасывается часть инт, где нет

миним. Итер продолжается по двум последним

формулам, пока расстояние больше

погрешности.

.

Далее отбрасывается часть инт, где нет

миним. Итер продолжается по двум последним

формулам, пока расстояние больше

погрешности.

113.Как начинается поиск минимума в методе квадратичной интерполяции с тремя точками?

Первые

3 точки находим по м.Свенна: ![]() .

Дифференцируем равенство

.

Дифференцируем равенство ![]() ,

и получаем

,

и получаем ![]() Получаем т минимума

Получаем т минимума ![]() .

Определяем коэф.

.

Определяем коэф.

114.Какого порядка метод квадратичной интерполяции с тремя точками?

Нулевого.

115.Какие преимущества и недостатки метода квадратичной интерполяции с тремя точками?

Преим:Легкие математ операции, нулевой порядок

Недост: Вледствии ошибок округления при выч минимума может оказаться, что значение окажется вне интервала неопределенности.

116.Какое назначение метода квадратичной интерполяции с двумя точками?

При помощи аппроксимации f(x) по 2 ее точкам квадратичным полиномом осущ поиск точки минимума этого функции точкой минимума этого полинома.

117.Опишите метод квадратичной интерполяции с двумя точками.

Первые

2 точки находим по м.Свенна: ![]() .

Вычислим знач производной функ. На одном

из концов

.

Вычислим знач производной функ. На одном

из концов ![]() Подставляем

эти значения в ур.параболы.и ее

произв.:сист.

Подставляем

эти значения в ур.параболы.и ее

произв.:сист.

.или

.или

![]() .

Решая одну из систем нах.парам и вычисл

.

Решая одну из систем нах.парам и вычисл

![]() .

Если

.

Если ![]() ,

то найдена точка минимума , и вычисления

прекращаются. Если

,

то найдена точка минимума , и вычисления

прекращаются. Если ![]() ,

то исключим интервал [a,u),

не содержащий точку минимума, полагая

a=u,

функ и производные равны. Если же

,

то исключим интервал [a,u),

не содержащий точку минимума, полагая

a=u,

функ и производные равны. Если же ![]() ,

то исключим интервал (u,b],

полагая b=u,

функ и производные равны. Вычисления

продолжаются, пока длина интервала

неопределенности L=b-a

превосходит допустимую погрешность

L>E.

,

то исключим интервал (u,b],

полагая b=u,

функ и производные равны. Вычисления

продолжаются, пока длина интервала

неопределенности L=b-a

превосходит допустимую погрешность

L>E.

118.Какого порядка метод квадратичной интерполяции с двумя точками?

первого

119.Какие преимущества и недостатки метода квадратичной интерполяции с двумя точками?

Преимущества: простота СЛАУ

Недостатки: Вычисление производных

120.Какое назначение метода секущих?

При помощи аппроксимации f(x) по 2 ее точкам квадратичным полиномом осущ поиск точки минимума этого функции точкой минимума этого полинома.

121.Как начинается поиск минимума в методе секущих?

Первые

2 точки и на концах интервала неопределенности

найдем по алгоритму метода Свенна.

Вычислим значения производных в этих

точках.Сост сист уравнений ![]() .

Получим ф для выч т миним

.

Получим ф для выч т миним ![]() .

.

122.Опишите метод секущих.

Первые 2 точки и на

концах интервала неопределенности

найдем по алгоритму метода Свенна.

Вычислим значения производных в этих

точках.Сост сист уравнений ![]() .

Получим ф для выч т миним

.

Получим ф для выч т миним ![]() .

. Если

.

. Если ![]() ,

то исключим интервал [a,u),

не содержащий точку минимума, полагая

a=u,

функ и производные равны. Если же

,

то исключим интервал [a,u),

не содержащий точку минимума, полагая

a=u,

функ и производные равны. Если же ![]() ,

то исключим интервал (u,b],

полагая b=u,

функ и производные равны. Вычисления

продолжаются, пока длина интервала

неопределенности L=b-a

превосходит допустимую погрешность

L>E.

,

то исключим интервал (u,b],

полагая b=u,

функ и производные равны. Вычисления

продолжаются, пока длина интервала

неопределенности L=b-a

превосходит допустимую погрешность

L>E.

123.Какого порядка метод секущих?

Первого

124.Какие преимущества и недостатки метода секущих?

Преим: Простота формул

Недост: медленная сходимость при минимиз невыпуклой ф-ции, диф функции

125.Какое назначение метода Ньютона?

При помощи аппроксимации f(x) по ее точке квадратичным полиномом осущ поиск приближением точки минимума этого функции точкой минимума этого полинома.

126.Выведите итерационную формулу метода Ньютона.

127.Опишите метод Ньютона.

Первую точку a на конце интервала неопределенности [a, b] со

значением целевой функции fa = f (a) найдем по алгоритму метода

Свенна. Вычислим значения первой и второй производных в этой точке f’a= f ‘(a) и f¢¢a = f ‘‘(a) . Дифференцируя равенство (4.2), имеем q¢¢(x) = 2a .

составим систему

уравнений:![]()

Решая эту систему и подставляя найденные значения коэффициентов

a и b ,получим формулу

для вычисления точки минимума ![]()

Эта формула геометрически соответствует нахождению точки пересе-

чения с осью абсцисс Ox касательной, проведенной из точки a гра-

фика функции f ¢(x) , поэтому ее называют формулой касательной.

Затем вычислим fu

= f

(u)

, f’u f (u)

и f’’u f (u).

Если ![]() ,

то найдена точка минимума , и вычисления

прекращаются. В противном сл a=u

и прим формулу

,

то найдена точка минимума , и вычисления

прекращаются. В противном сл a=u

и прим формулу

Вычисления продолжаются, пока расстояние между двумя последовательными точками интерполяции превышает допустимую погрешность e .

128.Какого порядка метод Ньютона? Второго

129.Какие преимущества и недостатки метода Ньютона?

Преим: Простота формул, а также его быстрая сходимость

Недост: Необход использ вторых частных производных, а также для выпуклых функ может расходиться.

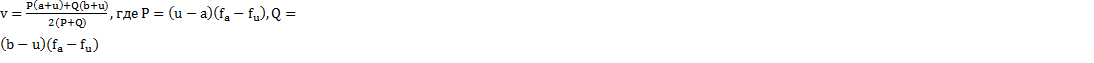

130.Какое назначение методов кубической интерполяции?