- •1. Определение информации. Семиотика и ее составные части. Фазы обращения информации.

- •2. Структура системы связи. Основные задачи каждого блока системы связи.

- •3. Измерение информации. Дискретный источник информации. Мера информации по Хартли и ее свойство

- •4. Измерение информации по Шеннону.

- •5. Свойства информации по Шеннону.

- •6. Энтропия нескольких источников информации.

- •7. Энтропия непрерывного источника. Относительная энтропия.

- •8. Избыточность источника сообщений.

- •9. Взаимосвязь между энтропией и числом сообщений.

- •10. Пропускная способность двоичного канала.

- •11. Согласование характеристик сигнала и канала.

- •Амплитудная модуляция

- •12. Пропускная способность непрерывного канала с помехами.

- •13. Классификация методов преобразования непрерывной информации в дискретную форму.

- •14. Теорема дискретизации Котельникова в.А. И ее особенности.

- •Свойства ряда Котельникова:

- •15. Корреляционный критерий дискретизации.

- •16. Адаптивные методы дискретизации.

- •Нулевая степень воспроизводящей функции

- •Первая степень приближающего многочлена

- •17. Квантование по уровню. Шум квантования.

- •О терминах

- •Основные принципы построения цап с резистивными цепочками Первый вариант

- •19. Ацп поразрядного взвешивания. Ацп поразрядного уравновешивания на конденсаторах

- •Первый шаг

- •Быстродействие

- •20. Устройство выборки - хранения. Принцип действия и схемы увх

- •21. Распределение мощности в спектре периодического сигнала.

- •22. Спектр периодической последовательности прямоугольных импульсов. Пример.

- •23. Спектр одиночного прямоугольного импульса. Пример.

- •24.Теорема Парсеваля о распределении энергии в спектре непериодического сигнала.

- •25. Взаимосвязь между длительностью импульса и шириной его спектра.

- •26. Спектральная плотность мощности случайного процесса.

- •27. Цели кодирования. Эффективное кодирование. Методы эффективного

- •Цели изучения темы «Эффективное кодирование».

- •Задачи эффективного кодирования.

- •28. Техническая реализация кодирующего и декодирующего устройств эффективного кода.

- •29. Теорема Шеннона о пропускной способности канала без помех и

- •30. Теорема Шеннона о пропускной способности канала при наличии помех. Классификация помехоустойчивых кодов.

- •31. Общие принципы использования избыточности в блоковых кодах.

- •32. Групповой код. Математическое введение. Определение количества

- •33. Таблицы опознавателей и проверочные уравнения для различных кодов (7;4); (7;3); (8;2); (9;3).

- •34. Техническая реализация группового кода и его матричная запись.

- •35. Циклический код. Математическое введение. Выбор образующего многочлена по требуемой корректирующей способности кода.

- •36.Методы построения циклического кода.

- •6.4.1. Методом умножения

- •6.4.2. Методом деления

- •6.4.3. По методу группового кода

- •37. Техническая реализация кодирующих устройств циклического кода по методу умножения (примеры).

- •38. Техническая реализация кодирующих устройств циклического кода по методу деления (примеры).

- •39. Техническая реализация кодирующих устройств циклического кода по методу группового кода (примеры).

- •40. Техническая реализация декодирующих устройств циклического кода, исправляющих одиночную ошибку. Пример.

- •41. Техническая реализация декодирующих устройств циклического кода, исправляющего 2-ые смежные ошибки. Пример.

- •42. Рекуррентный код. Кодирующее и декодирующее устройства. Пример.

- •43.Итеративные коды. Код с повторениями.

- •Модифицированный код с повторением

6. Энтропия нескольких источников информации.

Пусть имеются два источника XиY, которые выдают события {x1;x2;...xi;...xn} и {y1;y2;...yj;...ym}. Рассмотрим одновременное наступление двух событийxiиxj. Вероятность его появления обозначимp(xi;yj), а вероятности появления любых пар (xi;yj) составят матрицу ||p(xi;yj)||, где 1 ≤i≤n, а 1 ≤j≤m.

Количество информации, которое будет получено от факта наступления события (xi;yj) будет равноI= –logp(xi;yj).

Среднее количество информации на одну пару, или энтропия объединения двух событий подсчитывается по формуле:

Для независимых случайных событий XиYвероятность совместного наступления объединения двух событийxiиyjопределяется как произведение вероятностей появления каждого из этих событий, то естьp(xi;yj) =p(xi) ·p(yj). Учитывая это энтропию объединения можно подсчитать по следующей формуле:

то есть энтропия объединения двух независимых источников XиYравна сумме энтропий этих источников. То же можно утверждать об энтропии объединения многих независимых случайных источников, то есть

![]() .

.

Вероятность совместного наступления объединения двух взаимозависимых событий p(xi;yj) подсчитывается как произведение вероятности появления одного из них на условную вероятность появления второго при условии, что имеет место факт появления первого события, то есть

.

.

Учитывая это, энтропию объединения двух взаимозависимых источников следует считать по иному:

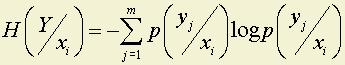

Где

–

условная энтропия источникаYотносительно событияxi;

–

условная энтропия источникаYотносительно событияxi;

H(Y⁄X) – условная энтропия источникаYотносительно источникаX, так как при расчете учитываются все состояния, которые может принимать источникX.

Для объединения из трех взаимозависимых источников X;Y;Zможно записать:

H(X;Y;Z) =H(X) +H(Y⁄X) +H(Z⁄X;Y).

Для объединения двух взаимозависимых событий можно записать пределы, в которых может меняться его энтропия:

max[H(X);H(Y)] ≤H(X;Y) ≤H(X) +H(Y), то есть

энтропия объединения всегда больше энтропии одного из источников, но меньше суммы их энтропий. Первое утверждение верно, когда имеет место линейная зависимость одного из источников от другого, а второе – когда источники независимы.

Рассмотрим пример расчета энтропии объединения двух источников. Пусть нам задана матрица ||p(xi;yj)|| следующего вида:

На матрицу наложены следующие ограничения:

.

.

Требуется определить H(X;Y) тремя способами:

Надо определить источники XиYвзаимозависимы или нет.

Матрицу ||p(xi;yj)|| можно задать самим при условии, что m и n не более четырех, а можно запросить у ЭВМ, которая ее (матрицу) сгенерирует.

При расчетах следует учитывать, что

![]() ;

;

![]()

7. Энтропия непрерывного источника. Относительная энтропия.

При попытке оценить неопределенность непрерывной случайной величины (с непрерывным множеством возможных состояний) – появляются особенности.

«Непрерывность» имеет смысл только для количеств, то есть объект с непрерывным множеством возможных состояний – это количественная случайная величина.

Распределение вероятности по состояниям характеризуется в этом случае плотностью вероятности p(x). Плотность вероятности величина размерная. Размерность обратная размерности случайной величины X, так как вероятность p(x)·dx безразмерна.

Переход к безразмерной случайной величине X, проведем путем деления размерной случайной величины X* на единицу ее измерения X0. Тогда и плотность вероятности будет безразмерной. Разобьем всю область (–Ґ; +Ґ) возможных значений случайной величины X на интервалы, разделенные отстоящими на равных расстояниях Δx друг от друга интервалами (x-1; x0;...xk;...).

Всякий раз, когда реализуется значение x О (xk; xk + Δx) будем считать, что реализовалось значение xk величины X.

Рис. 2.3

Таким образом перешли к дискретной случайной величине, которая характеризуется распределением вероятностей. Вероятность наступления какого-либо состояния равна

.

.

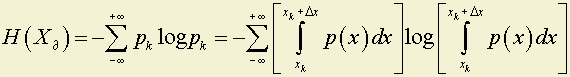

Очевидно, что при Δx ® 0 квантованная величина Xд будет все более и более полно отражать все свойства непрерывной величины X. С другой стороны, к величине Xд (дискретной) можно применить понятие энтропии

.

.

Устремим Δx

® 0. При достаточно малых Δx

примем

.

Поэтому

.

Поэтому

Таким образом предел энтропии H(Xд) за счет второго члена (–log Δx) стремится к бесконечности при Δx ® 0. Убедившись в том, что непрерывные случайные величины не допускают введения конечной абсолютной меры неопределенности, введем относительную меру. В качестве стандарта для сравнения можно брать неопределенность какого-либо простого распределения, например – равномерного в интервале шириной e. Разделим интервал e также на участки Δx и подсчитаем

.

.

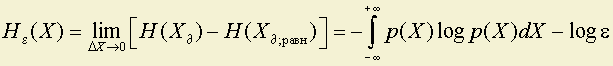

Будем характеризовать неопределенность непрерывной случайной величины X числом, к которому стремится разность энтропий квантованных величин Xд (случайной величины X любого распределения) и Xд;равн(случайной величины, распределенной по равномерному закону на интервале e):

.

.

Эта разность конечна.

Если взять за стандарт неопределенность случайной величины, равномерно распределенной в единичном интервале, то есть принять (e = 1), то

.

.

Число He=1(X) обычно и называют относительной энтропией непрерывной случайной величины. По численному значению относительной энтропии различные источники сообщения можно сравнить между собой.

Относительная энтропия характеризуется теми же свойствами, что и энтропия дискретного источника:

1. Не зависит от конкретного содержания случайной величины.

2. Энтропия объединения двух независимых источников выражается формулой:

.

.

3. Энтропия объединения двух статистически зависимых источников:

![]() ,

,

где

.

.

4. He(X; Y) ≤ He(X) + He(Y).

5. Всякое сглаживание функций распределения p(X) ведет к росту He(X).

Рис. 2.4

Hε1(X) < Hε2(X).

Исключение составляет лишь то, что He(X) может принимать отрицательные значения, так как He(X) – это разность энтропий, а случайная величина X может быть распределена на небольшом интервале меньшем, чем (e = 1).

Примеры.

Подсчитайте относительную энтропию непрерывного источника, имеющего следующий закон распределения плотности вероятности случайной величины X:

1.

Рис. 2.5

He(x) = 0.

2.

Рис. 2.6

He(x) = –1;

.

.

3.

Рис. 2.7

He(x) = 1;

.

.