- •План лекции

- •Постановка задачи оптимизации

- •Классификация методов минимизации

- •Прямые методы

- •Структура методов решения задач безусловной минимизации

- •Методы нулевого порядка

- •Метод покоординатного спуска (метод Гаусса –Зайделя)

- •Методы первого порядка

- •Метод наискорейшего спуска, метод градиента

- •Метод сопряженных направлений

- •Методы второго порядка

- •Метод Ньютона

- •Квазиньютоновские методы

Процессы массопереноса в системах c участием твердой фазы Часть 1. Методы оптимизации Лекция 3. Численные методы и алгоритмы безусловной оптимизации 2014 г. © Н.Н. Зиятдинов

План лекции

Постановка задачи оптимизации

Классификация методов решения задач минимизации

Структура методов решения задач безусловной минимизации

Методы многомерной безусловной оптимизации

Методы нулевого порядка.

Метод покоординатного спуска

Методы первого порядка

Метод наискорейшего спуска, метод градиента

Метод сопряженных направлений

Методы многомерной оптимизации. Методы второго порядка

Метод Ньютона

Квазиньютоновские методы

Общее правило выбора метода оптимизации

Постановка задачи оптимизации

Напомним общую постановку задачи оптимизации

![]() , (1)

, (1)

![]() – критерий

оптимальности

(целевая функция);

– критерий

оптимальности

(целевая функция);

![]() – вектор

варьируемых параметров;

– вектор

варьируемых параметров;

![]() – допустимая

область значений

– допустимая

область значений

![]() :

:

![]()

Если

![]() – семейство задач безусловной

оптимизации.

– семейство задач безусловной

оптимизации.

Если

![]()

![]() –

семейство

задач условной оптимизации.

–

семейство

задач условной оптимизации.

На прошлой лекции мы показали, что, используя функцию Лагранжа, задача условной оптимизации может быть сведена к задаче безусловной оптимизации.

Рассмотрим методы решения задач безусловной оптимизации.

Классификация методов минимизации

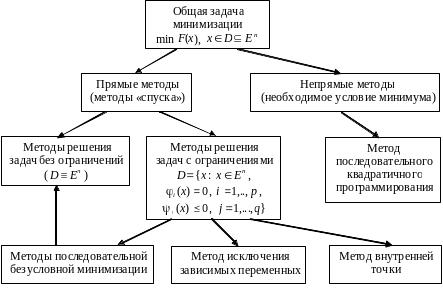

Методы решения задач минимизации можно разделить на две группы (рис. 1).

Первая группа: прямые методы, базирующиеся на непосредственном сравнении значений функции в соседних точках.

Вторая группа: непрямые методы, при использовании которых положение минимума определяется с помощью соответствующего необходимого условия.

В этой лекции мы рассмотрим прямые методы.

Рис. 1. Классификация методов решения задач минимизации

Прямые методы

Рассматриваемые

методы носят итерационный

характер,

т. е. представляют собой совокупность

определенных вычислительных процедур

с применением рекуррентных

формул,

результатом выполнения которых является

построение

конечной или бесконечной последовательности

точек

![]() ,

позволяющей с заданной точностью найти

минимум

,

позволяющей с заданной точностью найти

минимум

![]() .

.

Структура методов решения задач безусловной минимизации

Последовательность

![]() обладает свойством:

обладает свойством:

![]() (2)

(2)

Большинство

методов безусловной

минимизации

предусматривает построение

последовательности

![]() направлений движения к минимуму

.

направлений движения к минимуму

.

Основное

отличие

одного метода от другого заключается

в способе

построения

![]() .

При этом соседние точки последовательности

.

При этом соседние точки последовательности

![]() связаны соотношением (см. рис. 2)

связаны соотношением (см. рис. 2)

![]() (3)

(3)

где

![]() – параметр, определяющий длину

шага вдоль направления

– параметр, определяющий длину

шага вдоль направления

![]() ,

избираемую некоторым определенным

способом.

,

избираемую некоторым определенным

способом.

Вектор

«сдвига»

![]() в направлении

равен

в направлении

равен

![]() . (4)

. (4)

Таким

образом, выполнение одной

(![]() -ой)

итерации

(или шага)

в конкретном алгоритме спуска заключается

в определении направления

спуска

и

точки

-ой)

итерации

(или шага)

в конкретном алгоритме спуска заключается

в определении направления

спуска

и

точки

![]() на данном направлении.

на данном направлении.

Рис. 2.

Графическое изображение итерационного

шага

Рис. 2.

Графическое изображение итерационного

шага

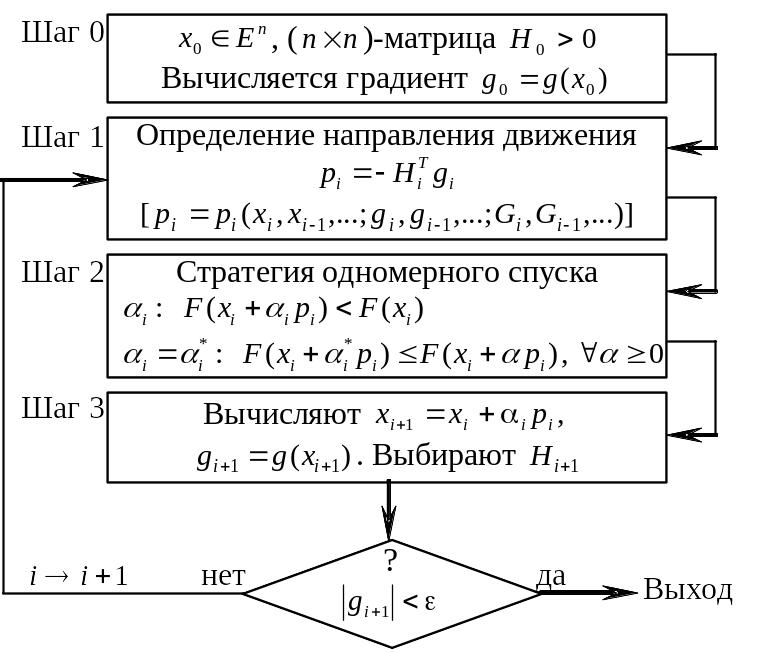

Структуру рассматриваемых далее методов безусловной минимизации можно представить следующей схемой (см. рис. 3).

Рис. 3. Структурная схема методов безусловной минимизации

Шаг

0.

Выбирается некоторая начальная точка

![]() и положительно определенная (

и положительно определенная (![]() )-матрица

)-матрица

![]() .

Выполняется расчет градиента

.

Выполняется расчет градиента

![]() минимизируемой функции в точке

минимизируемой функции в точке

![]() .

.

Шаг

1.

Даны: точка

![]() ,

вектор градиента

,

вектор градиента

![]() ,

(

)-матрица

,

(

)-матрица

![]() .

Определяется направление

.

Определяется направление

. (5)

. (5)

В

общем случае вектор направления

является

некоторой явной функцией точки

![]() ,

предыдущих точек

,

предыдущих точек

![]() ,

,

![]() ,…,

векторов градиентов

,…,

векторов градиентов

![]() ,

,

![]() ,…

минимизируемой функции

и матриц

,…

минимизируемой функции

и матриц

![]() ,

,

![]() ,…

ее вторых производных (матриц Гессе),

вычисленных в точках

,

,…,

т.е.

,…

ее вторых производных (матриц Гессе),

вычисленных в точках

,

,…,

т.е.

![]() . (6)

. (6)

В выражении (6) зависимость от некоторых групп переменных, например, , ,…, может отсутствовать.

Если существует явная зависимость от предыдущих точек , ,…, или величин, вычисленных в этих точках, то подобный поисковый метод называется методом с памятью. Если же вектор направления явно зависит лишь от величин, вычисленных в точках , то соответствующий метод называется методом без памяти.

В зависимости от максимального порядка производных, входящих в выражение (6), алгоритмы минимизации относятся соответственно к методам нулевого, первого и второго порядков.

Вектор

,

![]() обычно определяет

направление «спуска»,

т.е. убывания функции

.

Это означает, что производная функции

по направлению

отрицательна

обычно определяет

направление «спуска»,

т.е. убывания функции

.

Это означает, что производная функции

по направлению

отрицательна

![]() (7)

(7)

Достаточным условием выполнения этого условия является положительная определенность матриц .

Шаг 2. Рассматривается функция одной переменной

![]() (8)

(8)

и выбирается величина , определяющая шаг по направлению и удовлетворяющая условию:

![]() (9)

(9)

и некоторым другим требованиям. Например, если дополнительное условие для имеет вид

![]() (10)

(10)

то

говорят о точном

нахождении минимума функции

в направлении

.

Соответствующее

будем обозначать

![]() ,

а точку

,

а точку

![]() назовем

оптимальной в направлении

.

В некоторых случаях полагают

= const, если удовлетворяется условие (9).

назовем

оптимальной в направлении

.

В некоторых случаях полагают

= const, если удовлетворяется условие (9).

Шаг

3.

Рассчитываются точка

и (в градиентных методах) вектор

![]() ,

а затем формируется матрица

,

а затем формируется матрица

![]() .

.

В

зависимости от результата проверки

условия остановки

работа алгоритма либо прекращается (в

этом случае

с требуемой точностью является оптимальной

точкой), либо осуществляется переход к

шагу

1

(![]() ).

Условием

окончания

работы алгоритма обычно является

неравенство

).

Условием

окончания

работы алгоритма обычно является

неравенство

![]() ,

где

,

где

![]() – заданное число, или

– заданное число, или

![]() .

Используются также и другие условия

окончания, например,

.

Используются также и другие условия

окончания, например,

![]() вместе с

,

и т.д.

вместе с

,

и т.д.