- •26. Вс с вертикальной обработкой информации (на примере вс «omen»).

- •27. Возможные пути построения высокопроизводительных вс, отличных от фоннеймановского типа. Понятие семантического разрыва между структурой вс и реализуемой программой.

- •28. Организация тэговой памяти и оценка ее эффективности на примере мультипроцессорной вс Эльбрус.

- •Независимость программных средств от обрабатываемых данных. Программные средства реализованы только на логический уровень, поэтому:

- •29. Принцип вычислений на основе управления потоком данных. Машины потоков данных (мпд). Архитектура. Достоинства и недостатки мпд.

- •Данные хранятся в пакетах данных – в активных ячейках памяти. В активной памяти находятся пакеты, готовые к выполнению.

- •30. Принцип вычислений на основе графовой редукции. «Энергичные» и «ленивые» вычисления.

- •31. Редукционная машина «Алиса». Пример выполнения фрагмента программы.

- •П о сети связи передаются как готовые к выполнению, так и выполненные пакеты. Она объединяет три типа связи vgl. Функционирование машины на основе редукции, которая позволяет заполнять пакеты сети.

- •32. Редукционная g-машина. Пример выполнения фрагмента программы.

- •Параллельная редукция

- •33. Реализация принципа «сверхмультиобработки». Статический и динамический способ создания «общего кода».

- •34. Перспективы развития архитектур класса мрр (Massively Parallel Processor).

- •35. Показатели качества функционирования вс. Критерий Гроша. Критерий Минского. Двухпараметрический критерий. Проблемы достижения линейного роста производительности вс.

- •36. Вычислительные системы с векторной обработкой команд (структура). Диаграмма выполнения операций с векторной обработкой команд.

- •37. Перспективы развития vpp (Vector Parallel Processor).

- •38. Факторы, влияющие на снижение производительности в системах с векторной обработкой команд.

- •39. Принципы векторизации последовательных программ. Критерии оценки векторной архитектуры.

- •40. Организация многоуровневой параллельной обработки в супер-эвм.

- •41. Способы организации памяти в супер-эвм.

- •42. Супер-эвм фирмы Cray Research.

- •43. Супер-эвм фирмы Hitachi.

- •44. СуперЭвм фирмы Fujitsu.

- •45. СуперЭвм с комбинированной структурой.

- •46. Особенности перехода к параллельным вычислениям. Проблемы организации параллельных вычислений.

- •47. Концепция неограниченного параллелизма. Выявление микро- и макропараллелизма в алгоритмах.

- •48. Теоретические модели параллельных систем. Ячеечные автоматы Неймана. Пространственная машина Унгера.

45. СуперЭвм с комбинированной структурой.

46. Особенности перехода к параллельным вычислениям. Проблемы организации параллельных вычислений.

В основе GRID технология. Она позволяет объединить вычислительные мощности существующих систем в единую систему таким образом, что бы общее время решения всех предполагаемых задач сводилось к минимуму.

GRID система – некоторый виртуальный компонент, с помощью которого можно создать параллельную ВС. Фундамент этой технологии: многоядерность и нмогопотоковость. Для реализации этой технологии необходимо строить новые архитектура.

Особенности перехода к параллельным вычислениям:

Параллельный доступ к ресурсам

Синхронизация процессов и потоков данных и команд

Поддержка когерентности КЭШ.

Необходима аппаратная и программная модернизация:

Разработка параллельных компиляторов. Система должна обнаруживать момент создания параллельных потоков.

Разработка параллельных программных отладчиков.

Разработка стандартов многоядерности.

Создание соответствующих библиотек и систем распараллеливания.

Разработка стандартов:

Использование концепции обмена сообщениями (MPI)

Использование разделения памяти (Open MP)

Поддержка параллельных вычислений на основе обмена сообщений в разделяемой памяти или совместной. (POSIX) Т.е. должна быть реализована концепция интеллектуального управления вычислениями.

Для реализации параллельных систем производительность д.б. 1012-1014 оп/с

Увеличение количества параллельных систем должно сократить разрыв между пиковой и реальной производительностью.

Проблемы:

1. Разработка параллельных компиляторов.

2. Отладчики программ

3. Специальные библиотеки и системы распараллеливания для многоядерных систем.

4. Выбор критериев оценки параллельных систем

5. Сохранение работоспособности при изменении внешней среды

6. Разработка стандартов.

7. Описание задач

47. Концепция неограниченного параллелизма. Выявление микро- и макропараллелизма в алгоритмах.

В развитии вычислительной техники многое определяется стремлением повысить производительность и увеличить объем быстрой памяти.

На вычислительных системах параллельной архитектуры время решения задач решающим образом зависит от того, какова внутренняя структура алгоритма и в каком порядке выполняются его операции. Возможность ускоренной реализации алгоритма на параллельных системах достигается за счет того, что в них имеется достаточно большое число процессоров, которые могут параллельно выполнять операции алгоритма.

На любой вычислительной технике одновременно могут выполняться только независимые операции. Существует некая специальная форма представления алгоритма, в которой фиксируются как группы операций, так и их последовательность. Называется она параллельной формой алгоритма.

Зафиксируем входные данные и разделим все операции алгоритма на группы. Назовем их ярусами и пусть они обладают следующими свойствами. Во-первых, в каждом ярусе находятся только независимые операции. И, во-вторых, существует такая последовательная нумерация ярусов, что каждая операция из любого яруса использует в качестве аргументов либо результаты выполнения операций из ярусов с меньшими номерами, либо входные данные алгоритма.

Число операций в ярусе принято называть шириной яруса, число ярусов в параллельной форме - высотой параллельной формы.

Каждый алгоритм при фиксированных входных данных в общем случае имеет много параллельных форм. Формы, в которых все ярусы имеют ширину, равную 1, существуют всегда. Наибольший интерес представляют параллельные формы минимальной высоты, так как именно они показывают, насколько быстро может быть реализован алгоритм, по крайней мере, теоретически. По этой причине минимальная высота всех параллельных форм алгоритма называется высотой алгоритма.

Основные проблемы:

1. Выделение ярусов и прогноз их развития

2. Передача информации через ярусы.

Перспектива внедрения в практику параллельных вычислительных систем потребовала разработки математической концепции построения параллельных алгоритмов, т.е. алгоритмов, специально приспособленных для реализации на подобных системах. Такая концепция необходима для того, чтобы научиться понимать, как следует конструировать параллельные алгоритмы. Концепция начала активно развиваться в конце 50-х - начале 60-х годов прошлого столетия и получила название концепции неограниченного параллелизма.

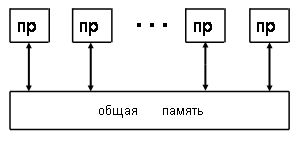

Истоки этого названия связаны с выбором для нее абстрактной модели параллельной вычислительной системы. Поскольку концепция разрабатывалась для проведения математических исследований, то в требованиях к модели могло присутствовать самое минимальное число технических параметров. Лишь быстрое развитие элементной базы подсказывало, что число процессоров в системе вскоре может стать очень большим. Но что-нибудь другое спрогнозировать было трудно. Поэтому явно или неявно в модели остались только следующие предположения. Число процессоров может быть сколь угодно большим, все они работают в синхронном режиме и за единицу времени выполняют абсолютно точно любую операцию из заданного множества. Процессоры имеют общую память. Все вспомогательные операции, взаимодействие с памятью, управление компьютером и любые передачи информации осуществляются мгновенно и без конфликтов. Входные данные перед началом вычислений записаны в память. Каждый процессор считывает свои операнды из памяти и после выполнения операции записывает результат в память. После окончания вычислительного процесса все результаты остаются в памяти.

Для математических исследований нет особого смысла усложнять модель параллельной вычислительной системы. Одна из схем абстрактной модели параллельной вычислительной системы представлена на рис.

Рис.

Абстрактная модель параллельной системы.

Рис.

Абстрактная модель параллельной системы.

Несмотря на то, что концепция неограниченного параллелизма предельно проста, она вполне приемлема для первого знакомства с параллельными вычислениями.