- •1. Основные направления в области систем ии, их характеристика.

- •2. Архитектура и свойства нс Back propagation. Функции активации.

- •3. Градиентный алгоритм обучения нс Back propagation(вр), его свойства.

- •4. Вывод рекурсивного соотношения для произвольного слоя сети вр. Организация вычислений компонент градиента в сети вр.

- •5. Модификация градиентного метода обучения.

- •6. Генетический алгоритм обучения нс вр и его свойства.

- •7. Метод сопряженных градиентов в обучении нс вр и его свойства.

- •8. Применение нс вр в задачах макроэкономичесого прогнозирования.

- •9. Нейронные сети с обратными связями. Нс Хопфилда и Хэмминга и ее свойства.

- •10. Самоорганизация в нейронных сетях. Нейронная сеть Кохонена.

- •13. Основные идеи и принципы мгуа

- •14. Поліноміальний алгоритм мгуа

- •15.Комбінаторний алгоритм мгуа

- •16. Алгоритм мгуа з послідовним виділенням трендів

- •17. Нечіткий метод групового обліку аргументів

- •22. Метод комплексирования аналогов в задачах прогнозирования случайных процессов.

- •23. Метод комплексирования аналогов в задачах прогнозирования случайных событий.

- •24. Классификация основных моделей обучения

- •25. Байесовский алгоритм обучения. Его свойства.

- •26. Вероятностные итеративные алгоритмы обучения. Условия сходимости.

- •27. Постановка задачи кластер-анализа. Критерии и метрики кластер-анализа.

- •28. Алгоритм мимовільної розбивки на незадане число класів

- •30. Агломеративний ієрархічний алгоритм кластер-аналізу

- •30.Общая характеристика задач распознования образов.

- •31.Этапы процесса распознавания. Классификация моделей и методов.

- •39. Классы структурированных моделей. Основные режимы изменений.

- •47. Алгоритм эра.

- •48. Применение алгоритма эволюционного моделирования эра в задачах классификации объектов по кривым.

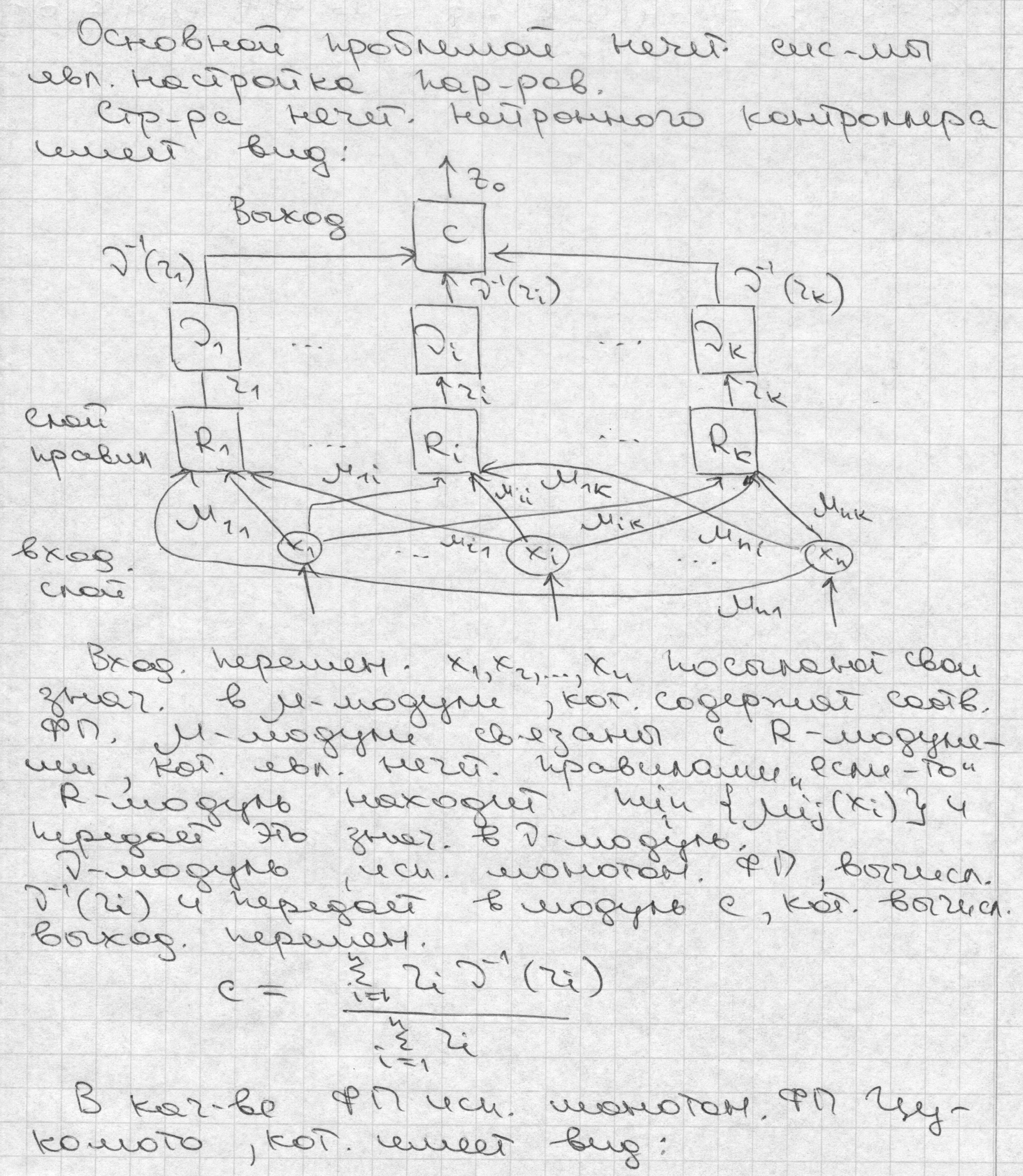

- •49.Загальна характеристика систем з нечіткою логікою. Лингвистические переменные и термы

- •50.Нечіткий метод групового обліку аргументів

- •51. Алгоритм Mamdani

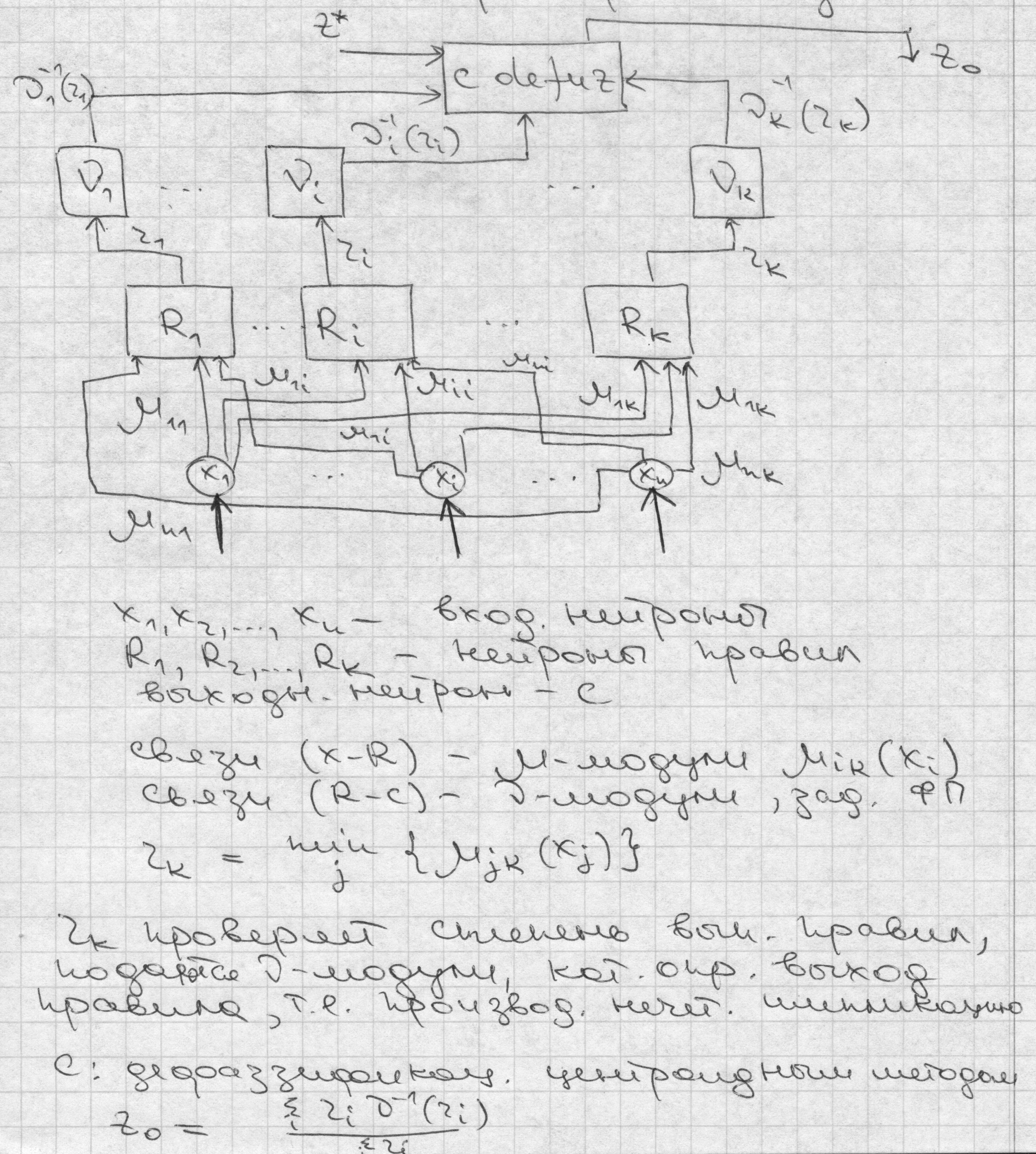

- •61. Нечеткая нс tsk и Менделя. Структура, функции слоев.

51. Алгоритм Mamdani

Даний алгоритм відповідає розглянутому прикладу на рис.3.15. У розглянутій ситуації він математично може бути описаний у такий спосіб [1]:

Введення нечіткості. Знаходяться ступені істинності для передумов кожного правила: А1(х0), А2(х0), В1(х0), В2(х0).

Логічний висновок. Знаходяться рівні “відсікання” для передумов кожного з правил (з використанням операції МІНІМУМ):

![]()

де

через “![]() ”

позначена операція логічного мінімуму

(min). Потім знаходяться “усічені” функції

належності:

”

позначена операція логічного мінімуму

(min). Потім знаходяться “усічені” функції

належності:

Композиція. Проводиться об’єднання знайдених усічених функцій з використанням операції МАКСИМУМ (mах, позначені далі як “

”),

що призводить до одержання підсумкової

нечіткої підмножини для змінної виходу

з функцією належності:

”),

що призводить до одержання підсумкової

нечіткої підмножини для змінної виходу

з функцією належності:

![]() .

.

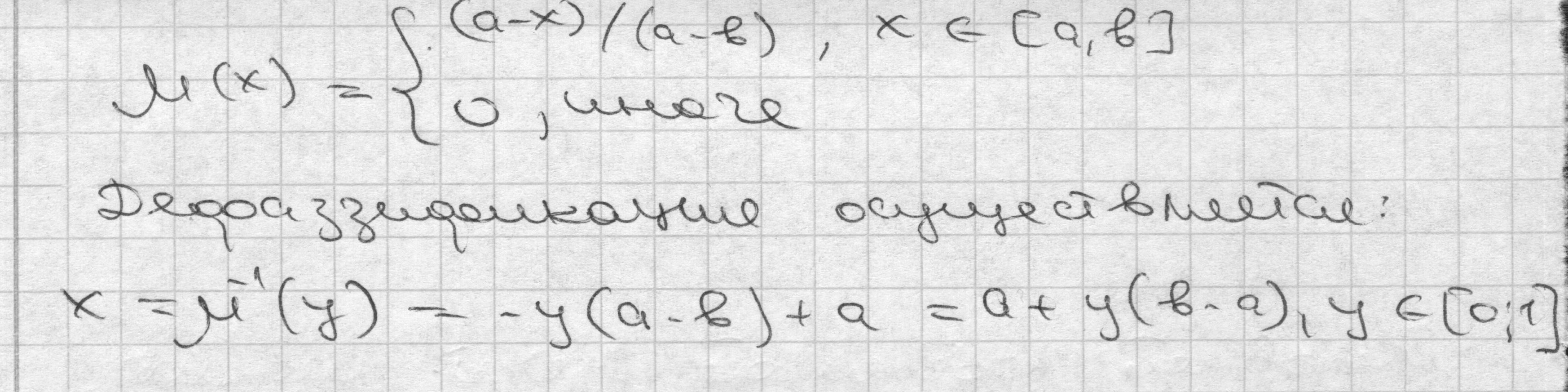

Приведення до чіткості. Проводиться для перебування z0, наприклад, центроїдним методом.

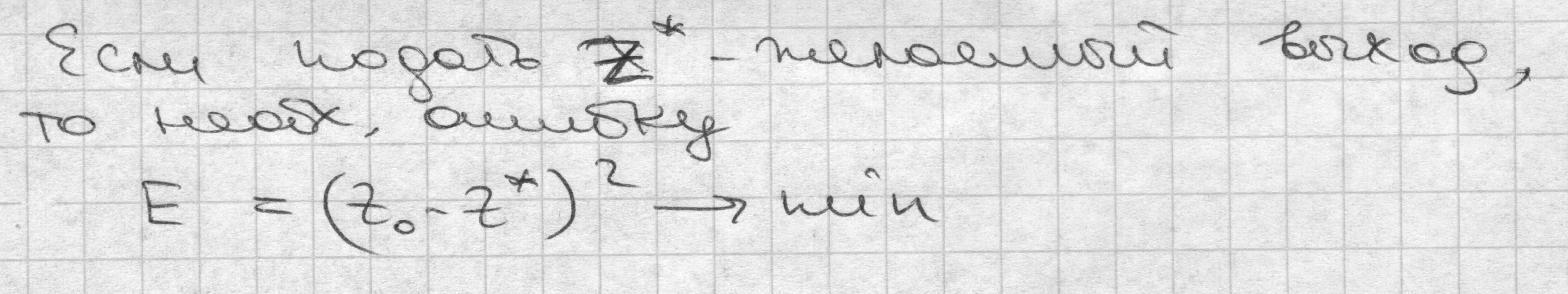

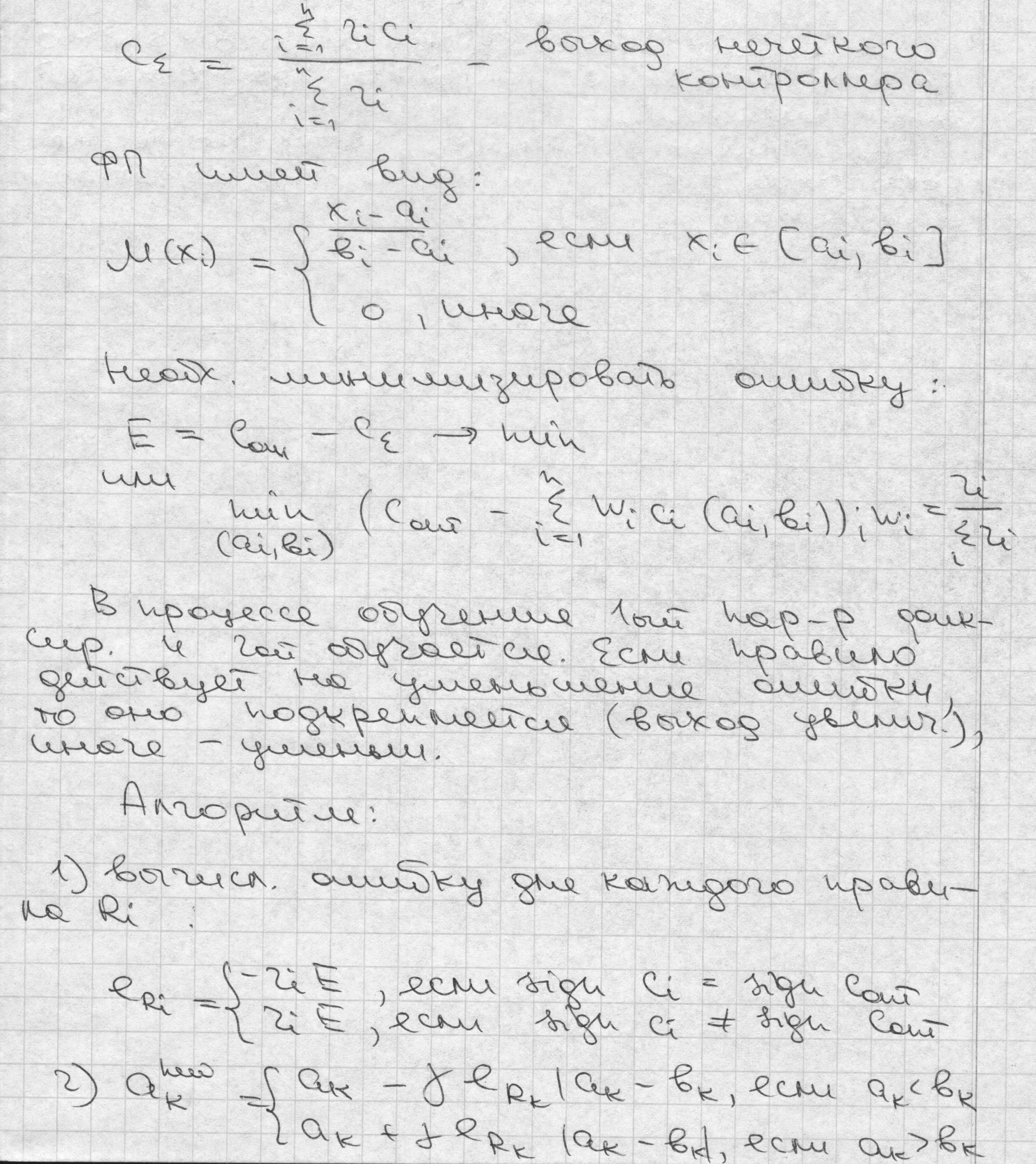

56. Нечеткий контроллер Мамдани.

57. Нечеткие нейронные сети(ННС). Нечеткий контроллер на основе ННС. Контроллер Цукамото.

58. Метод обратного распространения ошибки в нечетком контроллере

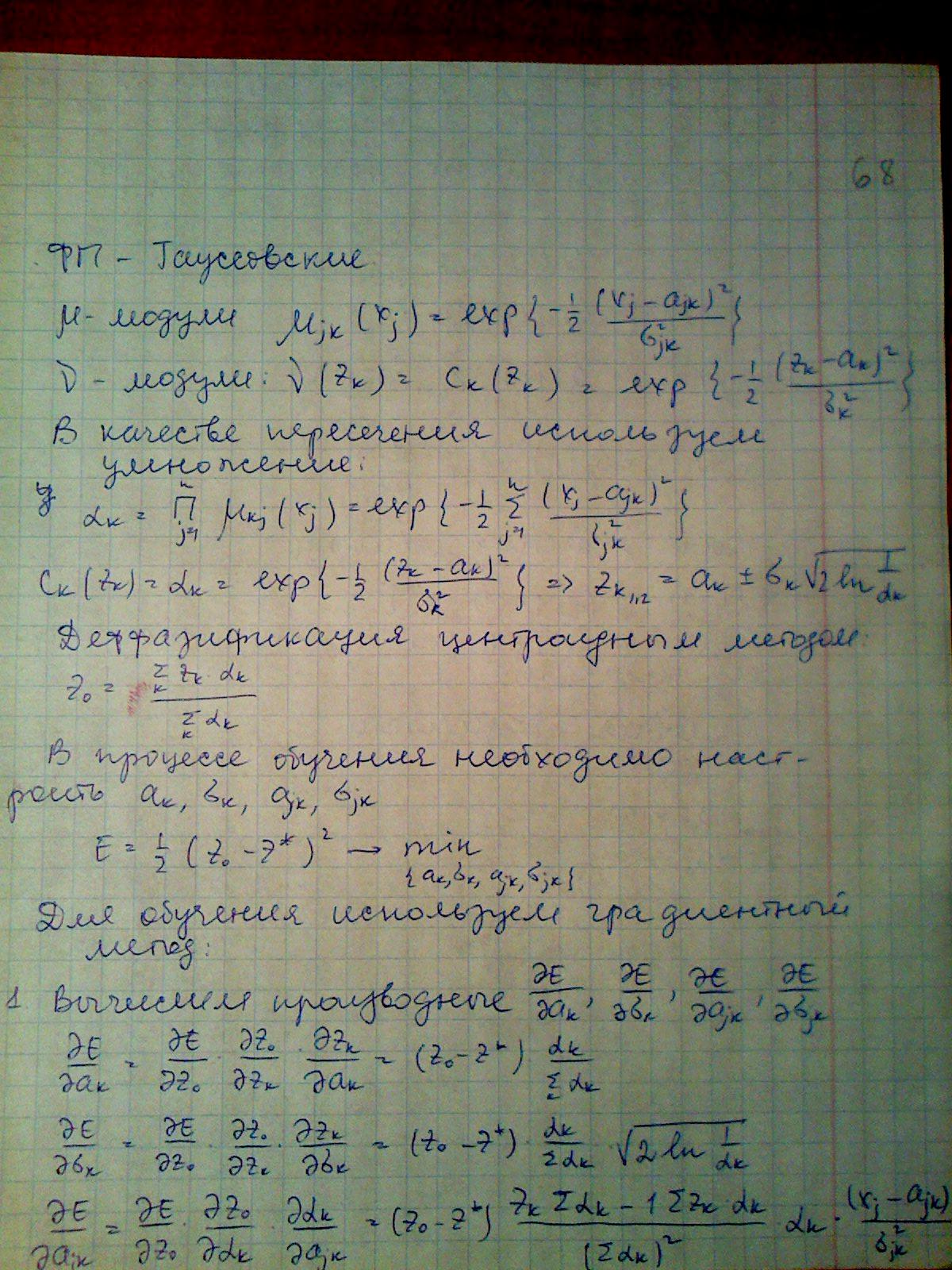

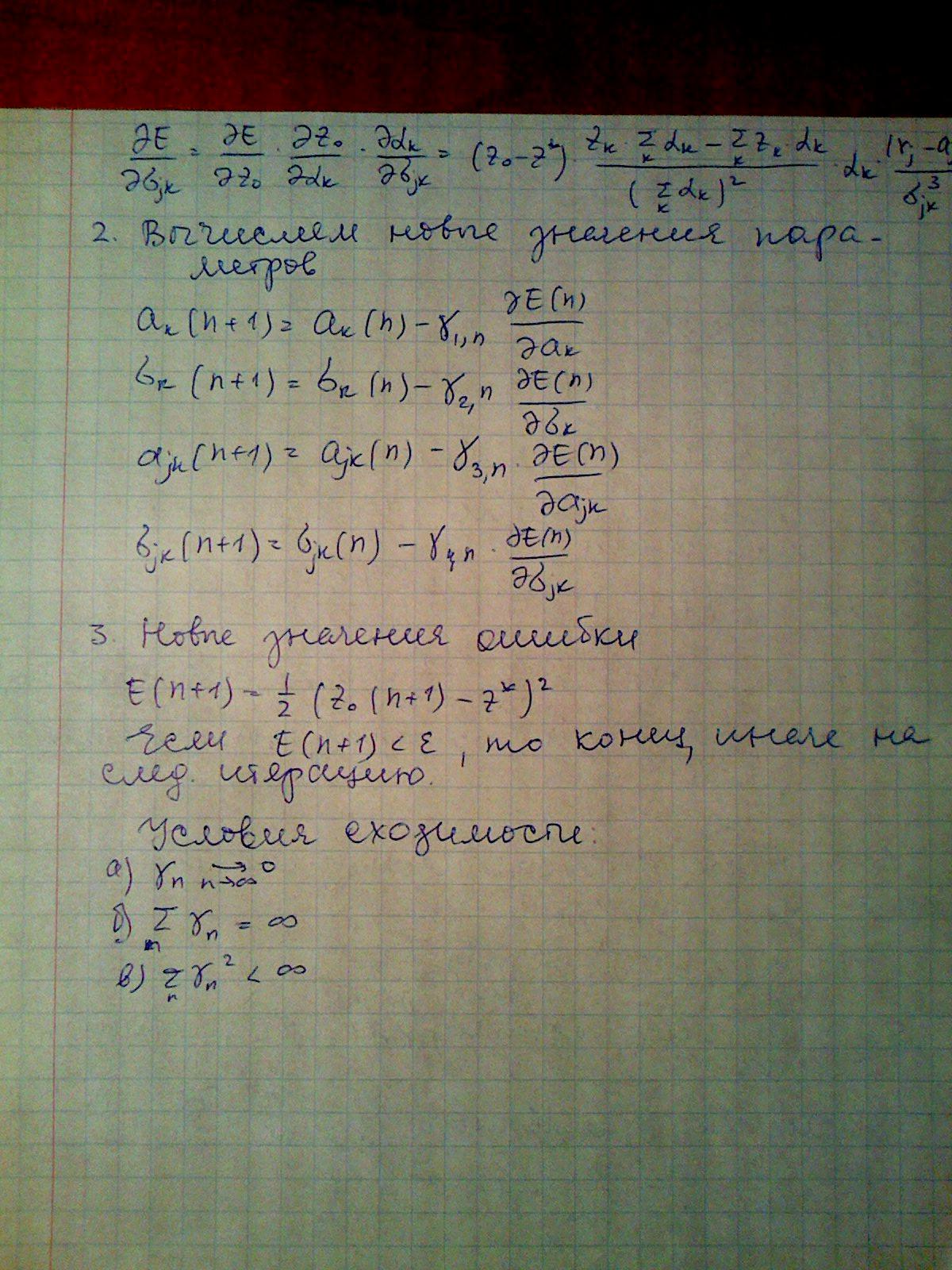

59. Настройки параметров функций принадлежности в НС

60. Нечеткая нейронная сеть ANFIS. Структура, алгоритм обучения. Применение нечеткой ННС ANFIS

ANFIS - гібридна система з механізмом логічного висновку запропонованого Сугено на базі правил ЯКЩО-ТО. Дана система може бути успішно використана для настройки функції належності та настройки бази правил в нечіткій експертній системі. Модель нечіткого висновку Сугено та структурна схема мережі ANFIS.

f1 =

a1 x

+ b1 y

+ r1  f

2= a2

x + b2

y + r2

f

2= a2

x + b2

y + r2

![]()

мережа ANFIS використовує наступну базу правил:

я кщо

х = А1 та у = В1 то f1

= a1x

+ b1y

+ r1

кщо

х = А1 та у = В1 то f1

= a1x

+ b1y

+ r1

якщо х = А2 та у = В2 то f 2= a2x + b2y + r2 , де Аi та Вi є лінгвістичними змінними.

Шари даної нечіткої нейронної мережі виконують такі функції:

Шар 1. Кожен нейрон даного шару є нейроном, що перетворює вхідний сигнал х чи у за допомогою функції належності (фазифікатор). Найчастіше використовують дзвіноподібну функцію (1) чи функцію Гауса (2)

(1)

(1)

(2)

(2)

Шар 2. Кожен нейрон в цьому шарі позначений як здійснює множення вхідних сигналів, моделюючи логічну операцію AND і посилає на вихід

![]() (3)

(3)

По суті, кожен нейрон представляє активуючу силу правила. (Фактично будь-який оператор Т-норми, що узагальнює операцію AND може бути використаний в даних нейронах).

Шар 3. Кожен нейрон в даному шарі обчислює нормовану силу правила:

![]() (4)

(4)

Шар 4. На даному шарі в нейронах формуються значення вихідних змінних:

![]() (5)

(5)

Шар 5. В

останньому шарі отримується вихідний

сигнал нейронної мережі та виконується

дефазифікація результатів:

(6)

(6)

Нейронна мережа архітектури ANFIS в даній роботі навчається за допомогою градієнтного методу. Нехай Х1 може приймати r лiнгвiстичних значень.

Х2

– k лiнгвiстичних

значень.

![]()

Створюється повна база правил - на всi можливi комбiнацii складається таблиця.

,

,

![]()

де y*- бажаний вихiд.

Алгоритм навчання НМ ANFIS

Нехай

![]() описується наступними параметрами:

описується наступними параметрами:

![]() - центр iнтервалу,

- центр iнтервалу,

![]() характеристика

ширини iнтервалу.

характеристика

ширини iнтервалу.

Градiєнтний алгоритм навчання

t+1

iтерацiя

-

розмiр

кроку.

-

розмiр

кроку.