- •Реферат

- •Содержание

- •1.Основная часть

- •1.1.Введение

- •1.2. Теоретическая часть: искусственные нейронные сети История возникновения

- •Общие принципы

- •Обучение нейронных сетей

- •Подходы к обучению

- •Обучение с учителем

- •Обучение без учителя

- •Методы обучения нейронных сетей с учителем Обучение однослойного персептрона

- •Метод обратного распространения ошибки

- •Градиентные методы

- •Эвристические методы

- •Методы обучения без учителя Обучение на основе корреляции

- •Сети pca

- •Сети ica

- •Сети с самоорганизацией на основе конкуренции

- •Алгоритм wta и сети Кохонена

- •Сети, решающие задачу распознавания образов

- •Когнитрон Архитектура

- •Обучение

- •Использование латерального торможения в обучении

- •Неокогнитрон

- •Архитектура

- •Структура слоев неокогнитрона Входной слой u0

- •Слой извлечения контраста ug

- •Обучение неокогнитрона

- •Обучение с учителем

- •Обучение без учителя промежуточных слоев

- •Обучение последнего слоя

- •Задача поиска образца на изображении

- •Структура Synapse (синаптическая связь)

- •Класс Neurolayer

- •Его наследники – классы cLayer и Slayer

- •Класс нейросети (Neuronet)

- •Преимущества и недостатки ооп-подхода

- •Производительность системы

- •Модификация системы

- •Производительность модифицированной системы

- •Алгоритм Создание сети

- •Расчет значений нейронов

- •Обработка данных

- •Обучение слоя s1 сети с учителем

- •Обучение слоя Sl без учителя

- •Обучение слоя sn

- •Поиск образцов на изображении

- •Анализ результатов Параметры реализованной системы

- •Быстродействие системы

- •Результат поиска на изображении

- •Применимость метода

- •Преимущества и недостатки системы

- •Дальнейшие возможности

- •2.ЭкономИческая часть

- •2.1. Введение

- •2.2. Сетевой график работ

- •Pert-анализ работ проекта

- •Дисперсия оценки сроков проекта

- •2.3. Затраты на создание проекта

- •Материальные затраты Расходные материалы

- •Затраты на электроэнергию

- •Заработная плата участников проекта

- •Социальные отчисления

- •Амортизационные отчисления

- •Прочие расходы

- •2.4. Выводы

- •3.Охрана труда и окружающей среды

- •3.1. Введение

- •Характеристики помещения

- •Оборудование

- •3.2. Анализ условий труда Санитарно-гигиенические факторы

- •Микроклимат

- •Освещение

- •Характеристики рабочего места

- •Электроопасность

- •Вибрация

- •Электромагнитные излучения

- •Эргономика рабочего места

- •Психофизиологические факторы

- •3.2. Расчет

- •Расчет эквивалентного шума и дозы для непостоянного шума

- •Вывод об уровне шума в помещении

- •3.3. Выводы

- •Заключение

- •Список использованных источников

- •Приложение Исходные коды основных классов

Сети ica

ICA (Independent Component Analysis, анализ независимых компонентов) также являются самоорганизующимися сетями на основе корреляции. Они используются обычно для обработки сигналов в режиме реального времени; исходно они разрабатывались для задачи так называемой слепой сепарации сигналов.

Задача,

решаемая сетью – получить приближения

сигналов sj(t)

в ситуации, когда известны только сигналы

xi(t), каждый из которых является

линейной суперпозицией сигналов sj(t):

![]() , причем коэффициенты aij

также неизвестны. Исходные сигналы

считаются статистически независимыми:

один не несет никакой информации о

другом.

, причем коэффициенты aij

также неизвестны. Исходные сигналы

считаются статистически независимыми:

один не несет никакой информации о

другом.

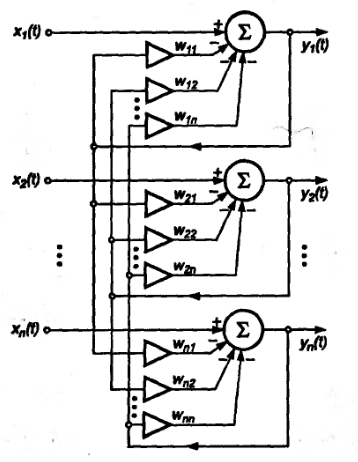

Существует рекуррентная схема сети, с зависимостью выходного сигнала нейрона от выходных сигналов других нейронов:

Для такой сети применяется обучение по формуле, представляющей собой нелинейное обобщение правила Хебба:

Параметрами обучения является скорость q(t), обычно убывающая до нуля в процессе обучения, а также нечетные функции f(y) и g(y), f(y)≠g(y). Обычно одна выпуклая, а другая вогнутая. Есть также модификации этой формулы, ускоряющие сходимость.

Рис. 1.5. Схема сети для разделения сигналов

Второй вариант – использование однонаправленных сетей.

Рис. 1.6. Схема однонаправленной сети разделения сигналов

В этой сети выходной сигнал нейрона формируется только из входных сигналов сети. Изменение весов производится по формуле Чихотского, либо одной из ее модифицированных версий.

Формула представлена в матричной форме, W – матрица весов.

Сети с самоорганизацией на основе конкуренции

Простейшая самоорганизующаяся сеть на основе конкуренции однослойна, все входные данные подаются на вход всем нейронам, таким образом, если входные данные имеют размерность N, у каждого нейрона есть N-мерный вектор связей. Победителем конкурентной борьбы при подаче на вход вектора x становится нейрон, чьи веса (после нормализации) наиболее близки к значениям компонент этого вектора. Для сравнения используются метрики расстояния между векторами, например евклидова мера:

Победитель, а также нейроны в его окрестности, обучаются по правилу Кохонена:

![]()

Здесь

Sw(k) – окрестность на итерации k;

qi(k) – скорость обучения нейрона i на итерации k;

wi – вектор весов нейрона i.

Размеры окрестности уменьшаются в процессе обучения. В процессе обучения веса нейронов в векторном пространстве сближаются, если нейроны реагируют на близкие векторы. Равенство wi=wj наступает тогда и только тогда, когда подаваемые этим нейронам векторы xi и xj совпадают или практически совпадают.

Для конкурентной борьбы характерной проблемой является слишком большой отрыв нейронов, уже становившихся победителями, и появление «мертвых» нейронов в областях, где недостаточная плотность обучающих векторов: такие нейроны имеют мало шансов на победу и их веса никогда не будут изменены. Для борьбы с этим используется механизм «утомления». Нейронам присваиваются потенциалы pi, и после победы нейрона его собственный потенциал уменьшается, а потенциалы окружающих возрастают. Если потенциал нейрона опустился ниже порогового значения, он не принимает участия в конкурентной борьбе, пока его потенциал снова не восстановится.