- •Искусственный интеллект. Основные направления и этапы развития.

- •Структура мозга. Уровни моделирования. Основные элементы моделей.

- •Виды функций активации

- •Классификация нейронных сетей

- •Применение нейронных сетей

- •Методика решения формализуемых задач в нейросетевом базисе

- •Настройка нейронной сети на решение прикладных задач

- •Обучение нс Основные понятия

- •Основные алгоритмы обучения нс без обратных связей

- •Персептронные алгоритмы обучения Алгоритм обучения по правилу Хебба

- •Алгоритм обучения Розенблатта

- •Процедура Уидроу-Хоффа

- •Обучение многослойной нейронной сети без обратных связей Математическая постановка задачи обучения

- •Алгоритм обратного распространения ошибки

- •Генетические алгоритмы оптимизации

- •Суть генетического алгоритма

- •Методы формирования популяции

- •Иллюстрация работы генетического алгоритма

- •Особенности реализации генетических алгоритмов

- •Модификация основных параметров га

- •Мобильные га

- •Динамическое изменение параметров в процессе выполнения га

- •Разновидности га

- •Применение генетического алгоритма к обучению многослойного персептрона

- •Рекуррентные и рециркуляционные сети

- •Сеть Хопфилда

- •Применение сети Хопфилда к решению задач комбинаторной оптимизации

- •Сеть Хемминга

- •Самоорганизующиеся нейронные сети Самоорганизация в нс

- •Конкурентное обучение

- •Сеть Кохонена

- •Алгоритмы кластеризации

- •Пороговый алгоритм

- •Алгоритм максимального расстояния

- •Алгоритм внутригруппового среднего (метод k-средних, k-means clustering, c-means clustering)

- •Алгоритм нечётких k-средних (fuzzy c-means clustering)

- •Алгоритм состязания процедур соединения и разделения.

- •Сети адаптивного резонанса

- •Основы адаптивного резонанса

- •Архитектура art

- •Комбинированные нс

- •Иерархический классификатор

- •Нейронные сети с функциональными связями

- •Решающие деревья

- •Методы проектирования нейросетевых архитектур для решения прикладных задач

- •Выбор топологии нс для решения задач нейроуправления

- •Практическое применение нс Управление движением робота по заданной траектории

- •Обучение и формирование обучающей выборки для управления мобильным роботом

- •Тестирование робота

- •Автономное управление мобильным роботом

Алгоритм обучения Розенблатта

Данный алгоритм был положен в основу обучения однослойных персептронов.

Структура персептрона Розенблатта представляется следующим образом:

S-нейроны (сенсорные) – предназначены для формирования входных сигналов; выполняют чисто распределительную функцию. Каждый сенсорный нейрон связан с одним или несколькими нейронами следующего слоя (ассоциативными нейронами), при этом каждый ассоциативный нейрон может быть связан с несколькими S-нейронами.

A-нейроны (ассоциативные) – предназначены для непосредственной обработки входных сигналов. Выходы ассоциативных нейронов соединены с входами нейронов третьего слоя.

R-нейроны (эффекторные) – предназначены для передачи сигналов к другим нейронам или сетям. Нейроны этого слоя имеют несколько входов (дендритов) и один выход (аксон), который возбуждается, если суммарная величина входных сигналов превосходит порог срабатывания (функция активации нейронов – пороговая).

Отличия алгоритма обучения Розенблатта от алгоритма обучения по правилу Хебба сводятся к следующему:

вводится эмпирический коэффициент α с целью улучшения процесса сходимости: α – скорость обучения

;

;исключены некоторые действия, которые замедляют процесс обучения, например, обновление весовых коэффициентов (update).

входные образы на вход НС подаются до тех пор, пока не будет достигнута допустимая величина ошибки обучения.

если решение существует, алгоритм обучения Розенблатта сходится за конечное число шагов.

Алгоритм обучения персептрона Розенблатта заключается в настройке коэффициентов межнейронных связей и порогов в слое A. На каждом шаге обучения, если необходимо, происходит обновление весовых коэффициентов в соответствии со следующей формулой.

![]() , (**)

, (**)

где t – номер такта; i – номер нейрона во входном слое; j – номер нейрона в слое A; α – скорость обучения; xi – входной сигнал; еj – ошибка обучения.

На каждом шаге обучения вычисляется ошибка обучения еj:

![]() ,

,

где dj – эталонное значение входного сигнала; yj – реальное значение входного сигнала.

Алгоритм обучения Розенблатта сводится к следующей последовательности действий:

Инициализация весовых коэффициентов и порогов значениями, близкими к нулю.

Подача на вход НС очередного входного образа (входного вектора Х), взятого из обучающей выборки, и вычисление суммарного сигнала по всем входам для каждого нейрона j:

,

где n – размерность

входного вектора, xi

– i-я компонента

входного вектора, wij

– весовой коэффициент связи нейрона

j и входа i.

,

где n – размерность

входного вектора, xi

– i-я компонента

входного вектора, wij

– весовой коэффициент связи нейрона

j и входа i.Вычисление значения выхода каждого нейрона:

![]() ,

где bj

– порог, соответствующий нейрону j

,

где bj

– порог, соответствующий нейрону j

Вычисление значения ошибки обучения для каждого нейрона .

Проводится модификация весового коэффициента связи по формуле (**).

Повторение пунктов 2 – 5 до тех пор, пока ошибка сети не станет меньше заданной

.

.

Особенности алгоритма обучения Розенблатта: должна быть задана скорость обучения α и ошибка обучения е.

Пример. Воспроизведение логической функции «И» с помощью НС. Обучение НС

производится в соответствии с алгоритмом обучения Розенблатта.

Значения сигналов – биполярные: 1 и -1. Задаём скорость обучения α = 1.

Инициализируем работу НС:

![]()

Вычисляем значение коэффициентов на каждом шаге:

, вычисляются аналогично.

![]()

Результаты вычислений сведём в таблицу.

-

шаг

x1

x2

x3

y

d

w11

w21

b

t

t+1

t+2

t+3

t+4

–

1

1

-1

-

–

1

-1

1

-

–

-1

-1

-1

-1

–

-1

1

1

-1

–

1

-1

-1

-1

0

2

0

2

2

0

2

4

2

2

0

-2

0

2

2

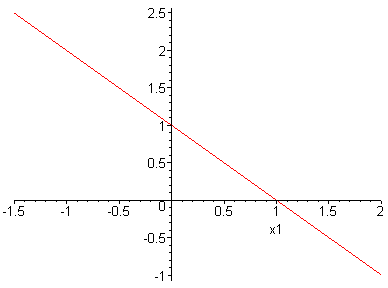

– дискриминантная линия

x

![]()