- •Искусственный интеллект. Основные направления и этапы развития.

- •Структура мозга. Уровни моделирования. Основные элементы моделей.

- •Виды функций активации

- •Классификация нейронных сетей

- •Применение нейронных сетей

- •Методика решения формализуемых задач в нейросетевом базисе

- •Настройка нейронной сети на решение прикладных задач

- •Обучение нс Основные понятия

- •Основные алгоритмы обучения нс без обратных связей

- •Персептронные алгоритмы обучения Алгоритм обучения по правилу Хебба

- •Алгоритм обучения Розенблатта

- •Процедура Уидроу-Хоффа

- •Обучение многослойной нейронной сети без обратных связей Математическая постановка задачи обучения

- •Алгоритм обратного распространения ошибки

- •Генетические алгоритмы оптимизации

- •Суть генетического алгоритма

- •Методы формирования популяции

- •Иллюстрация работы генетического алгоритма

- •Особенности реализации генетических алгоритмов

- •Модификация основных параметров га

- •Мобильные га

- •Динамическое изменение параметров в процессе выполнения га

- •Разновидности га

- •Применение генетического алгоритма к обучению многослойного персептрона

- •Рекуррентные и рециркуляционные сети

- •Сеть Хопфилда

- •Применение сети Хопфилда к решению задач комбинаторной оптимизации

- •Сеть Хемминга

- •Самоорганизующиеся нейронные сети Самоорганизация в нс

- •Конкурентное обучение

- •Сеть Кохонена

- •Алгоритмы кластеризации

- •Пороговый алгоритм

- •Алгоритм максимального расстояния

- •Алгоритм внутригруппового среднего (метод k-средних, k-means clustering, c-means clustering)

- •Алгоритм нечётких k-средних (fuzzy c-means clustering)

- •Алгоритм состязания процедур соединения и разделения.

- •Сети адаптивного резонанса

- •Основы адаптивного резонанса

- •Архитектура art

- •Комбинированные нс

- •Иерархический классификатор

- •Нейронные сети с функциональными связями

- •Решающие деревья

- •Методы проектирования нейросетевых архитектур для решения прикладных задач

- •Выбор топологии нс для решения задач нейроуправления

- •Практическое применение нс Управление движением робота по заданной траектории

- •Обучение и формирование обучающей выборки для управления мобильным роботом

- •Тестирование робота

- •Автономное управление мобильным роботом

Алгоритм нечётких k-средних (fuzzy c-means clustering)

Алгоритм предложен американским учёным Bezdek.

Fuzzy ISODATA

Т вёрдые

алгоритмы С-means

(CM)

вёрдые

алгоритмы С-means

(CM)

Hard C- means (HCM)

Основу алгоритма HCM составляет введение некоторой функции качества при заданных ограничениях.

Пусть U – матрица, определяющая принадлежность множества векторов X некоторым кластерам.

X1, X2, … , Xn – вектора множества X

q – число кластеров

Размерность матрицы U:

![]()

X |

q |

||||||

1 |

2 |

………………………… |

q |

||||

1 |

1 |

0 |

0 |

0 |

0 |

0 |

0 |

2 |

0 |

0 |

1 |

0 |

0 |

0 |

0 |

… |

1 |

0 |

0 |

0 |

0 |

0 |

0 |

n |

0 |

0 |

0 |

1 |

0 |

0 |

0 |

![]() ,

,

![]()

![]() ,

,

![]()

Общие ограничения:

1)

![]() (1)

(1)

2)

![]() (2)

(2)

3) ЦФ:

,

,

![]() (3)

(3)

Рассмотрим вариант нечёткой кластеризации:

Матрица принадлежности U может иметь следующий вид:

X |

q |

|||||

1 |

2 |

…………… |

(q-1) |

q |

||

1 |

0,1 |

0,2 |

0,08 |

|

0,3 |

0,5 |

2 |

0,3 |

|

|

0,02 |

0,42 |

|

… |

|

|

|

|

|

|

k |

0,1 |

0,4 |

|

|

|

0 |

… |

|

|

|

|

|

|

n |

0,001 |

0,08 |

|

|

|

0,9 |

Принадлежность векторов кластеру в

случае нечёткой кластеризации может

находиться в интервале:

![]() .

.

Вектор может относится к различным кластерам с разной степенью принадлежности (grade), но ограничение (1) остаётся справедливо.

Формула (3) сохраняется, а m изменяется

в интервале:

![]() .

.

Основная цель кластеризации: подбор центров Z1, Z2, … Zq с целью удовлетворения показателю (3) с учётом ограничений (1) и (2).

Для оптимизации целевой функции (3) Bezdek ввёл функцию Лагранжа:

(4)

(4)

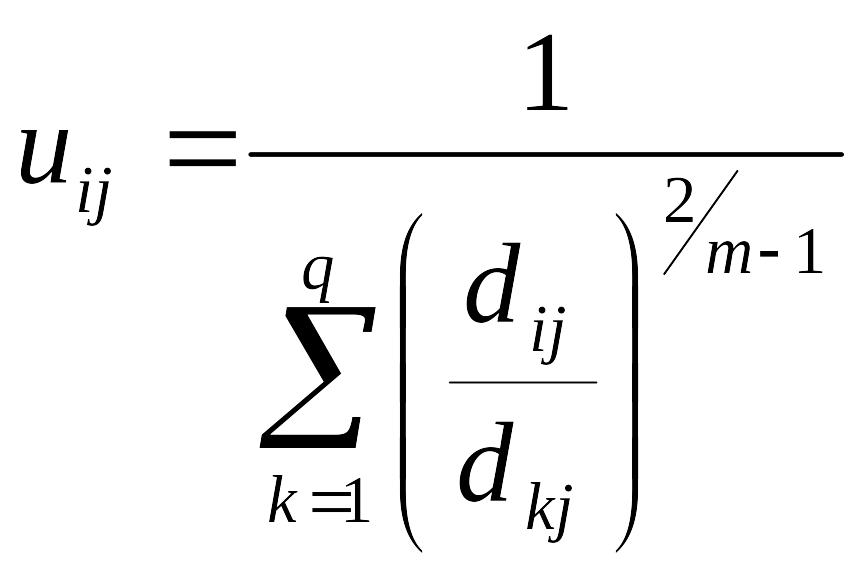

Bezdek доказал, что минимизация функции (4) осуществляется по следующим формулам:

(5)

(5)

(6)

(6)

В режиме off –line алгоритм fuzzy C-means сводится к следующей последовательности действий:

Инициализировать матрицу U случайным образом числами в интервале , при этом должны выполняться ограничения (1) и (2).

Вычислить q нечётких кластерных центров по формуле (5).

Вычислить стоимостную функцию по формуле (3).

Останов, если значение целевой функции J окажется ниже заданного порога или её уменьшение на предыдущем шаге ниже допустимого значения. В противном случае вычисляем значения

по формуле (6) и переходим к шагу 2.

по формуле (6) и переходим к шагу 2.

Замечание 1. Вместо инициализации матрицы U (шаг 1) могут инициализироваться кластерные центры.

Замечание 2. Алгоритм не даёт гарантии получения оптимального решения, поэтому начальная инициализация центров должна производиться с помощью других алгоритмов или с помощью приёма "мультстарт".