- •Принятие решений в условиях неопределенности и в условиях риска

- •Принятие решений в условиях неопределенности

- •Принятие решений в условиях риска

- •Стохастическое программирование

- •Вероятностные модели управления запасами

- •2.1. Одноэтапная модель управления запасами

- •Одноэтапная модель с учетом затрат на оформление заказа

- •Многоэтапная модель управления запасами

- •Управление запасами с учетом издержек на производство

- •3. Марковские цепи

- •Марковские цепи. Уравнение Колмогорова-Чэпмена

- •3.2 Марковские цепи с дискретным временем. Теорема о предельных вероятностях

- •3.3. Марковские цепи с непрерывным временем. Уравнения Колмогорова

- •Пуассоновский процесс

- •Простейший поток

- •Пуассоновский поток как марковский процесс. Немарковские потоки

- •Сложный пуассоновский процесс и процессы риска в страховой математике

- •Системы массового обслуживания

- •Марковские системы массового обслуживания

- •Процессы рождения и гибели. Одноканальная марковская смо с бесконечной очередью

- •Многоканальная марковская смо с ожиданием. Дисциплины взаимопомощи

- •Задача о ремонте станков

- •Немарковские модели смо

- •6. Марковские процессы принятия решений

- •6.1. Модели с конечным горизонтом планирования. Задача о замене оборудования

- •6.2. Задача о наилучшем выборе

- •Модели с бесконечным горизонтом планирования

- •7. Статистическое моделирование

- •7.1. Моделирование случайных величин

- •7.2. Моделирование случайных процессов в страховой и финансовой математике

- •Моделирование систем массового обслуживания

- •Статистический анализ данных. Методы уменьшения дисперсии

- •7.5. Метод Монте Карло марковских цепей. Метод отжига в задачах комбинаторной оптимизации

- •Приложение Сводка определений и теорем теории вероятностей и математической статистики

- •Литература

- •Оглавление

- •Глава 1. Принятие решений в условиях неопределенности и в условиях риска

- •Глава 2. Вероятностные модели управления запасами

- •Глава 3. Марковские цепи

- •Глава 4. Пуассоновский процесс

- •Глава 5. Системы массового обслуживания

- •Глава 6. Марковские процессы принятия решений

- •Глава 7. Статистическое моделирование

3.2 Марковские цепи с дискретным временем. Теорема о предельных вероятностях

В этом параграфе

мы будем считать, что время

принимает неотрицательные целые

значения:

![]() .Такие марковские цепи называются

марковскими цепями с дискретным временем.

.Такие марковские цепи называются

марковскими цепями с дискретным временем.

Используя соотношения Колмогорова-Чэпмена (3.3), мы можем видеть, что

![]() ,

(3.6)

,

(3.6)

где

![]() - матрица переходных вероятностей за

шагов (единиц времени). Разрешая это

рекуррентное соотношение, мы получаем,

что

- матрица переходных вероятностей за

шагов (единиц времени). Разрешая это

рекуррентное соотношение, мы получаем,

что

![]() .

(3.7)

.

(3.7)

Таким образом, для

вычисления матрицы переходных вероятностей

за

шагов достаточно задать матрицу

переходных вероятностей за один шаг и

затем возвести ее в

-ую

степень. Матрицу переходных вероятностей

за один шаг мы будем обозначать

![]() ,

,

![]() и будем называть ее матрицей переходных

вероятностей. Рассмотрим несколько

примеров.

и будем называть ее матрицей переходных

вероятностей. Рассмотрим несколько

примеров.

Пример 1. Случайное блуждание.

Пусть

![]() - последовательность независимых,

одинаково распределенных, целочисленных

случайных величин. Определим процесс

- последовательность независимых,

одинаково распределенных, целочисленных

случайных величин. Определим процесс

![]() как

как

![]()

![]() .

Марковость этого процесса видна из

соотношения

.

Марковость этого процесса видна из

соотношения

![]()

![]() .

В случае, когда случайные величины

.

В случае, когда случайные величины

![]() принимают значения +1 и -1 с вероятностью

принимают значения +1 и -1 с вероятностью

![]() ,

,

![]() ,

где

,

где

![]() ,

процесс случайного блуждания называется

простым случайным блужданием. Этот

пример играет важную роль в физике, но

с помощью процессов такого рода можно

также описывать поведение курсов акций

(под

понимается цена акции в момент времени

). В случае, когда множество состояний

,

процесс случайного блуждания называется

простым случайным блужданием. Этот

пример играет важную роль в физике, но

с помощью процессов такого рода можно

также описывать поведение курсов акций

(под

понимается цена акции в момент времени

). В случае, когда множество состояний

![]() ,

матрица переходных вероятностей для

простого случайного блуждания является

бесконечной. При некотором размышлении

можно научиться возводить такие матрицы

в произвольную степень. Но переходную

вероятность за

шагов в простом случайном блуждании

легко найти, не прибегая к возведению

бесконечной матрицы

в

-ую

степень. Пусть

,

матрица переходных вероятностей для

простого случайного блуждания является

бесконечной. При некотором размышлении

можно научиться возводить такие матрицы

в произвольную степень. Но переходную

вероятность за

шагов в простом случайном блуждании

легко найти, не прибегая к возведению

бесконечной матрицы

в

-ую

степень. Пусть

![]() .

Очевидно, что если

.

Очевидно, что если

![]() , то переход из

в

невозможен и

, то переход из

в

невозможен и

![]() .

Пусть, например,

.

Пусть, например,

![]() .

Чтобы попасть из состояния

в состояние

,

необходимо сделать

.

Чтобы попасть из состояния

в состояние

,

необходимо сделать

![]() шагов направо (в сторону увеличения

номера состояния), а оставшиеся

шагов направо (в сторону увеличения

номера состояния), а оставшиеся

![]() шагов - налево. При этом порядок совершения

шагов направо и налево не важен, и, кроме

того, если

не является целым числом, то

.

Отсюда мы получаем, что

шагов - налево. При этом порядок совершения

шагов направо и налево не важен, и, кроме

того, если

не является целым числом, то

.

Отсюда мы получаем, что

![]() .

.

Пример 2. Случайное блуждание с ограничениями (задача о разорении).

Игрок приходит в

казино с

рублями в кармане. В каждой игре он

выигрывает 1 рубль с вероятностью

и проигрывает один рубль с вероятностью

![]() .

Игрок уходит из казино , если его капитал

достигает величины

.

Игрок уходит из казино , если его капитал

достигает величины

![]() рублей или 0 рублей. Обозначим через

его капитал после

-ой

игры. Ясно, что последовательность

рублей или 0 рублей. Обозначим через

его капитал после

-ой

игры. Ясно, что последовательность

![]() образует марковскую цепь, причем

образует марковскую цепь, причем

![]() .

Множеством состояний этой цепи является

множество

.

Множеством состояний этой цепи является

множество

![]() .

Матрица переходных вероятностей размера

.

Матрица переходных вероятностей размера

![]() имеет вид

имеет вид

.

(3.8)

.

(3.8)

Заметим, что из любого состояния данной цепи можно с ненулевой вероятностью попасть в состояния 0 и , но из этих состояний выйти уже нельзя. Такие состояния называются поглощающими. Этот пример представляет собой случайное блуждание с ограничениями.

Пример 3. (ветвящийся процесс).

Пусть некоторый

вид биологических организмов может

иметь от каждой особи

потомков с вероятностью

![]() ,

,

![]() .

Обозначим через

.

Обозначим через

![]() количество этих организмов в 0-й момент

времени. Пусть

- количество организмов в

-ый

момент времени. Обозначим через

количество этих организмов в 0-й момент

времени. Пусть

- количество организмов в

-ый

момент времени. Обозначим через

![]() случайное количество потомков у

-ой

особи в

-м

поколении,

случайное количество потомков у

-ой

особи в

-м

поколении,

![]() .

Случайные величины

.

Случайные величины

![]() независимы между собой при разных парах

независимы между собой при разных парах

![]() .

Марковский характер процесса следует

из очевидной формулы

.

Марковский характер процесса следует

из очевидной формулы

![]() .

.

Такие марковские процессы называются ветвящимися процессами и они могут моделировать как процессы размножения в биологических популяциях, так и цепные реакции в ядерной физике.

Пусть имеется

марковская цепь с матрицей переходных

вероятностей

![]() .

Мы будем предполагать, что цепь конечна

и пусть в дальнейшем для определенности

.

Мы будем предполагать, что цепь конечна

и пусть в дальнейшем для определенности

![]() .

.

Определение 3.2.

Распределение вероятностей

![]() называется стационарным для данной

марковской цепи, если

называется стационарным для данной

марковской цепи, если

![]() ,

,

![]() (3.9)

(3.9)

Из этого определения

следует, что если начальное распределение

вероятностей состояний системы задается

стационарным распределением

![]() ,

,

![]() , то оно остается таким же для любого

, то оно остается таким же для любого

![]()

![]() ,

.

,

.

Если ввести

вектор-строку

![]() ,

то условие стационарности распределения

(3.9) перепишется в матричной форме как

,

то условие стационарности распределения

(3.9) перепишется в матричной форме как

![]() .

(3.10)

.

(3.10)

Таким образом, стационарное распределение вероятностей задается левым собственным вектором матрицы с собственным числом 1.

Система линейных

уравнений (3.9), задающих стационарное

распределение

![]() ,

является вырожденной ( в силу того, что

сумма элементов каждой строки матрицы

равна 1). Но если дополнить эту систему

условием нормировки

,

является вырожденной ( в силу того, что

сумма элементов каждой строки матрицы

равна 1). Но если дополнить эту систему

условием нормировки

![]() ,

,

то можно однозначно определить стационарное распределение .

Определение 3.3.

Марковская цепь

![]() называется эргодической, если существуют

не зависящие от начального распределения

и не зависящие от

величины

называется эргодической, если существуют

не зависящие от начального распределения

и не зависящие от

величины

![]() ,

,

![]() .

.

Вероятности

![]() называют предельными или финальными

вероятностями.

называют предельными или финальными

вероятностями.

Замечательным обстоятельством является то, что при некоторых условиях матрица переходных вероятностей имеет предел при , причем этот предел является матрицей, все строки которой совпадают со стационарным распределением . Эту теорему называют теоремой о предельных вероятностях или эргодической теоремой.

Пусть марковская

цепь обладает таким свойством, что

существует

![]() такое, что все элементы матрицы

такое, что все элементы матрицы

![]() положительны. Определим величину

положительны. Определим величину

![]() ,

(3.11)

,

(3.11)

которая называется коэффициентом эргодичности.

Заметим, что для

марковской цепи с конечным множеством

состояний из строгой положительности

матричных элементов матрицы

следует, что коэффициент эргодичности

![]() .

Не все марковские цепи обладают таким

свойством. Например, если матрица

переходных вероятностей

.

Не все марковские цепи обладают таким

свойством. Например, если матрица

переходных вероятностей

![]() ,

,

то

![]() совпадает с единичной матрицей при

четных

и с матрицей

при нечетных

и поэтому при любом

матрица

содержит нулевые матричные элементы.

совпадает с единичной матрицей при

четных

и с матрицей

при нечетных

и поэтому при любом

матрица

содержит нулевые матричные элементы.

Теорема 3.1 (теорема о предельных вероятностях). Пусть для конечной марковской цепи существует такое, что матричные элементы матрицы положительны. Тогда существуют пределы

![]() ,

,

![]() ,

(3.12)

,

(3.12)

Другими словами, марковская цепь является эргодической.

Доказательство. Обозначим

![]() ,

,

![]() .

.

Поскольку

![]() ,

,

то из того, что

![]() при любом

следует

при любом

следует

![]() .

Значит

.

Значит

![]() .

.

Отсюда следует,

что существуют пределы последовательностей

![]() и

и

![]() при

.

Наша цель состоит в том, чтобы доказать

равенство этих пределов.

при

.

Наша цель состоит в том, чтобы доказать

равенство этих пределов.

Пусть

![]() и

- произвольные состояния. Запишем, что

и

- произвольные состояния. Запишем, что

![]()

![]() ,

,

где суммирование

![]() ведется по таким

,

для которых

ведется по таким

,

для которых

![]() ,

а

,

а

![]() ведется по таким

,

для которых

ведется по таким

,

для которых

![]() .

Отсюда следует, что

.

Отсюда следует, что

![]()

![]()

![]() .

.

Значит,

![]() ,

где

,

где

![]() задается (3.11). Заметим, что

задается (3.11). Заметим, что

![]()

![]() .

.

Поэтому для любого

![]()

![]()

![]()

![]()

=![]()

=![]() .

.

Отсюда получаем, что

![]() ,

,

![]() .

.

Поскольку

![]() ,

последовательность

,

последовательность

![]() монотонно возрастает, последовательность

монотонно возрастает, последовательность

![]() монотонно убывает и

монотонно убывает и

![]() ,

то

,

то

![]() .

.

Значит,

последовательности

и

,

а следовательно и последовательность

![]() имеют один и тот же предел, который мы

обозначим

имеют один и тот же предел, который мы

обозначим

![]() :

:

![]() ,

,

![]() .

.

Покажем, что

предельные вероятности

,

![]() образуют стационарное распределение

вероятностей. Перейдя в уравнениях

образуют стационарное распределение

вероятностей. Перейдя в уравнениях

![]()

к пределу по

![]() ,

получаем

,

получаем

![]() .

.

Кроме того

![]() .

.

Значит, величины

,

![]() действительно образуют стационарное

распределение вероятностей. Теорема

доказана.

действительно образуют стационарное

распределение вероятностей. Теорема

доказана.

Из этой теоремы

следует, что для любого начального

распределения вероятностей

![]() ,

,

![]() безусловные вероятности

безусловные вероятности

![]() стремятся к

:

стремятся к

:

![]()

![]() .

.

Отсюда, в частности,

следует единственность стационарного

распределения

![]() .

Предельную вероятность

можно интерпретировать как вероятность

обнаружить систему в состоянии

при больших

.

Действительно, пусть

.

Предельную вероятность

можно интерпретировать как вероятность

обнаружить систему в состоянии

при больших

.

Действительно, пусть

![]() -

случайный момент времени, равномерно

распределенный по множеству значений

-

случайный момент времени, равномерно

распределенный по множеству значений

![]() ,

,

![]() ,

,

![]() ,

причем случайная величина

не зависит от случайных величин, задающих

нашу марковскую цепь. Пусть

,

причем случайная величина

не зависит от случайных величин, задающих

нашу марковскую цепь. Пусть

![]() .

Тогда

.

Тогда

![]()

![]() .

(3.13)

.

(3.13)

Из доказательства теоремы следует, что

![]() ,

(3.14)

,

(3.14)

а также то, что для

любого начального распределения

![]()

![]() ,

(3.15)

,

(3.15)

![]() .

.

Утверждение

эргодической теоремы справедливо и для

марковской цепи со счетным множеством

состояний. Для справедливости утверждения

в общем случае надо сразу потребовать,

чтобы при некотором

![]() коэффициент эргодичности

коэффициент эргодичности

![]() ,

задаваемый формулой (3.11), был положительным.

,

задаваемый формулой (3.11), был положительным.

Что может служить

препятствием к существованию предельных

вероятностей? Рассмотрим пример

марковской цепи с множеством состояний

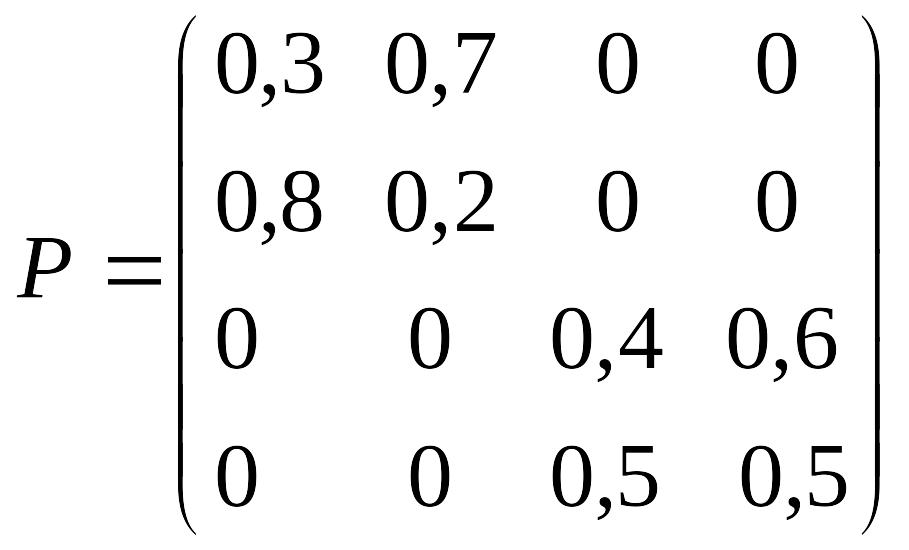

![]() и матрицей переходных вероятностей

и матрицей переходных вероятностей

.

.

Если начальное

состояние

![]() ,

то в пределе получится стационарное

распределение

,

то в пределе получится стационарное

распределение

![]() ,

а если

,

а если

![]() ,

то в пределе марковская цепь «выйдет»

на стационарное распределение

,

то в пределе марковская цепь «выйдет»

на стационарное распределение

![]() .

Множество состояний этой цепи разбито

на подмножества

.

Множество состояний этой цепи разбито

на подмножества

![]() и

и

![]() .

Нельзя перейти из состояний множества

.

Нельзя перейти из состояний множества

![]() в состояния множества

в состояния множества

![]() и наоборот.

и наоборот.

Мы говорим, что

состояние

достижимо из состояния

,

если существует такое

,

что

![]() .

Если состояние

достижимо из состояния

и состояние

достижимо из состояния

,

то состояния

и

называются сообщающимися. Если все

состояния в множестве

являются сообщающимися, то марковская

цепь называется неразложимой.

.

Если состояние

достижимо из состояния

и состояние

достижимо из состояния

,

то состояния

и

называются сообщающимися. Если все

состояния в множестве

являются сообщающимися, то марковская

цепь называется неразложимой.

Другой пример неэргодического поведения задается матрицей

.

.

Множество состояний

этой цепи разбивается на подмножества

![]() и

и

![]() .

Мы наблюдаем некоторую периодичность:

за нечетное число шагов цепь переходит

из состояний множества

в состояния множества

и наоборот. Такие цепи называются

периодическими. Дадим точные определения.

.

Мы наблюдаем некоторую периодичность:

за нечетное число шагов цепь переходит

из состояний множества

в состояния множества

и наоборот. Такие цепи называются

периодическими. Дадим точные определения.

Состояние

имеет период

![]() ,

если

является наибольшим числом таким, что

,

если

является наибольшим числом таким, что

![]() только для

,

кратных

только для

,

кратных

![]() .

Другими словами,

является наибольшим общим делителем

чисел

таких, что

.

Если

.

Другими словами,

является наибольшим общим делителем

чисел

таких, что

.

Если

![]() для всех

для всех

![]() ,

то

,

то

![]() .

Состояние

называется апериодическим, если

.

Состояние

называется апериодическим, если

![]() .

.

Можно показать, что все состояния неразложимой марковской цепи имеют один и тот же период и поэтому можно говорить о периоде неразложимой марковской цепи. Если этот период больше 1, то цепь называется периодической, а если он равняется 1, то цепь называется апериодической.

Можно доказать, что конечная неразложимая апериодическая марковская цепь эргодична.