- •1. Парето-оптимальные решения многокритериальных задач и способы сужения границы Парето: субоптимизация, лексикографическая оптимизация, построение обобщенного критерия.

- •2. Метод анализа иерархий (метод Саати): определение значимости критериев, согласованность матрицы парных сравнений, определение весовых коэффициентов методом собственного вектора.

- •3. Критерии принятия решений в условиях неопределенности: методы Лапласа, Вальда, Сэвиджа, Гурвица.

- •4. Обобщенный критерий Гурвица для безопасной и опасной ситуаций.

- •Формализация ситуации риска, принципы доминирования.

- •6. Меры риска, масштабные и вероятностные.

- •7. Критерии принятия решений в условиях риска: ожидаемого значения (критерий Байеса), минимальной вариации, предельного уровня, наиболее вероятного исхода.

- •8. Критерий «ожидаемое значение – вариабельность результата», коэффициент склонности к риску, зоны склонности к риску.

- •9. Понятие кривой безразличия. Три типа кривых безразличия.

- •10. Понятие идеального эксперимента, обоснование его целесообразности.

- •11. Понятие неидеального эксперимента, алгоритм обоснования его целесообразности.

- •12. Смешанные стратегии как инструмент уменьшения риска.

- •13. Понятие функции полезности, алгоритм ее построения. Основные типы функций полезности.

- •14. Интенсивность несклонности к риску, премия за риск (подход Марковица).

- •15. Формула Эрроу-Пратта.

- •16. Понятие многошагового управляемого процесса. Формализация многошаговой детерминированной задачи принятия решения.

- •17. Характерные особенности многошаговых процессов принятия решений. Принцип оптимальности Беллмана.

- •18. Марковские процессы с дискретными состояниями. Формула Колмогорова-Чепмена.

- •19. Марковские процессы принятия решений с конечным числом этапов: метод итераций по стратегиям и его возможные обобщения.

- •20.Марковские процессы принятия решений с бесконечным числом этапов: специфика постановки задачи. Отыскание оптимальных стратегий на бесконечном временном горизонте методом полного перебора.

- •21. Метод итераций по стратегиям без дисконтирования (для бесконечного числа этапов).

- •22. Случайные процессы с непрерывным временем, их формализация. Система дифференциальных уравнений Колмогорова, правила ее составления.

- •23. Потоки событий, их свойства. Простейший (пуассоновский стационарный) поток.

- •24. Вероятностные характеристики простейшего потока.

- •25. Роль экспоненциального распределения в исследовании простейших потоков. Финальные состояния системы, в которой протекает марковский процесс.

- •26. Процессы гибели и размножения, финальные вероятности состояний.

- •27. Процессы гибели и размножения в системе с m узлами, финальные вероятности состояний.

- •28. Системы массового обслуживания, их основные компоненты и характеристики функционирования.

- •29. Многоканальные системы массового обслуживания с отказами.

- •30. Одноканальные системы массового обслуживания с ожиданием и ограничением на длину очереди.

20.Марковские процессы принятия решений с бесконечным числом этапов: специфика постановки задачи. Отыскание оптимальных стратегий на бесконечном временном горизонте методом полного перебора.

На бесконечном временном горизонте в форме максимизации полного ожидаемого дохода смысла не имеет: он автоматически становится бесконечным, нужно делать дополнительные предположения о стабилизации процессов. Марковские процессы и обладают тем свойством, что стабилизируются с течением времени. Последнее проявляется в том, что вероятности состояний стремятся к некоторым пределам, после чего система функционирует в установившемся режиме.

При определении оптимальной долгосрочной стратегии марковская задача принятия решений может основываться на оценке результата за переходный период. Однако более естественной является постановка задачи в форме оптимизации результата за один период после того, как система перешла в установившейся режим. Рассматриваются лишь стационарные стратегии, когда выбор управляющего воздействия не зависит от номера этапа, а опр лишь текущим состоянием системы.

Существует два основных метода решения задач с бесконечным временным горизонтом. Первый основан на переборе всех стационарных стратегий. Однако использовать его можно лишь при небольшом числе состояний системы и, как следствие, небольшом количестве стационарных стратегий. При использовании второго метода (итеграции по стратегиям) возникают вычислительные сложности.

Метод полного перебора

Суть: рассматриваются все возможные стационарные стратегии. Каждая из них количественно оценивается средним ожидаемым результатом за один период, сопоставлением найденных оценок выбирается способ действия.

Q – стац стратегии

Pq,Rq – матрицы переходных вероятностей и результатов.

Действие алгоритма сводится к 4 шагам:

По заданным матрицам Pq и Rq находят средний ожидаемый доход за один этап для каждого i-ого состояния системы.

Viq=

По данной матрице находим финальные состояния системы из матричного уравнения системы Pq

q=

q,

q=(

q1,

2q….)

q=

q,

q=(

q1,

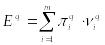

2q….)находят ожидаемый выигрыш за i – этап: Eq.

После

выполнения этого алгоритма для всех

стационарных стратегий получают набор

Е1,

Е2,

…, Еq

ожидаемых результатов, из которых и

выбирается оптимум.

После

выполнения этого алгоритма для всех

стационарных стратегий получают набор

Е1,

Е2,

…, Еq

ожидаемых результатов, из которых и

выбирается оптимум.Сопоставляем оценки, выбираем

21. Метод итераций по стратегиям без дисконтирования (для бесконечного числа этапов).

При рассмотрении метода динамического программирования на конечном числе этапов была получена формула, позволяющая оценить каждую стационарную стратегию с номером q.

Для того, чтобы применить эту формулу на бесконечном временном горизонте необходимо несколько модифицировать ее. Пусть eta количество этапов, которые остались для анализа

В полной теории марковских процессов установлено, что приближенно находится

Алгоритм Ховарда состоит из двух последовательно повторяемых шагов.

Шаг 1 – этап оценивания параметров. Выбрать произвольно стационарную стратегию с номером q в качестве начальной. Используя матрицы , отвечающие данной стационарной стратегии составить систему линейных уравнений.

Эта

система является неопределенной, в том

смысле, что содержит m

уравнений и m+1

переменную. Для того, чтобы замкнуть

систему одну из переменных выбирают

произвольно. Обычно полагают

остальные

значения из системы находятся однозначно.

остальные

значения из системы находятся однозначно.

Шаг

2 – улучшение

стратегии. Для каждого состояния системы

xi находим управленческую альтернативу

U,

обеспечивающую оптимум opt{ }

где в качестве fq(xk)

берется значение, полученное на шаге

оценивания параметров.

}

где в качестве fq(xk)

берется значение, полученное на шаге

оценивания параметров.

В совокупности найденные управленческие альтернативы формируют новую стационарную стратегию. При совпадении двух последовательно полученных стационарных стратегий, она и считается оптимальной. В противном случае переходят к шагу один с новой стационарной стратегией.

Шаг 3: Если 2 последовательные стационарные стратегии совпали, то найдется стационарная стратегия, являющаяся оптимальной. В противном случае полагается q=t и переходят к шагу 1 с новой стационарной стратегией.