- •Основная (фундаментальная) задача теории оптимизации и ее 4 части.

- •Основные понятия о системах оптимального управления.

- •Основные типы критериев оптимальности.

- •Классификация оптимальных систем. Определение характеристического критерия, как необходимое условие для применения оптимизационных методов.

- •Определение математической модели технической системы, как необходимое условие для применения оптимизационных методов.

- •Формулировка задачи условной оптимизации с ограничениями.

- •Формулировка задачи безусловной оптимизации.

- •Задачи оценки состояния системы, общие сведения об эстиматорах.

- •Система асимптотической оценки вектора состояния системы, структурная схема.

- •Оптимизация стабилизирующей ос. Интегральный критерий качества и его минимизация.

Формулировка задачи условной оптимизации с ограничениями.

Задача

общего вида: Минимизировать f(x)

при ограничениях hk(x)=0,

где k=1,2,…,k;

gj(x)>=0

j=1,2,…,j ;

![]()

функция f(x) называется целевой функцией, уравнение вида hk(x)=0 называется ограничением в виде равенств, - ограничения сверху и снизу, а g(x)>=0 ограничением в виде неравенств.

Задача, в которой присутствуют ограничения j, k,

называется оптимизационной задачей с ограничениями или задачей условной оптимизации с ограничениями.

Классификация:

1)Если ограничения заданы линейными функциями, то независимо от вида целевой функции, задача называется оптимизационной задачей с линейными ограничениями.

2)Если задача содержит линейную целевую функцию, то она будет задачей линейного программирования.

3)Задачи, в котор. компоненты вектора X принимают только целые значения, называется задачей целочисленного программирования.

4)Задача с нелинейной целевой функцией f(x) и линейными ограничениями называется задачей нелин. программирования с линейными ограничениями.

5)f(x) – квадратичная -> задача квадратичного программирования.

6)f(x) задана отношением линейных функций -> задача дробно-линейного программирования.

Формулировка задачи условной оптимизации с ограничениями.

f(x) – цел.ф-ция (Крит. опт-ции)

hk(x)=0 – ограничения в виде неравенств

gj(x) – ограничения в виде неравенств.

Предполагается что все ф-ции вещественные, а число ограничений конечно.

Задача с ограничениями (усл. опт-ции):

Минимиз-ть

ф-цию f(x)

при ограничениях:![]()

Формулировка задачи безусловной оптимизации.

Все задачи оптимизации м. классифицировать, как задачи min некой веществ-ой целевой ф-ии f(x) некоего N-мерного вектора-аргумента X=(x1,x2..xn) компоненты которого удовлетворяют системе уравнений hk(x)=0 и набору нерав-тв qi(x)≤0 , а также ограниченное сверху и снизу Xjв≥Xj≥Xjн.

hk(x)=0 – ограничение в виде равенств; qi(x)≤0 – огр. в виде неравенств.

Задачи в которых ограничения отсутствуют j=k=0 и Xjв= -Xjн= ∞ при

j=1,2...N – называются оптимизац-ми задачами без ограничений или задачами безусловной оптимизации.

Формулировка задачи безусловной оптимизации.

f(x) – цел.ф-ция (Крит. опт-ции)

hk(x)=0 – ограничения в виде неравенств

gj(x) – ограничения в виде неравенств.

Задача

без ограничений (безусл. опт-ции):

минимиз-ть ф-цию f(x)

при отсутсвии ограничений, если k=j=0

и

![]() ,

где i=1,2,…N.

,

где i=1,2,…N.

Задачи оценки состояния системы, общие сведения об эстиматорах.

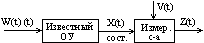

Известная с-а рассматр-ся с учетом случайных вх. воздействий (шумов) W(t) и шумов измерения V(t) так, что измеренный вых. cигнал Z(t) предст. собой искаженное сост-е с-ы, при этом задача предст-ся след. образом (рис.)

В этом сл. д.б.

известны з-ны распредел-я шума с-ы или

устр-ва W(t)

и шума измерений V(t).

При этом треб-ся найти «наилучшую» или

оптимальную оценку в-ра сост-я с-ы

![]() истинного

сост-я с-ы X(t)

по известному знач-ю наблюдаемого сост-я

с-ы Z(t).

истинного

сост-я с-ы X(t)

по известному знач-ю наблюдаемого сост-я

с-ы Z(t).

В реал. с-ах не

всегда возможно получение новой инф-и

о в-ре сост-я с-ы, рассмотрим более сложный

вариант построения инженерной оптимизации

с-ы при отсутствии полной инф-и о в-ре

сост-я с-ы, заменив его предположением

о возмож-ти относит-но точного измерения

в-ра отклика с-ы Y(t)

= CX(t) в любой

момент времени t ≥ 0. Будем

считать, что в-р сост-я с-ы X(t)

опр-ся как пеш-е ур-ий (**)

(**)

Тогда м.б. построено

устр-во, называемое с-ой асимптотической

оценки или эстиматором, исп-щим в кач-ве

вх. воздействий измеряемый в-р отклика

объекта Y=CX(t)

и его вход U(t),

и вырабатывающее оценку в-ра сост-я с-ы

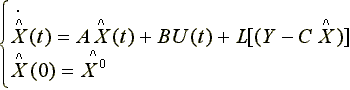

![]() как реш-е ур-я след. вида:

как реш-е ур-я след. вида:

(*)

(*)

![]() ,

причемпри усл-и невырожденности матр-цы

с-ы АТ, СТ

,

причемпри усл-и невырожденности матр-цы

с-ы АТ, СТ

rank| СТ | АТСТ | (АТ)2, СТ…| = n (условие наблюдаемости по Калману) в выраж-и (*) матр. L м.б. выбрана так, что ошибка оценивания в-ра сост-я

![]() , (

, (![]() - коорд. в-ра сост-я)

- коорд. в-ра сост-я)

будет стремиться

к нулю, если t → ∞ при

любой ограниченной начальной ошибке

в-ра сост-я. Д/док-ва этого высказывания

необх. вычесть ур-е (*) из ур-я (**), тогда

получим ур-е, определяющее изменение

ошибки оценивания т.о.:

![]() из этого выраж-я следует, чтобы ошибка

→ 0, достаточно выбрать матр. L

так, чтобы матр. (A – LC)

имела «хорошие» (оптим.) собств. числа,

однако они совпадают с собств. числами

транспонированной матр. (АT

– LT

CT),

если вып-ся усл-е наблюдаемости, т.е

матрицы АТ, СТ, А, С не

особенные, то задача выбора матр. L

или LT

отлич-ся от рассмотреннойзадачи

размещения собств чисел матр. (А – В К)

лишь обозначением, а именно, заменой

матр. А на АТ, К на LT,

В на CT

и разрешима с пом. алг-ов ужеописанных

ранее д/невырожд. Пары матриц АТ,

CT.

из этого выраж-я следует, чтобы ошибка

→ 0, достаточно выбрать матр. L

так, чтобы матр. (A – LC)

имела «хорошие» (оптим.) собств. числа,

однако они совпадают с собств. числами

транспонированной матр. (АT

– LT

CT),

если вып-ся усл-е наблюдаемости, т.е

матрицы АТ, СТ, А, С не

особенные, то задача выбора матр. L

или LT

отлич-ся от рассмотреннойзадачи

размещения собств чисел матр. (А – В К)

лишь обозначением, а именно, заменой

матр. А на АТ, К на LT,

В на CT

и разрешима с пом. алг-ов ужеописанных

ранее д/невырожд. Пары матриц АТ,

CT.

Если пара матриц АТ и CT вырождена, т.е.усл-е наблюдаемости не вып-ся, но ненаблюдаемая с-а устойчива, представленные выше ф-лы о возм-ти построения д/этой с-ы устр-ва асимптотической оценки остаются в силе, при этом говорят, что такая с-а будет явл-ся обнаруживаемой (детектируемой).

Д/реал. с-м при

построении с-ы оценки исп-ют те же матр.

А, В, С, что и в описании оптимизируемой

с-ы и вводят то же самое внешнее воздействие

U(t). Поэтому,

если нач. условия в-ра сост-ий с-ы Х(0)

= Х0 и нач. условия оценки в-ра

сост-ий с-ы

![]() совпадают, то вовпадают и дальнейшие

траектории в-ра сост. и оценки в-ра сост.

при всех t > 0. Т.е. с-а

оценки объекта работает как модель

этого объекта, при этом главное достоинство

с-ы оценки б. заключ-ся в том, что она

позвол. оценивать изменение сост-я

объекта и тогда, когда его начальное

сост-е неизв. Именно д/этой цели служит

последнее слагаемое в выражении (*),

вводящее в с-у оценки сигнал ОС,

пропорциональный разности м/д истинным

непосредственно измеренным выходом

с-ы Y(t) и его

прогнозом

совпадают, то вовпадают и дальнейшие

траектории в-ра сост. и оценки в-ра сост.

при всех t > 0. Т.е. с-а

оценки объекта работает как модель

этого объекта, при этом главное достоинство

с-ы оценки б. заключ-ся в том, что она

позвол. оценивать изменение сост-я

объекта и тогда, когда его начальное

сост-е неизв. Именно д/этой цели служит

последнее слагаемое в выражении (*),

вводящее в с-у оценки сигнал ОС,

пропорциональный разности м/д истинным

непосредственно измеренным выходом

с-ы Y(t) и его

прогнозом

![]() т.е.:

т.е.:

![]() (*)

(*)

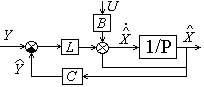

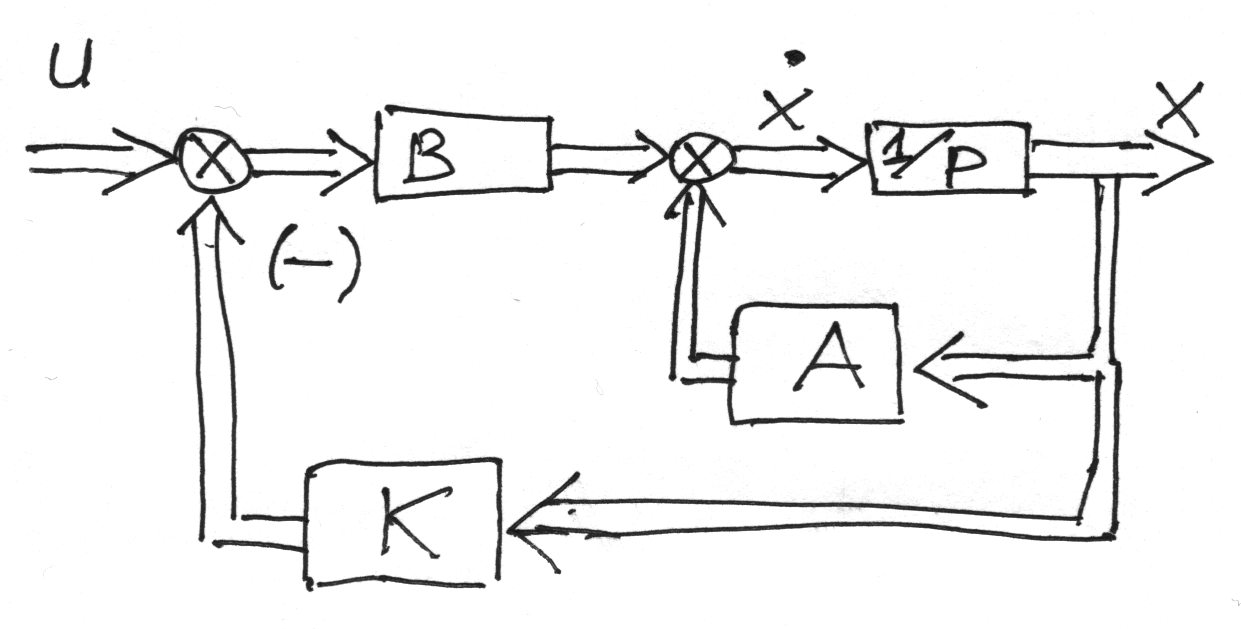

опр-ет стр-ру строгореализуемого с пом. стандартных типовых блоков (интеграторы и усилители) устр-ва асимптотич. оценки (эстиматора). Схема эстиматора:

Если мат. м-ль ОУ задана в норм. форме в терминах пр-ва состояния:

где A(n×n), B(n×m)

то требуется найти матрицу K(1×n)

![]() ,

где

,

где

![]() (n×n)

(n×n)

имеющую собств. набор чисел λ, удовлетворяющий треб-ям опт-ии. Для этого необх. и дост., чтобы: rank[B1|AB|…|An-1B]=n.

Проблема стабилизации: если пара матриц А и В невырождены и при t=>0 доступен для измер. вектор x(t), тогда с целью оптимальной стабилизации м.б. постр. ОС: U= - KX. Такая сист. устойчива. К м.б. выбрана так, чтобы все числа оказ. в лев. полуплоскости и обладали заданными св-ми:

При оптимизации САУ рассматривают 2 варианта (по возможности получения информации о векторе её состояния (полной или неполной).

1-ый вариант проще чем 2-ой, но встречается реже, т.к. применим в основном для простых систем. Если есть математическое описание системы и известно характеристическое уравнение системы (матрица), его корни (собств. числа матрицы системы), то по виду корней можно судить о свойствах системы и, в частности, о её устойчивости.

При оптимизации системы (оптимальная стабилизация), имея возможность влияния на размещение корней в нужной нам области, можно получить такую систему, которая обладала бы желаемыми свойствами.

Методы этой задачи различны, но суть оптимизации системы в изменении свойств системы.