- •52. Модели медицинской диагностики, основанные на теории статистич-х решений

- •Метод максимального правдоподобия

- •Метод Неймана-Пирсона

- •Модель Фишера

- •Метод Байеса

- •Метод Вальда

- •54. Методы классификации и распознавания образов в задачах диагностики и прогнозирования.

- •Метод максимального правдоподобия

- •Метод Неймана-Пирсона

- •Модель Фишера

- •54. Нейронные сети в медицинских технологиях

Метод максимального правдоподобия

Метод Неймана-Пирсона

Модель Фишера

Метод Байеса

Метод Вальда

критерий качества классификации: w=С1* + С2*

- вероятность пропуска опасного

состояния (ошибка 1-го рода)

![]()

- вероятность диагностики (ошибка

2-го рода)

![]()

С1 - стоимость пропуска опасного состояния

С2 - стоимость гипердиагностики

Чувствительность - способность системы распознавать опасное состояние: 1-

Специфичность - способность правильно определять неопасное состояние: 1-

54. Нейронные сети в медицинских технологиях

Нейронные сети используются для следующих задач:

Прогнозирование (распознавание изображений, образов, задачи классификации)

Задачи оптимизации

Автоматическое управление

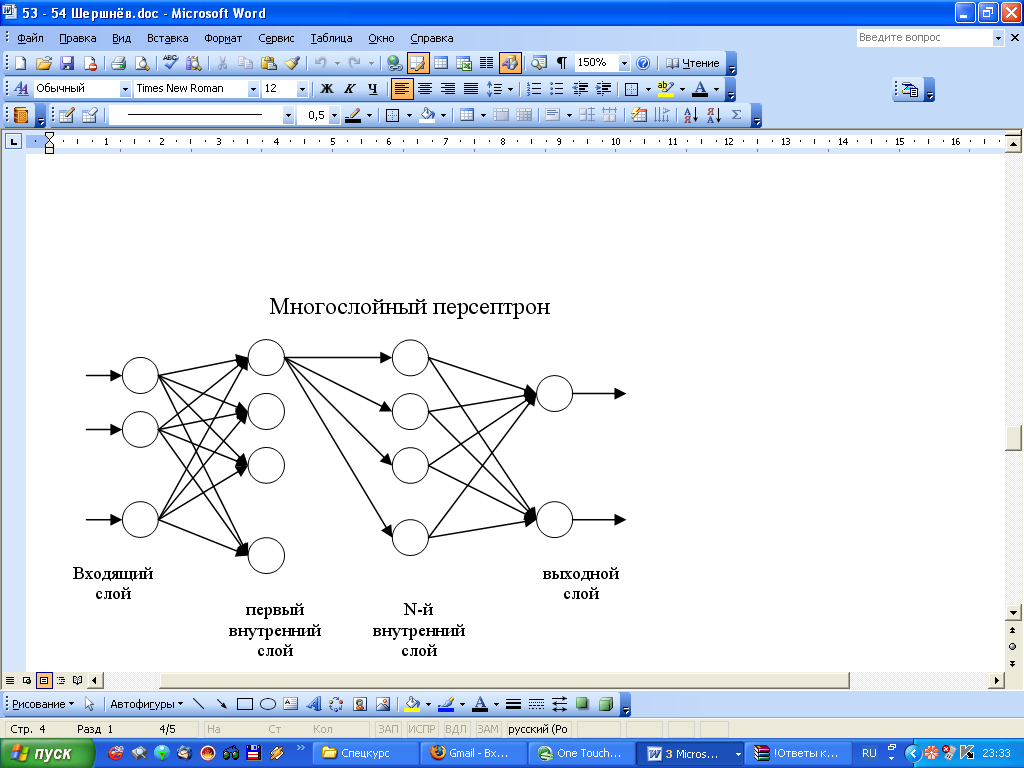

Многослойный персептрон

Нейроны 1-го слоя выполняют нормировку полученных сигналов. 1-й слой состоит из m нейронов (количество нейронов равно размерности пространства признаков)

Выходной слой для решения задач классификации должен содержать столько нейронов, сколько у нас классов. Каждый нейрон выходного слоя привязан к определенному классу.

Считается, что объект принадлежит классу Ks, если выходной сигнал yks больше остальных.

Обучение проходит по обучающей выборке.

0. Начальная активация (нулевое приближение весов. Их выбирают случайным образом в диапазоне (-1, +1).

1 этап (эпоха). На вход персептрона последовательно подаются объекты

1) подается первый объект. От последнего слоя к первому поступает поправка весов. Следующий объект уже работает с поправкой

…

n)

(n – объем обучающей выборки)

2 этап. Если обучение не произошло успешно, то повторяется первый этап

Проверка:

- контрольная выборка

- скользящий экзамен

Возможны 2 ошибки:

Недообучение: сеть с заданной точностью не распознает объекты из обучающей выборки

В промежуточный слой добавляют нейроны

Добавляют промежуточный слой

Переобучение: видим то, чего нет

Сети радиальных базисных функций

Каждый р.б.нейрон задаётся гаусовой функцией распределения:

μ – центр радиального базисного нейрона; σ – радиус радиального базисного нейрона

Архитектура сети:

Входной слой состоит из m нейронов (m – размерность пространства признаков). Выходной слой состоит из k нейронов (k – количество классов). Промежуточный слой один, состоит из радиальных базисных нейронов, количество которых не известно.

Обучение состоит в определении μ и σ для каждого базисного нейрона.

Определение μ:

Центры выбираются случайно

Алгоритм k-среднего. Предполагается, что все объекты можно разбить на k кластеров. Для каждого кластера выбираются центры. Для всех объектов обучающей выборки вычисляется расстояние до всех центров. Каждый объект относится к тому кластеру, расстояние до центра которого наименьшее. Затем повторяется то же самое, но с другими центрами.

Условие остановки: алгоритм завершает работу, когда центры классов на каком-то шаге перестают меняться.

Определение σ: метод ближайших соседей.

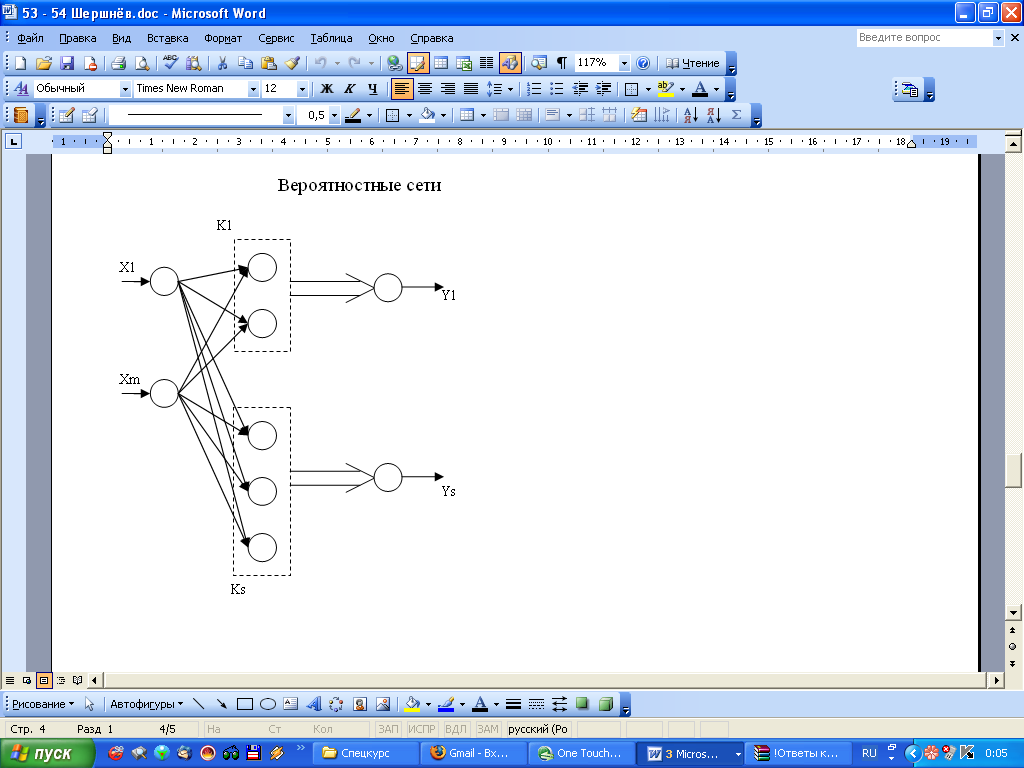

Вероятностные сети

Используются р.б. нейроны, объединённые в группы (на каждый класс группа).

Каждый выходной нейрон получает сигналы только от р.б. нейронов своего класса.

P1 = Y1/(Y1+Y2) - вероятность того, что объект принадлежит первому классу

P2 = Y2/(Y1+Y2) - вероятность того, что объект принадлежит второму классу

Объект принадлежит тому классу, для которого Р больше.

обучение:

xis -> yis

получаем P(x1s),...,P(xnss) -> fs(x) - оценка на основе плотности в m-мерном пространстве