- •Предмет теории вероятностей, два признака случайного явления, постулат теории вероятностей. Примеры построения пространств элементарных исходов.

- •Определение условной вероятности, ее свойства.

- •21)Схема Бернулли. Предельная теорема Пуассона. Неравенство Прохорова.

- •Часть 2:

- •2.9Дисперсия случайной величины, имеющей распределение Бернулли.

- •Дисперсия случайной величины, имеющей распределение Пуассона.

- •3.5. Методы получения точечных оценок.

- •16) Многомерные дискретные случайные величины: определение, совместный закон распределения, одномерные и условные законы распределения.

- •17) Абсолютно непрерывные двумерные величины: двумерная, одномерные и условные плотности распределения

- •18) Плотность двумерного нормального распределения, смысл параметров распределения.

- •3.6 Законы распределений выборочных характеристик, используемые при оценке параметров.

- •Проверка статистических гипотез о параметрах распределения.

- •Задача корреляционного анализа.

- •1.6 Понятие случайного события, операции над событиями

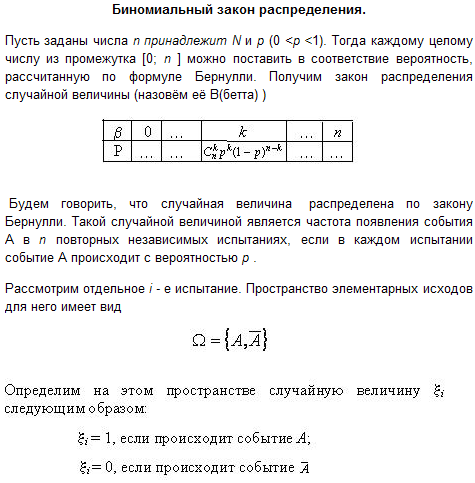

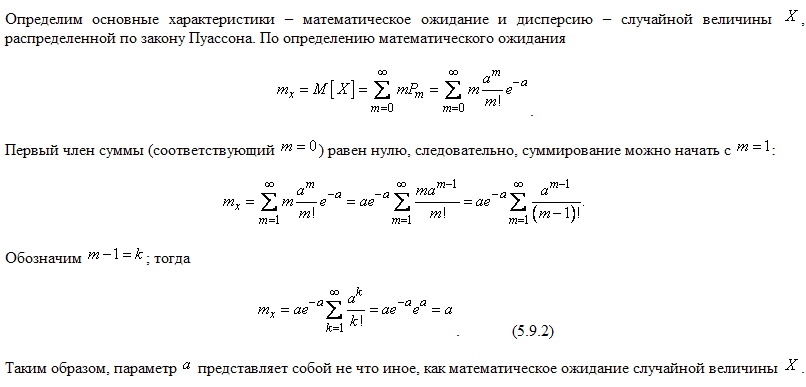

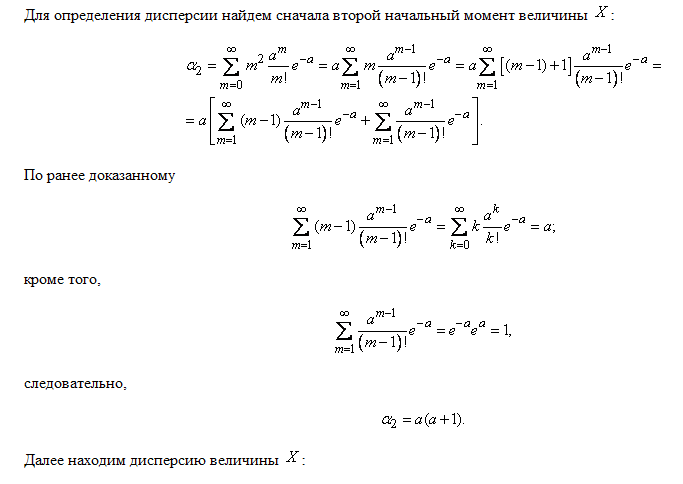

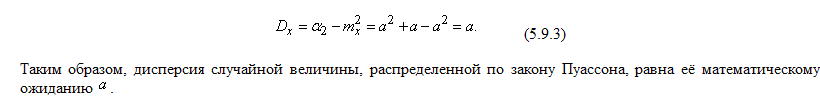

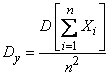

2.9Дисперсия случайной величины, имеющей распределение Бернулли.

Дисперсия случайной величины, имеющей распределение Пуассона.

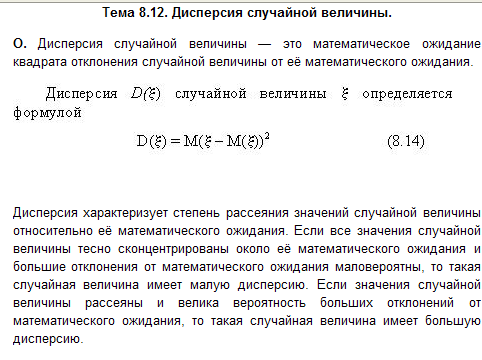

Дисперсией случайной величины Х называют математической ожидание квадрата отклонения случайной величины от ее математического ожидания:

Это свойство распределения Пуассона часто применяют на практике для решения вопроса, правдоподобна ли гипотеза о том, что случайная величина распределена по закону Пуассона. Для этого определяют из опыта статистические характеристики - математическое ожидание и дисперсию - случайной величины. Если их значения близки, то это может служить доводом в пользу гипотезы о пуассоновском распределении; резкое различие этих характеристик, напротив, свидетельствует против подобной гипотезы.

1.Определение случайной величины

и связанных с ней понятий: распределения

и функции распределения.

Случайной величиной называется

функция ![]() , измеримая относительно

, измеримая относительно ![]() и борелевскойσ-алгебры на

и борелевскойσ-алгебры на ![]() .

.

Случайную величину можно определить

и другим эквивалентным способом.

Функция

называется

случайной величиной, если для любых

вещественных чисел ![]() и

и ![]() множество

событий

множество

событий ![]() ,

таких что

,

таких что ![]() ,

принадлежит

.

,

принадлежит

.

Пусть дано вероятностноепространство ![]() ,

и на нём определена случайнаявеличина

,

и на нём определена случайнаявеличина ![]() с

распределением

с

распределением ![]() .

Тогда функцией распределения случайной

величины

называется функция

.

Тогда функцией распределения случайной

величины

называется функция ![]() ,

задаваемая формулой:

,

задаваемая формулой:

![]() .

.

То есть функцией распределения

(вероятностей) случайной величины

называют

функцию ![]() ,

значение которой в точке

,

значение которой в точке ![]() равно

вероятности события

равно

вероятности события ![]() ,

то есть события, состоящего только из

тех элементарных исходов, для которых

,

то есть события, состоящего только из

тех элементарных исходов, для которых ![]() .

.

2.Дискретные случайные величины, законы распределения, примеры (распределение Бернулли, биномиальное распределение, распределение Пуассона).

Если случайная величина дискретна, то есть её распределение однозначно задаётся функциейвероятности

![]() ,

,

то функция распределения ![]() этой

случайной величины кусочно-постоянна

и может быть записана как:

этой

случайной величины кусочно-постоянна

и может быть записана как:

![]() .

.

Эта функция непрерывна во всех

точках ![]() ,

таких что

,

таких что ![]() ,

и имеет разрыв первого рода в точках

,

и имеет разрыв первого рода в точках ![]() .

.

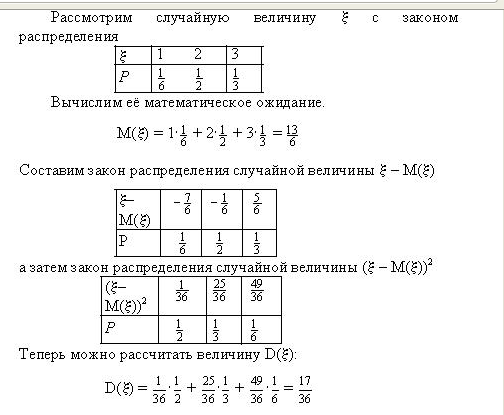

Закон распределения вероятностей р(m)определяется формулой Бернулли:

![]() .Закон

распределения вероятностей по формуле

Бернулли часто называют биномиальным,

так как Pn(m) представляет

собой m-й член разложения

бинома

.Закон

распределения вероятностей по формуле

Бернулли часто называют биномиальным,

так как Pn(m) представляет

собой m-й член разложения

бинома ![]() .

Пусть

случайная величина

.

Пусть

случайная величина ![]() может

принимать любое целое неотрицательное

значение, причем

может

принимать любое целое неотрицательное

значение, причем

3. Математическое ожидание дискретной случайной величины и его свойства. Пусть 1°. Математическое

ожидание постоянной С равно этой

постоянной.

Доказательство. Постоянную C можно

рассматривать как случайную величину

,

которая может принимать только одно

значение C c вероятностью равной

единице. Поэтому

3°. Математическое ожидание суммы нескольких случайных величин равно сумме математических ожиданий этих величин:

4°. Математическое ожидание произведения двух независимых случайных величин равно произведению математических ожиданий этих величин **:

|

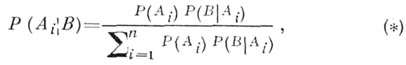

1.16.Полная группа событий, априорная и апостериорная вероятность.теорема Байеса.

По́лнойгру́ппойсобы́тий в теории вероятностей называется система случайных событий такая, что в результате произведенного случайного эксперимента непременно произойдет одно из них.

Пусть![]() есть вероятностное пространство. Любое

разбиение множества

есть вероятностное пространство. Любое

разбиение множества![]() элементами сигма-алгебры

элементами сигма-алгебры![]() называется полной группой событий.

называется полной группой событий.

Теорема Байеса-

формула, позволяющая вычислять

апостериорные вероятности событий (или

гипотез) через априорные вероятности.

Пусть

![]() - полная группа несовместимых событий

- полная группа несовместимых событий![]() :

при

:

при![]() . Тогда апостериорная вероятность

. Тогда апостериорная вероятность![]() события

события![]() при условии, что произошло событие В

при условии, что произошло событие В![]() , может быть найдена по формуле Бейеса:

, может быть найдена по формуле Бейеса:

Где![]() - априорная вероятность события

- априорная вероятность события

![]() ,

,

![]() - условная вероятность события Впри

условии, что произошло событие

- условная вероятность события Впри

условии, что произошло событие![]() .

.

АПОСТЕРИОРНАЯ ВЕРОЯТНОСТЬ какого-либо события - условная вероятность события при нек-ром условии, рассматриваемая в противоположность его безусловной или априорной вероятности.

1.17События называются независимыми в совокупности, если каждое из них и любое произведение остальных (включающее либо все остальные события, либо часть из них) есть события независимые.События, независимые в совокупности, попарно независимы между собой; обратное утверждение неверно.

Теорема умножения произвольных событий. Вероятность произведения двух произвольных событий равна произведению вероятности одного из них на условную вероятность другого, в предположении, что первое имеет место, т.е. P(AB) = P(A)P(B|A) = P(B)P(A|B).

Следствие. Для любых двух событий А и В справедливо равенство P(A)P(B|A) = P(B)P(A|B).

Теорема умножения произвольных событий допускает обобщение на случай нескольких событий.

Теорема умножения независимых событий. Вероятность совместного появления двух независимых событий А и В равна произведению вероятностей этих событий: P(AB) = P(A)P(B).

Теорема умножения независимых в совокупности событий. Вероятность произведения конечного числа независимых в совокупности событий равна произведению вероятностей этих событий:

P(A1 x A2 x...x An) = P(A1) x P(A2) x...x P(An).

Формула полной вероятности. Если Н1….Нп-полная группа попарно несовместных событий(т.е сумма этих событий есть достоверное событие и никакие два из них не могут произойти одновременно) то вероятность любого события А может быть вычислена с помощью формулы полной вероятности :

Р(А)=Р(Н1)Р(А│Н1)+…+Р(Нп)Р(А│Нп).

События Н1….Нп называются при этом гипотезами ,а вероятности Р(Н1)…Р(Нп) -априорными вероятностями гипотез.

Из попарной независимости не следует независимость в совокупности.

Независимость событий заключается в том, что между событиями нет причинно-следственной связи.

Пример показывающий, что из попарной незавимости не следует независимость в совокупности.

Подбрасывается

тетраэдр, на трёх гранях которого

написано по одной цифре 1, 2, 3 соответственно,

а на четвёртой присутствуют все 3 цифры

одновременно. Рассматриваются события

![]() {тетраэдр

упадёт на грань, на которой присутствует

цифра i},

{тетраэдр

упадёт на грань, на которой присутствует

цифра i},

![]() .

Показать, что события

.

Показать, что события

![]() попарно независимы, но не являются

независимыми в совокупности.

попарно независимы, но не являются

независимыми в совокупности.

![]()

![]()

![]()

![]()

![]()

![]()

Имеем

![]()

![]()

![]()

Исходя из проведённых выкладок, делаем вывод о том, что попарная независимость есть.

Проверим теперь, есть ли независимость в совокупности:

![]() => независимости

в совокупности нет. Этот пример

подтверждает изложенный выше факт, что

из попарной независимости не следует

независимость в совокупности.

=> независимости

в совокупности нет. Этот пример

подтверждает изложенный выше факт, что

из попарной независимости не следует

независимость в совокупности.

2.6. Определение независимых случайных величин. Математическое ожидание произведения и дисперсия суммы независимых случайных величин.

Случайные величины

![]() называют независимыми (в совокупности),

если для любого набора борелевских

множеств

называют независимыми (в совокупности),

если для любого набора борелевских

множеств

![]() ,...,

,...,![]() имеет

место равенство:

имеет

место равенство:

![]()

Случайные величины называют попарно независимыми, если независимы любые две из них.

Математи́ческоеожида́ние — среднее значение случайной величины, распределение вероятностей случайной величины.

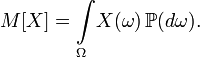

Определение. Пусть

задано вероятностное пространство![]() и определённая на нём случайная величина

. То есть, по определению,

и определённая на нём случайная величина

. То есть, по определению,![]() — измеримая функция. Если существует

интеграл Лебега от X

по пространству

— измеримая функция. Если существует

интеграл Лебега от X

по пространству![]() , то он называется математическим

ожиданием, или средним (ожидаемым)

значением и обозначается

, то он называется математическим

ожиданием, или средним (ожидаемым)

значением и обозначается![]() или

или![]() .

.

Свойства математического ожидания

Математическое ожидание суммы независимых случайных величин равно сумме их математических ожиданий: Mx + y = Mx + My.

Математическое ожидание произведения независимых случайных величин равно произведению их математических ожиданий:Mx · y = Mx · My.

Диспе́рсияслуча́йной

величины́ — мера разброса данной

случайной величины, то есть её отклонения

от математического ожидания. Обозначается![]()

Определение. Пусть

Х — случайная величина, определённая

на некотором вероятностном пространстве.

Тогда![]() ,

где символ М обозначает математическое

ожидание.

,

где символ М обозначает математическое

ожидание.

Свойства

Дисперсия любой

случайной величины неотрицательна:

![]()

Если дисперсия случайной величины конечна, то конечно и её математическое ожидание;

Если случайная

величина равна константе, то её дисперсия

равна нулю:![]() Верно и обратное: если

Верно и обратное: если![]() то

то

![]() почти

всюду;

почти

всюду;

Дисперсия суммы

двух случайных величин равна:

![]()

, где![]() — их ковариация;

— их ковариация;

Для дисперсии

произвольной линейной комбинации

нескольких случайных величин имеет

место равенство:

![]()

, где![]() ;

;

В частности,

![]() для любых независимых или некоррелированных

случайных величин, так как их ковариации

равны нулю;

для любых независимых или некоррелированных

случайных величин, так как их ковариации

равны нулю;

![]()

![]()

![]()

2.7. Ковариа́ция (корреляционный момент, ковариационный момент) в теории вероятностей и математической статистике мера линейной зависимости двух случайных величин.

Определение

Пусть![]() — две случайные величины, определённые

на одном и том же вероятностном

пространстве. Тогда их ковариация

определяется следующим образом:

— две случайные величины, определённые

на одном и том же вероятностном

пространстве. Тогда их ковариация

определяется следующим образом:![]()

,в предположении, что все математические ожидания в правой части определены.

Замечания

Если![]() , то есть имеют конечный второй момент,

то ковариация определена и конечна.

, то есть имеют конечный второй момент,

то ковариация определена и конечна.

В гильбертовом

пространстве несмещённых случайных

величин с конечным вторым моментом

![]() ковариация имеет вид

ковариация имеет вид![]() и играет роль скалярного произведения.

и играет роль скалярного произведения.

Свойства

Если

— независимые случайные величины, то:

![]()

НО обратное утверждение, вообще говоря, неверно: из отсутствия ковариации не следует независимость.

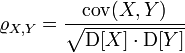

2.8. Коэффициент корреляции.

Определение

Пусть

![]() — две случайные величины, определённые

на одном вероятностном пространстве.

Тогда их коэффициент корреляции задаётся

формулой:

— две случайные величины, определённые

на одном вероятностном пространстве.

Тогда их коэффициент корреляции задаётся

формулой:

, где

![]() обозначает ковариацию, а

обозначает ковариацию, а

![]() —дисперсию,

или, что то же самое,

—дисперсию,

или, что то же самое,

,

![]() где

символ

где

символ![]() обозначает математическое ожидание.

обозначает математическое ожидание.

Свойства

Неравенство Коши

— Буняковского:

![]()

Коэффициент

корреляции равен

![]() тогда и только тогда, когда

тогда и только тогда, когда

![]() и

и

![]() линейно зависимы:

линейно зависимы:

![]()

Где![]() . Более того в этом случае знаки

. Более того в этом случае знаки![]() иК совпадают:

иК совпадают:

Если

независимые

случайные величины, то![]() . Обратное, вообще говоря, неверно.

. Обратное, вообще говоря, неверно.

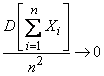

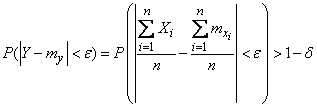

2.11. Теорема Маркова.неравенствоЧебышева,правило трех ..

Теорема Маркова.

Если имеются зависимые случайные

величины

![]() и если при

и если при![]()

,

то

среднее арифметическое наблюденных

значений случайных величин

сходится по вероятности к среднему

арифметическому их математических

ожиданий. Доказательство. Рассмотрим

величину

то

среднее арифметическое наблюденных

значений случайных величин

сходится по вероятности к среднему

арифметическому их математических

ожиданий. Доказательство. Рассмотрим

величину

Очевидно,

Очевидно,

Применим к величине

неравенство

Чебышева:

![]()

Так как по условию

теоремы при

![]() , то при достаточно большом

, то при достаточно большом

![]()

![]() или,

переходя к противоположному событию,

или,

переходя к противоположному событию,

, что и требовалось доказать.

Неравенство

Чебышева. Первое неравенство Чебышева.

Пусть Х – неотрицательная случайная

величина (т.е.

![]() для любого

для любого

![]() ).

Тогда для любого положительного числа

а справедливо неравенство

).

Тогда для любого положительного числа

а справедливо неравенство![]()

Доказательство.

Все слагаемые в правой части формулы

(4), определяющей математическое ожидание,

в рассматриваемом случае неотрицательны.

Поэтому при отбрасывании некоторых

слагаемых сумма не увеличивается.

Оставим в сумме только те члены, для

которых![]() . Получим, что

. Получим, что

![]() .

(9)

.

(9)

Для всех слагаемых

в правой части (9)

, поэтому![]() .

(10)

.

(10)

Из (9) и (10) следует требуемое.

Второе неравенство

Чебышева. Пусть Х – случайная величина.

Для любого положительного числа а

справедливо неравенство![]()

Для доказательства

второго неравенства Чебышёва рассмотрим

случайную величину У = (Х – М(Х))2. Она

неотрицательна, и потому для любого

положительного числа b, как следует из

первого неравенства Чебышёва, справедливо

неравенство![]()

Положим b = a2. Событие

{Y>b} совпадает с событием {|X – M(X)|>a},

а потому![]() что

и требовалось доказать.

что

и требовалось доказать.

ПРАВИЛО ТРЕХ СИГМ.

В качестве следствия получим так

называемое «правило трёх сигм», которое

означает, что вероятность случайной

величине отличаться от своего

математического ожидания более, чем на

три корня из дисперсии, мала. Мы получим

верную для всех распределений с конечной

дисперсией оценку сверху для вероятности

случайной величине отличаться от своего

математического ожидания более, чем на

три корня из дисперсии.Правило

трех сигм

При рассмотрении нормального закона

распределения выделяется важный частный

случай, известный как правило трех сигм.

Запишем вероятность того, что отклонение

нормально распределенной случайной

величины от математического ожидания

меньше заданной величины D:

![]() Если принять D = 3s, то получаем с

использованием таблиц значений функции

Лапласа:

Если принять D = 3s, то получаем с

использованием таблиц значений функции

Лапласа:

![]() Т.е.

вероятность того, что случайная величина

отклонится от своего математического

ожидание на величину, большую чем

утроенное среднее. На практике считается,

что если для какой – либо случайной

величины выполняется правило трех сигм,

то эта случайная величина имеет нормальное

распределение.

Т.е.

вероятность того, что случайная величина

отклонится от своего математического

ожидание на величину, большую чем

утроенное среднее. На практике считается,

что если для какой – либо случайной

величины выполняется правило трех сигм,

то эта случайная величина имеет нормальное

распределение.

2.12 Абсолютно

непрерывные случ величины. Случайную

величину назовем непрерывной, если ее

функция распределения непрерывна. Легко

видеть, что случайная величина непрерывна

тогда и только тогда, когда![]() при всех

при всех![]() .

.

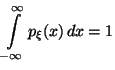

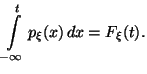

Важный класс непрерывных случайных величин -- абсолютно непрерывные случайные величины. Это случайные величины, распределение которых имеет плотность.

Случайная величина![]() называется абсолютно непрерывной, если

существует функция

называется абсолютно непрерывной, если

существует функция![]() такая, что

такая, что

![]() ,

,

,

,

![]() ,

имеет место равенство:

,

имеет место равенство:

Функция![]() , обладающая вышеперечисленными

свойствами, называется плотностью

распределения случайной величины

.

, обладающая вышеперечисленными

свойствами, называется плотностью

распределения случайной величины

.

Следствие Если

-- абсолютно непрерывная случайная

величина, то

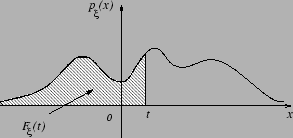

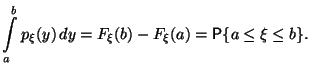

Наглядный смысл

плотности можно проиллюстрировать

следующим рисунком.

Замечание Если

плотность

непрерывна в точке

,

то из Следствия 3.1 вытекает следующее

представление:

![]() =

=

![]()

![]()

Следствие 3.2 Если

-- точка непрерывности функции

, то

![]()

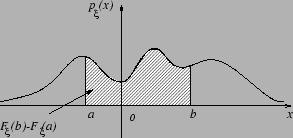

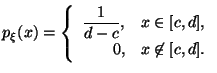

Примеры абсолютно непрерывных распределений

1) Равномерное

распределение в отрезке

![]()

2) Показательное

распределение с параметром

![]()

Показательное распределение называют также экспоненциальным.

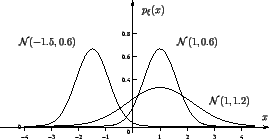

3) Нормальное (или

гауссовское) распределение![]() ,

,![]() ,

,![]() :

:

![]()

Стандартное

нормальное распределение -- :

![]()

![]()

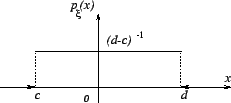

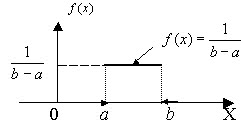

2.13 Равномерное распределение

Р. р. на отрезке

числовой прямой (прямоугольное

распределение). Р. р. на каком-либо отрезке

[ а, b], а<b, - это распределений вероятностей,

имеющее плотность

Понятие Р. р. на [

а, b] соответствует представлению о

случайном выборе точки на этом отрезке

"наудачу". Математич. ожидание и

дисперсия Р. р. равны, соответственно,

(b+a)/2 и (b-а)2/12. Функция распределения

задается формулой а характеристич. функция - формулой

а характеристич. функция - формулой

![]()

График

дифференциальной функции равномерного

распределения вероятностей представлен

на рис.

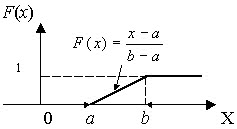

Интегральную

функцию равномерного распределения

аналитически можно записать так:

![]() График

интегральной функции равномерного

распределения вероятностей представлен

на рис.

График

интегральной функции равномерного

распределения вероятностей представлен

на рис.

Математическое ожидание равномерного распределения: M(X) = (a + b)/2

Дисперсия равномерного распределения: D(X) = (b - a)2/12

Среднее квадратичное отклонение равномерного распределения: σ(X) = (b - a)/(2√3)

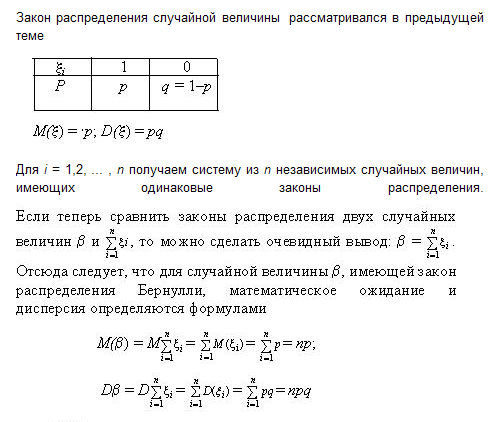

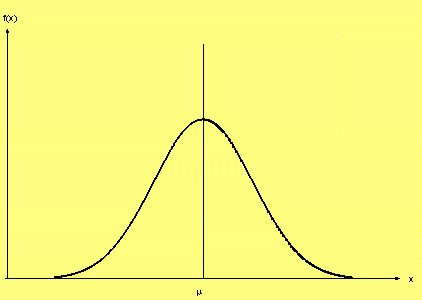

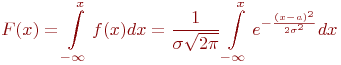

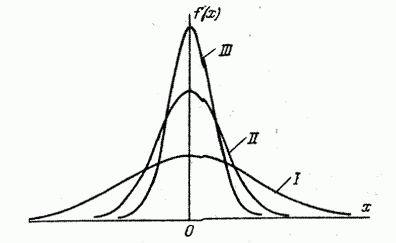

2.15 Нормальное распределение. Нормальное распределение, также называемое гауссовым распределением, гауссианой или распределением Гаусса — распределение вероятностей, которое задается функцией плотности распределения:

![]() где

параметр μ — среднее значение

(математическое ожидание) случайной

величины и указывает координату максимума

кривой плотности распределения, а σ² —

дисперсия.

где

параметр μ — среднее значение

(математическое ожидание) случайной

величины и указывает координату максимума

кривой плотности распределения, а σ² —

дисперсия.

Плотность

вероятности ![]()

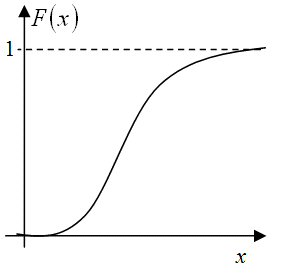

Функция

распределения![]()

График плотности распределения для нормально распределённой случайной величины имеет вид, отдалённо напоминающий колокол:

График

нормальной функции распределения

График

нормальной функции распределения

Функция

нормального распределения имеет вид (22)

(22)

Заметим,

что нормальная кривая (рис.9.11 ) симметрична

относительно прямой![]() и асимптотически приближается к оси

ОХ при

и асимптотически приближается к оси

ОХ при![]() .

.

Вычислим

математическое ожидание для нормального

закона![]()

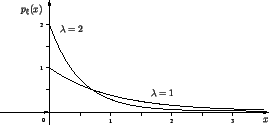

СМЫСЛ ПАРАМЕТРОВ РАСПРЕДЕЛЕНИЯ

Кривая

распределения по нормальному закону

имеет симметричный холмообразный вид

(рис. 6.1.1). Максимальная ордината кривой,

равная![]() , соответствует точке

, соответствует точке![]() ; по мере удаления от точки

; по мере удаления от точки![]() плотность распределения падает, и при

плотность распределения падает, и при

![]() кривая асимптотически приближается к

оси абсцисс.

кривая асимптотически приближается к

оси абсцисс.

Выясним

смысл численных параметров

и

![]() ,

входящих в выражение нормального закона

(6.1.1); докажем, что величина

есть не что иное, как математическое

ожидание, а величина

- среднее квадратическое отклонение

величины . Для этого вычислим основные

числовые характеристики величины Х -

математическое ожидание и дисперсию.

,

входящих в выражение нормального закона

(6.1.1); докажем, что величина

есть не что иное, как математическое

ожидание, а величина

- среднее квадратическое отклонение

величины . Для этого вычислим основные

числовые характеристики величины Х -

математическое ожидание и дисперсию.

![]()

Применяя

замену переменной

![]() имеем:

имеем:

![]()

Нетрудно убедиться, что первый из двух интервалов в формуле (6.1.2) равен нулю; второй представляет собой известный интеграл Эйлера-Пуассона:

![]() Следовательно,

Следовательно,

![]() т.е.

параметрm

представляет собой математическое

ожидание величиныX

. Этот параметр, особенно в задачах

стрельбы, часто называют центром

рассеивания (сокращенно – ц. р.).

т.е.

параметрm

представляет собой математическое

ожидание величиныX

. Этот параметр, особенно в задачах

стрельбы, часто называют центром

рассеивания (сокращенно – ц. р.).

Вычислим

дисперсию величины X:

![]()

Применив

снова замену переменной

имеем:

![]()

Интегрируя

по частям, получим:

![]()

Первое

слагаемое в фигурных скобках равно нулю

(так как![]() при

при

![]() убывает быстрее, чем возрастает любая

степень

убывает быстрее, чем возрастает любая

степень![]() ), второе слагаемое по формуле (6.1.3) равно

), второе слагаемое по формуле (6.1.3) равно![]() , откуда

, откуда

![]()

Следовательно, параметр в формуле (6.1.1) есть не что иное, как среднее квадратическое отклонение величины Х .

Выясним

смысл параметров

и

нормального распределения. Непосредственно

из формулы (6.1.1) видно, что центром

симметрии распределения является центр

рассеиванияm

. Это ясно из того, что при изменении

знака разности![]() на обратный выражение (6.1.1) не меняется.

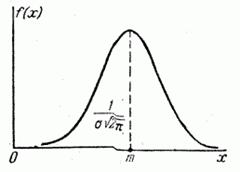

Если изменять центр рассеивания , кривая

распределения будет смещаться вдоль

оси абсцисс, не изменяя своей формы

(рис. 6.1.2). Центр рассеивания характеризует

положение распределения на оси абсцисс.

на обратный выражение (6.1.1) не меняется.

Если изменять центр рассеивания , кривая

распределения будет смещаться вдоль

оси абсцисс, не изменяя своей формы

(рис. 6.1.2). Центр рассеивания характеризует

положение распределения на оси абсцисс.

Размерность центра рассеивания – та же, что размерность случайной величины X.

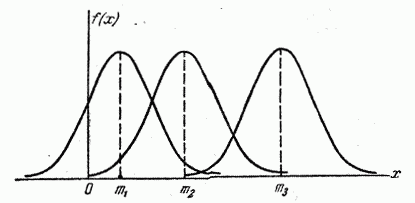

Параметр

характеризует не положение, а самую

форму кривой распределения. Это есть

характеристика рассеивания. Наибольшая

ордината кривой распределения обратно

пропорциональна

; при увеличении максимальная ордината

уменьшается. Так как площадь кривой

распределения всегда должна оставаться

равной единице, то при увеличении

кривая распределения становится более

плоской, растягиваясь вдоль оси абсцисс;

напротив, при уменьшении

кривая распределения вытягивается

вверх, одновременно сжимаясь с боков,

и становится более иглообразной. На

рис. 6.1.3 показаны три нормальные кривые

(I, II, III) при![]() ; из них кривая I соответствует самому

большому, а кривая III – самому малому

значению

. Изменение параметра равносильно

изменению масштаба кривой распределения

– увеличению масштаба по одной оси и

такому же уменьшению по другой.

; из них кривая I соответствует самому

большому, а кривая III – самому малому

значению

. Изменение параметра равносильно

изменению масштаба кривой распределения

– увеличению масштаба по одной оси и

такому же уменьшению по другой.

Размерность параметра , естественно, совпадает с размерностью случайной величины .

В некоторых курсах теории вероятностей в качестве характеристики рассеивания для нормального закона вместо среднего квадратического отклонения применяется так называемая мера точности. Мерой точности называется величина, обратно пропорциональная среднему квадратическому отклонению :

![]() Размерность

меры точности обратная размерности

случайной величины.Термин «мера точности»

заимствован из теории ошибок измерений:

чем точнее измерение, тем больше мера

точности. Пользуясь мерой точности ,

можно записать нормальный закон в виде:

Размерность

меры точности обратная размерности

случайной величины.Термин «мера точности»

заимствован из теории ошибок измерений:

чем точнее измерение, тем больше мера

точности. Пользуясь мерой точности ,

можно записать нормальный закон в виде:

![]()

3.1 Определение.

Множество

![]() отдельных значений случайной величины

отдельных значений случайной величины

![]() ,

полученных в серии из

,

полученных в серии из

![]() независимых экспериментов (наблюдений),

называется выборочной

совокупностью или выборкой

объема

из генеральной совокупности.

независимых экспериментов (наблюдений),

называется выборочной

совокупностью или выборкой

объема

из генеральной совокупности.

Итак, с одной

стороны, выборка - это конкретный набор

значений случайной величины. Однако,

если мы повторим серию из

экспериментов, мы получим другой набор

значений случайной величины

,

т.е. любое выборочное значение

![]() само является случайной величиной,

очевидно распределенной по тому же

закону

само является случайной величиной,

очевидно распределенной по тому же

закону

![]() .

.

Таким образом, в математической модели, выборка - совокупность независимых и одинаково распределенных случайных величин .

Графическая иллюстрация статистических рядов

В качестве графической иллюстрации статистических рядов используются:

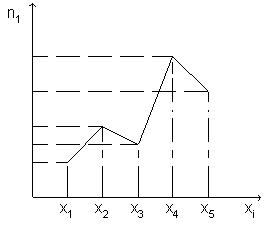

Полигон частотназывают ломанную, отрезки которой соединяют точки (x1; n1), (x2; n2), ..., (xk; nk). Для построения полигона частот на оси абсцисс откладывают варианты xi, а на оси ординат - соответствующие им частоты ni. Точки ( xi; ni) соединяют отрезками прямых и получают полигон частот

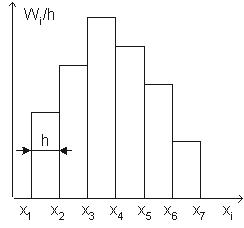

Гистограмма

частот

- ступенчатая фигура, состоящая из

![]() прямоугольников, опирающихся на частичные

интервалы. Высота

прямоугольников, опирающихся на частичные

интервалы. Высота

![]() -го

прямоугольника полагается равной

плотности частоты

-го

прямоугольника полагается равной

плотности частоты

![]() .

Соответственно площадь каждого

прямоугольника равна

.

Соответственно площадь каждого

прямоугольника равна

![]() - относительной частоте. Гистограмма

частот также является статистическим

аналогом кривой плотности распределения

(рис 2).

- относительной частоте. Гистограмма

частот также является статистическим

аналогом кривой плотности распределения

(рис 2).

Полигоном относительных частот называют ломанную, отрезки которой соединяют точки (x1; W1), (x2; W2), ..., (xk; Wk). Для построения полигона относительных частот на оси абсцисс откладывают варианты xi, а на оси ординат - соответствующие им относительные частоты Wi. Точки ( xi; Wi) соединяют отрезками прямых и получают полигон относительных частот.

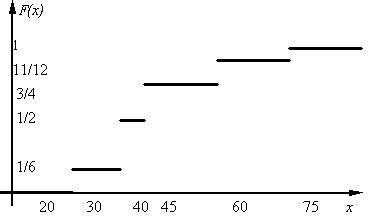

Эмпирическая функция распределения

Эмпирической

функцией распределения называется

функция, вычисляемая для любого значения

х по формуле

![]()

,

где n – объем

выборки,![]() – количество вариант, значения которых

меньше, чем х.

– количество вариант, значения которых

меньше, чем х.

Свойства![]() :

:

При![]() ;

;![]()

При

![]() ;

;![]()

При

![]() ;

;![]()

– функция неубывающая.

3.2. Понятие о статистической оценке параметров. Θ, θ (название: те́та, греч. θήτα)

Пусть распределение признака Х - генеральной совокупности - задается функцией вероятности f(x, θ) = P(X=xi) для дискретной случайной величины или плотностью вероятностей для непрерывной случайной величины, которая содержит неизвестный параметр θ.

Для вычисления параметра θ используют выборку x1, x2, ..., xn, каждая из которых имеет один и тот же закон распределения, что и признак Х.

Оценкой θn параметра θ называют всякую функцию результатов наблюдений (иначе - статистику), с помощью которой делают вывод о значении параметра θ: θn = θn(x1, x2, ..., xn).

Так как x1, x2, ..., xn - случайные величины, то и оценка θn является случайной величиной, которая зависит от закона распределения и объема выборки n. Оцениваемый параметр θ является постоянной величиной.

Всегда существует

множество функций от результатов

наблюдений x1, x2, ...xn, которые можно

предложить в качестве оценки параметра

θ. Например, для математического ожидания

в качестве оценки θn по выборке можно

взять среднюю арифметическую результатов

наблюдений

![]() ,

моду M0, медиану Me и т. д.

,

моду M0, медиану Me и т. д.

Так как θn - случайная величина, то невозможно предсказать индивидуальное значение оценки в данном частном случае. Поэтому о качестве оценки следует судить не по ее индивидуальным значениям, а по распределению ее значений при достаточно большом числе испытаний, т. е. по выборочному распределению оценки.

свойства оценок

Оценка θn параметра θ называется несмещенной, если ее математическое ожидание равно оцениваемому параметру, т. е. M(θn) = θ.

В противном случае оценка называется смещенной. Если это равенство не выполняется, то оценка θn, полученная по разным выборкам, будет либо завышать θ, если M(θn) > θ, либо занижать его, если M(θn) < θ. Таким образом, требование несмещенности гарантирует отсутствие систематических ошибок при оценивании.

Для оценок важными являются еще свойства состоятельности и эффективности, определения которых приводятся ниже.

Оценка θn параметра

θ называется состоятельной,

если она удовлетворяет закону больших

чисел, т. е. сходится по вероятности к

оцениваемому параметру![]() или

или![]()

.

Если оценка состоятельна, то практически достоверно, что при достаточно большом n θn ≈ θ.

Несмещенная оценка

θn параметра θ является эффективной,

если она имеет наименьшую дисперсию

среди всех возможных несмещенных оценок

параметра θ, вычисленных по выборкам

одного и того же объема n. Так как для

несмещенной оценки M(θn – θ)2 есть

дисперсия![]() , то эффективность является решающим

свойством, определяющим качество оценки.

, то эффективность является решающим

свойством, определяющим качество оценки.

В качестве статистических оценок параметров генеральной совокупности желательно использовать оценки, удовлетворяющие одновременно требованиям несмещенности, состоятельности и эффективности.

![]() называется

несмещенной оценкой параметра

называется

несмещенной оценкой параметра![]() , если для любого

, если для любого![]() выполнено равенство

выполнено равенство

![]()

называется

состоятельной оценкой параметра

, если для любого

имеет место сходимость

![]() при .

при .![]()

.