- •Информация. Свойства. Формы представления.

- •Формула Хартли, Шеннона. Единицы измерения информации.

- •Системы счисления. Перевод чисел из одной системы счисления в другую.

- •Кодирование текстовой информации. Кодирование графической информации.

- •Алгебра логики. Высказывания. Логические операции. Таблица истинности

- •Логические основы эвм.

- •Основные принципы построения эвм. Устройство памяти компьютера.

- •Устройства ввода, вывода информации.

- •Программные средства реализации информационных процессов. Классификация программных средств.

- •Операционные системы. Разновидности операционных систем.

- •Операционная система Windows. Основные характеристики.

- •Сервисные системные программы: назначение и классификация.

- •Прикладное программное обеспечение: назначение и классификация.

- •14.Понятие модели данных. Иерархическая модель данных. Реляционная модель данных.

- •15.Основы работы с базами данных: понятие базы данных и системы управления базами данных. Типы объектов базы данных ms Access.

- •16.Понятие алгоритма. Свойства алгоритма. Способы представления алгоритмов.

- •17.Эволюция языков программирования. Классификация языков программирования.

- •18. Технологии программирования. Структурное программирование. Объектно-ориентированное программированиею

- •19.Характеристики компьютерных сетей. Классификация компьютерных сетей. Топологии сетей.

- •20.Глобальная компьютерная сеть Интернет. Принципы построения и адресация

- •21.Службы сети Интернет

- •22.Вопросы компьютерной безопасности.

Информация. Свойства. Формы представления.

Информация – это сведения об окружающем мире, которые являются объектом преобразования и используются для выработки поведения, для принятия решения, для управления или для обучения.

Будучи объектом преобразования и использования, информация характеризуется следующими свойствами:

синтаксис – свойство, определяющее способ представления информации на носителе (в сигнале). данная информация представлена на электронном носителе с помощью определенного шрифта. можно рассматривать такие параметры представления информации, как стиль и цвет шрифта, его размеры, междустрочный интервал и т.д

семантика – свойство, определяющее смысл информации как соответствие сигнала реальному миру. Так, семантика сигнала “информатика” заключается в данном ранее определении. Семантика может рассматриваться как некоторое соглашение, известное потребителю информации, о том, что означает каждый

прагматика – свойство, определяющее влияние информации на поведение потребителя. Так прагматика информации, получаемой читателем настоящего учебного пособия, заключается, по меньшей мере, в успешной сдаче экзамена по информатике.

Формы представления(способы кодирования) информации:

– разговорные языки (более 2000);

– язык мимики и жестов;

– язык рисунков и чертежей;

– научные языки (математики, программирования);

– языки искусства (музыка, живопись, скульптура);

– специальные языки (азбука Брайля, азбука Морзе, флажковая азбука).

Способы кодирования информации:

1) графический (с помощью рисунков, значков, схем, чертежей, графиков);

2) числовой (с помощью чисел);

3) символьный (с помощью символов того же алфавита, что и исходный текст).

Формула Хартли, Шеннона. Единицы измерения информации.

В качестве единицы информации условились принять один бит.Бит в теории информации - количество информации, необходимое для различения двух равновероятных сообщений.

В вычислительной технике битом называют наименьшую "порцию" памяти компьютера, необходимую для хранения одного из двух знаков "0" и "1", используемых для внутримашинного представления данных и команд.

Одним битом могут быть выражены два понятия: 0 или 1 (да или нет, черное или белое, истина или ложь и т.п.).

Если количество битов увеличить до двух, то уже можно выразить четыре различных понятия:

00 01 10 11

Тремя битами можно закодировать восемь различных значений:

000 001 010 011 100 101 110 111

Увеличивая на единицу количество разрядов в системе двоичного кодирования, мы увеличиваем в два раза количество значений, которое может быть выражено в данной системе, то есть общая формула имеет вид:

N=2m

где N - количество независимых кодируемых значений; m - разрядность двоичного кодирования, принятая в данной системе. Бит - слишком мелкая единица измерения. На практике чаще применяется более крупная единица - байт, равная восьми битам.

Именно восемь битов требуется для того, чтобы закодировать любой из 256 символов алфавита клавиатуры компьютера: 256=2^8

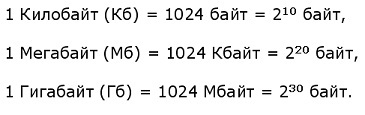

Широко используются также ещё более крупные производные единицы информации:

В последнее время в связи с увеличением объёмов обрабатываемой информации входят в употребление такие производные единицы, как:

![]()

Количество информации, которое вмещает один символ N-элементного алфавита, определяется по формуле Хартли:

N=2i

Формула Шеннона:

![]()

где I - количество информации;

N - количество возможных событий;

рi - вероятность i-го события.

Формула Хартли

определяет количество информации,

содержащееся в сообщении длины n.

![]()