- •Процесори 80х86. Основні характеристики. Типи процесорів: sx, dx, dx-2. Адресний простір. Обчислення адреси.

- •Пам'ять pc. Типи пам'яті (convention, umb, hma, extended, expanded). Cmos - пам'ять, Shadow - пам'ять.

- •Диски, дисководи і контролери. Типи, коротка характеристика.

- •Ms dos. Призначення, особливості й основні компоненти.

- •Комп'ютерні віруси. Способи захисту інформації.

- •Ms dos. Пакетні командні файли. Призначення, команди. Утиліта ве.

- •Os/2. Коротка характеристика. Особливості обчислення адреси.

- •Unix: команди керування файлами і каталогами. Права доступу користувачів.

- •Windows. Коротка характеристика. Режими роботи.

- •Класифікація переривань ibm pc. Апаратні переривання. Маскирование апаратних переривань.

- •Оброблювачі переривань ibm pc. Обробка переривань з використанням мов ассемблера і с. Модифікація оброблювачів переривань.

- •Структура дискових томів у ms dos.

- •Керування дисками і каталогами в ms dos.

- •Com і exe програми. Їх особливості і правила написання.

- •Принципи організації взаємодії користувальницької програми з клавіатурою ibm pc.

- •Принципи організації виводу інформації на екран ibm pc.

- •Принципи організації виводу інформації на принтер для ibm pc.

- •Файлова система ms dos, функції з використанням fcb і дескриптора.

- •Основи створення резидентних програм для ms dos.

- •Компоновщики і завантажники. Призначення і застосування.

- •Відладчики, дизасемблери і профайлери. Призначення. Функції і можливості.

- •Утиліти. Призначення. Приклади використання.

- •Комп'ютерна електроніка

- •T, jk, d, rs - тригери. Принцип роботи. Синхронні й асинхронні тригери.

- •Двоступінчасті тригери за схемою ms. Тригери з керуванням по фронту. Принцип роботи. Область застосування.

- •Шифрувачі і дешифрувачі. Синтез комбінаційних схем (кс) на базі дешифрувачів.

- •Мультиплексори. Синтез кс на мультиплексорах.

- •Синтез операційних елементів комбінаційного типу.

- •Регістри. Загальні відомості, класифікація і принцип роботи.

- •Методика синтезу багатофункціональних регістрів.

- •Лічильники. Принцип дії, класифікація. Синтез лічильників з довільним модулем і порядком рахунку.

- •Додавачі. Основні поняття і визначення. Перенос у додавачах.

- •Програмуємі логічні матриці (плм). Синтез схем із застосуванням плм.

- •Запам'ятовуючі пристрої. Класифікація, структура, принцип дії.

- •Постійні запам'ятовуючі пристрої (пзп). Синтез схем на базі пзп.

- •Арифметико-логічні пристрої. Принцип дії, використання в обчислювальній техніці.

- •Розподільники тактів. Методи синтезу розподільників по заданих часових діаграмах.

- •Аналогові обчислювальні машини. Основні вирішальні елементи.

- •Структурні міри інформації. Статична міра інформації, поняття ентропії.

- •2. Комбинаторная мера.

- •3. Логарифмическая мера.

- •Властивості безумовної ентропії.

- •Умовна ентропія, властивості умовної ентропії.

- •Ентропія й інформація, властивості інформації.

- •Квантування інформації. Теорема Котельникова.

- •Основна теорема про кодування для каналу без шуму. Оптимальне кодування.

- •Коди Шеннона-Фано і Хаффмена.

- •Коди, що виявляють помилки і коректують коди. Код Хемминга.

- •Групові коди. Циклічні коди.

- •Семантичний розрив між архітектурою еом і мовами високого рівня.

- •Основи горизонтальної і вертикальної обробки інформації.

- •Використання матричного паралелізму в архітектурі спеціалізованих еом.

- •Використання конвеєрного паралелізму в архітектурі спеціалізованих еом.

- •Заготівля результату в архітектурі спеціалізованих еом.

- •Машини потоків даних.

- •Асоціативні системи.

- •Матричні системи.

- •Конвеєрні системи.

- •Багатопроцесорні системи.

- •Багатомашинні системи.

- •Топологічні структури обчислювальних систем. Приклади реалізацій.

- •Мережі еом

- •Алгоритмічна структура обчислювальних мереж. Призначення протоколів відповідних рівнів.

- •Стандарти комітету ieee в області локальних обчислювальних мереж. Протоколи ieee 802.3, ieee 802.4, ieee 802.5.

- •Стандарт швидкісної оптичної магістралі fddi.

- •Основні складові елементи мережної архітектури.

- •Стандарти швидкісних магістралей Fast Ethernet, Switch Ethernet, 100vg.

- •Архітектурні особливості малих локальних мереж. Структура мережі битбас.

Структурні міри інформації. Статична міра інформації, поняття ентропії.

1. Геометрическая мера.Определяют количество информации по числу информационных элементов (квантов), занимающих определенную область информационного поля.

Информационная емкость – максимальное количество квантов, размещаемых в заданных структурных габаритах.

Например, для трехмерного информационного поля, имеющего по осям координат протяженности X, Y, Z и имеющего шаги квантования по осям DX,DY,DZ информационная емкость будет определяться формулой:

2. Комбинаторная мера.

Количество информации измеряется числом комбинаций информационных элементов в информационной системе.

Для текстовых сообщений наиболее применимый способ комбинирования - размещение с повторением. Наибольшее число комбинаций для этого способа: L=mn

Число размещений из m элементов по n является степенью => зависимость количества информации L от длинны сообщения нелинейна.

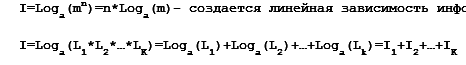

Если

измеряем обобщенное количество информации

нескольких источников сообщений, то

общее количество информации определяется

как произведения информативности

отдельных источников:

![]()

3. Логарифмическая мера.

Автором этой меры является Хартли. Выделение логарифма позволяет избавиться от главного недостатка комбинаторной меры - нелинейной зависимости количества информации от длины сообщения.

Логарифмическая мера определяется по формуле: I=Loga(L)

Основание логарифма (a) определяет единицу измерения количества информации, основание может быть любое, например:

а=10 - единица измерения дит;

а=е - единица измерения нит;

а=2 - единица измерения бит.

1 бит информации содержится в ответе на вопрос, допускающий 2 равновероятных ответа - да или нет. В ответе да/нет один вид информации.

Ентропія є мірою невизначеності випадкової величини. Зазвичай, в якості інформаційної ентропії використовують ентропію Шеннона.

Ентропія Шеннона визначає абсолютну межу найкращого стиснення даних без втрат.

Властивості безумовної ентропії.

Об'єднання - сукупність двох і більше ансамблів дискретних, випадкових подій. З об'єднанням пов'язані поняття умовної, безумовної, спільної та взаємної ентропії.

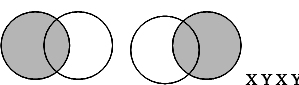

1. Безумовна ентропія - середня кількість інформації, що припадає на один символ (рис. 1). Якщо Х - передається, а У - прийняте повідомлення, то можна записати наступні співвідношення:

H (X) = H (X / Y) + H (X × Y),

H (Y) = H (Y / X) + H (X × Y).

Рис.

1. Безумовна ентропія

Рис.

1. Безумовна ентропія

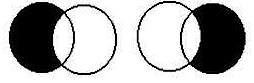

Умовна ентропія, властивості умовної ентропії.

Умовна ентропія - кількість інформації про джерело, коли відомо, що приймається Y, або міра кількості інформації в приймачі коли відомо, що передається X (рис. 2).

H (X / Y) = H (X)-H (X? × Y)

H (Y / X) = H (Y)-H (X? × Y).

X

Y X Y Рис. 2. Умовна ентропія

X

Y X Y Рис. 2. Умовна ентропія

Ентропія й інформація, властивості інформації.

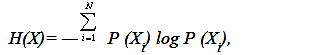

Базисным понятием всей теории информации является понятие энтропии. Энтропия – мера неопределенности некоторой ситуации. Можно также назвать ее мерой рассеяния и в этом смысле она подобна дисперсии. Но если дисперсия является адекватной мерой рассеяния лишь для специальных распределений вероятностей случайных величин (а именно – для двухмоментных распределений, в частности, для гауссова распределения), то энтропия не зависит от типа распределения. С другой стороны, энтропия вводится так, чтобы обладать, кроме универсальности и другими желательными свойствами. Так, мера неопределенности была аддитивной: f(nm)=f(n)+f(m). Именно такая удобная мера неопределенности была введена К. Шенноном:

где

Х – дискретная случайная величина с

диапазоном изменчивости N, P(Xi)

– вероятность i – го уровня X.

где

Х – дискретная случайная величина с

диапазоном изменчивости N, P(Xi)

– вероятность i – го уровня X.