- •Раздел I. Линейные системы. Цифровые фильтры

- •Системы хранения медиаданных

- •Скорости и интерфейсы

- •Расчет аналогового нормированного фильтра нижних частот Баттерворта

- •Df 1. Введение в адаптивные фильтры

- •1.1. Адаптивная обработка данных

- •1.1.1 Адаптивные фильтры

- •1.1.2 Принцип действия адаптивного фильтра

- •1.4 Адаптивные фильтры

- •1.4.1 Адаптивные фильтры с бесконечной импульсной характеристикой

- •1.4.2 Адаптивные фильтры с конечной импульсной характеристикой

- •1.4.3 Адаптивные фильтры, основанные на методах преобразования сигнала

- •3 Адаптивные алгоритмы для фильтров с конечной импульсной характеристикой

- •3.1. Введение

- •4. Адаптивные алгоритмы для фильтров с бесконечной импульсной характеристикой

- •4.1. Введение

- •4.1.1 Общий обзор

- •2.3 Оптимальное рекурсивное калмановское оценивание

- •2.3.1 Скалярный фильтр Калмана

- •2.3.2. Вывод коэффициента фильтра Калмана

- •2.4. Векторный фильтр Калмана

- •2.4.1. Векторный фильтр Калмана в качестве устройства коррекции канала

- •Требования к вейвлетам

- •Свойства вейвлет преобразования

- •Непрерывное вейвлет-преобразование

- •Дискретное вейвлет-преобразование

- •Графическое представление

- •Применение

- •Примечания

- •Чирплет

- •Аналогия с другими преобразованиями

- •Чирплеты и чирплет-преобразование

- •Приложения

- •Систематика чирплет-преобразования

- •Df Глава 1. Постановка задачи и обзор моделей прогнозирования временных рядов

- •1.1. Содержательная постановка задачи

- •1.2. Формальная постановка задачи

- •1.3. Обзор моделей прогнозирования

- •1.3.1. Регрессионные модели

- •1.3.2. Авторегрессионные модели

- •1.3.3. Модели экспоненциального сглаживания

- •1.3.4. Нейросетевые модели

- •1.3.5. Модели на базе цепей Маркова

- •1.3.6. Модели на базе классификационно-регрессионных деревьев

- •1.1.1. Другие модели и методы прогнозирования

- •1.4. Сравнение моделей прогнозирования

- •1.4.1. Достоинства и недостатки моделей

- •1.4.2. Комбинированные модели

- •1.5. Выводы

- •Тема 15. Регрессия

- •Введение

- •15.1. Постановка задачи регрессии

- •15.2. Линейная регрессия [25]

- •15.3. Полиномиальная регрессия [25]

- •15.4. Нелинейная регрессия [25]

- •15.5. Сглаживание данных [25]

- •15.6. Предсказание зависимостей [25]

- •Df Линейная регрессия

- •8. Регрессия

- •8.1. Детерминированные и статистические зависимости

- •8.2. Корреляция и коэффициент корреляции

- •8.3. Уравнения регрессии

- •8.3.1. Линейная регрессия

- •8.3.2. Полиномиальная регрессия

- •8.3.3. Нелинейная регрессия

- •8.4. Сглаживание данных

- •8.5. Предсказание зависимостей

- •Параболическая и экспоненциальная регрессия.

- •Аппроксимация. Параболическая регрессия

- •Интерполяция

- •[Править]Определения

- •[Править]Пример

- •[Править]Способы интерполяции [править]Интерполяция методом ближайшего соседа

- •[Править]Интерполяция многочленами

- •[Править]Определение и история

- •[Править]Классификация сплайнов

- •Интерполяционный сплайн

- •1.4. Линейные операторы

- •Фильтр Гаусса

- •Фильтр Лапласа

- •Компьтерное зрение. Оператор Собеля Среда, Февраль 10th, 2010 | Программирование (10 голосов, средний: 4.60 из 5)

- •Быстрое размытие по Гауссу

15.4. Нелинейная регрессия [25]

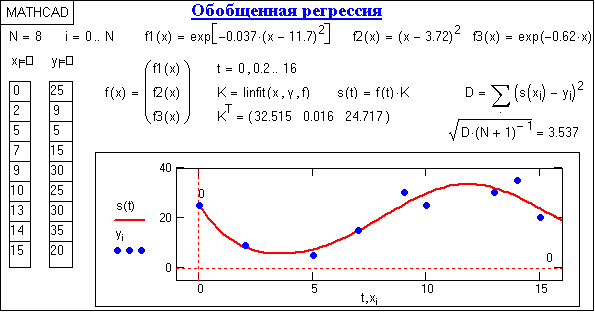

Линейное суммирование произвольных функций. В Mathcad имеется возможность выполнения регрессии с приближением к функции общего вида в виде весовой суммы функций fn(x):

f(x, Kn) = K1 f1(x) + K2 f2(x) + … + KN fN(x),

при этом сами функции fn(x) могут быть любого, в том числе нелинейного типа. С одной стороны, это резко повышает возможности аналитического отображения функций регрессии. Но, с другой стороны, это требует от пользователя определенных навыков аппроксимации экспериментальных данных комбинациями достаточно простых функций.

Рис. 15.4.1. Обобщенная

регрессия.

linfit(X,Y,f),

которая вычисляет значения коэффициентов Kn. Вектор f должен содержать символьную запись функций fn(x). Координаты xk в векторе Х могут быть любыми, но расположенными в порядке возрастания значений х (с соответствующими отсчетами значений yk в векторе Y). Пример выполнения регрессии приведен на рис. 15.4.1. Числовые параметры функций f1-f3 подбирались по минимуму среднеквадратического отклонения.

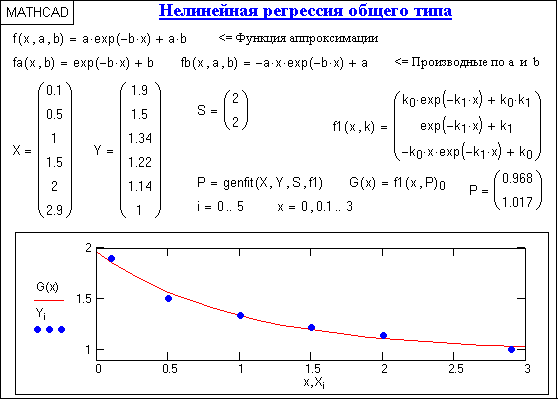

Рис. 15.4.2.

genfit(X,Y,S,F),

которая возвращает коэффициенты ki, обеспечивающие минимальную среднюю квадратическую погрешность приближения функции регрессии к входным данным (векторы Х и Y координат и отсчетов). Символьное выражение функции регрессии и символьные выражения ее производных по параметрам ki записываются в вектор F. Вектор S содержит начальные значения коэффициентов ki для решения системы нелинейных уравнений итерационным методом. Пример использования метода приведен на рис. 15.4.2.

Типовые функции регрессии Mathcad. Для простых типовых формул аппроксимации предусмотрен ряд функций регрессии, в которых параметры функций подбираются программой Mathcad самостоятельно. К ним относятся следующие функции:

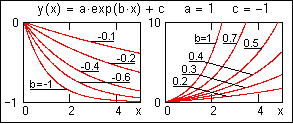

expfit(X,Y,S)

– возвращает вектор, содержащий

коэффициенты a, b и c экспоненциальной

функции y(x) = a·exp(b·x)+c. В вектор S вводятся

начальные значения коэффициентов a, b и

c первого приближения. Для ориентировки

по форме аппроксимационных функций и

задания соответствующих начальных

значений коэффициентов на рисунках

слева приводится вид функций при

постоянных значениях коэффициентов a

и c.

expfit(X,Y,S)

– возвращает вектор, содержащий

коэффициенты a, b и c экспоненциальной

функции y(x) = a·exp(b·x)+c. В вектор S вводятся

начальные значения коэффициентов a, b и

c первого приближения. Для ориентировки

по форме аппроксимационных функций и

задания соответствующих начальных

значений коэффициентов на рисунках

слева приводится вид функций при

постоянных значениях коэффициентов a

и c.

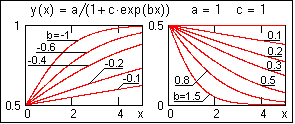

lgsfit(X,Y,S)

– то же, для выражения y(x) = a/(1+c·exp(b·x)).

lgsfit(X,Y,S)

– то же, для выражения y(x) = a/(1+c·exp(b·x)).

pwrfit(X,Y,S)

– то же, для выражения y(x) = a·xb+c.

pwrfit(X,Y,S)

– то же, для выражения y(x) = a·xb+c.

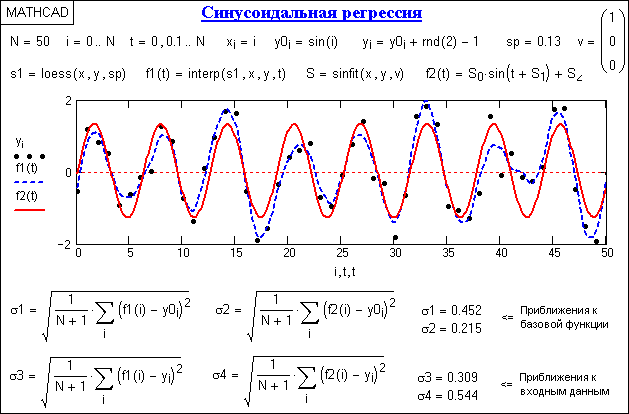

sinfit(X,Y,S) – то же, для выражения y(x) = a·sin(x+b)+c. Подбирает коэффициенты для синусоидальной функции регрессии. Рисунок синусоиды общеизвестен.

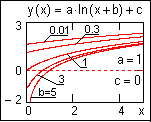

logfit(X,Y)

– то же, для выражения y(x)=a ln(x+b)+c. Задания

начального приближения не требуется.

logfit(X,Y)

– то же, для выражения y(x)=a ln(x+b)+c. Задания

начального приближения не требуется.

medfit(X,Y) – то же, для выражения y(x) = a+b·x, т.е. для функции линейной регрессии. Задания начального приближения также не требуется. График – прямая линия.

Рис. 15.4.3.