3. Смешанные

-iSCSI

-Fibre Channel

-FCIP (Fibre Channel over IP)

-iFCP (Internet Fibre Channel Protocol)

4. Infiniband (?)

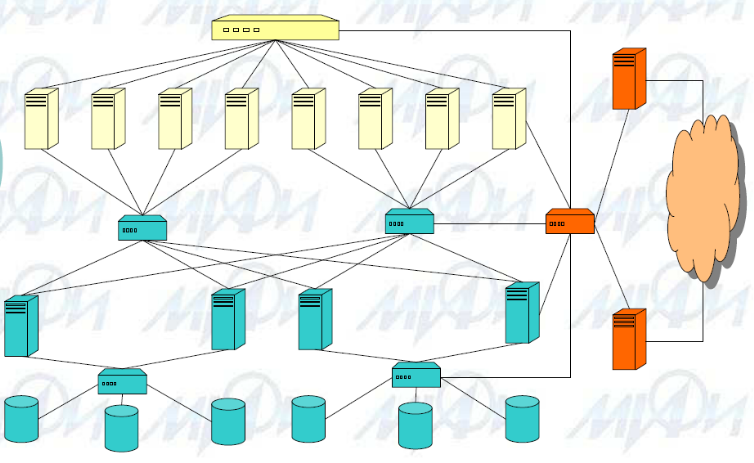

Построен SAN с исп FCoE (CNA) Пр топологии SAN на базе FC: Трехуров топология CE

Достоинства SAN:

- Открытые стандарты

- Обеспечивает непрерывность работы

- Обеспечивает высокую надежность

- Консолидация серверов и хранилищ

- Масштабируемость и реконфигурируемость в реальном времени

- Централизованное управления

- Безопасность

- «Быстрое» создание архивных копий

- Сокращение затрат (TCO, ROI)

Компоненты SAN:

1. Адаптеры для подключения к SAN

-HBA / TBA (FC)

-HCA / TCA (Infiniband)

-NIC / ToE NIC / SNIC (iSCSI)

-CNA (FCoE)

2. Коммуникационное оборудование

-Коммутаторы / Шлюзы / Маршрутизаторы

-Директоры / Бэкбоны

3. Интеллектуальные системы хранения (ISS)

4. Роботизированные ленточные библиотеки

Архитектуры интеллектуальные системы хранения данных (ISS). Обобщенная схема. Архитектура EMC2 CLARiiON. Кэш-память в ISS. Кэш-память EMC2 CLARiiON. Архитектура EMC2 Symmetrix.

Интеллектуальные системы хранения данных представляют собой полно функциональные RAID-массивы, обеспечивающие оптимизированные возможности обработки ввода/вывода. Эти массивы снабжены операционной средой, осуществляющей управление, распределение и использование ресурсов хранения. Такие системы хранения данных конфигурируются с большими объемами памяти, называемой кэш-памятью, и используют сложные алгоритмы обработки вводов/выводов для приложений, для которых производительность систем является критичной.

Обобщенная схема интеллектуальной подсистемы хранения данных

З апрос

ввода/вывода, который приходит от

хост-узла на внешний порт, обрабатывается

посредством кэш-памяти и выходного

блока для получения возможности

сохранять и извлекать данные с физического

диска. Прочитанный запрос может быть

обработан прямо из кэш-памяти, если

запрошенные данные находятся в ней.

апрос

ввода/вывода, который приходит от

хост-узла на внешний порт, обрабатывается

посредством кэш-памяти и выходного

блока для получения возможности

сохранять и извлекать данные с физического

диска. Прочитанный запрос может быть

обработан прямо из кэш-памяти, если

запрошенные данные находятся в ней.

Основные компонентов:

входной блок - обеспечивает интерфейс между системой хранения данных и хост-узлом. Внешние порты позволяют хост-узлам подключаться к интеллектуальной системе хранения данных. Внешние контроллеры направляют данные в кэш-память и обратно по внутренней шине данных.

кэш-память - полупроводниковая память, в которую временно помещаются данные для снижения времени, требуемого на обслуживание запросов ввода/вывода, полученных от хост-узла. Кэш-память улучшает быстродействие системы хранения данных путем изолирования хост-узла от механических задержек, связанных с физическими дисками, которые являются самыми медленными компонентами интеллектуальной системы хранения данных. На доступ к данным, находящимся на физическом диске, требуется несколько миллисекунд, необходимых на поиск и ожидание нужного сектора диска. Если хост-узел запрашивает данные с диска для каждой операции ввода/вывода, запросы ставятся в очередь, что приводит к задержке их выполнения. На доступ к данным из кэш-памяти требуется меньше миллисекунды. Данные для записи помещаются в кэш-память, а затем записываются на диск. После того как данные полностью помещены в кэш-память, на хост-узел немедленно отправляется подтверждающее сообщение.

выходной блок - обеспечивает интерфейс между кэш-памятью и физическими дисками. Из кэш-памяти данные направляются во внутренний блок, а после этого — на диск назначения. Физические диски подсоединены к портам, расположенным на внутреннем блоке. Внутренний контроллер обменивается данными с дисками при выполнении операции чтения и записи, а также обеспечивает дополнительный, хотя и ограниченный, объем памяти для хранения данных.

физические диски - предназначены для постоянного хранения данных. Диски подсоединены к выходному блоку посредством интерфейса SCSI или Fibre Channel.

Примеры интеллектуальных подсистем хранения данных:

1. Pure: EMC CLARiiON Series, Symmetrix DMX Series, Symmetrix VMAX Series

2. Unified: NetApp FAS 6200, 3200, 2000 Series, EMC VNX Series

Архитектура EMC CLARiiON Архитектура памяти EMC CLARiiON

Основные блоки:

Корпус процессора хранилища содержит два процессора хранилища, каждый из которых состоит из одного модулей ЦПУ (1 или 2), памяти и разъемов для модулей ввода/вывода. Процессоры хранилища обеспечивают возможности подключения входного и выходного блоков к хост-узлу и физическому диску соответственно. Процессоры хранилища осуществляют обмен сообщениями между собой посредством коммуникационного интерфейса (СМI), который передает команды, информацию о статусе и данные для зеркального кэширования между процессорами хранилища.

Корпус дискового массива: содержит до 15 дисковых накопителей, две карты управления каналом связи, два источника питания и два вентилятора.

Архитектура EMC Symmetrix

Системный отсек Symmetrix состоит из внешних контроллеров (называемых Диспетчерами канала) для подключения к хост-узлу, глобальной кэш-памяти большой емкости (называемой Диспетчером глобальной памяти) и внутренних контроллеров (называемых Диспетчерами дисков) для подключения к диску.

Отсек накопителя представляет собой корпус, который может вмещать до 240 накопителей.

К омпоненты

EMC Symmetrix:

омпоненты

EMC Symmetrix:

1. До 12 Channel Director

-Fibre Channel, ESCON, FICON, iSCSI, Gigabit Ethernet

2. До 8 Global Memory Director

-2-64 Гбайта DDR SDRAM

-16 портов в/в

3. До 8 Disk Director

-До 2400 дисков

4. 2 Cross Communication Module (XCM)

-Сервисные процессоры

-Коммуникации между директорами

5. Модули PS+UPS+BBU

6. Модули вентиляторов

NAS подход к построению СХД. Обобщенная схема. Классификация архитектур NAS-решений. Основные компоненты NAS-хранилищ. Архитектура EMC2 Celerra, VNX. Тенденция к унификации систем хранения данных.

NAS – Network Attached Storage - специализированное устройство, служащее в качестве выделенного высокопроизводительного шлюза для доступа к разделяемым данным на файловом уровне через сетевую среду общего назначения, как правило, посредством сетевой файловой системы.

По сути, представляет собой компьютер с дисковым массивом (обычно RAID-массивом), предоставляющий доступ к хранимым данным другим клиентам сети. Несколько таких компьютеров могут быть объединены в одну систему.

- Хранилище данных доступное через сеть общего пользования

- Доступ к данным на уровне файловой системы (сетевой): CIFS и NFS

- IDC: в 2012 году более 80% от общего количества

продаваемых хранилищ составят файловые

хранилища

IDC: в 2012 году более 80% от общего количества

продаваемых хранилищ составят файловые

хранилища

Обобщенная структура NAS

Классификация NAS

1. По степени интеграции с устройствами хранения данных

-Integrated NAS(Standalone NAS/NAS server) - Интегрированное сетевое хранилище

-Gateway NAS(NAS head/Proxy NAS)-Шлюз м/д сетевыми клиентами и SAN (иногда DAS) хранилищами

2. По аппаратной базе

-На базе серверов общего назначения

-На базе специализированных аппаратных решений

Примеры NAS серверов:

1.Pure NAS

-EMC Celerra series

-HDS BlueArc Corporation Titan 3200

-HP ProLiant DL585 Storage Server

-Sun ZFS StorageTek 7X20 Series

2. Unified Storage

-EMC Isilion

-EMC VNX / VNXe Series

- NetApp FAS6200 , FAS3200, FAS 2000 series

3. Virtual Appliance / Software

-OpenFiler

-Sun Storage Appliance Software

Компоненты NAS сервера

1. Управляющие узлы

--- Средства управления компонентами системы

--- Обеспечивает контроль взаимодействия

2. Data movers \ Filers – перенос данных

--- Сетевые интерфейсы

--- Интерфейсы к системам хранения

--- Буферная память

--- Работают под специальной ОС

3. Коммуникационные узлы

--- Средства сетевого интерфейса для подсистемы хранения

4.Узлы хранения

--- Управление массивами данных

--- Работают под специальной ОС

5. Вспомогательные узлы

--- Питание

--- Охлаждение

EMC Celerra MPFS: конфигурация системы хранения

EMC Celerra MPFS: Принцип функционирования

EMC Celerra Multi-Path File System (MPFS) по iSCSI или Fibre Channel позволяет приложениям предприятий любого масштаба совместно использовать файлы из тысяч клиентских систем и одновременно обеспечивать самую высокую в мире общую производительность. Система MPFS предназначена для работы в стандартной NAS-среде совместного доступа к файлам без изменения приложений и использует существующую инфраструктуру локальной сети и сети SAN для снижения затрат и упрощения управления.

Шлюзовая платформа Celerra для максимального количества клиентов

и обеспечения высокой пропускной способности.

• EMC Celerra NS40G и NS-G8 под управлением кода DART NAS

• Несколько внутренних массивов хранения EMC Symmetrix или CLARiiON

• Клиенты, серверы приложений или Grid-серверы, предоставляющие системам Celerra доступ к файлам по локальной сети

• Драйвер MPFSi и инициатор SAN (iSCSI или FC), загруженные на каждом клиенте или узле сети распределенных Grid-вычислений, нуждающемся в повышении производительности (нет необходимости загружать MPFS на клиентах, которым требуется стандартный доступ к файлам по протоколу NFS).

• Для iSCSI, CLARiiON CX4, CX3-20 или CX3-40 с подключением по FC/ iSCSI (до 512 клиентов) или MDS-коммутатор EMC Connectrix® c мостом «Fibre Channel–iSCSI» (тысячи клиентов)

Celerra и клиенты MPFS взаимодействуют по IP-сети для обмена метаданными и управляющей информацией, используя протоколы NFS или CIFS. Когда клиент MPFS получает запрос данных от приложения, он использует предоставленные Celerra метаданные для доступа к массиву хранения напрямую, используя SAN с высокой производительностью и малой задержкой.

Унифика́ция - приведение к единообразию, к единой форме или системе.

Потребность в унификации систем хранения данных существует практически у всех компаний, имеющих данные на производительной, масштабируемой дисковой системе хранения. Унифицированные системы ЕМС Celerra представляют собой оптимальное решение для увеличения масштаба виртуализации серверов. Независимо от интересующей заказчиков платформы виртуализации серверов (VMware®, MicrosoftHyper-V™ или Xen), системы ЕМС Celerra полностью сертифицированы для всех поддерживаемых протоколов, что позволяет обеспечить успешное развертывание виртуальных инфраструктур на всех этапах внедрения

NAS подход к построению СХД. Архитектура EMC Isilion. Оценки производительности NAS-серверов.

N AS

– Network Attached Storage

- специализированное устройство,

служащее в качестве выделенного

высокопроизводительного шлюза для

доступа к разделяемым данным на файловом

уровне через сетевую среду общего

назначения, как правило, посредством

сетевой файловой системы.

AS

– Network Attached Storage

- специализированное устройство,

служащее в качестве выделенного

высокопроизводительного шлюза для

доступа к разделяемым данным на файловом

уровне через сетевую среду общего

назначения, как правило, посредством

сетевой файловой системы.

По сути, представляет собой компьютер с дисковым массивом (обычно RAID-массивом), предоставляющий доступ к хранимым данным другим клиентам сети. Несколько таких компьютеров могут быть объединены в одну систему.

- Хранилище данных доступное через сеть общего пользования

- Доступ к данным на уровне файловой системы (сетевой): CIFS и NFS

- IDC: в 2012 году более 80% от общего количества продаваемых хранилищ составят файловые хранилища

Архитектура EMC Isilion:

1. Десятки петабайт в рамках одной файловой системы

2. Линейная масштабируемость

3. Производительность > 1 млн. IOPS

4. Систему используют: NASA, Facebook, Sony, Adobe, Paramount Pictures, Discovery Channel

5. Различные уровни хранения под управлением единой файловой системой – OneFS

6. Типы узлов:

а. S200 (IOPS)

--2 QC CPU; 24-96 GB RAM; 24 SAS HDD, SSD (7-14 TB)

б. X200 (Balance)

--1 QC CPU; 6-48 GB RAM; 12 SATA HDD, SSD (6-36 TB)

в. 36NL, 72NL, 108NL (Cost)

--1 QC CPU, до 16 GB RAM, 36 SATA HDD

г. Accelerators

--Backup (NDMP через FC на ленточные накопители)

--Performance (CPU + RAM, без дисков)

7. Коммуникации

-Внутренние – Infiniband

-Внешние – 1 / 10 Gb Ethernet

Архитектура EMC Isilion: защита данных:

1. Распределение файлов между узлами кластера

2. Защита на уровне файлов

-Зеркалирование: от 2 до 8

-Коды коррекции ошибок (четность): от N+1 до N+4

-Коды Рида-Соломона

3.Управляется политиками на уровне каталогов, подкаталогов и отдельных файлов

4. Активный мониторинг файлов и дисковых компонент с ведением статистики и автоматической миграцией данных

5. Полностью журналируемая файловая система с большим количеством NVRAM (battery packed)

Оценка производительности NAS серверов (System File Server )

1. SPEC SFS97_R1 V3.0

-Тестовый пакет для измерения пропускной способности и времени отклика для файловых серверов с системой NFS

-Учитывается производительность для всех типичных файловых операций

-с 4 квартала 2008 не принимаются результаты тестирования для публикации

2. SPECsfs2008

-Обновлено нагрузочное тестирование для NFSv3 --- Включена поддержка нагрузочного тестирования для CIFS

-Исключена поддержка NFSv2 и транспортного протокола UDP.

-В качестве клиентов могут выступать AIX, FreeBSD, Linux, MacOS X, Solaris 10, Windows-платформы.

Модель ввода-вывода при использовании сетевых файловых систем. Узкие места традиционных архитектур. Архитектура BlueArc SiliconServer.

Последовательность операций ввода/вывода при использовании сетевых файловых систем

С етевая

файловая служба -NAS

етевая

файловая служба -NAS

Единственная разница с одиночной ОС заключается в доставке запросов; вместо нескольких внутренних операций между приложением и Файловой Системой, работающей в составе ядра ОС, встроенная "заглушка" отправляет запросы через сеть, получает ответы и передаёт их приложению. Вся "реальная работа" (обслуживание Таблицы Размещения Файлов и кэша) выполняется на компьютере Файлового Сервера.

Так как только компьютер Файлового Сервера имеет прямой доступ к физическому диску, то все приложения, запущенные на сервере, используют одну и ту же Файловую Систему - Файловую Систему, работающую на Файловом Сервере. Эта Файловая Система гарантирует целостность данных.

Архитектура BlueArc Titan (HDS)

1. Модуль сетевых интерфейсов NIM

2. Модули файловой системы

- FSA/FSX

- FSB

3. Модуль интерфейсов систем хранения

С хема

BlueArc Titan

хема

BlueArc Titan

Физически NAS-решение компании BlueArc представляет собой специализированную систему, управляющую потоком данных и файловых операций, которая для подключения к прикладным серверам и пользователям имеет или 6 1GE портов, или 2 порта по 10GE с одной стороны, а с другой – 4 FC-порта (1, 2 или 4 Gbps) для подключения системы хранения. Для управления имеются еще

четыре 100 Мbps порта.

Программируемые вентильные матрицы – Field Programmable Gate Arrays (FPGA) – основа BlueArc Titan архитектуры. Современные FPGAs – перепрограммируемые интегральные схемы, представляющие собой высокоэффективные аппаратные компоненты/чипы с собственной памятью, буферами ввода-вывода и внутренней синхронизацией.

NAS-решения BlueArc строятся на Titan SiliconServer архитектуре. В ее основе лежит имплементация функций файлового сервера в аппаратуру (чипы и специализированные устройства). Технология SiliconServer представляет множество машин с массовым параллелизмом для реализации функциональности, которая в стандартном файловом сервере выполняется на уровне ОС, но с гораздо более высокой производительностью и надежностью. Однако при этом поддерживаются все стандартные протоколы для коммуникации с существующими клиентскими компьютерами.

NAS-платформа компании BlueArc разработана в 3 отдельных секциях, названных подсистемами:

1. Network Interface Module (NIM) – ответственна за управление всеми Ethernet функциями ввода-вывода, соответствующими OSI уровню 1-4. Функции, имплементированные в NIM-модуль, включают управление Ethernet и Jumbo Ethernet фреймами до 9000 байт, ARP, IP-протоколом и роутингом, а также TCP- и UDP-протоколом.

2. сост из двух модулей – File System Modules (FSA & FSB), поддерживает различные сетевые файловые системы, включая NFS, CIFS, FTP и NDMP, а также объектную файловую систему.

3. Storage Interface Module (SIM) – обеспечивает кэширование и управление для подключенных систем хранения.

Каждая подсистема имеет собственные процессорные мощности и память для управления всеми задачами параллельно. Такая архитектура позволяет всем процессам работать параллельно без влияния на другие процессы, что существенно отличается от архитектуры традиционных NAS-серверов. Каждая из подсистем связана с соседними через 2 высокоскоростных канала, каждый из которых может писать и читать данные со скоростью до 20 Гбит/с без влияния друг на друга, что позволяет реализовать преимущества полной дуплексной связи.

CAS подход к построению СХД. Обобщенный принцип работы. Архитектура EMC2 Centera. Достоинства и недостатки подхода.

CAS

- система хранения данных для хранения

и организации доступа к данным с

неизменным содержимым с учетом

специальных требований по безопасности

данных, времени хранения данных и

доступу к данным. А дресация

объектов данных осуществляется не по

имени, а по содержанию с использованием

дресация

объектов данных осуществляется не по

имени, а по содержанию с использованием

алгоритмов хеширования.

Content-addressable storage (CAS) — архитектура хранения, в которой адресация осуществляется образом хранимых данных. Образ данных хэшируется и хэш используется для его нахождения на устройствах или системах хранения.

Применение CAS-систем:

1. Медицинские учреждения: хранение рентгенограмм, МРТ-снимков,...

2. Банки и финансовые организации: хранение копий чеков, договоров,…

3. Проектные организации: хранение CAD/CAM-документации

4. Библиотеки: хранение копий различных изданий

5. Системы охраны, системы online вещания по требованию: хранение аудио и видео файлов

Достоинства CAS-систем

+ Обеспечивают неизменность и целостность данных

+ Сокрытие от клиентского ПО места хранения данных

+ Отсутствие дублирования данных

+ Быстрый доступ к данным

+ Управление жизненным циклом данных на уровне объектов хранения

+ Независимость от технологии хранения

+ Оптимизированная стоимость владения

+ Масштабируемость

Архитектура EMC Centera

Архитектура Centera представляет собой платформу без единичных точек отказа. В ней используется массив независимых узлов (RAIN). Число идентичных узлов в одной стойке может составлять 16, 24 или 32, что обеспечивает от 4,6 до 9,6 Тбайт защищенной емкости хранения. Каждый узел содержит процессор и 600 Гбайт емкости хранения, на каждом выполняется копия ПО Centera в одном из двух эксплуатационных режимов - узел хранения (обеспечивается долговременное хранение объектов типа BLOP и CDF) и узел доступа (магистраль для взаимодействия между сервером приложений и узлами хранения). Узел связан со всеми другими узлами в кластере через частную локальную сеть.

Узлы доступа не предусматривают долгосрочного хранения контента, поэтому защищенная память кластера Centera определяется исключительно числом узлов хранения. Подобная архитектура обеспечивает системам Centera исключительную масштабируемость и по вместимости, и по производительности, а также простоту управления физическими ресурсами хранения.

Типичной для CAS архитектурой является RAIN (Redundant Arrays of Independent Nodes). Системы состоят из независимо функционирующих узлов хранения. Каждый узел содержит дисковый массив, центральный процессор, память и соединения Ethernet, служащие магистралями связи внутри модуля. Каждый узел, также как и подключаемые к сети устройства хранения, работает со своей собственной операционной системой. RAIN – это своего рода реализация RAID на узлах, а не на дисковых массивах.

Недостатки: можно выделить наличие узлов доступа, пропускающих через себя данные с узлов хранения. Это создает потенциальные узкие места в потоке данных в системе, снижает ее надежность.

RAID-массивы. Классические уровни RAID (0-5). Расширение классических уровней RAID (1E, 5E, 5EE). Сравнение и характеристики.

RAID(redundant array of independent disks — избыточный массив независимых жёстких дисков, 1987-1994) — массив из нескольких дисков, управляемых контроллером, взаимосвязанных скоростными каналами и воспринимаемых внешней системой как единое целое. В зависимости от типа используемого массива может обеспечивать различные степени отказоустойчивости и быстродействия.

Уровни RAID:

- Без обеспечения надежности хранения данных (RAID 0)

- С возможностью потери до 1 жесткого диска (RAID 1-5)

- С возможностью потери до 2 любых дисков (RAID 6)

-Кластерные (комбинированные) – с возможностью потери до 1 (2) дисков из группы (RAID1+0, 0+1)

RAID 0: Дисковый массив без отказоустойчивости (Striped Disk Array): независимые блоки параллельно записываются на диски. Блоки - некий непрерывный файл.

(+): независимость чт/зап блока данных – 1 оп-ция вв/выв – эффективное использование дискового пространства.

(-): низкая надежность, т. к. отказ любого из дисков приводит к неработоспособности всего массива.

Надежнее данные записывать на 1 диск, чем на RAID0.

RAID 1: Дисковый массив с зеркалированием:

(+): высокая надежность

(-): неэффективное использование дискового пространства (избыточность).

RAID 2: Отказоустойчивый дисковый массив с использованием кода Хемминга: диски делятся на 2 группы — для данных (n дисков) и для кодов коррекции ошибок (n − 1 дисков). Данные записываются на как в RAID 0, они разбиваются на небольшие блоки по числу дисков. Оставшиеся диски хранят коды коррекции ошибок, по которым в случае выхода какого-либо жёсткого диска из строя возможно восстановление информации (XOR).

(-): сложная реализация, большое кол-во.

RAID 3: Отказоустойчивый массив с параллельной передачей данных и четностью:

записываются непрерывные блоки данных, разделенные на подблоки. Блоки зап/сч параллельно ЦЕЛИКОМ (А.1,А.2,А.3,А.4)! Всегда по 4. Восстановление: через контрольную сумму (ЕСС:А) через XOR.

В RAID 2 инф-ция на контрольных дисках использовалась для коррекции ошибок на лету, в то время как большинство пользователей удовлетворяет простое восстановление информации в случае поломки диска, для чего хватает информации, умещающейся на одном выделенном жёстком диске.

Отличия RAID 3 от RAID 2: невозможность коррекции ошибок на лету и меньшая избыточность.

Достоинства:

- высокая скорость чтения и записи данных;

- минимальное количество дисков для создания массива равно трём.

Недостатки:

- синхронизация работы дисков в системе

- большая нагрузка на контрольный диск.

- массив этого типа хорош только для однозадачной работы с большими файлами, так как время доступа к отдельному сектору, разбитому по дискам, равно максимальному из интервалов доступа к секторам каждого из дисков. Для блоков малого размера время доступа намного больше времени чтения.

a+b+c+d+c+c*=a+b+c*+d

RAID 4: Массив независимых дисков с разделяемым диском четности: похож на RAID 3, но отличается от него тем, что данные разбиваются на блоки, а не на подблоки. Диск 5 хранит контрольную сумму. Если модифицируем блок В, то модифицируем и контрольную сумму.

Используется фирмой Network Applines (ликвидация недостатков за счет интеллектуального управления размещением данных)

(-): диск 5 – контрольная сумма – наиболее горячая точка в системе, чаще всего выходит из строя.

RAID 5: Отказоустойчивый массив независимых дисков с распределенной четностью: блоки данных и контрольные суммы циклически записываются на все диски массива, нет асимметричности конфигурации дисков.

(+): эффективное использование дискового пространства, высокая скорость на операции чтения, на операции записи ниже: 1 операция записи = 4 оп вв/выв, равномерный износ компонентов.

Применение:наиболее популярный уровень для данных, где не требуется большого кол-ва оп-ций записи. Например, для БД.

RAID 1E: Отказоустойчивый массив с двунаправленным зеркалированием

RAID 5E: создает ряды данных и контрольных сумм во всех дисках массива

RAID 5EE: Отказоустойчивый массив независимых дисков с распределенными четностью и диском горячей подмены: подобен массиву RAID-5E, но с более эффективным использованием резервного диска и более коротким временем восстановления. В отличие от RAID level-5E, использующего неразделенное свободное место для резерва, в RAID level-5EE в резервный диск вставлены блоки контрольных сумм. Это позволяет быстрее перестраивать данные при поломке физического диска.

Подходы к реализации

1. Программный RAID (LVM и т.п.)

2. Аппаратный RAID

-Плата расширения

--Программная реализация на уровне драйвера (интерфейс для подключения HDD)

--Аппаратная реализация (полноценный RAID контроллер)

-Отдельная система (DAS, SAN)

3. Реализация при помощи SAN (виртуализаторы на уровне SAN)

4. Комбинированные подходы

Hot Spare HDDs: Диски «горячей» подмены

-Предназначены для замены вышедших из строя HDD без участия человека

-В нормальном режиме работы не используются

-Могут быть общими для всех групп в комбинированных уровнях RAID

RAID 6. Различные подходы к построению систем уровня RAID 6. Комбинированные уровни RAID. Сравнение и характеристики.

RAID 6: Отказоустойчивый массив независимых дисков с двумя независимыми распределенными схемами четности

1. Обеспечивает надежное хранение данных при выходе из строя до двух дисков

2. Два основных подхода:

- ECC независимые по данным

- ECC независимые по алгоритмам

3. Несколько различных реализаций:

- EVENODD

- X-Code

- С кодами Рида-Соломона (Reed-Solomon) - недвоичные циклические коды, позволяющие исправлять ошибки в блоках данных.

RAID 6: EVENODD

- Коды четности распределены по дискам

- P – XOR внутри горизонтальныхгрупп

- Q – XOR внутри диагональных групп

- Случайная запись вызывает 6 операций ввода/вывода для 13 блоков и 12 для 3 блоков

RAID 6: X-Code

- Количество дисков должно быть простым числом

- P – XOR внутри диагональных групп слева направо

- Q – XOR внутри диагональных групп справа налево

- Случайная запись вызывает 6 операций ввода/вывода

RAID 6: Reed-Solomon

- XOR внутри горизонтальных групп

- R-S внутри горизонтальных групп

- Случайная запись вызывает 6 операций ввода/вывода

- М.б. расширен для обесп надежного хранения данных в случае отказа большего числа дисков (>2)

RAID 1+0: Отказоустойчивый массив с дублированием и параллельной обработкой

RAID 0+1: Отказоустойчивый массив с параллельной обработкой и зеркалированием

RAID 5+0. Отказоустойчивый массив с распределенными блоками четности и повышенной производительностью

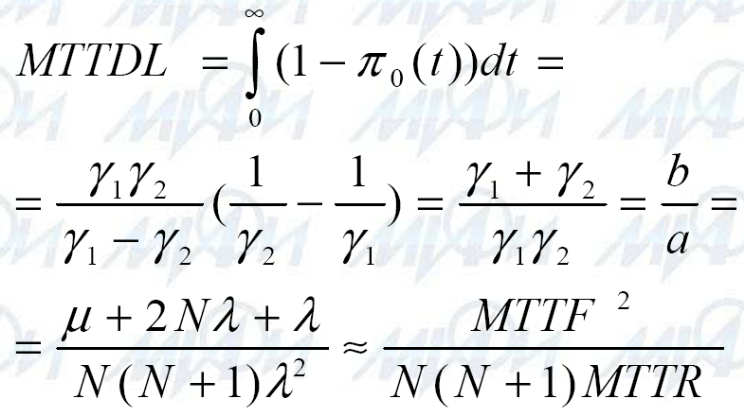

Оценка надежности уровней RAID. Проблема скрытых (отложенных) ошибок. Последовательное моделирование методом Монте-Карло в задачах оценки надежности дисковых массивов (Метод Элиреса).

Оценка надежности:

1. при помощи Марковских цепей (1988)

2. последовательное моделирование методом Монте-Карло – метод Элиреса (Jon G. Elerath) (2007)

Основные метрики надежности для дисковых подсистем

- Среднее время до сбоя (MTTF, MTBF)

- Среднее время восстановления (MTTR)

- Среднее время до потери данных (MTTDL)

- Среднее время до потери доступа к данным (MTTLDA, MTDA)

Оценка надежности дисковых массивов с использованием Марковских цепей

Допущения:

- Интенсивности перехода из одного состояния в другое константы

- В упрощенном случае рассматриваются только дисковые компоненты системы хранения данных

- Массив состоит из N+1 дисков, используется уровень RAID 1-5

- MTTF>>MTTR

Марковская модель системы с восстановлением:

Постановка задачи: Система ур-ий Колмогорова Среднее время до потери данных

Среднее время до потери данных в групповом уровне RAID:

постановка задачи

- Двухуровневый RAID

- Первый из уровней RAID 0, второй позволяет восстановить данные при отказе 1 диска

- N+1-дисков в массиве

- G+1-дисков в группе четности

Марковская цепь, результат

![]()

Усиление модели: вероятность повторного сбоя

Усиление модели: вероятность невосстановимой ошибки при чтении

![]() ,

p - вероятность успешного чтения всех

данных с HDD

,

p - вероятность успешного чтения всех

данных с HDD

Усиление модели: вероятность программного сбоя

![]()

Аппаратная реализация RAID с энергонезависимым КЭШ

![]()

Программная реализация RAID

![]()

Среднее время до потери данных в RAID 6: Марковская цепь

![]()

Недостатки подхода основанного на Марковских цепях

- Частота сбоев является функцией времени

- Частота сбоев зависит от модели компонент

- Время восстановления после сбоя не постоянно, но имеет нижнюю границу

- Невосстановимые ошибки могут случаться в любое время

- В модель необходимо включить наличие скрытых ошибок

Модель сбоев HDD Пример скрытой ошибки

Метод Элиреса для оценки надежности дисковых систем

Используются 4 распределения:

-D(Op) – время до функционального сбоя

-D(Ld) – время до появления скрытой ошибки

-D(Rest) – время восстановления после функционального сбоя

-D(Scrub)-время обнаружения и исправления скрытой ошибки

Диаграмма состояний RAID массива из N+1 дисков

Последовательное моделирование методом Монте-Карло

RAID-массивы. Оценка производительности дисковых подсистем. Расчет необходимого количества HDD в дисковой подсистеме. Эффективность использования адресного пространства. Рекомендации по применению RAID-уровней. Проблемы при использовании RAID систем. Системы хранения без RAID.

Оценка производительности уровней RAID:

а) 4 типа операций: короткое чтение, длинное чтение, короткая запись, длинная запись

б) 2 режима работы: штатный, вырожденный (режим деградации)

в) Зависит от:

--Архитектуры внутренней шины

--Архитектуры внешней шины

--Режимов оптимизации

--Алгоритмов кэширования

г) Подходы к оценке: теоретические, моделирование, тестирование

Оценка производительности: оценка необходимого количества дисков

Приложению требуется X IOPS для нормальной работы, отдельный HDD обеспечивает Y IOPS, доли операций чтения и записи составляют соответственно R и W, операции ввода / вывода носят случайный характер рассчитать необходимое количество дисков в массиве с заданным уровнем RAID

1. N = X*(R*IOPSr +W*IOPSw) / Y

2. R + W = 1

- RAID 0: IOPSr = IOPSw = 1

-- N = X * (R*1 + W * 1) / Y= X/Y

- RAID 5: IOPSr = 1, IOPSw = 4

-- N = X * (R * 1 + W * 4) / Y

- RAID 10: IOPSr = 1, IOPSw = 2

-- N = X * (R * 1 + W * 2) / Y

Эффективность использования емкости массива

Рекомендации по применению RAID-массивов

Кластерные системы. Типы кластерных систем. Достоинства и недостатки архитектуры. Примеры кластерных архитектур. Кластерные системы и СХД.

Кластер (первые идеи 1950-1960)- две или более вычислительных системы (узлы кластера), объединенных при помощи сетевых технологий и представляемых перед пользователем в качестве единого информационно-вычислительного ресурса.

История создания: 1950-1960: Первые идеи, 1967: Закон Амдала (Gene Amdahl), 1984: DELL VAXCluster, 1989: Parallel Virtual Machine

Вычислительная кластерная система: набор рабочих станций общего назначения используемый в качестве дешевого варианта массивно-параллельного компьютера

Классификация кластерных систем: однородность

- Гетерогенные (неоднородные). Пр: theHIVE

- Гомогенные (однородные)

Кластер the HIVE состоит из четырех подкластеров E, B, G, и DL, объединяя 332 процессора и два выделенных хост-узла, содержит 64 узла по 2 процессора Pentium Pro/200MHz и 4GB памяти в каждом, 5 коммутаторов Fast Ethernet. Все узлы данного кластера работают под управлением RedHat Linux.

Классификация кластерных систем: Радаевского-Эдлайна

Класс I: Стандартные компоненты

Класс II: Эксклюзивные или не широко распространенные компоненты

Классификация кластерных систем: решаемые задачи

1. Системы высокой доступности / надежности (High availability (HA) / failover )

- Two-node Active/Passive: с холодным резервом или активный/пассивный. Активный узел выполняет запросы, а пассивный ждет его отказа и включается в работу, когда таковой произойдет.

- Multinode Active/Passive (N+I): с горячим резервом или активный/активный. Все узлы выполняют запросы, в случае отказа одного нагрузка перераспределяется между оставшимися.

- Active/Active: с модульной избыточностью. Применяется только в случае, когда простой системы совершенно недопустим. Все узлы одновременно выполняют один и тот же запрос (либо части его, но так, что результат достижим и при отказе любого узла), из результатов берется любой.

2. Многопоточные системы (Network Load Balancing (NLB) / throughput / capacity)

3. Системы для высокопроизводительных вычислений (High performance Computing (HPC))

4. Load-balancing clusters. (распределение вычислительной нагрузки)

Границы между этими типами кластеров до некоторой степени размыты, и кластер может иметь такие свойства или функции, которые выходят за рамки перечисленных типов.

Более того, при конфигурировании большого кластера, используемого как система общего назначения, приходится выделять блоки, выполняющие все перечисленные функции.

Достоинства кластерных систем:

- Производительность(performance)

- Масштабируемость(scalability)

- Наращиваемость(upgradeability)

- Соотношение производительность/стоимость (price/performance)

П ри

всех своих достоинствах (дешевизна,

масштабируемость),недостатками

кластерных систем

являются непредсказуемый характер

сетевого трафика и конфликты в сети,

высокое время ожидания сообщений.

Поэтому скорость кластеров меньше

скорости мультипроцессорной системы

при одинаковом количестве процессоров.

ри

всех своих достоинствах (дешевизна,

масштабируемость),недостатками

кластерных систем

являются непредсказуемый характер

сетевого трафика и конфликты в сети,

высокое время ожидания сообщений.

Поэтому скорость кластеров меньше

скорости мультипроцессорной системы

при одинаковом количестве процессоров.

Системы хранения данных для кластерных систем

- Использование специализированных узлов для хранения и распределения данных

- Использование специализированных кластерных файловых систем

Кластерные файловые системы:

Системы хранения ↔ кластерные системы

1. Кластеры в системах хранения:

- NAS сервера (ПР.: BlueArc Titan,..)

- Системы виртуализации (ПР.: EMC Invista,..)

2. Системы хранения в кластерах: NAS, SAN

Компоненты кластерных систем. Оценка эффективности выполнения программ на многопроцессорных системах. Закон Амдала. Анализ масштабируемости кластерных систем.

Компоненты кластерных систем:

1. Окружение:

--Пространство под кластер

--Вентиляция

--Энергообеспечение

--Обслуживающий персонал

2. Узлы:

--Вычислительные узлы

--Управляющие узлы

--Узлы хранения и распределения данных

3. Сетевые технологии:

--Fast/Gigabit Ethernet

--Myrinet

--InfiniBand Architecture

4. Сетевые протоколы:

--TCP/IP

--Virtual Interface Architecture (VIA)

--Grand Message (GM)

5. ОС:

--Linux based (Scientific Linux и т.д.)

--UNIX based

--Microsoft Windows based (Computer Cluster Server 2003)

6. Промежуточное ПО:

--OSCAR

--SCYLD

--SCore

7. Библиотеки передачи сообщений:

--MPI

--MPICH

--PVM

8. Параллельное приложение

Стек компонент кластерной системы Закон Амдала: обобщенный вид

Закон Амдала: иллюстрирует ограничение роста производительности вычислительной системы с увеличением количества вычислителей.

![]()

- S – ускорение выполнения приложения на кластерной системе

- P - количество узлов в кластерной системе

- F – доля последовательной части программы по времени выполнения

Анализ масштабируемости кластерных систем с учетом накладных расходов

Выводы:

- Эффективность падает с увеличением числа процессоров

- Эффективность растет с увеличением сложности задачи

Кластерные системы. Проблема организации связей между узлами кластера. Типы сетей в кластерах. Стандартные сетевые технологии, применяемые для соединения узлов (Ethernet, Infiniband). Технология RDMA.

Сеть кластера в первую очередь предназначена не для связи машин, а для связи вычислительных процессов. Поэтому чем выше будет пропускная способность вашей сети, тем быстрее будут считаться параллельные задачи, запущенные на кластере.

Параметры сетевого оборудования:

Пропускная способность - это скорость передачи данных между двумя узлами после того, как связь установлена.

Латентность - это среднее время между вызовом функции передачи данных и самой передачей. Время затрачивается на адресацию информации, срабатывание промежуточных сетевых устройств, прочие накладные расходы, возникающие при передаче данных.

С етевые

технологии для кластерных систем

етевые

технологии для кластерных систем

Gigabit Ethernet:

- Производители: Intel, Broadcom,…

- Пропускная способность TCP/IP: до 120 Мбайт/с

- Пропускная способность MPI:до 70 Мбайт/с

- Задержка: ~50 мкс

- Топология: Коммутируемая