- •Министерство общего и профессионального образования российской федерации

- •А.А.Ожиганов, м.В.Тарасюк передача данных по дискретным каналам

- •30 Ноября 1998 г., протокол № 14

- •3 Февраля 1999 г., протокол № 2

- •Оглавление

- •2.4.Энтропийные и информационные характеристики случайных последовательностей 46

- •3.3. Кодирование в дискретных каналах с шумами 60

- •1.Сигналы и помехи в системах передачи информации

- •2.Дискретные каналы

- •2.1. Собственная информация. Взаимная Информация

- •2.2.Средняя собственная информация (энтропия)

- •2.3.Средняя взаимная информация

- •2.4.Энтропийные и информационные характеристики случайных последовательностей

- •3.Кодирование. Пропускная способность канала

- •3.1.Основные определения.

- •3.2.Кодирование в дискретных каналах без шумов

- •3.3. Кодирование в дискретных каналах с шумами

- •4.Передача непрерывных сообщений по дискретным каналам

- •5.Частотное согласование сигналов и каналов

- •6.Практические задания Задание 1 Решение задач по основным разделам теории информации

- •Задание 2 Анализ избыточности дискретных сообщений

- •Задание 3 Эффективное кодирование дискретных сообщений

- •Задание 4 Помехоустойчивое кодирование двоичных сообщений с использованием кодов Хемминга

- •Задание 5 Декодирование кодов Хемминга

- •Задание 6 Помехоустойчивое кодирование двоичных сообщений с использованием циклических кодов

- •Задание 7 Декодирование циклических кодов

- •Задание 8 Передача данных на основе импульсно-кодовой модуляции

- •Задание 9 Частотное согласование сигналов и каналов

- •Ответы, решения, методические указания

- •2.2.Средняя собственная информация (Энтропия)

- •2.3.Средняя взаимная информация

- •2.4.Энтропийные и информационные характеристики случайных последовательностей

- •Л и т е р а т у р а

2.Дискретные каналы

2.1. Собственная информация. Взаимная Информация

Описание дискретного канала

Дискретным называется канал, сигналы на входе и выходе которого являются последовательностями случайных дискретных величин (символов).

Для полного описания канала на интервале времени, соответствующем передаче одного символа, необходимо задать ансамбли символов на входе X и выходе Y и условные вероятности переходов p(yk/xj).

Будем обозначать

X={x1,x2,…,xj,…,xn; p(x1),p(x2),…,p(xj),…,p(xn)} - ансамбль сообщений на входе,

Y={y1,y2,…,yk,…,yn; p(y1),p(y2),…,p(yk),…,p(yn)} - ансамбль сообщений на выходе.

Собственная информация

Поскольку появление символа сообщения xj на входе дискретного канала есть событие случайное, то говорят, что имеет место неопределенность исхода. В результате опыта неопределенность уменьшается, и при этом получается некоторое количество информации.

Тогда собственная информация символа xj (количество информации, доставляемое самим символом xj или любым другим, однозначно с ним связанным) определяется как

I(xj) = log 1/p(xj) = - log p(xj), (2.1.1)

т.е. информация в каком-либо событии измеряется логарифмом величины, обратной вероятности его появления.

Выбор основания логарифма loga p(xj) определяет единицу количества информации. Если а = 2, то единица информации называется двоичной (бит), при а = е - натуральной (нат), а при а = 10 - десятичной (дит, хартли). Двоичная единица количества информации, например, есть собственная информация символа, обладающего двумя равновозможными состояниями. Переход от одной системы логарифмов к другой равносилен простому изменению единицы измерения информации. Этот переход осуществляется по формуле

logb k = logb a loga k .

Отсюда 1 нат = log2 e бит= 1,443 бит,

1 дит = log2 10 бит = 3,32 бит.

Условная собственная информация

В общем случае символы X и Y на входе и выходе дискретного канала зависимы. Пусть p(xj / yk) - условная вероятность того, что реализовалось состояние xj ансамбля X при условии, что ансамбль Y принял состояние yk. Тогда, по аналогии с собственной, информация, содержащаяся в символе xj при условии, что сигнал принял значение yk, определяется как

I(xj / yk) = - log p(xj / yk), (2.1.2)

и называется условной собственной информацией.

Взаимная информация

Рассмотрим снова ансамбли X и Y. Пусть ансамбли зависимы. В результате опыта (приема символа yk) апостериорная вероятность появления символа xj изменяется по сравнению с априорной. Тогда количество информации относительно символа сообщения xj, доставляемое символом yk, можно определить как логарифм отношения апостериорной вероятности к априорной

I(xj ; yk) = log (p(xj / yk))/ p(xj). (2.1.3)

Таким образом и определяется взаимная информация.

Основные свойства взаимной информации

1.Взаимная информация может быть отрицательной, положительной или равной нулю, в зависимости от соотношения между априорной и апостериорной вероятностями

- < I(xj ; yk) < (2.1.4)

2.Взаимная информация не превышает собственную

I(xj ; yk) I(xj)

I(xj ; yk) I(yk). (2.1.5)

При данной вероятности p(xj) взаимная информация I(xj ; yk) достигает максимума, когда принятый символ yk однозначно определяет переданный символ xj , при этом

и это максимальное значение взаимной информации

I(xj ; yk) = - log p(xj) ,

равно собственной информации, определяемой только априорной вероятностью символа xj .

3.Свойство симметрии

I(xj ; yk) = I( yk ; xj) , (2.1.6)

т.е. информация, содержащаяся в yk относительно xj , равна информации, содержащаяся в xj относительно yk . В силу этого свойства информацию I(xj ; yk) называют взаимной информацией между xj и yk .

4.Свойство аддидивности количества информации

I(xj , zi; yk, ql) = I(xj ; yk) + I( zi ; ql) . (2.1.7)

Если пара X,Y независима от пары Z,Q , то информация, содержащаяся в паре yk, ql относительно пары xj , zi, равна сумме информации, содержащейся в yk относительно xj , и информации, содержащейся в ql относительно zi .

Решение типовых примеров

Пример 2.1.1. Определить собственную информацию, содержащуюся в изображении, при условии, что оно разлагается на 500 строк по 500 элементов в каждой строке. Яркость каждого элемента передается 8 квантованными уровнями. Различия градации яркости равновероятны, а яркости разных элементов статистически независимы.

Решение. Обозначим случайной величиной Х яркость одного элемента изображения. По условию задачи все градации яркости одинаково вероятны, т.е. p(xj) = 1/n, где n = 8 и, следовательно, собственная информация одного элемента по формуле (2.1.2)

I(xj) = log2 n .

Изображение содержит

N = 500500 = 2.5105 элементов.

Так как яркости элементов независимы, то по свойству аддитивности информации

I(изображения) = N I(xj) = N log2 n = 2.51053 = 7.5105 бит.

Пример 2.1.2. На экране индикатора РЛС, представляющего поле с 10 вертикальными и 10 горизонтальными полосами, появляется изображение объекта в виде яркостной отметки. Все положения объекта равновероятны.

Определить количество информации, содержащееся в сообщениях:

а)объект находится в 46-м квадрате экрана;

б)объект находится в 5-й горизонтальной строке экрана.

Решение. а) Пусть х46 – сообщение о том, что объект находится в 46-м квадрате экрана.

Собственная информация в этом сообщении по формуле (2.1.1) I(x46)=-log2 x46. Безусловная вероятность сообщения - объект находится в 46-м квадрате экрана – равна

p(x46) = m / n,

где n – общее число возможных исходов (квадратов поля),

m – число исходов, благоприятствующих событию x46 .

По условию задачи n=100 (квадратов), а m =1. Тогда

p(x46) = 1 / 100 и I(x46)=-log2 1/100= log2 100=6.64 бит.

б) Вероятность события y5 - объект находится в 5-й горизонтальной строке экрана, по аналогии с рассмотренным случаем а), определяется так:

p(y5) = m / n где n=100, m =10 и p(y5) = 10 / 100 =1/10.

Собственная информация

I(y5) =)= -log2 1 / 10 = log2 10 = 3.32 бит.

Пример 2.1.3..Рассматривается ансамбль сообщений, приведенный в таблице

|

xi |

x0 |

x1 |

x2 |

x3 |

x4 |

x5 |

x6 |

|

p(xj) |

1/2 |

1/4 |

1/8 |

1/32 |

1/32 |

1/32 |

1/32 |

|

Код |

001 |

010 |

100 |

011 |

101 |

110 |

111 |

Сообщение x4 поступает в кодер. Вычислить дополнительную информацию об этом сообщении, доставляемую каждым последующим символом на выходе кодера.

Решение. На вход кодера поступают сообщения x0,x1,…, x6 и кодер порождает соответствующие таблице двоичные символы. Так, сообщению x4 . соответствует кодовое слово 101. Символы на выходе кодера появляются последовательно, т.е. первый символ 1, второй 0 и третий 1. Первый символ кодового слова содержит некоторую информацию относительно того, какое сообщение поступает на вход кодера. Так, первый символ 1 показывает, что на выходе могут быть сообщения x2, x4, x5 или x6 . Второй символ 0 сужает выбор – теперь на входе возможно обно из двух сообщений: x2 или x4 . И, наконец, последний, третий символ 1 однозначно определяет переданное сообщение.

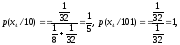

Как известно, взаимная информация есть некоторая (логарифмическая) функция изменения вероятностей. Тогда по формуле (2.1.3) взаимная информация, содержащаяся в первом кодовом символе 1 относительно сообщения x4 ,

I(x4 ; 1) = log (p(x4 / 1))/ p(x4).

Вероятность p(x4 / 1) может быть найдена по формуле Байеса. Условная вероятность гипотезы

В нашем случае гипотезы x0,x1,…, x6 (Hi) , а случайное событие А, имеющее место при некоторой гипотезе, есть появление кодового символа 1 на выходе кодера. Тогда формула Байеса примет такой вид:

где

т.е. условная вероятность p(1/ x4)=0 для гипотез, у которых первый кодовый символ 0, и p(1/ x4)=1 для гипотез, у которых первый кодовый символ 1. В формуле Байеса учитываются, таким образом, те гипотезы, при которых возможно появление 1 на первом месте.

Итак

и взаимная информация, содержащаяся в первом кодовом символе относительно сообщения x4,

Информация, содержащаяся во втором кодовом символе 0 при условии, что первый кодовый символ был 1, есть

Информация, содержащаяся в третьем кодовом символе 1 при условии, что ему предшествовали 10, есть

Так как сообщения xj и кодовые слова однозначно связаны, то

I(x4) = I(x4;1) + I(x4;0/1) + I(x4;1/10).

Действительно, I(x4) = - log2 p(x4) = - log2 32 =5 бит и это равно

I(x4) = I(x4;1) + I(x4;0/1) + I(x4;1/10=

=2.2 + 0.48 + 2.32 =5 бит.

Пример 2.1.4.По дискретному каналу передаются сообщения x1 и x2. Вследствие действия шумов на выходе канала появляются сигналы y1, y2 и y3. Вероятности совместного появления заданы в таблице

|

xj |

yk | ||

|

|

y1 |

y2 |

y3 |

|

x1 |

1/4 |

1/16 |

1/8 |

|

x2 |

1/8 |

3/16 |

1/4 |

Вычислить взаимные информации I(x2 ; y2), I(x1 ; y3).

Решение. Дискретный канал с шумом удобно изображать в виде графа

Определим взаимную информацию по формуле (2.1.3)

I(x1 ; y3) = log (p(x1 / y3))/ p(x1)

или в силу свойства симметрии

I(x1 ; y3) = I(y3 ; x1 ) = log (p( y3 / x1))/ p(y3).

Условные и безусловные вероятности найдем, воспользовавшись таблицей. По формуле (1.3)

p(x1)= p(x1, y1)+ p(x1, y2)+ p(x1, y3)=

=1/4+1/16+1/8=7/16;

p(x2)= 1/8+3/16+1/4=9/16; p(y1)=1/4+1/8=3/8;

p(y2)=1/16+3/16=1/4; p(y3)=1/8+1/4=3/8.

Найдем условные вероятности

p( y2 / x2) = p(x2 , y2))/ p(x2)=(3/16)/(9/16)=1/3;

p(x1 / y3) = p(x1 ; y3))/ p(y3)=(1/8)/(3/8)=1/3.

Тогда количество взаимной информации по формуле (2.3.1)

I(x2 ; y2) = log2 p( y2 / x2 ))/ p(y2)= log2 (1/3)/(1/4)=

=2 – 1.585 =0.415 бит .

I(x1 ; y3) = log2 p( x1 / y3 ))/ p(x1)= log2 (1/3)/(7/16)=

= log2 16/21= 4 – 4.39 = -0.39 бит .

Мы получили I(x1 ; y3) < 0 , так как p(x1 / y3)< p(x1).

Задачи

2.1.1.На шахматной доске произвольным образом расставлены фигуры. Априори все положения фигур на доске одинаково вероятны. Определить собственную информацию, получаемую от сообщения, что фигура находится в одной из угловых клеток доски.

2.1.2.Сколько информации содержится в сообщении о том, что сумма очков на двух подброшенных игральных костях есть четное число ?

2.1.3.Сколько информации содержится в сообщении о том, что сумма очков на двух подброшенных игральных костях равна 7 ?

2.1.4.Бросаются одновременно две игральные кости. Определить количество информации, содержащееся в сообщении о том, что произведение чисел выпавших очков четно.

2.1.5.В цехе работают 7 мужчин и три женщины. По табельным номерам наудачу отобраны 3 человека. Найти количество информации, содержащееся в сообщении "все отобранные люди - мужчины".

2.1.6.Из шести букв разрезной азбуки составлено слово "машина". Ребенок, не умеющий читать, рассыпал эти буквы и затем собрал в произвольном порядке. Какое количество информации будет содержаться в утверждении, что у него снова получилось слово "машина" ?

2.1.7.Два стрелка, для которых вероятности попадания в мишень равны соответственно 0.6 и 0.7, производят по одному выстрелу. В результате оказалось, что мишень поражена. Какое количество информации содержится в сообщении ?

2.1.8.Урна содержит 5 черных и 10 белых шаров. Случайно, без возвращения, из урны вынимают 3 шара и результат опыта передается по системе связи. Пусть шары выбраны в следующей последовательности: черный, черный, белый.

Какое количество информации надо передать, если:

а) интересоваться только числом шаров ?

б) представляет интерес также и порядок, в котором выбраны шары ?

2.1.9.В некотором городе четверть женщин - блондинки, половина - брюнетки и четверть шатенки. Блондинки всегда приходят на свидание вовремя, брюнетки - кидают монету и в зависимости от результата приходят вовремя или опаздывают, а шатенки всегда опаздывают.

1.Определить взаимную информацию между высказыванием "женщина пришла на свидание вовремя" относительно каждого из следующих предложений:

а) она блондинка;

б) она брюнетка;

в) она шатенка.

2.Сколько информации содержится в высказывании "женщина пришла вовремя на 3 свидание подряд" относительно предложения, что она брюнетка ?

2.1.10.При фототелеграфной передаче изображения кадр состоит из 2,5106 элементов. Для хорошего воспроизведения необходимы 12 градаций (уровней) яркости. Предполагается, что все уровни яркости встречаются с одинаковой вероятностью. Элементы изображения независимы. Какое количество информации надо передать по каналу связи, если передача продолжается 5 минут ?

2.1.11.По дискретному каналу передаются сообщения x1,x2,,x3. Вследствие действия шумов на выходе канала появляются сигналы y1 и y2. Вероятности совместного появления заданы в таблице

|

xj |

yk | |

|

|

y1 |

y2 |

|

x1 |

0,4 |

0,1 |

|

x2 |

0,2 |

0,15 |

|

x2 |

0,1 |

0,05 |

Вычислить взаимные информации I(x1 ; y2), I(x3 ; y1), I(x2 ; y2).

2.1.12.По двоичному каналу с шумом передается сообщения x1,x2,,x3 с вероятностями 0.2, 0.3 и 0.5. На выходе канала появляются сигналы y1, y2,y3. Вероятности искажения в канале (условные вероятности переходов):

p(y1 / x1) = 3/4 ; p(y1 / x2) = 1/8 ; p(y1 / x3) = 1/8 ,

p(y2 / x1) = 1/8 ; p(y2 / x2) = 3/4 ; p(y2 / x3) = 1/8 ,

p(y3 / x1) = 1/8 ; p(y3 / x2) = 1/8 ; p(y3 / x3) = 3/4 .

Вычислить взаимные информации I(x1 ; y3) и I(x3 ; y1).

2.1.13.По двоичному каналу с помехами передаются равновероятные и статистически независимые сообщения x1 и x2. В результате действия помех они преобразуются в сигналы y1, y2, y3 . Условные вероятности переходов p(yk / xj) заданы в таблице:

|

xj |

yk | ||

|

|

y1 |

y2 |

y3 |

|

x1 |

5/8 |

2/8 |

1/8 |

|

x2 |

1/8 |

5/8 |

2/8 |

Вычислить взаимные информации I(x1 ; y3) и I(x2 ; y2).

2.1.14.Рассматривается ансамбль сообщений, приведенный в таблице

|

xi |

x0 |

x1 |

x2 |

x3 |

x4 |

x5 |

x6 |

x7 |

|

p(xj) |

1/4 |

1/4 |

1/8 |

1/8 |

1/16 |

1/16 |

1/16 |

1/16 |

|

Код |

000 |

001 |

010 |

011 |

100 |

101 |

110 |

111 |

Сообщение x2 поступает в кодер. Вычислить дополнительную информацию об этом сообщении, доставляемую каждым последующим символом на выходе кодера.

2.1.15.Сообщения источника x1, x2, x3, x4 для согласования с каналом кодируются в соответствии с таблицей

|

Сообщения xi |

x1 |

x2 |

x3 |

x4 |

|

p(xj) |

1/2 |

1/4 |

1/8 |

1/8 |

|

Код |

000 |

011 |

101 |

100 |

Пусть на вход кодера поступает сообщение x3. Вычислить дополнительную информацию об этом сообщении, которую содержит каждый последующий символ на выходе кодера.

2.1.16.Среди студенток некоторого института 25 % всех девушек - блондинки, а 75 % всех блондинок имеют голубые глаза; всего же голубые глаза имееют половина всех девушек. Пусть мы знаем, что некоторая студентка имеет голубые глаза. Сколько дополнительной информации будет содержаться в сообщении о том, что эта девушка – блондинка ?