- •Предисловие.

- •1. Основные задачи искусственного интеллекта.

- •1.1. История развития систем искусственного интеллекта.

- •1.2. Обзор основных направлений в области искусственного интеллекта

- •1.3. Решение задач и искусственный интеллект

- •1.3.1. Графовое представление задачи в пространстве состояний.

- •1.3.2. Стратегии поиска в пространстве состояний

- •2. Проблемная область искусственного интеллекта

- •2.1. Представление знаний

- •2.2 Модели представления знаний

- •2.2.1. Семантические сети

- •2.2.2. Фреймы

- •2.2.3. Формальные логические модели

- •2.2.4. Продукционная модель

- •2.2.5. Вывод на знаниях

- •3. Сильные методы решения задач. Экспертные системы

- •3.1. Структура экспертных систем

- •3.2. Классификация экспертных систем

- •3.3. Отличие эс от других программных продуктов

- •3.4. Цикл работы экспертных систем

- •3.5. Технология проектирования и разработки экспертных систем

- •4. Принятие решений в условиях неопределенности

- •4.1. Нечеткая логика

- •4.1.1. Нечеткие множества

- •4.1.2. Более строгое представление о нечетких множествах

- •4.1.3. Основные характеристики нечетких множеств

- •4.1.4. Примеры нечетких множеств и их характеристик

- •4.1.5. Операции над нечеткими множествами

- •4.1.6. Четкое множество α-уровня (или уровня α)

- •4.1.7. Нечеткая и лингвистическая переменные

- •4.1.8. Нечеткие числа

- •5. Машинное обучение на основе нейронных сетей

- •5.1. Биологический нейрон и его математическая модель

- •5.1.1. Биологический нейрон

- •5.1.2. Искусственный нейрон

- •5.2. Нейросети

- •5.2.1. Классификация и свойства нейросетей

- •5.2.2. Обучение искусственных нейронных сетей

- •5.3. Теорема Колмогорова

- •5.4. Персептрон

- •5.4.1. Алгоритм обучения персептрона

- •5.4.2. Линейная разделимость и персептронная представляемость

- •Логическая функция

- •Входы и выходы нейронов сети,

- •5.5. Сеть обратного распространения

- •5.5.1. Алгоритм обучения сети обратного распространения

- •5.6. Сеть встречного распространения

- •5.6.1. Сеть Кохонена. Классификация образов

- •5.6.2. Алгоритм обучения сети Кохонена

- •5. 6.3. Нейроны Гроссберга. Входные и выходные звезды

- •5.6.4. О бучение входной звезды

- •5.6.5. Обучение выходной звезды

- •5.6.6. Двухслойная сеть встречного распространения

- •5.6.7. Алгоритм обучения сети встречного распространения

- •5.7. Стохастические сети

- •5.7.1. Обучение Больцмана

- •5.7.2. Обучение Коши

- •5.8. Сети с обратными связями

- •5.8.1. Сеть Хопфилда

- •5.8.2. Правило обучения Хебба

- •5.8.3. Процедура ортогонализации образов

- •5.9. Сеть дап (двунаправленная ассоциативная память)

- •5.10. Сеть арт (адаптивная резонансная теория)

- •5.10.1. Алгоритм функционирования сети арт-1

- •Список иллюстраций

5.8.2. Правило обучения Хебба

Метод обучения для сети Хопфилда опирается на исследования Дональда Хебба, реализовавшего простой механизм обучения, названный правилом Хебба. Рассмотрим его подробно.

Пусть

задана обучающая выборка образов

,

![]() Требуется

построить матрицу связей W

такую,

что соответствующая нейронная сеть

будет иметь в качестве стационарных

состояний образы обучающей выборки

(значения порогов нейронов

.

положим равными нулю). В случае

одного обучающего образа

Требуется

построить матрицу связей W

такую,

что соответствующая нейронная сеть

будет иметь в качестве стационарных

состояний образы обучающей выборки

(значения порогов нейронов

.

положим равными нулю). В случае

одного обучающего образа

![]()

![]() правило Хебба

приводит к матрице

правило Хебба

приводит к матрице

![]() Покажем, что состояние Y=X

является

стационарным для сети Хопфилда с данной

матрицей W.

Действительно,

значение функции энергии в состоянии

X

является

для нее

глобальным минимумом:

Покажем, что состояние Y=X

является

стационарным для сети Хопфилда с данной

матрицей W.

Действительно,

значение функции энергии в состоянии

X

является

для нее

глобальным минимумом:

![]() ,

,

т. е. сеть прекратит изменения, достигнув состояния X

Для

запоминания K

образов

применяется итерационный процесс:

![]()

![]() (считаем,

что

(считаем,

что

![]() ).

Этот процесс приводит

к полной матрице связей:

).

Этот процесс приводит

к полной матрице связей:

![]()

Сеть Хопфилда нашла широкое применение в системах ассоциативной памяти, позволяющих восстанавливать идеальный образ по имеющейся неполной или зашумленной его версии.

Пример

5.1. В качестве примера рассмотрим сеть, состоящую из 70 нейронов, упорядоченных в матрицу 10 х 7.

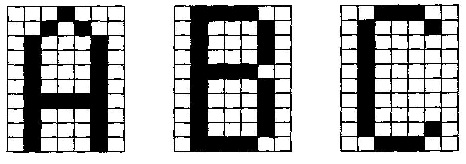

Сеть обучалась по правилу Хебба на трех идеальных образах — шрифтовых начертаниях латинских букв А, В и С (рис. 6.21). Темные ячейки соответствуют нейронам в состоянии +1, светлые — 1.

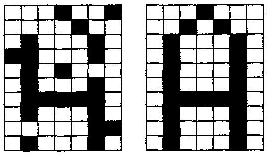

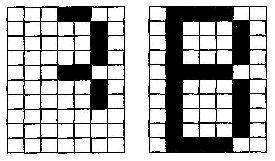

После обучения нейросети в качестве начальных состояний нейронов предъявлялись различные искаженные версии образов, которые в процессе функционирования сети сходились к стационарным состояниям. Для каждой пары изображений на рис. 6.22—6.24 левый образ является начальным состоянием, а правый — результатом работы сети — достигнутым стационарным состоянием.

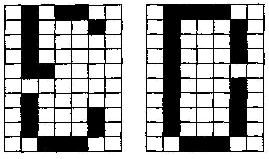

Опыт практического применения сетей Хопфилда показывает, что эти нейросетевые системы способны распознавать практически полностью зашумленные образы и могут ассоциативно узнавать образ по его небольшому фрагменту. Однако особенностью работы данной сети является возможная генерация ложных образов. Ложный образ является устойчивым локальным минимумом функции энергии, но не соответствует никакому идеальному образу. На рис. 6.24 показано, что сеть не смогла различить, какому из идеальных образов (В или С) соответствует поданное на вход зашумленное изображение и выдала в качестве результата нечто собирательное.

Рис. 6.21.

Идеальные образы обучающей выборки

Л

Рис. 6.22.

Сеть Хопфилда распо знает образ

с информационным шумом

Рис. 6.23. Сеть

Хопфилда распо знает образ по его

небольшому фрагменту

![]() ,

то ее весовые коэффициенты

пересчитываются по формуле:

,

то ее весовые коэффициенты

пересчитываются по формуле:

![]() где e

— малое

число

где e

— малое

число

![]() ,

что

гарантирует незначительное ухудшение

полезной

памяти. После нескольких процедур

разобучения свойства сети улучшаются.

Это объясняется тем, что состояниям

ложной памяти

соответствуют гораздо более «мелкие»

энергетические

минимумы, чем состояниям, соответствующим

запоминаемым образам.

,

что

гарантирует незначительное ухудшение

полезной

памяти. После нескольких процедур

разобучения свойства сети улучшаются.

Это объясняется тем, что состояниям

ложной памяти

соответствуют гораздо более «мелкие»

энергетические

минимумы, чем состояниям, соответствующим

запоминаемым образам.

Д ругим

существенным недостатком сетей

Хопфилда является небольшая емкость

памяти.

Многочисленные исследования показывают,

что нейронная сеть, обученная по правилу

Хебба, может в среднем, при размерах

сети n,

хранить

не более чем 0,14n

различных образов. Для некоторого

увеличения емкости памяти сети

используется специальный

алгоритм ортогонализации образов.

ругим

существенным недостатком сетей

Хопфилда является небольшая емкость

памяти.

Многочисленные исследования показывают,

что нейронная сеть, обученная по правилу

Хебба, может в среднем, при размерах

сети n,

хранить

не более чем 0,14n

различных образов. Для некоторого

увеличения емкости памяти сети

используется специальный

алгоритм ортогонализации образов.

Рис. 6.24.

Сеть Хопфилда генерирует ложный

образ