- •Предисловие.

- •1. Основные задачи искусственного интеллекта.

- •1.1. История развития систем искусственного интеллекта.

- •1.2. Обзор основных направлений в области искусственного интеллекта

- •1.3. Решение задач и искусственный интеллект

- •1.3.1. Графовое представление задачи в пространстве состояний.

- •1.3.2. Стратегии поиска в пространстве состояний

- •2. Проблемная область искусственного интеллекта

- •2.1. Представление знаний

- •2.2 Модели представления знаний

- •2.2.1. Семантические сети

- •2.2.2. Фреймы

- •2.2.3. Формальные логические модели

- •2.2.4. Продукционная модель

- •2.2.5. Вывод на знаниях

- •3. Сильные методы решения задач. Экспертные системы

- •3.1. Структура экспертных систем

- •3.2. Классификация экспертных систем

- •3.3. Отличие эс от других программных продуктов

- •3.4. Цикл работы экспертных систем

- •3.5. Технология проектирования и разработки экспертных систем

- •4. Принятие решений в условиях неопределенности

- •4.1. Нечеткая логика

- •4.1.1. Нечеткие множества

- •4.1.2. Более строгое представление о нечетких множествах

- •4.1.3. Основные характеристики нечетких множеств

- •4.1.4. Примеры нечетких множеств и их характеристик

- •4.1.5. Операции над нечеткими множествами

- •4.1.6. Четкое множество α-уровня (или уровня α)

- •4.1.7. Нечеткая и лингвистическая переменные

- •4.1.8. Нечеткие числа

- •5. Машинное обучение на основе нейронных сетей

- •5.1. Биологический нейрон и его математическая модель

- •5.1.1. Биологический нейрон

- •5.1.2. Искусственный нейрон

- •5.2. Нейросети

- •5.2.1. Классификация и свойства нейросетей

- •5.2.2. Обучение искусственных нейронных сетей

- •5.3. Теорема Колмогорова

- •5.4. Персептрон

- •5.4.1. Алгоритм обучения персептрона

- •5.4.2. Линейная разделимость и персептронная представляемость

- •Логическая функция

- •Входы и выходы нейронов сети,

- •5.5. Сеть обратного распространения

- •5.5.1. Алгоритм обучения сети обратного распространения

- •5.6. Сеть встречного распространения

- •5.6.1. Сеть Кохонена. Классификация образов

- •5.6.2. Алгоритм обучения сети Кохонена

- •5. 6.3. Нейроны Гроссберга. Входные и выходные звезды

- •5.6.4. О бучение входной звезды

- •5.6.5. Обучение выходной звезды

- •5.6.6. Двухслойная сеть встречного распространения

- •5.6.7. Алгоритм обучения сети встречного распространения

- •5.7. Стохастические сети

- •5.7.1. Обучение Больцмана

- •5.7.2. Обучение Коши

- •5.8. Сети с обратными связями

- •5.8.1. Сеть Хопфилда

- •5.8.2. Правило обучения Хебба

- •5.8.3. Процедура ортогонализации образов

- •5.9. Сеть дап (двунаправленная ассоциативная память)

- •5.10. Сеть арт (адаптивная резонансная теория)

- •5.10.1. Алгоритм функционирования сети арт-1

- •Список иллюстраций

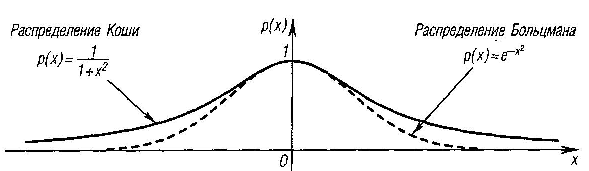

5.7.2. Обучение Коши

В

этом

методе распределение Больцмана

заменяется на распределение

Коши. Распределение Коши имеет, как

показано на рис. 6.19, более

высокую вероятность больших шагов.

Дисперсия распределения Коши

бесконечна. С помощью такого простого

изменения максимальная скорость

уменьшения температуры становится

обратно пропорциональной

линейной величине, а не логарифму, как

для алгоритма обучения Больцмана.

Эта связь может быть выражена следующим

образом:

![]() Таким

образом, время обучения резко уменьшается.

Распределение Коши имеет вид

Таким

образом, время обучения резко уменьшается.

Распределение Коши имеет вид

![]()

где

![]() - вероятность

принять изменение веса

- вероятность

принять изменение веса

![]() .

.

Несмотря на улучшение скорости обучения, даваемое распределением Коши по сравнению с распределением Больцмана, время сходимости все еще может в 100 раз превышать время для алгоритма обратного распространения.

Рис. 6.19. Распределение Коши и распределение Больцмана

Комбинирование обратного распространения с обучением Коши. Коррекция весов в комбинированном алгоритме, использующем обратное распространение и обучение Коши, состоит из двух компонент: компоненты, вычисляемой с использованием алгоритма обратного распространения, и случайной компоненты, определяемой распределением Коши.

Эти компоненты вычисляются для каждого веса, и их сумма является величиной, на которую изменяется вес. Как и в алгоритме Коши, после вычисления изменения веса вычисляется целевая функция. Если имеет место улучшение, изменение сохраняется. В противном случае оно сохраняется с вероятностью, определяемой распределением Коши.

Коррекция веса вычисляется с использованием представленных ранее уравнений для каждого из алгоритмов:

![]()

где

![]() —

коэффициент, управляющий относительными

величинами обучения

Коши и обратного распространения в

компонентах весового шага. Если

приравнивается

нулю, метод становится обучением Коши.

Если

приравнивается

единице, метод становится алгоритмом

обратного распространения.

—

коэффициент, управляющий относительными

величинами обучения

Коши и обратного распространения в

компонентах весового шага. Если

приравнивается

нулю, метод становится обучением Коши.

Если

приравнивается

единице, метод становится алгоритмом

обратного распространения.

Комбинированная сеть, использующая обратное распространение и обучение Коши, обучается быстрее, чем каждый из алгоритмов в отдельности. Сходимость к глобальному минимуму гарантируется алгоритмом Коши, и во многих экспериментах по обучению сеть практически не попадала в локальные минимумы.

Упражнения

5.11.

Стохастические нейронные сети можно

использовать для поиска

глобального минимума в невыпуклых или

не имеющих строгой математической

формализации задачах оптимизации. На

первом этапе обучения,

например по методу Коши, подстраиваются

весовые коэффициенты сети так, чтобы

она аппроксимировала данную функцию

(в качестве

обучающей выборки используются наборы

значений переменных, для

которых известно значение функции). На

втором этапе весовые коэффициенты сети

остаются без изменения, а определению

подлежат входные

значения сети, которые пересчитываются

по тому же закону, что

и весовые коэффициенты, но в качестве

функции ошибки используется

оптимизируемая функция, аппроксимируемая

данной сетью (за ее

уменьшением или увеличением должен

следить алгоритм обучения). Напишите

программу, определяющую с помощью

обучения Коши глобальный

минимум функции

![]() на отрезке [—2, 2].

на отрезке [—2, 2].

5.12. Напишите программу, обучающую стохастическую сеть распознаванию цифр. На вход сети подаются графические изображения цифр, разбитые на квадраты (или пиксели) так же, как для однослойного персептрона или сети обратного распространения. Используйте не менее 15—20 различных написаний цифр. Выходом сети служит двоичное представление входной цифры.