- •Предисловие.

- •1. Основные задачи искусственного интеллекта.

- •1.1. История развития систем искусственного интеллекта.

- •1.2. Обзор основных направлений в области искусственного интеллекта

- •1.3. Решение задач и искусственный интеллект

- •1.3.1. Графовое представление задачи в пространстве состояний.

- •1.3.2. Стратегии поиска в пространстве состояний

- •2. Проблемная область искусственного интеллекта

- •2.1. Представление знаний

- •2.2 Модели представления знаний

- •2.2.1. Семантические сети

- •2.2.2. Фреймы

- •2.2.3. Формальные логические модели

- •2.2.4. Продукционная модель

- •2.2.5. Вывод на знаниях

- •3. Сильные методы решения задач. Экспертные системы

- •3.1. Структура экспертных систем

- •3.2. Классификация экспертных систем

- •3.3. Отличие эс от других программных продуктов

- •3.4. Цикл работы экспертных систем

- •3.5. Технология проектирования и разработки экспертных систем

- •4. Принятие решений в условиях неопределенности

- •4.1. Нечеткая логика

- •4.1.1. Нечеткие множества

- •4.1.2. Более строгое представление о нечетких множествах

- •4.1.3. Основные характеристики нечетких множеств

- •4.1.4. Примеры нечетких множеств и их характеристик

- •4.1.5. Операции над нечеткими множествами

- •4.1.6. Четкое множество α-уровня (или уровня α)

- •4.1.7. Нечеткая и лингвистическая переменные

- •4.1.8. Нечеткие числа

- •5. Машинное обучение на основе нейронных сетей

- •5.1. Биологический нейрон и его математическая модель

- •5.1.1. Биологический нейрон

- •5.1.2. Искусственный нейрон

- •5.2. Нейросети

- •5.2.1. Классификация и свойства нейросетей

- •5.2.2. Обучение искусственных нейронных сетей

- •5.3. Теорема Колмогорова

- •5.4. Персептрон

- •5.4.1. Алгоритм обучения персептрона

- •5.4.2. Линейная разделимость и персептронная представляемость

- •Логическая функция

- •Входы и выходы нейронов сети,

- •5.5. Сеть обратного распространения

- •5.5.1. Алгоритм обучения сети обратного распространения

- •5.6. Сеть встречного распространения

- •5.6.1. Сеть Кохонена. Классификация образов

- •5.6.2. Алгоритм обучения сети Кохонена

- •5. 6.3. Нейроны Гроссберга. Входные и выходные звезды

- •5.6.4. О бучение входной звезды

- •5.6.5. Обучение выходной звезды

- •5.6.6. Двухслойная сеть встречного распространения

- •5.6.7. Алгоритм обучения сети встречного распространения

- •5.7. Стохастические сети

- •5.7.1. Обучение Больцмана

- •5.7.2. Обучение Коши

- •5.8. Сети с обратными связями

- •5.8.1. Сеть Хопфилда

- •5.8.2. Правило обучения Хебба

- •5.8.3. Процедура ортогонализации образов

- •5.9. Сеть дап (двунаправленная ассоциативная память)

- •5.10. Сеть арт (адаптивная резонансная теория)

- •5.10.1. Алгоритм функционирования сети арт-1

- •Список иллюстраций

5. 6.3. Нейроны Гроссберга. Входные и выходные звезды

Входная звезда Гроссберга (S. Grossberg), как показано на рис. 6.14, состоит из нейрона, на который подается группа входов, умноженных на синапсические веса.

В

Рис. 6.14.

Входная звезда Гроссберга

5.6.4. О бучение входной звезды

В

Рис. 6.15.

Выходная звезда Гроссберга![]() т. е. выход входной звезды

определяется как взвешенная сумма ее

входов:

т. е. выход входной звезды

определяется как взвешенная сумма ее

входов:

![]()

С другой точки зрения, выход можно рассматривать как скалярное произведение входного вектора с весовым вектором. Если эти векторы имеют единичную норму, то скалярное произведение будет максимальным для того входного образа, которому нейрон был обучен.

В процессе обучения веса корректируются следующим образом:

![]()

где — весовой коэффициент входа ; — нормирующий коэффициент обучения, который имеет начальное значение 0,1 и постепенно уменьшается в процессе обучения.

После завершения обучения предъявление входного вектора X будет активизировать обученный входной нейрон. Хорошо обученная входная звезда будет реагировать не только на определенный запомненный вектор, но также и на незначительные изменения этого вектора. Это достигается постепенной настройкой нейронных весов при предъявлении в процессе обучения векторов, представляющих нормированные вариации входного вектора. Веса настраиваются таким образом, чтобы усреднить величины обучающих векторов, и нейроны получают способность реагировать на любой вектор этого класса.

5.6.5. Обучение выходной звезды

В то время как входная звезда учится реагировать на определенный вход, выходная звезда обучается выдавать требуемый целевой выход.

Для

того чтобы обучить нейрон выходной

звезды, его веса настраиваются в

соответствии с требуемым целевым

выходным вектором У.

Формула

коррекции весов имеет вид:

![]()

где

![]() представляет

собой нормирующий коэффициент обучения,

который

вначале приблизительно равен единице

и постепенно уменьшается до

нуля в процессе обучения.

представляет

собой нормирующий коэффициент обучения,

который

вначале приблизительно равен единице

и постепенно уменьшается до

нуля в процессе обучения.

Как и в случае входной звезды, веса выходной звезды постепенно настраиваются на множестве векторов, представляющих собой возможные вариации запоминаемого выходного вектора.

5.6.6. Двухслойная сеть встречного распространения

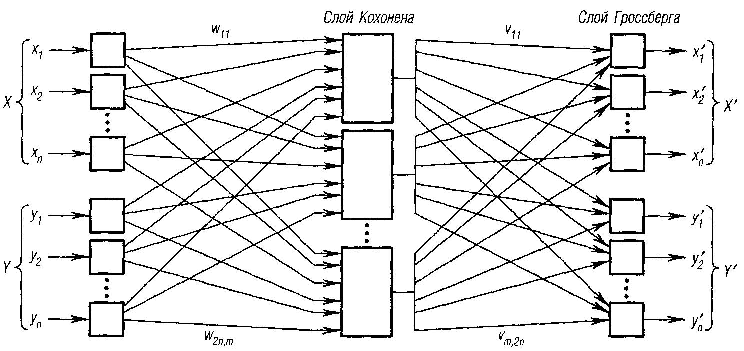

Сеть встречного распространения состоит из двух слоев: слоя нейронов Кохонена и слоя нейронов Гроссберга. Автор сети Р. Хехт-Нильсен (R. ) удачно объединил эти две архитектуры, в результате чего сеть приобрела свойства, которых не было у каждой из них в отдельности.

Слой Кохонена классифицирует входные векторы в группы схожих. Это достигается с помощью такой подстройки весов слоя Кохонена, что близкие входные векторы активируют один и тот же нейрон данного слоя. Затем слой Гроссберга дает требуемые выходы.

На рис. 6.16 показана сеть встречного распространения полностью.

В режиме нормального функционирования предъявляются входные векторы X и Y,и обученная сеть дает на выходе векторы X' и У’, являющиеся аппроксимациями соответственно для X и У. Векторы X, У предполагаются здесь нормированными векторами единичной длины, следовательно, порождаемые на выходе векторы также должны быть нормированными.

В процессе обучения векторы X и У подаются одновременно и как входные векторы сети, и как желаемые выходные сигналы. В результате получается отображение, при котором предъявление пары входных векторов порождает их копии на выходе. Это не было бы особенно интересным, если не учитывать способность этой сети к обобщению. Благодаря обобщению предъявление только вектора X (с вектором У, равным нулю) порождает как выходы X', так и выходы У. Если F — функция, отображающая X в У, то сеть аппроксимирует ее. Кроме того, если функция F обратима, то предъявление только вектора Y (при нулевом векторе X) порождает выходы X'.

Рис. 6.16. Сеть встречного распространения

Уникальная способность порождать функцию и обратную к ней делает сеть встречного распространения полезной в ряде приложений. Например, в задаче аппроксимации многомерной векторной функции сеть обучается на известных значениях этой функции.