- •Аннотация

- •Summary

- •Реферат

- •Перечень демонстрационных графических материалов

- •Содержание

- •Введение

- •Анализ технического задания

- •1.1.1 Принцип сканирующего окна

- •1.1.2Интегральное представление изображений

- •1.1.3 Признаки Хаара

- •1.1.5 Бустинг

- •2 Методы дистантного сопоставления с эталоном

- •4.3 Классы и функции используемые в работе

- •4.3.1 Класс VideoCapture

- •4.3.2 Класс CascadeClassifier

- •4.3.3 Класс calcImageHash

- •4.3.4 Класс cFaceBase

- •4.3.5 Функция calcHammingDistance

- •4.3.6 Функция HashWithMinHammDis

- •5.2 Мероприятия по улучшению условий труда

- •5.3 Организационные меры профилактики

- •5.4 Технические меры профилактики

- •5.5 Санитарно-гигиенические меры профилактики

- •5.6 Психологические меры профилактики

- •5.6 Пожарная безопасность

- •5.7 Защита окружающей среды

- •Заключение

- •Список использованных источников

- •Приложение а Код программы cvFaceHash

- •Код подпрограммы cvHashCalc

1.1.5 Бустинг

Для решения проблемы данного, столь сложного обучения существует технология бустинга.

Бустинг — комплекс методов, способствующих повышению точности аналитических моделей. Эффективная модель, допускающая мало ошибок классификации, называется «сильной». «Слабая» же, напротив, не позволяет надежно разделять классы или давать точные предсказания, делает в работе большое количество ошибок. Поэтому бустинг (от англ. boosting – повышение, усиление, улучшение) означает дословно «усиление» «слабых» моделей – это процедура последовательного построения композиции алгоритмов машинного обучения, когда каждый следующий алгоритм стремится компенсировать недостатки композиции всех предыдущих алгоритмов. Идея бустинга была предложена Робертом Шапиром (Schapire) в конце 90-х годов, когда надо было найти решение вопроса о том, чтобы имея множество плохих (незначительно отличающихся от случайных) алгоритмов обучения, получить один хороший. В основе такой идеи лежит построение цепочки (ансамбля) классификаторов, который называется каскадом, каждый из которых (кроме первого) обучается на ошибках предыдущего. Например, одни из первых алгоритмов бустинга Boost1 использовал каскад из 3-х моделей, первая из которых обучалась на всем наборе данных, вторая – на выборке примеров, в половине из которых первая дала правильные ответы, а третья – на примерах, где «ответы» первых двух разошлись. Таким образом, имеет место последовательная обработка примеров каскадом классификаторов, причем так, что задача для каждого последующего становится труднее. Результат определяется путем простого голосования: пример относится к тому классу, который выдан большинством моделей каскада.

Бустинг представляет собой жадный алгоритм построения композиции алгоритмов (greedy algorithm) — это алгоритм, который на каждом шагу делает локально наилучший выбор в надежде, что итоговое решение будет оптимальным. Бустинг над решающими деревьями считается одним из наиболее эффективных методов с точки зрения качества классификации. Во многих экспериментах наблюдалось практически неограниченное уменьшение частоты ошибок на независимой тестовой выборке по мере наращивания композиции. Более того, качество на тестовой выборке часто продолжало улучшаться даже после достижения безошибочного распознавания всей обучающей выборки. Это перевернуло существовавшие долгое время представления о том, что для повышения обобщающей способности необходимо ограничивать сложность алгоритмов. На примере бустинга стало понятно, что хорошим качеством могут обладать сколь угодно сложные композиции, если их правильно настраивать.

Математически бустинг объясняется так:

Наряду с множествами XиYвводится вспомогательное множество R, называемое пространством оценок. Рассматриваются алгоритмы, имеющие вид суперпозиции:

(1.6)

(1.6)

где функция b: X → Rназывается алгоритмическим оператором;

функция C: R → Y–решающим правилом.

Многие алгоритмы классификации имеют именно такую структуру: сначала вычисляются оценки принадлежности объекта классам, затем решающее правило переводит эти оценки в номер класса. Значение оценки, как правило, характеризует степень уверенности классификации. Алгоритмическая композиция – алгоритмa: X → Yвида:

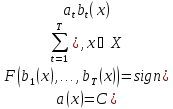

a(x) = C(F(b1(x),...,bT(x)), x ∈ X, (1.7)

где составленный из алгоритмических операторов bt:X→R, t=1,...,T, корректирующей операцииF: RT→Rи решающего правилаC: R→Y.

Базовыми алгоритмами обозначаются функции at(x) = C(bt(x)), а при фиксированном решающем правилеC— и сами операторыbt(x). Суперпозиции видаF(b1,..., bT)являются отображениями изXвR, то есть, опять же, алгоритмическими операторами.

В задачах классификации на два непересекающихся класса в качестве пространства оценок обычно используется множество действительных чисел. Решающие правила могут иметь настраиваемые параметры. Так, в алгоритме Виолы-Джонса используется пороговое решающее правило, где, как правило, сначала строится оператор при нулевом значении, а затем подбирается значение оптимальное. Процесс последовательного обучения базовых алгоритмов применяется, пожалуй, чаще всего при построении композиций.

Критерии останова могут использоваться различные, в зависимости от специфики задачи, возможно также совместное применение нескольких критериев:

построено заданное количество алгоритмов T;

достигнута заданная точность на обучающей выборке;

достигнуто точность контрольной выборке не удается улучшить на протяжении последних нескольких шагов при определенном параметре алгоритма.

Развитием данного подхода явилась разработка более совершенного семейства алгоритмов бустинга AdaBoost (adaptive boosting – адаптированное улучшение), предложенная Йоавом Фройндом (Freund) и Робертом Шапиром (Schapire) в 1999 году, который может использовать произвольное число классификаторов и производить обучение на одном наборе примеров, поочередно применяя их на различных шагах.

Рассматривается задача классификации на два класса, Y = {−1,+1}. К примеру, базовые алгоритмы также возвращают только два ответа −1 и +1, и решающее правило фиксировано:C(b) = sign(b). Искомая алгоритмическая композиция имеет вид:

(1.8)

(1.8)

Функционал качества композиции Qt определяется как число ошибок, допускаемых ею на обучающей выборке:

(1.9)

(1.9)

где Wl= (w1, …, wl)– вектор весов объектов.

Для решения задачи AdaBoosting’а нужна экспоненциальная аппроксимация пороговой функции потерь [z<0], причем экспонентаEz = e-z.

Плюсы AdaBoost:

хорошая обобщающая способность. В реальных задачах практически всегда строятся композиции, превосходящие по качеству базовые алгоритмы. Обобщающая способность может улучшаться по мере увеличения числа базовых алгоритмов;

простота реализации;

собственные накладные расходы бустинга невелики. Время построения композиции практически полностью определяется временем обучения базовых алгоритмов;

возможность идентифицировать объекты, являющиеся шумовыми выбросами. Это наиболее «трудные» объекты xi, для которых в процессе наращивания композиции весаwiпринимают наибольшие значения.

Минусы AdaBoost:

Бывает переобучение при наличии значительного уровня шума в данных. Экспоненциальная функция потерь слишком сильно увеличивает веса «наиболее трудных» объектов, на которых ошибаются многие базовые алгоритмы. Однако именно эти объекты чаще всего оказываются шумовыми выбросами. В результате AdaBoost начинает настраиваться на шум, что ведёт к переобучению. Проблема решается путём удаления выбросов или применения менее «агрессивных» функций потерь. В частности, применяется алгоритм GentleBoost;

AdaBoost требует достаточно длинных обучающих выборок. Другие методы линейной коррекции, в частности, бэггинг, способны строить алгоритмы сопоставимого качества по меньшим выборкам данных;

Бывает построение неоптимального набора базовых алгоритмов. Для улучшения композиции можно периодически возвращаться к ранее построенным алгоритмам и обучать их заново.

Бустинг может приводить к построению громоздких композиций, состоящих из сотен алгоритмов. Такие композиции исключают возможность содержательной интерпретации, требуют больших объёмов памяти для хранения базовых алгоритмов и существенных временных затрат на вычисление классификаций.

В наши дни подход усиления простых классификаторов является популярным и, вероятно, наиболее эффективным методом классификации за счёт высокой скорости и эффективности работы и относительной простоты реализации.

Каскадная модель сильных классификаторов

Объединение сильных классификаторов в каскадную модель. При объединении слабых анизотропных классификаторов в один большой сильный классификатор детектирующая способность повышается, но при этом повышается и время принятия решения. В некоторых случаях время, помимо качества распознавания, является ключевым фактором. Для этого случая предлагается построить каскадную модель из небольших сильных классификаторов, позволяющую повысить скорость детектирования, не ухудшая качество.

Каскадная модель сильных классификаторов – это дерево принятия решений, где каждый узел дерева построен таким образом, чтобы детектировать почти все интересующие образы и отклонять некоторую часть регионов, не являющуюся образами. Помимо этого, узлы дерева размещены таким образом, что чем ближе узел находится к корню дерева, тем из меньшего количества анизотропных гауссовых примитивов он состоит и тем самым требует меньшего времени на принятие решения. Данный вид каскадной модели хорошо подходит для обработки изображений, на которых общее количество детектируемых образов мало. В этом случае метод может быстрее принять решение о том, что данный регион не содержит образ, и перейти к следующему. Пример каскадной модели показан на рисунке 5:

Рисунок 5 – Каскад модели сильных классификаторов

Сложность обучения таких каскадов равна О(xyz), где применяетсяxэтапов,yпримеров иzпризнаков.

Далее, каскад применяется к изображению:

работа с «простыми» классификаторами – при этом отбрасывается часть «отрицательных» окон;

положительное значение первого классификатора запускает второй, более приспособленный и так далее;

отрицательное значение классификатора на любом этапе приводит к немедленному переходу к следующему сканирующему окну, старое окно отбрасывается;

цепочка классификаторов становится более сложной, поэтому ошибок становится намного меньше.

Для тренировки такого каскада потребуются следующие действия:

задаются значения уровня ошибок для каждого этапа (предварительно их надо количественно просмотреть при применении к изображению из обучающего набора) – они называются detectionиfalse positive rates– надо чтобы уровень detection был высок, а уровень false positive rates низок;

добавляются признаки до тех пор, пока параметры вычисляемого этапа не достигнут поставленного уровня, тут возможны такие вспомогательные этапы, как:

тестирование дополнительного маленького тренировочного набора;

порог AdaBoost умышленно понижается с целью найти больше объектов, но в связи с этим возможно большее число неточных определений объектов;

если false positive rates остается высоким, то добавляется следующий этап или слой;

ложные обнаружения в текущем этапе используются как отрицательные уже на следующем слое или этапе.