125 Кібербезпека / 3 Курс / 3.1_Теорія інформації та кодування / Лаби готові / Lab-1-10

.pdfМіністерство освіти і науки України Тернопільський національний технічний університет імені Івана Пулюя

Кафедра кібербезпеки

ЗВІТ

до лабораторних робіт

з курсу “Теорія інформації та кодування”

Виконав: студент групи

Перевірила: Стадник М.А.

Тернопіль

Лабораторна робота №1

Тема: Ансамблі та джерела повідомлень.

Мета: Ознайомлення із поняттями: ансамбль та джерело повідомлення та його характеристиками. Отримати практичні навички визначення кількості інформації та ентропії джерела повідомлення, яке продукує повідомлення.

Порядок виконання роботи:

1. Вибрав повідомлення із множини літер прізвища, імені та по-батькові українською мовою. Побудував ансамбль джерела повідомлення та обчислив його характеристики.

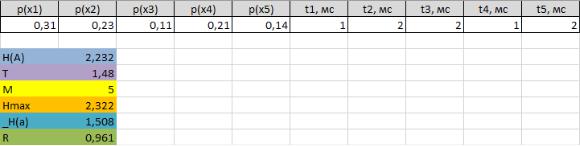

2. Розподіл ймовірностей появи символів на виході джерела з алфавітом X потужності M = 5 задано таблично. Обчислив ентропію, продуктивність та надмірність джерела.

H(A)=0,31*log2*0,31+0,23*log2*0,23+0,11*log2*0,11+0,21*log2*0,21+0,14*log2*

0,14=2,232 біт

T=0,31*1+0,23*2+0,11*2+0,21*1+0,14*2=1,48 мс

H(maxA)=log= HT2M== 2,2321,48,322 біт= 1,508 біт/с

R=1-(H/Hmax)=0,961

Висновок: Контрольні запитання:

1.Що таке джерело повідомлень?

Це те(той) що надає(продукує) повідомлення. Початкова позиція звідки надходить повідомлення.

2.Що таке ансамбль повідомлень?

Множина повідомлень.

3.Як визначається кількість інформації в одному повідомленні?

4.Властивості кількості інформації.

5.Що таке ентропія та які її властивості?

6.Як визначити максимальну ентропію джерела повідомлення?

7.Як визначити продуктивність джерела повідомлення?

8.Як визначити надмірність джерела повідомлення?

9.Поясніть взаємозв’язок між кількістю інформації та ентропією.

10.Чи визначає пара множин А = {a1, a2, a3}, P = {1/2; 1/4; 1/5} ансамбль повідомлень?

Лабораторна робота №2

Тема: Ентропія та її види.

Мета: Набуття практичних навиків знаходження часткових та загальної умовної ентропії, ентропії об’єднання двох джерел та взаємної кількості інформації.

Порядок виконання роботи:

1.Знаходжу часткові ентропії спостерігача Y щодо джерела X.

2.Знаходжу загальні умовні ентропії спостерігача Y щодо джерела X.

3.Ентропії дискретних джерел X та Y.

4.Знаходжу часткові умовні ентропії джерела X щодо Y.

5.Знаходжу загальну умовну ентропію джерела X щодо Y.

6.Знаходжу взаємну ентропію та кількість інформації.

Взаємну ентропію знаходжу за формулоюH(X,Y)=H(X)+H(Y|X)=H(Y)+H(X|Y).

H(X,Y)=1,550+1,371=2,920

Кількість інформації знаходжу за формулою I(X,Y)=H(X)+H(Y)-H(X,Y)=Y(X)- H(X|Y)=H(Y)-H(Y|X).

I(X,Y)=1,550-1,233=0,317

Контрольні запитання:

1. Дайте визначення терміну “часткова умовна ентропія”.

це кількість інформації, що припадає на одне повідомлення джерела X за умови встановлення факту вибору джерелом Y повідомлення y j , або кількість інформації, що припадає на одне повідомлення джерела Y за умови, що відомий стан джерела X.

2. Дайте визначення терміну “загальна умовна ентропія”.

Загальна умовна ентропія – це середньостатистична кількість інформації (математичне сподівання), що припадає на будь-яке повідомлення джерела X, якщо відомий його статистичний взаємозв’язок з джерелом Y та навпаки.

3. Дайте визначення терміну “взаємна ентропія”.

це середня кількість інформації, що припадає на два будь-які повідомлення джерел X та Y.

4. Дайте визначення терміну “взаємна кількість інформації”.

кількість інформації, що містить в середньому символ на виході першого джерела про виникнення символів на виході другого джерела, дорівнює кількості інформації, яка міститься в середньому в символі на виході другого джерела про виникнення символів на виході першого

5.Назвіть властивості умовної ентропії.

1.якщо джерела повідомлень X і Y статистично незалежні, то умовна ентропія

джерела X стосовно Y дорівнює безумовній ентропії джерела X і навпаки:

H(X/Y)=H(X), H(Y/X)=H(Y);

2.якщо джерела повідомлень X і Y настільки статистично взаємозв'язані, що виникнення одного з повідомлень спричиняє безумовну появу іншого, то їхні умовні ентропії дорівнюють нулю: H(X/Y)=H(Y/X)=0;

3.ентропія джерела статистичновзаємозалежних повідомлень (умовна ентропія) менша від ентропії джерела незалежних повідомлень (безумовної ентропії):

H(X/Y)<H(X), H(Y/X)<H(Y).

6.Назвіть властивості ентропії об’єднання двох джерел.

1.При статистичній незалежності джерел X і Y їх взаємна ентропія дорівнює

сумі ентропій кожного з джерел, тобтоH(X, Y)=H(X)+H(Y);

2.При повній статистичній залежності джерел X і Y їх взаємна ентропія дорівнює безумовній ентропії одного з джерел, тобтоH(X,Y)=H(X)=H(Y);

3.Взаємна ентропія статистично залежних джерел X і Y меншасуми безумовних ентропій кожного з них, тобтоH(X, Y) H(X)+H(Y).

7.Як визначити ймовірності алфавіту X маючи сумісні ймовірності?

1

8.Як визначити ймовірності алфавіту Y маючи сумісні ймовірності?

1

9.Як обчислити умовні ймовірності маючи сумісні ймовірності та відповідні безумовні ймовірності.

1

10.Напишіть формули для знаходження умовних та взаємної ентропій та взаємної кількості інформації.

1

Лабораторна робота №3

Тема: Джерела повідомлень з пам’яттю.

Мета: Навчитись визначати ентропію дискретних джерел повідомлень із пам’яттю. Розглянути марківські джерела повідомлень.

Порядок виконання роботи:

Завдання 1. Марківське дискретне джерело інформації має

алфавіт X = {x1, x2}. Статистичні зв’язки розповсюджуються тільки на суміжні символи ( тобто глибина пам’яті h = 1). Чисельні значення умовних ймовірностей p( xi / xk) та тривалостей символів t i ( в мі-лісекундах, мс ) для

різних варіантів наведені у наступній таблиці. Отримати чисельні значення ентропії, |

||||||||||

( 1, 2) |

|

( 2 |

, 1) |

0,33 |

0,1 |

|

||||

продуктивності та надмірності джерела. |

, 2) |

= 0,67 |

0,9 |

|

||||||

( 2, 1) |

|

( 2 |

|

|||||||

|

|

1 |

= |

0,3; 2 |

= 1; |

|

|

|||

|

( ) =1 |

= |

2 |

( | ) ( ) |

|

|||||

|

|

|

||||||||

( 1) + ( 2) |

= 1 |

=1 |

|

+ ( 2) ( 1 |

| 2) |

|||||

( 1) = ( 1 |

| 1) ( 1) |

|||||||||

|

|

( 1) = 1 − ( 2) |

|

|

||||||

|

1 ( 1) − 0,33 ( 1) = 0,1 ( 2) |

|

||||||||

|

0,67 −0,67 ( 2) = 0,1 ( 2) |

|

||||||||

|

|

0,67 ( 1) |

= 0,1 ( 2) |

|

|

|||||

|

|

0,67 = 0,77 ( 2) |

|

|

||||||

|

|

( 2) |

= |

0,67 |

|

|

|

|||

|

|

0,77 = 0,87 |

|

|

||||||

|

|

|

|

( 1) |

= 0,13 |

|

|

|||

|

|

|

|

( 2) |

= 0,87 |

|

|

|||

( | 1) = −(0,33 20,33 + 0,67 20,67) = 0,91 |

||||||||||

( | 22) |

= −(0,1 20,1 + 0,9 2 |

0,9) |

= 0,46 |

|||||||

( ) =1 = ( | ) |

( ) = 0,91 0,13 + 0,46 0,87 = 0,51 |

|||||||||

=1 |

|

|

|

|

|

|

|

|

|

|

( ) =1 = 0,3 0,13 + 1 0,87 = 0,90 мс |

||||||||||

|

|

= 2 = 22 = 1 |

|

|||||||

|

|

|

|

0,51 |

|

біт |

|

|

||

|

= 0,90 10−3 = 567 сек |

|

|

|||||||

|

|

= 1 − 0,51/ 22 = 0,49 |

|

|

||||||

Завдання2. Марківське дискретне джерело інформації має

алфавіт X = {x1, x2}. Статистичні зв’язки розповсюджуються тільки насуміжні символи ( тобто глибина пам’яті h = 1). Чисельні значеннясумісних

ймовірностей p( xi ,xk) та наведені у наступній таблиці. Отримати чисельні значення |

||||||||

загальної ентропії. |

( 1 |

, 2) |

( 2 |

, 1) = |

0,6 |

0,03 |

|

|

|

|

|||||||

|

( 2 |

, 1) |

( 2 |

, 2) |

0,17 |

0,2 |

|

|

|

|

( ) |

= {0,07; 0,93} |

|

= 0,87 |

|||

( | 1) = −(0,6 |

20,6 + 0,17 20,17) |

|||||||

( | 2) = −(0,03 220,03 + 0,2 20,2) = 0,61 |

||||||||

|

( ) =1 = |

( | ) ( ) |

біт |

|||||

|

|

|

|

=1 |

|

|

||

|

( ) =1 = 0,87 0,07 + 0,61 0,93 = 0,62 |

сим |

||||||

Лабораторна робота №4

Тема: Дискретні канали зв’язку та характеристики дискретних джерел повідомлень.

Мета: Розглянути та навчитись оцінювати інформаційні втрати в дискретних каналах зв’язку, пропускну здатність дискретного каналу, продуктивність та дискретного джерела повідомлення.

Порядок виконання роботи: |

|

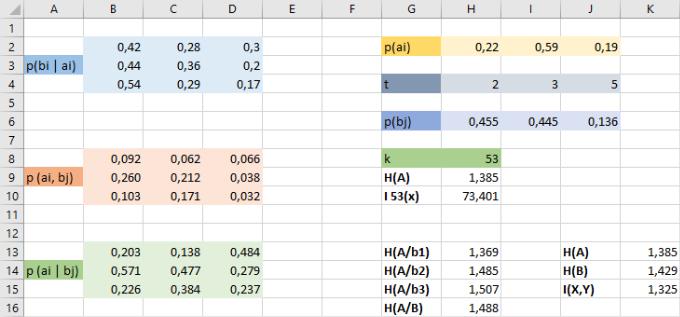

Завдання: Ансамбль повідомлень джерела А визначено як |

. |

Матриця умовних ймовірностей каналу та імовірностей |

появи повідомлень |

задані наступною таблицею. Примітка: для виконання завдання будемо вважати

значення τ=τсер .

1. Визначити кількість інформації, що передається в одному та k повідомленнях.

2.Чому дорівнюють інформаційні втрати в каналі при передачіk повідомлень

залфавіту А?

3.Визначити пропускну здатність каналу при відсутності завад і у випадку каналу із шумом (завадами).

4.Визначити швидкість передачі інформації поканалузв’язку із шумом та при відсутності завад.

5.Визначити продуктивність джерела повідомлень А.

Примітка: значення k=30+номер варіанту

1.Кількість інформації, що передається в одному та k повідомленнях:

H(A)= - (0,22*log20,22+0,59*log20,59+0,19*log20,19) = 1.385 біт\сим;

В k повідомлень: k=30 + Nв = 30+23 = 53;

I53(X) = 53*H(A) = 53*1,385 = 73.401 біт;

2.Інформаційні втрати в каналі зв’язку:

Часткові умовні ентропії:

H(A/b1) = -(0,203*log20,203 + 0,138*log20,138 +0,484*log20,484) = 1.369; H(A/b2) = -(0,571*log20,571+0,477*log20,477+0,279*log20,279) = 1,485; H(A/b3) = -(0,226*log20,226+0,384*log20,384+0,237*log20,237) = 1,507; H(A/B) = 0,455*1.369 + 0,445*1,485 + 0,136*1,507=1,488 біт/сим ;

3. Швидкість передачі інформації по каналу зв’язку :

V = I(A,B)/t;

H(A)= - (0,22*log20,22+0,59*log20,59+0,19*log20,19)= 1.385 біт/сим; H(B)=-(0,455*log20,455 + 0,445*log20,455 + 0,136*log20,136) = 1.429 біт/сим; I(X,Y) = 1,385 +1,429 – 1,488 = 1.325 біт/сим ;

V = 1,325/3,16*10-3 = 419,3 бод ;

Із завадами:

Vзв = C/H(A) = 1,341/1,385 = 0,968 бод;

4.Продуктивність:

Vдж = H(A)/tc ;

tc = (0,22*2 + 0,59*3 + 0,19*5) = 3,16 мс; Vдж = 1,385/3,16 *10-3 = 438,2 біт/сим ;

Лабораторна робота №5

Тема: Оптимальні методи кодування інформації.

Мета: Розглянути та навчитись використовувати оптимальні нерівномірні методи кодування за алгоритмом Шеннона-Фано і Хаффмана, оцінювати оптимальність отриманого коду.

Порядок виконання роботи:

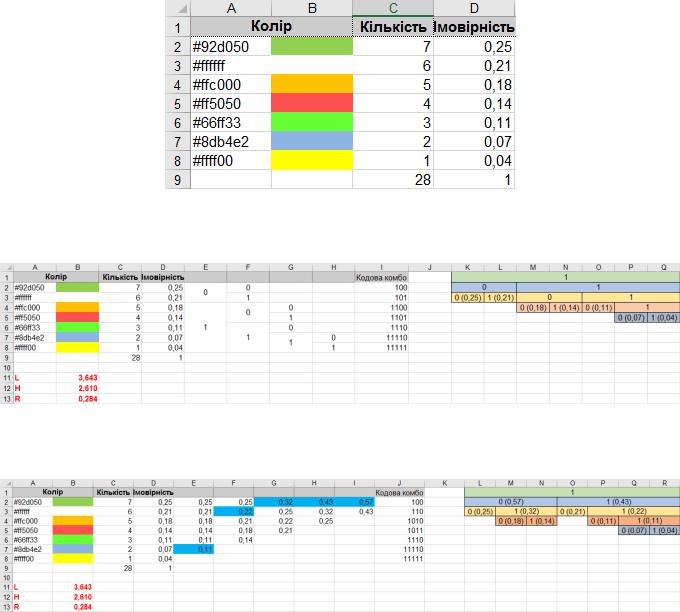

1.Побудував ансамбель повідомлень для джерела під номером 23. Та написав імовірності відповідно частоті появи повідомлення.

2.Виконав кодування повідомлення, використовуючи нерівномірне оптимальне кодування методом Шеннона-Фано та визначив його характеристики.

3.Виконав кодування повідомлення, використовуючи нерівномірне оптимальне кодування методом Хаффмана та визначив його характеристики.

Контрольні запитання:

1.Які способи використовуються для подання кодів?

1) Таблиць кодових комбінацій;