- •2. Дайте определение теоретическому коэффициенту корреляции. Что он показывает? в каком диапазоне меняется?

- •3. Почему на практике исследователь не может вычислить сам теоретический коэффициент корреляции?

- •24. В каком случае применение евклидова расстояния не имеет под собой теоретического основания (хотя может давать разумные результаты)?

- •25. Назовите известные Вам алгоритмы агломерации.

- •26. Даны 4 трехмерных наблюдения. Реализуйте их кластеризацию на основе метода ближнего соседа (дальнего соседа, средней связи) и расстояния Евклида (Манхеттен, Чебышев). Постройте дендрограмму

- •27. Дана дендрограмма. Укажите получившиеся кластеры.

- •29. Объясните, почему при кластеризации необходимо приводить все показатели к единой шкале измерения?

- •34. Кто и почему впервые назвал регрессию регрессией?

- •35. В чем суть метода наименьших квадратов?

- •36. Формализуйте идею метода наименьших квадратов в ситуации парной линейной регрессии (в случае центрированных иксов).

- •37. Выведите мнк-оценки коэффициентов парной линейной регрессии (в случае центрированных иксов).

- •38. Как получить мнк-оценки коэффициентов парной линейной регрессии в обычном случае центрированных иксов?

- •39. Покажите связь между коэффициентом корреляции к.Пирсона и коэффициентом β1 парной линейной регрессии. (См рисунок в контакте)

- •Вопрос 40. Сформулируйте 4 условия Гаусса – Маркова.

- •Вопрос 41. Сформулируйте теорему Гаусса – Маркова

- •1. Несмещенность

- •2. Эффективность

- •47.Что такое автокорреляция остатков? Когда она может возникать в регрессионной модели?

- •48. К каким последствиям для свойств мнк-оценок ведет нарушение каждого из условий Гаусса – Маркова?

- •51.Укажите распределение (и его параметры) мнк-оценок коэффициентов регрессии при выполнении условий Гаусса – Маркова и условия нормальности. (смотри оисунок в контакте)

- •52. Дано значение мнк-оценок коэффициентов парной регрессии. Известно число наблю-дений. Проверьте, значимы ли коэффициенты регрессии.

- •53. Дана таблица результатов регрессионного анализа из некоторой статьи англоязычного политологического журнала. Укажите статистически значимые коэффициенты регрессии.

- •54. Даны несколько пар наблюдений над случайными величинами X и y. Постройте уравне-ние регрессии y на X и проверьте значимость коэффициентов.

- •55. Что такое коэффициент детерминации? Что он показывает?

- •56. Даны значения rss и ess. Найти r(квадрат)

- •57. Дано значение коэффициента корреляции между X и y. Найти r(квадрат)

- •60. Даны значения rss и ess, число наблюдений и число предикторов в регрессии. Проверить гипотезу о качестве модели на основе статистики Фишера.

- •61. Дано значение r2, число наблюдений и число предикторов в регрессии. Проверить гипотезу о качестве модели на основе статистики Фишера.

- •63. Дана таблица дисперсионного анализа. Заполнить пропуски в таблице.

- •64. Дана таблица выдачи регрессионного анализа. Запишите полученное уравнение регрес-сии

- •67. Какова природа проблемы мультиколлинеарности в задачах множественной регрессии?

- •68.К чему ведет мультиколлинеарность?

- •73. Каковы методы выявления автокорреляции в задаче регрессионного анализа?

- •74. В чем состоит проблема эндогенности в задаче регрессии? Каковы последствия эндогенности для мнк-регрессии?

- •75.В чем состоит проблема гетероскедастичности? Из-за чего она возникает и каковы ее по-следствия для мнк-оценок коэффициентов регрессии?

- •76.Опишите не менее 2 методов выявления гетероскедастичности остатков в задаче множе-ственной регрессии.

- •77. Опишите известные Вам методы борьбы с гетероскедастичностью остатков в задаче множественной регрессии.

- •78. Назовите задачи, которые решает метод главных компонент.

- •79. Приведите примеры использования мгк в политологических задачах.

- •90. Назовите оптимальные свойства главных компонент.

- •91. Объясните смысл характеристического уравнения для ковариационной матрицы:

- •94. Чему равен коэффициент корреляции между главными компонентами?

35. В чем суть метода наименьших квадратов?

МНК— один из базовых методов регрессионного анализа для оценки неизвестных параметров регрессионных моделей по выборочным данным. Метод основан на минимизации суммы квадратов остатков регрессии.

Сущность:

Задача

заключается в нахождении коэффициентов

линейной зависимости, при которых

функция двух переменных а и b принимает

наименьшее значение. То есть, при данных

а и b сумма квадратов отклонений

экспериментальных данных от найденной

прямой будет наименьшей. В этом вся суть

метода наименьших квадратов. Геометр.

смысл. МНК - это ортогональн. проецир.

игрека на икс.

Задача

заключается в нахождении коэффициентов

линейной зависимости, при которых

функция двух переменных а и b принимает

наименьшее значение. То есть, при данных

а и b сумма квадратов отклонений

экспериментальных данных от найденной

прямой будет наименьшей. В этом вся суть

метода наименьших квадратов. Геометр.

смысл. МНК - это ортогональн. проецир.

игрека на икс.

36. Формализуйте идею метода наименьших квадратов в ситуации парной линейной регрессии (в случае центрированных иксов).

Центрирование переменных состоит в параллельном переносе системы координат по Х и/или по Y, при котором наклон (то есть ) не меняется, но упрощается нахождение этого коэффициента. При центрировании Y, дополнительно, свободный член = 0.

Центрированный X = ; EX = 0.

Формализация:

x1, x2 … xn – независимые переменные (регрессоры/предикторы)

y1, y2 … yn – зависимые переменные (отклики)

- общая форма парной линейной регрессии (в обычном случае), где - объясненная моделью часть, а - стандартные ошибки (та часть переменной, которую не удалось объяснить моделью). Построить регрессионную модель = оценить коэффициенты и .

В случае центрированных X мы меняем X на =>

37. Выведите мнк-оценки коэффициентов парной линейной регрессии (в случае центрированных иксов).

Для центрированных X: .

и = 0 => сокращаем.

38. Как получить мнк-оценки коэффициентов парной линейной регрессии в обычном случае центрированных иксов?

Пусть xi, yi – исходные данные, а ; - центрированные X и Y.

Для центрированных X и Y:

Тогда для исходных данных:

Выведение МНК-оценок парной линейной регрессии в общем случае (то, что было на лекции):

| : n (разделим на n)

Подставим во второе уравнение:

; ; => подставим:

| * n

; => заменим:

39. Покажите связь между коэффициентом корреляции к.Пирсона и коэффициентом β1 парной линейной регрессии. (См рисунок в контакте)

Вопрос 40. Сформулируйте 4 условия Гаусса – Маркова.

1)E(ε1) = E(ε2) = … = E(εn) = 0, (15)

2)Var(ε1) = Var(ε2) = … = Var(εn) = σ2(16) - D(E/x) = сигма в квадрате - условная гомоскедастичность

3)Cov(xi,εj) = 0 при всех значениях i и j (18) -отсутствие эндогенности в узком смысле; распределение Е не зависит от распределения Х

4)Cov(εi, εj) = 0 при i≠j(17)

Единственно-должна отсутствовать автокорреляция

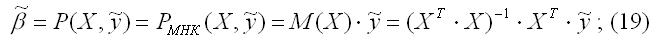

Вопрос 41. Сформулируйте теорему Гаусса – Маркова

Пусть матрица Х коэффициентов уравнений наблюдений (6) имеет полный ранг, а случайные возмущения (8) удовлетворяют четырем условиям,

В этом случае справедливы следующие утверждения:

а)

наилучшая линейная процедура (13),

приводящая к несмещенной и эффективной

оценке (11), имеет вид:

а)

наилучшая линейная процедура (13),

приводящая к несмещенной и эффективной

оценке (11), имеет вид:

б)

линейная несмещенная эффективная оценка

(19) обладает свойством наименьших

квадратов:

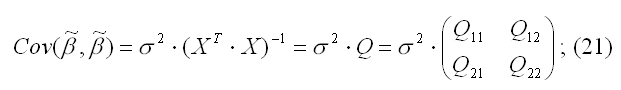

в) ковариационная матрица оценки (19) вычисляется по правилу:

г) несмещенная оценка параметра σ2 модели (2) находится по формуле:

Короче

говоря, если выполняются 4 условия

Гауса-Маркова, то МНК оценки являются

несмещенными, состоятельными и наиб.

Эффективными

среди всех линейных оценок.

среди всех линейных оценок.

Свойства точечных оценок