- •Тема 2. Информационные характеристики.

- •2.1. Количество информации в сообщении.

- •2.2. Энтропия дискретного источника.

- •2.3. Взаимная информация и условная энтропия.

- •2.4. Непрерывный источник. Взаимная информация для непрерывных ансамблей. Относительная (дифференциальная) энтропия.

- •2.5. Информационные характеристики источника и канала.

2.4. Непрерывный источник. Взаимная информация для непрерывных ансамблей. Относительная (дифференциальная) энтропия.

Рассматривавшиеся до сих пор дискретные ансамбли сообщений не исчерпывают всего многообразия вариантов, встречающихся на практике. Значительный интерес представляют и непрерывные ансамбли, которым посвящен настоящий параграф.

Как уже упоминалось, в качестве модели

непрерывного ансамбля в теории информации

используется континуальное множество

![]() ,

на котором задана соответствующая

плотность вероятности

,

на котором задана соответствующая

плотность вероятности![]() .

Тем самым рассматриваемый тип непрерывных

ансамблей отождествляется с числовой

осью. Распространение понятия взаимной

информации на непрерывные ансамбли не

встречает затруднений и состоит в

обычном предельном переходе.

.

Тем самым рассматриваемый тип непрерывных

ансамблей отождествляется с числовой

осью. Распространение понятия взаимной

информации на непрерывные ансамбли не

встречает затруднений и состоит в

обычном предельном переходе.

Пусть имеются два непрерывных ансамбля

![]() с заданной двумерной плотностью

вероятности

с заданной двумерной плотностью

вероятности![]() .

Понятно, что одномерные плотности

.

Понятно, что одномерные плотности![]() можно получить из

можно получить из![]() интегрированием по «ненужной» переменной

интегрированием по «ненужной» переменной

![]()

и далее, если потребуется, найти условные

плотности вероятности

![]() и

и![]() из правила умножения вероятностей

из правила умножения вероятностей

![]() .

.

|

|

Квантование по уровню заключается в

замене значения

![]() непрерывной случайной величины

непрерывной случайной величины![]() дискретным значением

дискретным значением![]() ,

удовлетворяющим условию

,

удовлетворяющим условию![]() .

Поэтому вероятность принятия величиной

.

Поэтому вероятность принятия величиной![]() значения

значения![]() находится как

находится как

,

,

где последнее приближение справедливо при достаточно малом .

|

Рис. 2.3 |

.

.

При

![]() ансамбли

ансамбли![]() и

и![]() приближаются к непрерывным

приближаются к непрерывным![]() и

и![]() ,

а операция суммирования заменяется

интегрированием, что приводит к

определению средней взаимной информации

непрерывных ансамблей

,

а операция суммирования заменяется

интегрированием, что приводит к

определению средней взаимной информации

непрерывных ансамблей![]() в следующем виде:

в следующем виде:

![]()

![]() . (2.22)

. (2.22)

Замечание.Практически все свойства

средней взаимной информации являются

общими для дискретных и непрерывных

ансамблей. Единственное отличие состоит

в том, что для непрерывных ансамблей не

определена собственная информация и,

следовательно, оказывается невозможным

представление ее разностью энтропий.

Однако можно ввести некоторые аналоги

энтропий и в непрерывном случае, получив

выражение, подобное (2.14). Для этого

запишем выражение для энтропии ансамбля![]() в виде

в виде

![]()

![]() . (2.23)

. (2.23)

С учетом того, что при

![]()

![]() ,

соотношение (2.23) принимает вид

,

соотношение (2.23) принимает вид

![]() ,

,

где

![]() – "предел" второго слагаемого в

(2.23).

– "предел" второго слагаемого в

(2.23).

Таким образом, энтропия ансамбля

![]() при

при![]() стремится к бесконечности, что согласуется

с представлением об энтропии как о мере

неопределенности, поскольку при

неограниченном возрастании числа

элементов ансамбля его неопределенность

также увеличивается беспредельно.

стремится к бесконечности, что согласуется

с представлением об энтропии как о мере

неопределенности, поскольку при

неограниченном возрастании числа

элементов ансамбля его неопределенность

также увеличивается беспредельно.

Однако, если в соответствии с (2.14)

рассматривать взаимную информацию, как

разность безусловной и условной энтропий,

то слагаемые

![]() ,

не зависящие от конкретного ансамбля,

компенсируются и не влияют на результат.

В связи с этим для характеристики

непрерывных источников используют

понятиеотносительной или дифференциальной

энтропии.

,

не зависящие от конкретного ансамбля,

компенсируются и не влияют на результат.

В связи с этим для характеристики

непрерывных источников используют

понятиеотносительной или дифференциальной

энтропии.

Относительной (дифференциальной) энтропией непрерывного источника называется величина

![]() . (2.24)

. (2.24)

Аналогично соотношению (2.24) можно записать выражение и для условной относительной энтропии

![]() , (2.25)

, (2.25)

так что в согласии с (2.14) и (2.22)

![]() . (2.26)

. (2.26)

Несмотря на большую степень общности между относительной энтропией и энтропией дискретного источника у первой имеется некоторая специфика. Так, относительная энтропия может принимать не только положительные, но и отрицательные значения.

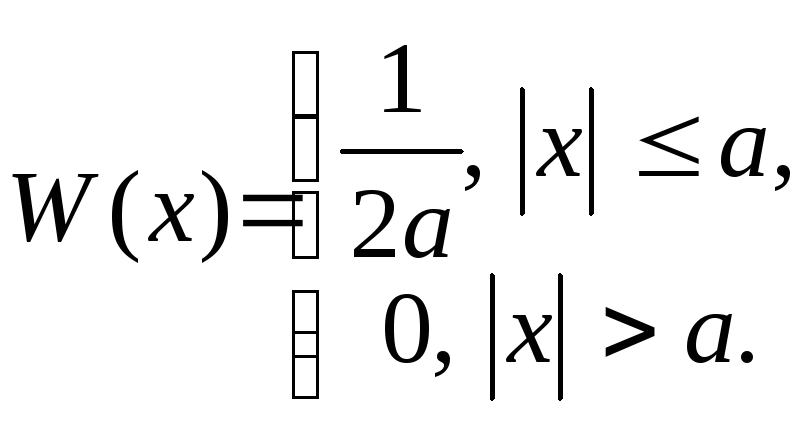

Пример 2.4.1.Пусть плотность вероятности

для некоторого непрерывного ансамбля

равномерна на отрезке![]() ,

т. е.

,

т. е.

(2.27)

(2.27)

Тогда относительная энтропия этого ансамбля

![]() .

.

Как видно, при

![]() значение

значение![]() ,

тогда как случай

,

тогда как случай![]() отвечает

отвечает![]() .

.

Пример 2.4.2.Пусть плотность вероятности

для непрерывного ансамбля распределена

по нормальному (гауссовскому) закону с

нулевым средним и дисперсией![]() ,

т.е.

,

т.е.

![]() . (2.28)

. (2.28)

Тогда

![]() , (2.29)

, (2.29)

поскольку

![]() .

Очевидно, что, как и в примере 2.4.1,

относительная энтропия может быть как

положительной, так и отрицательной в

зависимости от значения дисперсии.

.

Очевидно, что, как и в примере 2.4.1,

относительная энтропия может быть как

положительной, так и отрицательной в

зависимости от значения дисперсии.