- •Понятия информации и информационных технологий.

- •Роль современных информационных технологий в деятельности юридиче-ской фирмы.

- •3. Техническое обеспечение информационных технологий.

- •4.Классификация программного обеспечения информационных технологий.

- •Интегрированные пакеты прикладных программ.

- •Измерение количества информации.

- •11. Архитектура персонального компьютера.

- •12. Основные характеристики современных персональных компьютеров.

- •14. Понятие и назначение операционной системы.

- •Состав ос

- •Назначение Операционной системы

- •Дополнительные функции:

- •15. Сохранение файлов с паролем.

-

Интегрированные пакеты прикладных программ.

Интегрированные пакеты - это совокупность программных средств различного назначения с единым пользовательским интерфейсом, совместно использующих одни и те же данные.

Наиболее распространены интегрированные пакеты, компонентами которых являются:

· СУБД;

· текстовый редактор;

· табличный процессор;

· органайзер;

· средства поддержки электронной почты;

· программы создания презентаций;

· графический редактор.

Компоненты интегрированных пакетов могут работать изолированно друг от друга, но основные достоинства интегрированных пакетов проявляются при их разумном сочетании друг с другом. Пользователи интегрированных пакетов имеют унифицированный для различных компонентов интерфейс, тем самым обеспечивается относительная легкость процесса их освоения.

-

Измерение ценности информации.

Существуют, по крайней мере, два метода определения ценности информации.

Согласно методу, предложенному А. А. Харкевичем, мерой ценности информации является изменение вероятности достижения цели при получении этой информации:

Iц=logP1 – logP0=log P1/P0. (3.2)

Здесь Р0-начальная, до получения информации, вероятность достижения цели;

Р1-вероятность достижения цели после получения информации.

Возможны следующие три случая. В первом случае полученная информация является ценной, увеличивающей вероятность достижения цели, то есть Р1>Р0. Следовательно, информация является ценной, полезной и количественная мера ценности информации Iц>0.

Во втором случае информация не изменяет вероятность достижения цели. Она является бесполезной. При этом Р1=Р0 и Iц=0.

В третьем случае вероятность достижения цели уменьшается т. к. полученная информация является ложной, ошибочной. При этом Р1<Р0 и Iц<0.

-

Измерение количества информации.

За единицу количества информации принимается такое количество информации, которое содержит сообщение, уменьшающее неопределенность в два раза. Такая единица названа "бит".

Для информации существуют свои единицы измерения информации. Если рассматривать сообщения информации как последовательность знаков, то их можно представлять битами, а измерять в байтах, килобайтах, мегабайтах, гигабайтах, терабайтах и петабайтах.

Давайте разберемся с этим, ведь нам придется измерять объем памяти и быстродействие компьютера.

Бит

Единицей измерения количества информации является бит – это наименьшая (элементарная) единица.

1бит – это количество информации, содержащейся в сообщении, которое вдвое уменьшает неопределенность знаний о чем-либо.

Байт

Байт – основная единица измерения количества информации.

Байтом называется последовательность из 8 битов.

Байт – довольно мелкая единица измерения информации. Например, 1 символ – это 1 байт.

Производные единицы измерения количества информации

1 байт=8 битов

1 килобайт (Кб)=1024 байта =210 байтов

1 мегабайт (Мб)=1024 килобайта =210 килобайтов=220 байтов

1 гигабайт (Гб)=1024 мегабайта =210 мегабайтов=230 байтов

1 терабайт (Гб)=1024 гигабайта =210 гигабайтов=240 байтов

Запомните, приставка КИЛО в информатике – это не 1000, а 1024, то есть 210 .

Методы измерения количества информации

Итак, количество информации в 1 бит вдвое уменьшает неопределенность знаний. Связь же между количеством возможных событий N и количеством информации I определяется формулой Хартли:

N=2i.

Алфавитный подход к измерению количества информации

При этом подходе отвлекаются от содержания (смысла) информации и рассматривают ее как последовательность знаков определенной знаковой системы. Набор символов языка, т.е. его алфавит можно рассматривать как различные возможные события. Тогда, если считать, что появление символов в сообщении равновероятно, по формуле Хартли можно рассчитать, какое количество информации несет в себе каждый символ:

I=log2N.

Вероятностный подход к измерению количества информации

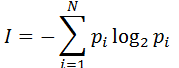

Этот подход применяют, когда возможные события имеют различные вероятности реализации. В этом случае количество информации определяют по формуле Шеннона:

,

где

,

где

I – количество информации,

N – количество возможных событий,

Pi – вероятность i-го события.

10. Кодирование информации в компьютерах.

Вся информация , которую обрабатывает

компьютер, должна быть представлена двоичным кодом с помощью двух цифр — 0 и 1. Эти два символа принято называть двоичными цифрами, или битами. С помощью двух цифр 1 и 0 можно закодировать любое сообщение. Это явилось причиной того, что в компьютере обязательно должно быть организовано два важных процесса:

-

кодирование, которое обеспечивается устройствами ввода при преобразовании входной информации в форму, воспринимаемую компьютером, то есть в двоичный код;

-

декодирование, которое обеспечивается устройствами вывода при преобразовании данных из двоичного кода в форму, понятную человеку.

С точки зрения технической реализации использование двоичной системы счисления для кодирования информации оказалось намного более простым, чем применение других способов. Действительно, удобно кодировать информацию в виде последовательности нулей и единиц, если представить эти значения как два возможных устойчивых состояния электронного элемента:

-

0 — отсутствие электрического сигнала или сигнал имеет низкий уровень;

-

1 — наличие сигнала или сигнал имеет высокий уровень.

Эти состояния легко различать. Недостаток двоичного кодирования — длинные коды. Но в технике легче иметь дело с большим числом простых элементов, чем с небольшим количеством сложных.

Вам и в быту ежедневно приходится сталкиваться с устройством, которое может находиться только в двух устойчивых состояниях: включено/выключено. Конечно же, это хорошо знакомый всем выключатель. А вот придумать выключатель, который мог бы устойчиво и быстро переключаться в любое из 10 состояний, оказалось невозможным. В результате после ряда неудачных попыток разработчики пришли к выводу о невозможности построения компьютера на основе десятичной системы счисления. И в основу представления чисел в компьютере была положена именно двоичная система счисления.

В настоящее время существуют разные способы двоичного кодирования и декодирования информации в компьютере. В первую очередь это зависит от вида информации, а именно, что должно кодироваться: текст, числа, графические изображения или звук. Кроме того, при кодировании чисел важную роль играет то, как они будут использоваться: в тексте, в расчетах или в процессе ввода-вывода. Накладываются также и особенности технической реализации.