- •1 Нормативні дані з дисципліни

- •2. Мета і завдання дисципліни

- •3 Перелік забезпечуючих дисциплін

- •4 Структура залікових кредитів

- •5 Навчально–методичне забезпечення дисципліни

- •5.1 Література

- •5.2 Методичні посібники та вказівки

- •Лекція 1 Система передачі інформації. Основні поняття і визначення

- •1. Місце інформаційних систем у сучасному світі

- •2. Класифікація систем передачі інформації

- •3. Узагальнена структурна схема системи передачі інформації

- •4.Основні інформаційно-технічні характеристики спи

- •4.1 Вірогідність передачі інформації

- •Завадостійкість передачі інформації

- •Швидкість передачі інформації

- •Пропускна здатність каналів зв'язку

- •Висновки

- •Тестові запитання

- •1.Кількість інформації в повідомленні

- •Логарифмічна міра добре відображає адитивність інформації.

- •2 .Джерело дискретних повідомлень і його ентропія

- •Ентропію джерела не рівноімовірних попарно залежних повідомлень, позначимо , дамо розрахункову формулу

- •3.Джерело неперервних повідомлень

- •Висновки

- •Тестові запитання

- •Практичне заняття №1

- •Задачі для самостійного розв’язання

- •Лекція 3 Передача інформації з дискретними і неперервними каналами зв'язку

- •1.Продуктивність джерела дискретних повідомлень

- •2.Швидкість передачі інформації з дискретних каналів без перешкод. Оптимальне статистичне кодування

- •3.Швидкість передачі інформації й пропускна здатність дискретних каналів з завадами

- •4.Пропускна здатність двійкового симетричного каналу зв'язку з завадами

- •5.Швидкість передачі інформації неперервними каналами з завадами.

- •6. Пропускна здатність неперервного каналу з нормальним білим шумом

- •Пропускна здатність неперервного каналу зв'язку при довільних спектрах сигналів і завад.

- •Висновки

- •Тестові запитання

- •Практичне заняття №2

- •Задачі для самостійного розв’язання

- •Лекція 4 завадостійке кодування. Основні положення теорії завадостійкого кодування

- •1.Постановка задачі застосування завадостійких кодів

- •2.Класифікація завадостійких кодів

- •3. Основні числові характеристики завадостійких кодів

- •4.Кодова відстань і її зв'язок із кратністю помилок що виявляються й або, що виправляються.

- •Висновки

- •Лекція 5 Систематичні блокові лінійні коди

- •Загальні методи кодування і декодування систематичних блокових лінійних кодів

- •Код з парним числом одиниць

- •Інверсний код

- •Код з подвоєнням елементів

- •Коди Хемінга

- •Висновки

- •Лабораторна робота №1 вивчення принципу дії та дослідження завадостійкості радіосистеми передавання інформації із блоковим кодом

- •1 Мета роботи

- •2 Методичні вказівки

- •Позиції, що займають одиниці в одиничній матриці, вказують номера позицій контрольних символів, що використовуються у кожній перевірці на парність.

- •3 Опис лабораторної установки

- •4 Порядок виконання роботи

- •6 Контрольні запитання і завдання

- •Лекція 6 циклічні коди

- •Основні властивості циклічного коду й способи побудови

- •Способи кодування і декодування циклічних кодів

- •Матричне подання циклічних кодів

- •Висновки

- •Тестові запитання

- •Лабораторна робота №2 Вивчення властивостей і принципів побудови циклічних кодів.

- •1 Ціль роботи

- •2 Методичні вказівки

- •3 Порядок виконання роботи

- •5 Контрольні запитання.

- •Практичне заняття №3

- •Розв’язання. Визначимо кількість інформаційних і контрольних символів у кодовій комбінації:

- •Задачі для самостійного розв’язання

- •Лекція 7 Оптимальний когерентний прийом дискретних сигналів

- •1.Основні положення теорії оптимального приймання сигналів

- •Синтез, правила розрізнення сигналів у випадку приймання повністю відомих сигналів на фоні нормального білого шуму

- •Структурні схеми оптимальних приймачів

- •Обчислення завадостійкості (імовірності помилок розрізнення сигналів) оптимальних когерентних приймачів

- •Виходячи з цього, можна записати формули для обчислення імовірностей помилок в системах когерентного приймання фазовою, частотною та амплітудною маніпуляцією.

- •Висновки

- •3 Порядок виконання роботи

- •5 Контрольні запитання

- •Лекція 8 оптимальний некогерентний прийом дискретних сигналів і його завадостійкість

- •Модель лінії зі змінними параметрами

- •Алгоритм прийняття рішення при прийманні сигналів з випадковою початковою фазою

- •Приймання сигналів з випадковою початковою фазою і флуктуючою амплітудою

- •Некогерентні приймачі сигналів з використанням обробки за огинаючою

- •Некогерентний приймач ортогональних сигналів

- •Приймання сигналів з випадковою початковою фазою при використанні відносної фозової маніпуляції

- •Висновки

- •Тестові запитання

- •3 Порядок виконання роботи.

- •4 Структура звіту

- •5 Контрольні запитання і завдання

- •Практичне заняття № 4 "Когерентне и не когерентне приймання дискретних сигналів та його завадостійкість"

- •Приклади розв’язання основних типів задач

- •Задачі для самостійного розв’язання

- •Лекція 9 оптимальний і квазиоптимальНіЙ прийом неПерервних сигналів і його завадостійкість

- •1.Особливості приймання неперервних сигналів з аналоговою модуляцією

- •2. Завадостійкість прийому сигналів з амплітудною модуляцією

- •3.Завадостійкість прийому сигналів з фазовою модуляцією

- •4.Завадостійкість прийому сигналів з частотною модуляцією

- •Висновки

- •Лекція 10 цифрові методи передачі неЗперервних повідомлень

- •Імпульсно – кодова модуляція

- •2.Завадостійкисть систем зв’язку з імпульсно-кодовою модуляцією

- •3.Диференціальна імпульсно-кодова модуляція. Дельта модуляція

- •Висновки

- •Тестові запитання

- •Практичне заняття № 5

- •Приклади розв’язання основних типів задач

- •Задачі для самостійного розв’язання

- •Лекція 11 багатоканальні системи передачі інформації

- •1.Узагальнена структура багатоканальної системи зв’язку

- •2.Системи зв’язку із частотним поділом каналів

- •3Системи зв’язку із часовим поділом каналів

- •Висновки

- •Тестові запитання

- •Лекція 12

- •1. Поняття про багатостанційний доступ

- •Системи з часовим поділом каналів

- •Системи із частотним поділом каналів

- •Системи з кодовим поділом каналів

- •Асинхронно-адресні системи передачі інформації (аас)

- •Висновки

Логарифмічна міра добре відображає адитивність інформації.

Припустимо,

що складне повідомлення складається з

елементів

![]() .

.

Відомі

імовірності

![]() .

.

Імовірність

складного повідомлення

![]()

![]()

![]() .

.

У теорії інформації використовують логарифм із підставами е й 2.

![]() ,

,

![]() .

.

Покладемо,

що є два повідомлення ![]() та

та ![]() й відомі їхні апріорні ймовірності

й відомі їхні апріорні ймовірності

![]()

тоді

![]() .

.

![]() ,

,

![]() ,

,

![]() .

.

Якщо

![]() ,

,

![]() .

.

За одиницю кількості інформації приймається кількість інформації, що втримується в повідомленні про одному із двох рівноможливих подій. Вона називається двійковою одиницею або біт.

2 .Джерело дискретних повідомлень і його ентропія

Покладемо, що ми маємо джерело дискретних повідомлень

![]()

Задано

набір апріорних імовірностей передачі

повідомлень

![]() .

.

Будемо

вважати, що повідомлення джерела

статистично незалежні, тобто ймовірності

їхньої появи описуються одномірними

безумовними

ймовірностями ![]() . При цьому

. При цьому

.

.

Можемо визначити кількість інформації, що втримується в кожному повідомленні джерела

![]()

![]() .

.

Середня кількість інформації в одному повідомлені

Воно обчислюється виходячи з апріорних знань про ймовірність появи окремих повідомлень. Ця величина характеризує невизначеність стану джерела, тобто невизначеність того, яке з повідомлень з'явиться на його виході в розглянутий момент часу. Назвемо цю величину ентропією .

Покладемо,

що є двійкове джерело повідомлень ![]() із апріорними ймовірностями

із апріорними ймовірностями

![]() .

.

![]() .

.

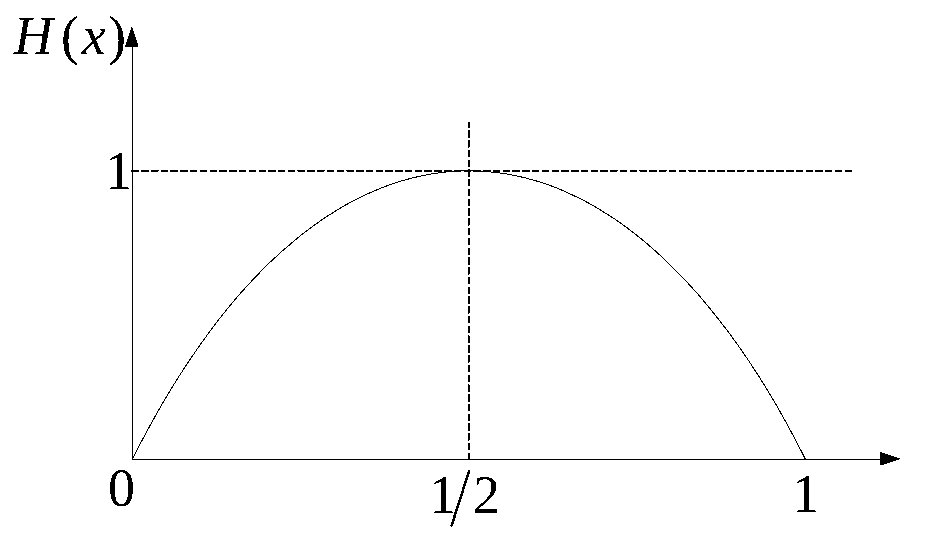

Побудуємо

графік ентропії

![]() у

функції від

у

функції від ![]() .

.

![]()

![]()

Видно,

що величина![]() завжди позитивно й досягає максимуму

при

завжди позитивно й досягає максимуму

при

![]()

Покладемо, що кількість повідомлень m. Тоді

![]() .

.

З

порівняння останніх двох виражень

видно, що зі збільшенням кількості

повідомлень джерела його ентропія

зростає пропорційно

![]() .

Звідси видно, що кількість інформації,

що втримується в одному повідомленні

джерела, росте зі збільшенням розміру

алфавіту.

.

Звідси видно, що кількість інформації,

що втримується в одному повідомленні

джерела, росте зі збільшенням розміру

алфавіту.

![]() - ентропія

нульового порядку, що`1

характеризує джерело статистичних

незалежних рівномірних повідомлень.

- ентропія

нульового порядку, що`1

характеризує джерело статистичних

незалежних рівномірних повідомлень.

Якщо

![]()

![]() ,

,

![]() .

.

Обчислимо

ентропію

джерела не

рівноімовірних

незалежних повідомлень ![]() Коли,

Коли,

![]()

.

.

Ентропію джерела не рівноімовірних попарно залежних повідомлень, позначимо , дамо розрахункову формулу

.

.

![]() -

характеризує джерело, у якого простежується

зв'язок між ℓ

–

повідомленнями. Можна довести що

-

характеризує джерело, у якого простежується

зв'язок між ℓ

–

повідомленнями. Можна довести що

![]() .

.

Таким чином, зі збільшенням статичних зв'язків між повідомленнями середня кількість інформації, що втримується в одному повідомленні, зменшується.

Надмірність повідомлень джерела повідомлень можна обчислити таким чином

![]() .

.

Обчислимо надмірність джерела російської мови. Кількість символів алфавіту m=32, тобто у випадку рівноімовірніх символів

![]()

У

російській мові простежуються статистичні

зв'язку між 8 буквами, тобто при ℓ=8

![]() .

.

Тоді

надмірність ![]() .

.

Тобто при відповідному кодуванні блоками можна на 60% скоротити російські тексти, але цей шлях дуже складній, бо потребує введення спеціальних конструкцій (умовних скорочень) і має обмежені можливості. То того ж надмірність дає змогу корегувати помилки в каналах з завадами.