- •Белорусский национальный технический университет

- •Практикум по курсу «Каналы передачи информации»

- •Часть 1

- •Составитель и разработчик в.В.Баркалин.

- •Тема 1: Информация и ее измерение. Определения и глоссарий

- •Задания для предварительной самостоятельной подготовки

- •Учебно-исследовательское задание

- •Литература

- •Тема 2: Основные понятия теории вероятностей. Вычисление вероятностей составных событий Определения и глоссарий

- •Задания для предварительной самостоятельной подготовки

- •Литература

- •Тема 3: условные вероятности Определения и глоссарий

- •Задания для предварительной самостоятельной подготовки

- •Учебно-исследовательское задание

- •Литература

- •Тема 4: Законы распределения и числовые характеристики одномерных случайных величин Определения и глоссарий

- •Задания для предварительной самостоятельной подготовки

- •Учебно-исследовательское задание

- •Литература

- •Тема 5: Многомерные случайные величины и условные функции распределения. Определения и глоссарий

- •Задания для предварительной самостоятельной подготовки

- •Учебно-исследовательское задание

- •Литература

- •Тема 5: Многомерные случайные величины и условные функции распределения (продолжение). Задачи

- •Тема 6: -функция Дирака.

- •Тема 7: Преобразования одномерных случайных величин.

- •Тема 8: Преобразования многомерных случайных величин.

- •Учебно-исследовательское задание

- •Литература

- •Тема 9: энтропия и количество информации в дискретных системах Определения и глоссарий

- •Задания для предварительной самостоятельной подготовки

- •Учебно-исследовательское задание

- •Литература

- •Тема 10: Дискретные каналы передачи информации Определения и глоссарий

- •Задания для предварительной самостоятельной подготовки

- •Тема 11: Законы распределения случайных процессов

- •Тема 12: корреляционные функции случайных процессов

- •Тема 13: спектральные плотности случайных процессов

- •Тема 14: Непрерывные системы передачи информации

- •Учебно-исследовательское задание

- •Литература

- •Содержание

Тема 1: Информация и ее измерение. Определения и глоссарий

Система – совокупность взаимодействующих элементов.

Подсистема – элемент системы.

Надсистема данной системы – система, подсистемой которой является данная система.

Окружение системы – совокупность систем, элементами которых являются надсистемы данной системы (объемлющая система).

Информация о системе – образ системы в ее окружении, совокупность надсистем данной системы. Полная информация о системе – воспроизведение самой системы.

Количество информации – мера неопределенности состояния наблюдателя, снятой испытанием системы.

Количество

информации по Харди

– максимальное количество вопросов,

которое необходимо задать, чтобы любой

из элементов множества мощностью N

мог быть

однозначно определен:

![]() .

.

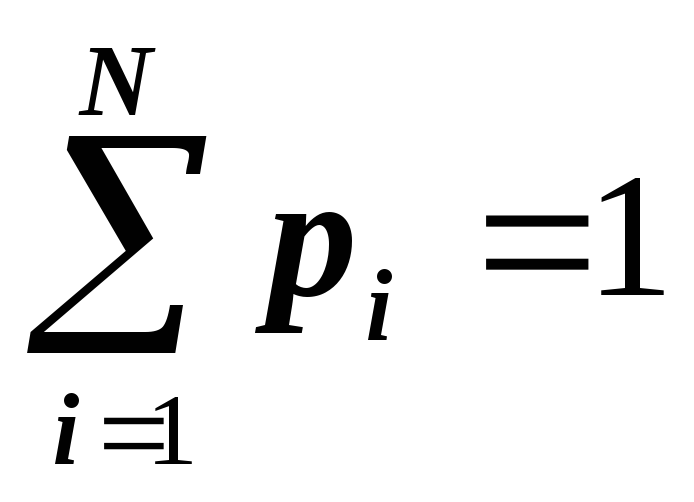

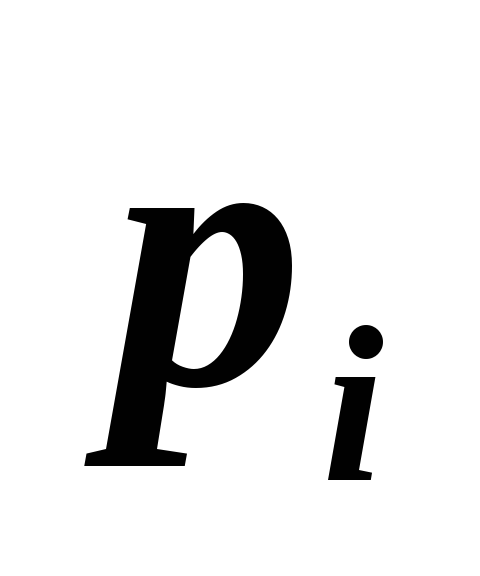

Неожиданность

элемента

множества – мера информационной

значимости появления конкретного

элемента множества при случайном выборе

из дискретного множества

![]()

![]() с распределением вероятностей

с распределением вероятностей

![]() ,

i

=1,…,N,

,

i

=1,…,N,

![]()

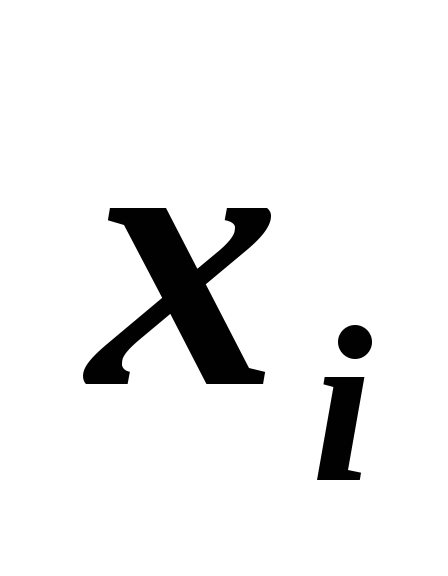

Среднее

значение

![]() признака

G

на множестве

Х

–

признака

G

на множестве

Х

–

![]() .

.

Количество

информации по Шеннону

– средняя неожиданность на Х,

![]() .

.

Информационная

энтропия системы

– мера неопределенности задания

состояний элементов системы при заданном

состоянии системы. Характеризует

состояние системы и определяется по

Больцману как

![]() ,

где

,

где

![]() - постоянная Больцмана, W

–количество состояний элементов

системы, совместимых с данным состоянием

всей системы. Применяется в статистическом

обосновании равновесной термодинамики.

В случае систем, составленных из большого

числа М

одинаковых элементов, каждый из которых

может находится в одном из N

состояний

- постоянная Больцмана, W

–количество состояний элементов

системы, совместимых с данным состоянием

всей системы. Применяется в статистическом

обосновании равновесной термодинамики.

В случае систем, составленных из большого

числа М

одинаковых элементов, каждый из которых

может находится в одном из N

состояний

![]() с вероятностью

с вероятностью

![]() ,

с точностью до множителя совпадает с

количеством информации по Шеннону:

,

с точностью до множителя совпадает с

количеством информации по Шеннону:

![]() .

.

Задания для предварительной самостоятельной подготовки

-

Сформулировать понятие ценности информации и привести примеры систем, в которых информация характеризуется ценностью.

-

Определить соотношение понятий информации о системе и модели системы.

-

Привести примеры систем, неопределенность которых не может быть полностью снята каким-либо испытанием.

Задачи

-

Доказать, что в случае равнораспределения вероятности по элементам множества количество информации по Щеннону сводится к количеству информации по Харди.

-

Предложить алгоритм задания вопросов, реализующий количество информации по Харди для множества студентов группы.

-

Какое количество информации получает школьник младших классов при работе в научной лаборатории в течении 10 минут, если ему поручено записывать показания восьмиразрядного цифрового вольтметра с интервалом в 10 секунд.

-

Как изменится количество информации, получаемой при некотором измерении, если используемый измерительный прибор заменить на более точный с ценой деления шкалы, в 100 раз меньшей цены деления исходной.

-

В партии 100 сенсоров, из них 5% бракованных. Из партии выбирают наугад 5 сенсоров для контроля. Какое количество информации содержится в сообщении о том, что в случайной выборке оказалось ровно 3 бракованных прибора?

-

Многоканальная сенсорная система состоит из 32 равнонадежных элементов и имеет устройство контроля их исправности. Определить минимальное число проб, которое необходимо выполнить этому устройству, чтобы установить любой неисправный элемент.

-

Для случая, когда в каждом испытании некоторой системы реализуется один из двух возможных исходов с заданной вероятностью p, записать количество получаемой в таком испытании информации по Шеннону

и найти максимум этой функции. Построить

график функции

и найти максимум этой функции. Построить

график функции

и проинтерпретировать полученный

результат.

и проинтерпретировать полученный

результат.

-

Используя метод неопределенных множителей Лагранжа, показать, что для системы, которая может находиться в одном из N состояний

с вероятностью

с вероятностью

,

где

,

где

,

максимуму информационной энтропии

соответствует равномерное распределение

вероятностей

,

максимуму информационной энтропии

соответствует равномерное распределение

вероятностей

.

. -

Найти распределение вероятностей, соответствующее максимуму информационной энтропии (см. предыдущую задачу) в случае, когда для системы задано еще и среднее значение некоторого свойства G, принимающее значение

в состоянии

в состоянии

.

Вычислить значение информационной

энтропии, соответствующее полученному

распределению и проинтерпретировать

результат в случае, когда G

– внутренняя

энергия системы.

.

Вычислить значение информационной

энтропии, соответствующее полученному

распределению и проинтерпретировать

результат в случае, когда G

– внутренняя

энергия системы.

-

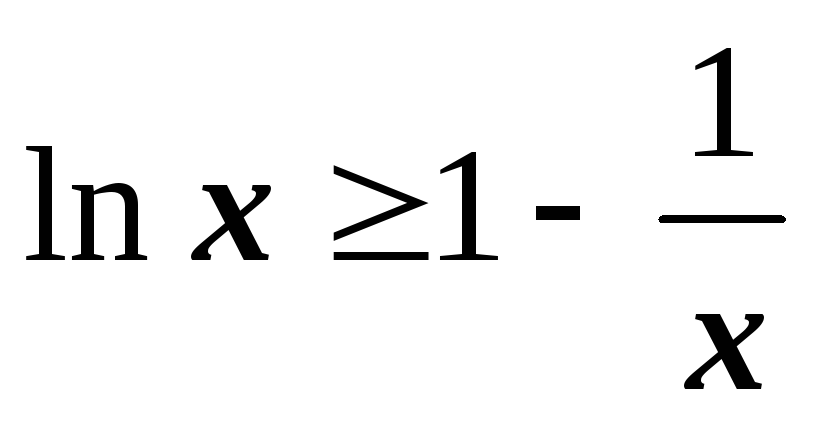

Показать, что для всех положительных x выполняется соотношение

,

где равенство достигается только в

случае x=1.

,

где равенство достигается только в

случае x=1.

-

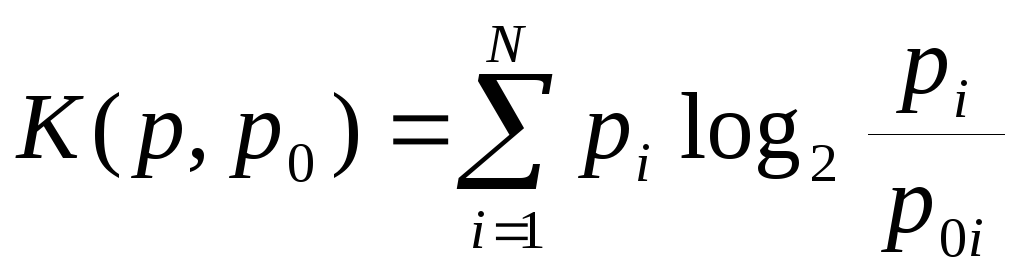

С точки зрения субъективной теории информации получение сведений о системе можно интерпретировать как изменение субъективных вероятностей различных состояний системы. В этом случае изменение информированности наблюдателя оценивается количеством информации Рени

,

где p0i

и pi

– исходное

и новое распределения вероятностей

соответственно. Используя результат

предыдущей задачи, доказать, что

информация Рени положительно определена

и интерпретировать приведенное выше

соотношение при различных p0i

и pi

.

,

где p0i

и pi

– исходное

и новое распределения вероятностей

соответственно. Используя результат

предыдущей задачи, доказать, что

информация Рени положительно определена

и интерпретировать приведенное выше

соотношение при различных p0i

и pi

.