- •1. Предмет теории вероятности. Вероятность и статистика.

- •2.Понятие события. Классификация событий.

- •3.Операции над событиями.

- •4.Статистический подход к определению вероятности.

- •6.Геометрический подход к определению вероятностей.

- •5.Классический подход к определению вероятности. Свойства вероятности.

- •7.Элементы комбинаторики.

- •8. Условная вероятность. Независимые события.

- •9 Вероятность суммы событий и произведения событий.

- •10 Формула полной вероятности. Формула Байеса.

- •11 Понятие случайной величины. Типы случайны величин. Закон распределения.

- •12 Дискретные случайные величины.

- •13 Непрерывные случайные величины.

- •15. Равномерное распределение,

- •17. Пуассона распределение,

- •14 Параметры распределения случайных величин.

- •16. Биномальное распределение

- •Моменты

- •18. Нормальное распределение,

- •Цели регрессионного анализа

- •21. Зако́н больши́х чи́сел

- •Слабый закон больших чисел

- •Усиленный закон больших чисел

- •25. Точечные оценки параметров распределения.

- •22.Понятие статистического исследования. Генеральная совокупность и выборка. Выборочный метод.

- •26. Интервальные оценки параметров распределения.

- •27. Оценки вероятности события.

- •23, 24.

- •1.1 Мода

- •1.2 Медиана

- •1.3 Выборочное среднее

- •1.4 Разброс выборки

- •1.5 Дисперсия

Цели регрессионного анализа

Определение степени детерминированности вариации критериальной (зависимой) переменной предикторами (независимыми переменными)

Предсказание значения зависимой переменной с помощью независимой(-ых)

Определение вклада отдельных независимых переменных в вариацию зависимой

Регрессионный анализ нельзя использовать для определения наличия связи между переменными, поскольку наличие такой связи и есть предпосылка для применения анализа.

Математическое определение регрессии

Строго регрессионную зависимость можно определить следующим образом. Пусть Y, X1,X2,...,Xp — случайные величины с заданным совместным распределением вероятностей. Если для каждого набора значений X1 = x1,X2 = x2,...,Xp = xp определено условное математическое ожидание

y(x1,x2,...,xp) = E(Y | X1 = x1,X2 = x2,...,Xp = xp) (уравнение линейной регрессии в общем виде),

то функция y(x1,x2,...,xp) называется регрессией величины Y по величинам X1,X2,...,Xp, а её график — линией регрессии Y по X1,X2,...,Xp, или уравнением регрессии.

Зависимость Y от X1,X2,...,Xp проявляется в изменении средних значений Y при изменении X1,X2,...,Xp. Хотя при каждом фиксированном наборе значений X1 = x1,X2 = x2,...,Xp = xp величина Y остаётся случайной величиной с определённым рассеянием.

Для выяснения вопроса, насколько точно регрессионный анализ оценивает изменение Y при изменении X1,X2,...,Xp, используется средняя величина дисперсии Y при разных наборах значений X1,X2,...,Xp (фактически речь идет о мере рассеяния зависимой переменной вокруг линии регрессии).

Метод наименьших квадратов (расчёт коэффициентов)

На

практике линия регрессии чаще всего

ищется в виде линейной функции Y

= b0

+ b1X1

+ b2X2

+ ... + bNXN

(линейная регрессия), наилучшим образом

приближающей искомую кривую. Делается

это с помощью метода

наименьших квадратов,

когда минимизируется сумма квадратов

отклонений реально наблюдаемых Y от их

оценок

![]() (имеются

в виду оценки с помощью прямой линии,

претендующей на то, чтобы представлять

искомую регрессионную зависимость):

(имеются

в виду оценки с помощью прямой линии,

претендующей на то, чтобы представлять

искомую регрессионную зависимость):

![]()

(M — объём выборки). Этот подход основан на том известном факте, что фигурирующая в приведённом выражении сумма принимает минимальное значение именно для того случая, когда Y = y(x1,x2,...xN).

Для решения задачи регрессионного анализа методом наименьших квадратов вводится понятие функции невязки:

![]()

Условие минимума функции невязки:

![]()

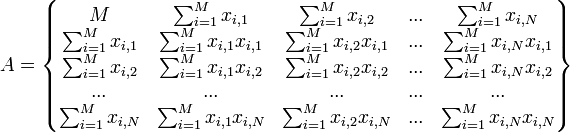

Полученная система является системой N + 1 линейных уравнений с N + 1 неизвестными b0...bN

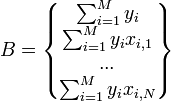

Если представить свободные члены левой части уравнений матрицей

а коэффициенты при неизвестных в правой части матрицей

то

получаем матричное уравнение:

![]() ,

которое легко решаетсяметодом

Гаусса.

Полученная матрица будет матрицей,

содержащей коэффициенты уравнения

линии регрессии:

,

которое легко решаетсяметодом

Гаусса.

Полученная матрица будет матрицей,

содержащей коэффициенты уравнения

линии регрессии:

![]()

Для получения наилучших оценок необходимо выполнение предпосылок МНК (условий Гаусса−Маркова). В англоязычной литературе такие оценки называются BLUE (Best Linear Unbiased Estimators) − наилучшие линейные несмещенные оценки.