- •ПОНЯТИЕ ИНФОРМАЦИИ И СООБЩЕНИЯ

- •Теория информации

- •Основные понятия теории информации: сообщение и информация

- •Основные понятия теории информации: сообщение и информация

- •Количественное определение

- •Количественное определение

- •Количественное определение

- •Информация обратно пропорциональна вероятности появления символа.

- •Информация обратно пропорциональна вероятности появления символа.

- •Правило интерпретации

- •Языки

- •Носители информации

- •Общая схема передачи сообщения

- •Общая схема передачи сообщения

- •Общая схема передачи сообщения

- •Пропускная способность канала

- •Пропускная способность канала

- •Пропускная способность канала

- •Сигнал, параметр сигнала

- •Сигнал, параметр сигнала

- •Модуляция

- •Система-передатчик данных относительно медленные изменения значений дискретного сигнала накладывает на несущую и полученный

- •Основные виды модуляции:

- •Основные виды модуляции:

- •Основные виды модуляции:

- •Знаки , алфавиты.

- •Знаки , алфавиты.

- •Коды

- •Коды с постоянной длиной слова

ПОНЯТИЕ ИНФОРМАЦИИ И СООБЩЕНИЯ

Курс Информатика лекция 2

проф. Петрова И.Ю.

Теория информации

Это наука, занимающаяся исследованием процессов возникновения, преобразования и передачи информации математическими методами.

Теорию информации можно разбить на два больших раздела:

собственно теория информации (автор К.Шеннон 1948 г.) - занимается исследованием скорости возникновения информации и передачи ее по каналу связи,

теория кодирования - математическая оценка возможности тех или иных кодов для передачи информации в системах связи с целью увеличения надежности и эффективности передачи.

Основные понятия теории информации: сообщение и информация

Информация передается посредством

конкретного сообщения.

Для одной и той же информации могут

существовать различные сообщения.

Например: |

|

It`s raining |

Идет дождь |

Основные понятия теории информации: сообщение и информация

Сообщения, передающие одну и ту же информацию, образуют класс эквивалентных сообщений.

Одно и то же сообщение может передавать разную информацию.

Количественное определение

информации.

Информацию, содержащуюся в сообщении можно количественно определить по тому насколько она была новой, неожиданной, т.е. ранее неизвестной.

Сколько информации поступает при приеме 1 символа алфавита?

Количественное определение

информации.

Если алфавит состоит только из одной буквы, то вероятность ее появления равна 1 и никакой неожиданности нет.

Все известно заранее и следовательно

информации нет.

Если алфавит состоит из нескольких сим- волов, то появление маловероятного символа является более неожиданным, т.е. будет по- лучено большее количество информации, чем при появлении высоковероятного символа.

Количественное определение

информации.

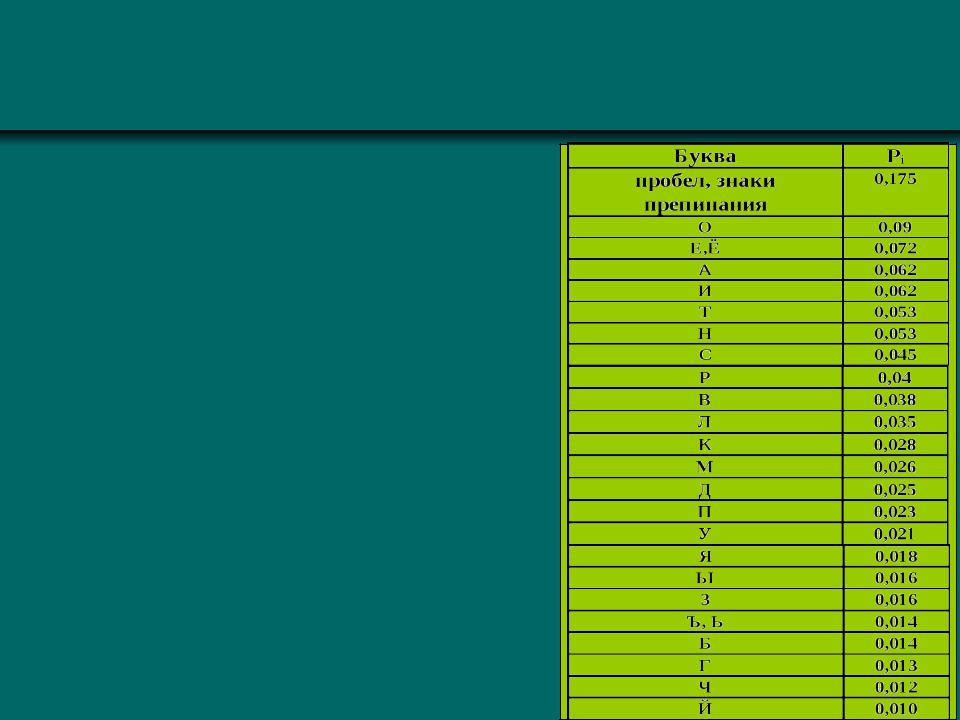

Пусть имеется источник сообщений, выдающий символы S1, S1 ...Sq. Каждый символ появляется с определенной вероятностью - Pi.

Например : вероятность появления букв русского языка:

Информация обратно пропорциональна вероятности появления символа.

Среднее количество информации, приходящееся на 1 знак определяется формулой Шеннона:

q |

|

1 |

|

|

|

|

|

н Pi log |

|

|

|

P |

|||

i 1 |

|

i |

|

Н - называют энтропией источника сообщений.

Энтропия измеряет количество неопределенности, неожиданности или информации, содержащееся в некоторой ситуации

Информация обратно пропорциональна вероятности появления символа.

Среднее количество информации, приходящееся на 1 знак определяется формулой Шеннона:

q |

|

1 |

|

|

|

|

|

н Pi log |

|

|

|

P |

|||

i 1 |

|

i |

|

Н - называют энтропией источника сообщений.

Наиболее удобно использовать как основание логарифма - 2. Это связано с технической реализацией устройств - они имеют 2 устойчивых состояния.

Правило интерпретации

Если сообщение обозначить N, а информацию I , то можно записать:

|

, |

т.е. связь между сообщением и информацией осуществляется посредством правила интерпретации - a. N a I

Если мы говорим "Х понимает язык R" - это означает, что Х знает правило интерпретации a для всех сообщений типа R.